- 1Gradle 不能刷新问题解决方案_could not open init generic class cache for initia

- 2cadence23---PCB Editer 学习笔记

- 3win7 安装.net framework 4.5.2报错:“根据当前系统时钟或签名文件中的时间戳验证时要求的证书不在有效期内。”

- 4css伪类_#aa div{

- 5JDBC:Java数据库连接技术_jdbc技术

- 6TunesKit for Mac如何在Mac上将iTunes DRM M4V转换为MP4?_tuneskit acemovi(视频编辑软件) 输出音频是mp4

- 7前端下载文件获取返回状态以及删除文件总结_前端获取文件加载回调

- 8【Qt+opencv】基础的图像绘制

- 9go mod 添加私有库GOPRIVATE_go mod 私有仓库

- 10算法面试题目1

【自然语言处理系列】安装nltk_data和punkt库(亲测有效)_nltk punkt

赞

踩

目录

一、下载nltk_data-gh-pages.zip数据文件

在使用自然语言处理库nltk时,许多初学者会遇到“nltk.download('punkt')”无法正常下载的问题。本文将提供一个详细的解决方案,包括如何下载所需的数据文件、将其移动到正确的目录,并进行测试以确保成功调用punkt库。无论您是编程新手还是有经验的开发者,希望这篇文章帮助您克服这一常见障碍,使您能够顺利使用nltk库进行自然语言处理任务。

一、下载nltk_data-gh-pages.zip数据文件

nltk_data: NLTK Data - Gitee.com

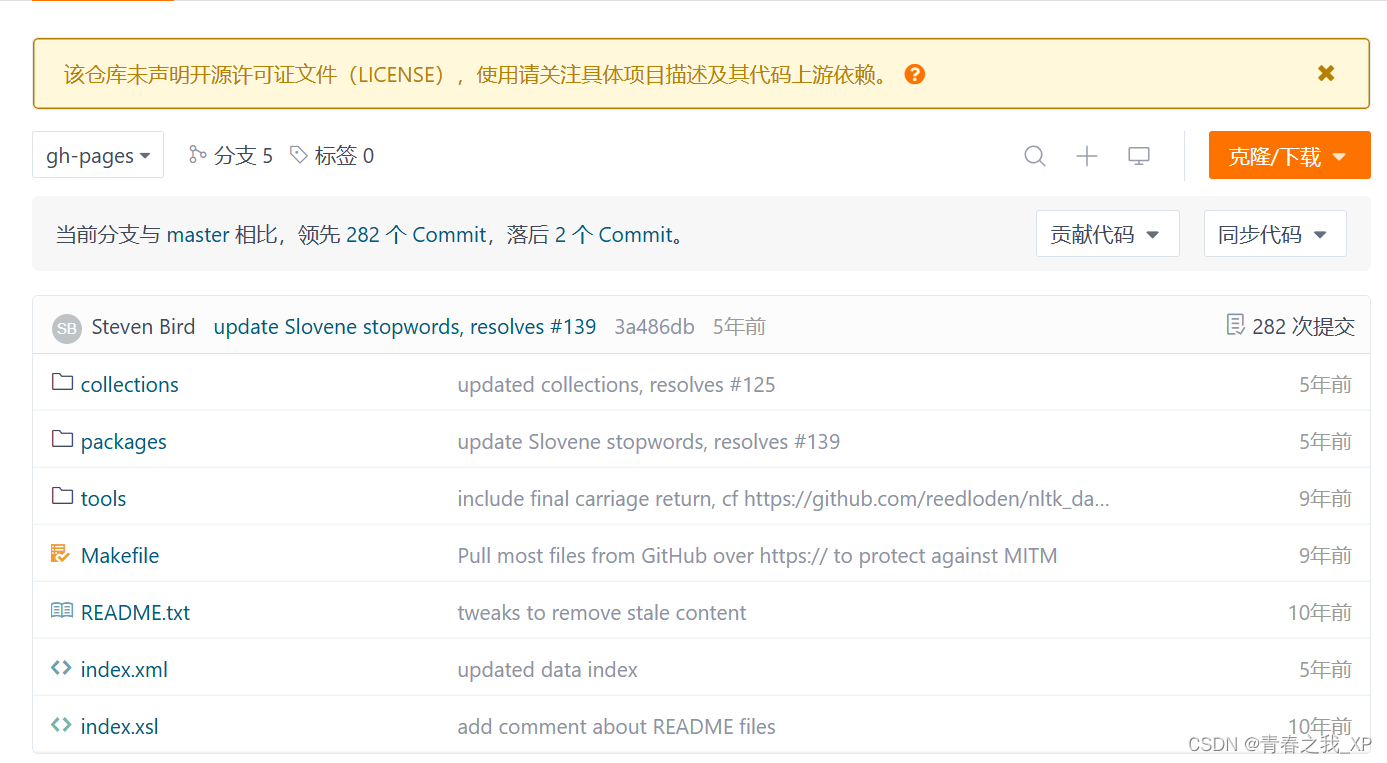

点击上方链接,进入到如下界面:

然后点击右上角的克隆下载,进入到如下界面,然后再点击下载zip,开始下载nltk_data-gh-pages.zip文件。

将下载得到的nltk_data-gh-pages.zip文件解压缩,解压缩后的内容如下:

重点:我们只需要其中的packages,将packages文件夹重新命名为nltk_data

二、将nltk_data文件夹移到对应的目录

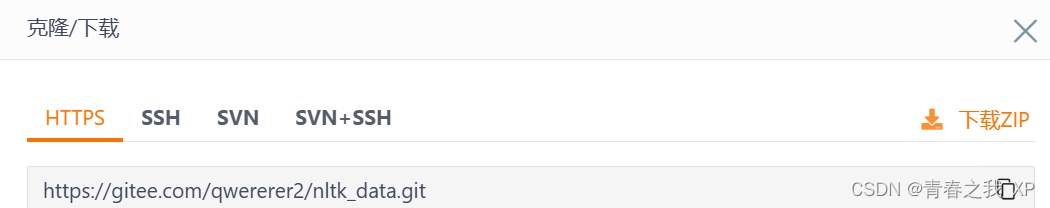

- import nltk

- nltk.find('.')

运行上方两行代码,我的运行结果是

则将nltk_data文件夹移动到Searched in下边的任意路径都可。

三、测试

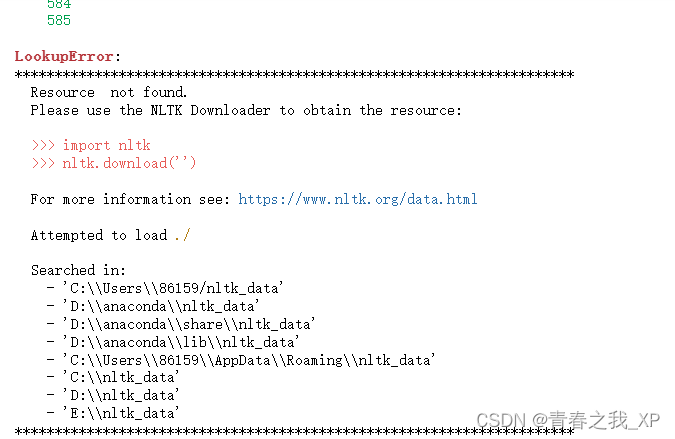

运行结果出现以下界面就是安装成功了。

四、成功调用punkt库

问题:

有的小伙伴在成功完成上边的步骤之后,在运行下边两行代码的时候仍然报错。

- import nltk

- nltk.download('punkt')

或者

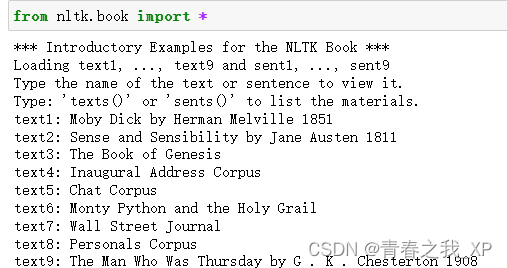

word_tokenize函数是 NLTK 库中的一个工具,用于将文本分解为单词。这个函数使用了一个名为punkt的 NLTK 数据文件,该数据文件包含了用于分词的语言特定的规则。

punkt是一个词法分析器(Lexical Analyzer),用于识别文本中的单词边界。它可以识别标点符号、空格和其他分隔符,并将文本分解成单词。在使用

word_tokenize函数进行分词之前,你需要确保已经下载了punkt数据文件。

运行下方代码时,仍然报错,报错的大概意思是没有punkt库。

- from nltk.tokenize import word_tokenize

- from nltk.text import Text

- input_str = "Today's weather is good, very windy and sunny, we have no classes in the afternoon,We have to play basketball tomorrow."

- tokens = word_tokenize(input_str)

解决方案:

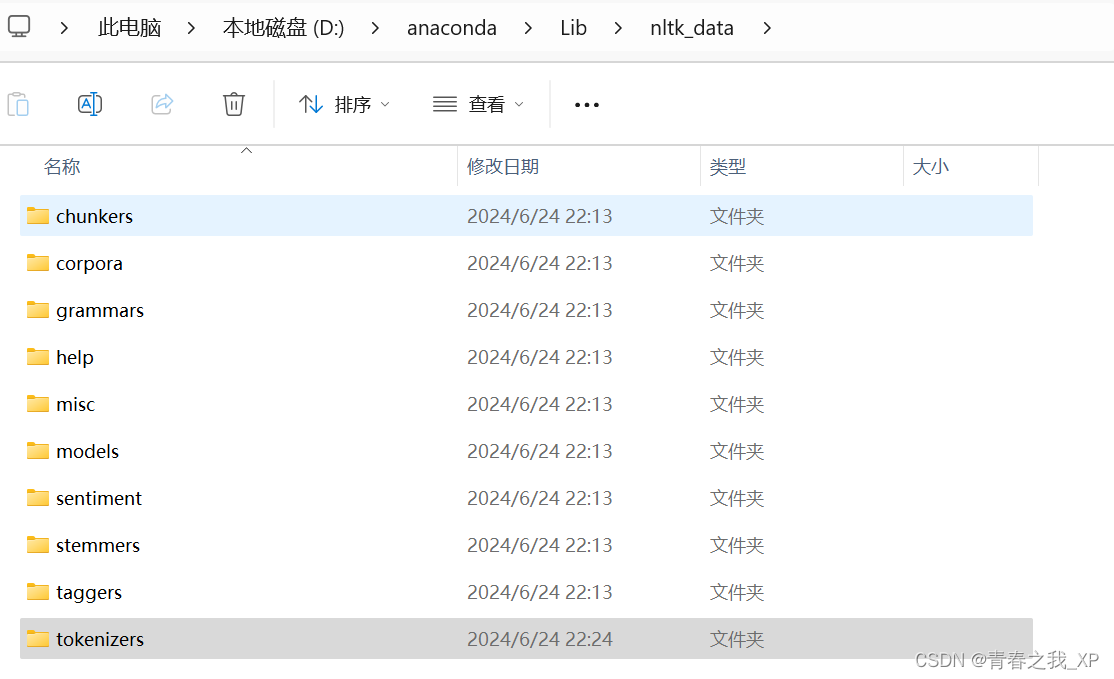

step1:打开刚刚路径下的nltk_data

step2:打开其中的tokenizers文件夹

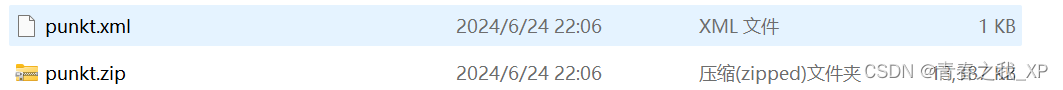

发现其中虽然有punkt,但是还没有解压,关键点就在于将其解压到当前文件路径下。

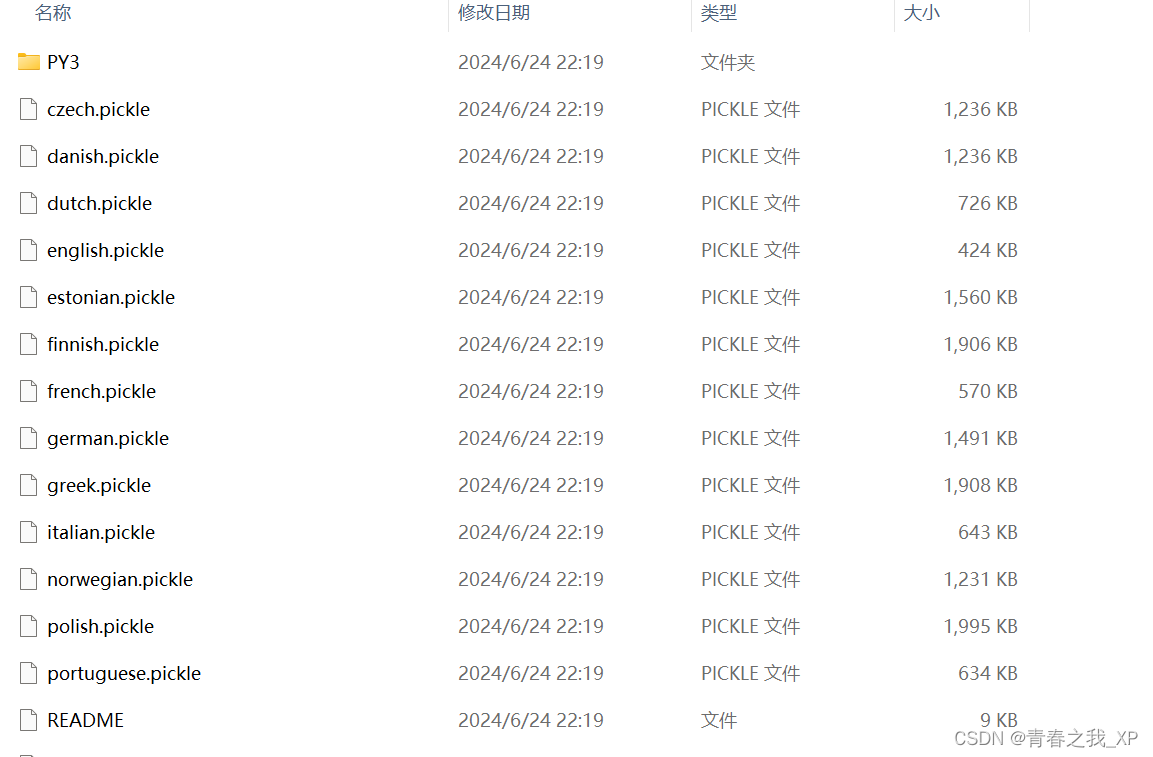

同时还有一个关键点需要注意,否则很有可能不成功。解压punkt.zip之后,punkt文件夹里的内容应该是如下:

如果打开punkt文件夹,里边还嵌套一个punkt文件夹,再打开第二个punkt文件夹之后才出现上方的界面,这样就需要删除一个punkt文件夹了。也就是避免nltk_data\tokenizers\punkt\punkt的情况出现,理想状态是nltk_data\tokenizers\punkt\