- 1第20天:信息打点-红蓝队自动化项目&资产侦察&企查产权&武器库部署&网络空间

- 2Xilinx Aurora IP应用介绍_pma_init

- 3学习可泛化的特定深度的结构表示CVPR2021_cvpr 结构信息

- 4【STM32F407VE】STM32F407VET6有1Mflash_stm32f407vet6flash大小

- 5(android 基础知识) ActivityManager(内存、进程、服务、任务)_android activitymanager

- 6实战|手把手教你用Python爬虫(附详细源码)

- 7【2024华为OD机试C卷】282、求满足条件的最长子串的长度 | 机试真题+思路参考+代码解析(C语言、C++、Java、Py、JS)_最长字符串长度二 od 2024

- 8数据结构之三元组的实现_ik jk sk生成三元组

- 9树莓派PICO入门教程

- 10Kafka高级&低级API、同异步发送及拦截器原理_kafka高级api低级api

【Python&;语义分割】Segment Anything(SAM)模型详细使用教程+代码解释(一)

赞

踩

2.3 单点输入mask,分割一个目标

这里的input_point指你想分割的兴趣点(图片坐标),这里的input_label代表目标的标签,如果你想要分割它input_label的值就为1,如果想排除它则值为0。

# --------------------------------------单点输入-------------------------------------- print("【单点分割阶段】") print("[%s]正在分割图片......" % datetime.now().strftime('%Y-%m-%d %H:%M:%S')) input_point = np.array([[250, 187]]) # 单点 prompt 输入格式为(x, y)和并表示出点所带有的标签1(前景点)或0(背景点)。 input_label = np.array([1]) # 点所对应的标签 plt.figure(figsize=(10, 10)) plt.imshow(image) show_points(input_point, input_label, plt.gca()) plt.axis('on') plt.show() masks, scores, logit = predictor.predict( point_coords=input_point, point_labels=input_label, multimask_output=True, # 为False时,它将返回一个掩码 ) # print(masks.shape) # (3, 2160, 3840)波段,高,宽 for i, (mask, score) in enumerate(zip(masks, scores)): # 三个置信度不同的图 plt.figure(figsize=(10, 10)) plt.imshow(image) show_mask(mask, plt.gca()) show_points(input_point, input_label, plt.gca()) plt.title(f"Mask {i + 1}, Score: {score:.3f}", fontsize=18) plt.axis('off') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

单点输入时,会出现三种不同置信度结果的图,可以自己选择。

2.4 多点输入masks,分割一/多个目标

这里的目标点可以同时输入多个,不同的lable可以控制不同的分割效果。如果label均为1,则将两个点分割成同一目标(单个输入点不明确,需要让模型返回了与其一致的多个对象)。如果label一个为1,一个为0则分割一个,排除一个。下面第一张图是label均为1的效果,第二张图为一个1,一个0的效果。此外还可以将先前迭代的掩码(logits值)提供给模型以帮助预测。

# --------------------------------------多点输入-------------------------------------- print("【多点分割阶段】") print("[%s]正在分割图片......" % datetime.now().strftime('%Y-%m-%d %H:%M:%S')) input_point = np.array([[250, 184], [562, 322]]) input_label = np.array([1, 0]) # input_label = np.array([1, 0])负点区域,用来排除该点 mask_input = logit[np.argmax(scores), :, :] # Choose the model's best mask # 将先前迭代的掩码logit值提供给模型以帮助预测 masks, _, _ = predictor.predict( point_coords=input_point, point_labels=input_label, mask_input=mask_input[None, :, :], multimask_output=False, ) # print(masks.shape) # output: (1, 600, 900) plt.figure(figsize=(10,10)) plt.imshow(image) show_mask(masks, plt.gca()) show_points(input_point, input_label, plt.gca()) plt.axis('off') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

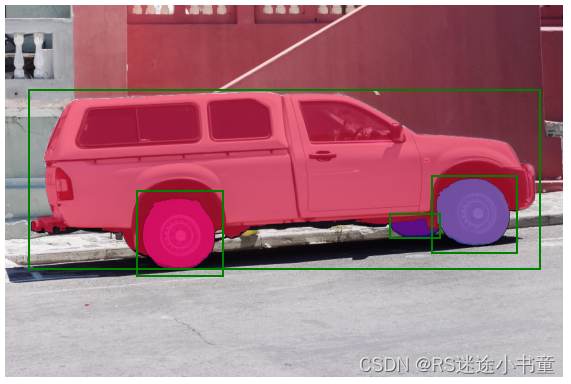

2.5 矩形输入mask,分割一个目标

SAM支持将xyxy格式(左上和右下角坐标)的矩形作为输入,将框内的主体目标识别出来。

# --------------------------------------矩形输入-------------------------------------- print("【矩形分割阶段】") print("[%s]正在分割图片......" % datetime.now().strftime('%Y-%m-%d %H:%M:%S')) input_box = np.array([212, 300, 350, 437]) masks, _, _ = predictor.predict( point_coords=None, point_labels=None, box=input_box[None, :], multimask_output=False, ) plt.figure(figsize=(10, 10)) plt.imshow(image) show_mask(masks[0], plt.gca()) show_box(input_box, plt.gca()) plt.axis('off') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

2.6 矩形+点同时输入masks,分割一个目标

点和矩形可以同时输入,只需定义这两种类型的label即可。在这里,这可以用来只选择卡车的轮胎(将车轴部分设置为负点),而不是整个车轮。需要注意的是矩形的label只能为1(正类)。

# --------------------------------------点&矩形输入-------------------------------------- print("【单点&矩形分割阶段】") print("[%s]正在分割图片......" % datetime.now().strftime('%Y-%m-%d %H:%M:%S')) input_box = np.array([215, 310, 350, 430]) # 只能默认框住正类 input_point = np.array([[287, 375]]) input_label = np.array([0]) # 将点设置为负点 masks, _, _ = predictor.predict( point_coords=input_point, point_labels=input_label, box=input_box, multimask_output=False, ) plt.figure(figsize=(10, 10)) plt.imshow(image) show_mask(masks[0], plt.gca()) show_box(input_box, plt.gca()) show_points(input_point, input_label, plt.gca()) plt.axis('off') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

2.7 多个矩形输入masks,分割多个目标

SamPredictor函数可以使用predict_tarch方法对同一图像输入多个提示(点、矩形)。该方法假设输入点已经是tensor张量,且boxes信息与image size相符合(已有来自对象检测器的输出结果)。

SamPredictor函数(也可以使用segment_anything.utils.transforms)可以将矩形信息编码为特征向量(以实现对多个矩形的支持,transformed_boxes),然后预测masks。

# --------------------------------------多矩形输入-------------------------------------- print("【多矩形分割阶段】") print("[%s]正在分割图片......" % datetime.now().strftime('%Y-%m-%d %H:%M:%S')) input_boxes = torch.tensor([ [75, 275, 1725, 850], [425, 600, 700, 875], [1375, 550, 1650, 800], [1240, 675, 1400, 750], ], device=predictor.device) # 假设为目标检测的预测结果 input_boxes = input_boxes/2 transformed_boxes = predictor.transform.apply_boxes_torch(input_boxes, image.shape[:2]) masks, _, _ = predictor.predict_torch( point_coords=None, point_labels=None, boxes=transformed_boxes, multimask_output=False, ) # print(masks.shape) # batch_size,num_predicted_masks_per_input,H,W ------>[4, 1, 600, 900] plt.figure(figsize=(10, 10)) plt.imshow(image) for mask in masks: show_mask(mask.cpu().numpy(), plt.gca(), random_color=True) for box in input_boxes: show_box(box.cpu().numpy(), plt.gca()) plt.axis('off') plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

3 总结

3.1 不足之处

以上代码来源于官方的demo,自己修改了一部分。官方的源码只能简单的进行点/矩形输入,每次分割前都需要手动确定目标的图片坐标(x,y)。如果分割做成交互式的会更好,例如我点击图片中的某个点,它就分某个目标。

另外官方的demo并没有保存图片的函数,如果3S工作者或者其他有需要的领域,可能需要保存分割后的mask就需要自己开发。我这里指的是单独保存mask,掩膜叠加底图显示的保存了也没啥用=。=

3.2 改进

官方还有一个全局分割的demo我还没有分享,那个我已经加入了保存mask的代码,所以就没跟这篇文章一起分享,后面会分享给大家。此外我还编了一个单点输入mask的交互式操作的代码,后面都会分享给大家。

总的来说,Segment Anything是真的强,官方的模型不夸张的说真的可以坐到分割万物。我自己拿高分辨率的遥感影像也试了试,建筑、树木、道路都分的还不错。

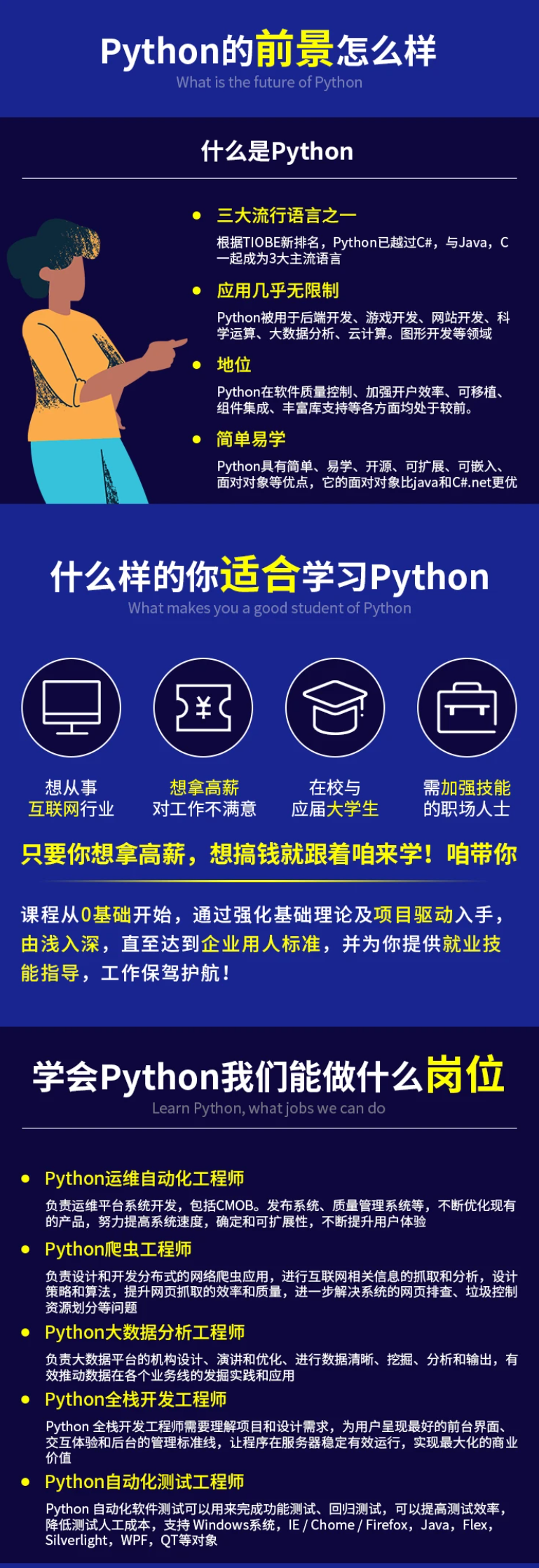

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

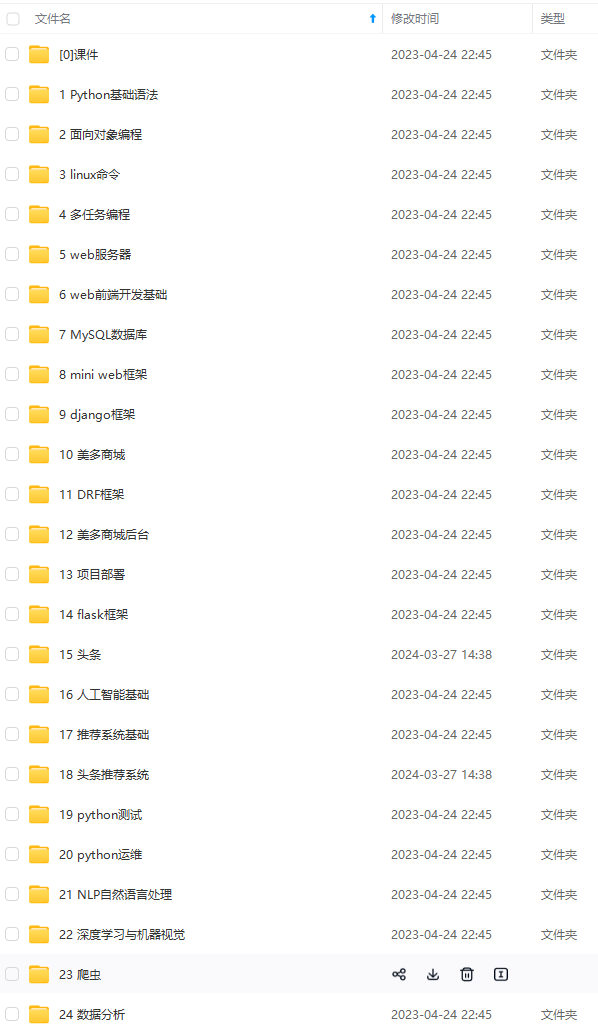

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注Python)

img_convert/9f49b566129f47b8a67243c1008edf79.png)

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注Python)