ESL第十一章 神经网络 投影追踪回归/岭函数/通用近似、径向基函数网络、随机近似/共轭梯度/变量度量、权重消去、信噪比计算、贝叶斯神经网络/贝叶斯推断/混合蒙特卡罗洛/哈密顿动力学/自动相关确定_投影追踪回归网络模型

赞

踩

11.1 导言

- P389 投影追踪模型projection pursuit model是在半参统计和光滑领域中发展来的

11.2 投影追踪回归Projection Pursuit Regression

-

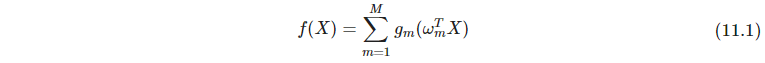

P389 投影追踪回归projection pursuit model(PPR)模型的问题定义

-

P390 岭函数ridge function

-

P390 通用近似universal approximator

-

P390 单指标模型single index model,计量经济学econometrics中的叫法。 M = 1 M=1 M=1的PPR。该模型比线性回归更加一般,也提供了一个类似的可解释性。而当 M > 1 M>1 M>1时的诸多模型,解释性就很差,像神经网络一样

-

P391 对于 M = 1 M=1 M=1,采用交替优化 g g g和 ω \omega ω的方式进行,关于 g g g当作是一个一维光滑问题,对于 ω \omega ω,则用一阶泰勒展开近似,导出带权线性回归。对于多个 M M M,则采用前向分段的方式,每次引入一对 ( ω m , g m ) (\omega_m, g_m) (ωm,gm)。其中的光滑 g g g,能求导最好,所以多用局部回归和光滑样条。通常 ω m \omega_m ωm没有被重新调整,没有backfitting过程

-

P392 14.7节的ICA和探索型投影追踪exploratory projection pursuit有关系

11.3 神经网络

- P392 径向基函数网络radial basis function network:高斯径向基作为激活函数

- P394 含一个隐藏层的神经网络实际上与PPR是类似的,区别在于PPR采用非参函数 g m ( v ) g_m(v) gm(v),神经网络采用固定的 σ ( v ) \sigma(v) σ(v),以及额外的第二层参数 β m \beta_m βm,还有第一层截距项和范数。公式11.7给出描述。由于PPR泛函空间大,所以用的项可能更少,例如 M = 5 , 10 M=5,10 M=5,10之类的

11.4 拟合神经网络

- P396 反向传播等式back-propagation equations

- P397 反向传播也叫做delta rule

- P397 学习率可以通过在每次更新时运用线搜索最小化误差函数来优化

- P397 学习的随机近似stochastic approximation形式,如果学习率满足Robbins and Munro算法的条件,无穷趋于0,一次和趋于无穷,二次和收敛,则神经网络保证收敛

- P398 二阶技巧矩阵太大,更好的拟合方式包括共轭梯度法conjugate gradients和变量度量方法variable metric methods,避免计算二阶矩阵,仍能很快收敛

11.5 训练神经网络中的一些问题

11.5.1 初始值

- P397 初始值设为0左右,网络一开始是退化成近似线性模型。之后会不断引入非线性

11.5.2 权重衰减

- P398 权重衰减weight decay

- P398 权重消去weight elimination,比L2的权重衰减更能收缩系数

11.5.3 输入的缩放

11.5.4 隐层单元数和层数

11.5.5 多极小值

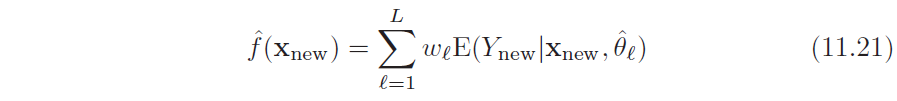

- P401·随机初始化参数,然后多训找最好的,或者对一系列预测值进行平均。另一种方式bagging则对随机扰动(应该是bootstrap)的训练数据集进行训练得到

11.6 例子:模拟数据

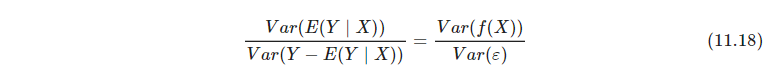

- P401 信噪比计算公式

- P401 模拟两个sigmoid加性结果的神经网络回归,如果初始化不好,用两个隐藏层可能还拼不过直接线性回归,书上做了10个例子,有两个拼不过

- P402 加大正则化,确实管用(这里回想第三章,加一点正则化,虽然bias变大了,有偏了,但是variance可能降得很多,就如这里的例子所示,hidden layer多的时候之所以效果差就是因为variance太大了)

11.7 例子:邮编数字

- P407 提到了:正切距离方式tangent distance approach,会在3.3.3节讲

- P408 boosted LeNet-4,在手写数字上效果超过了经典的LeNet-5

11.8 讨论

- P408 神经网络适用于高信噪比和不需要解释的预测问题

- P409 神经网络是实值参数的连续函数,促使了贝叶斯推断bayesian inference的发展

11.9 贝叶斯神经网络和NIPS2003挑战

11.9.1 贝叶斯、提升和bagging

- P410 混合蒙特卡洛hybrid monte carlo、哈密顿动力学hamiltonian dynamics

- P411 自动相关确定automatic relevance determination筛选特征

- P411 bagging和boosting,与贝叶斯方法中的MCMC有一些相似之处。MCMC扰动参数、bagging扰动数据然后重新估计模型给出一组新的模型参数

这些模型都可以写成如下形式

11.9.2 性能比较

- P413 bayse neural network、boosted tree、boosted neural network、random forest、bagged neural network性能大比拼

- P414 内部特征选择方法可能会提升boosted neural network,也即设计一种自然的、self-contained的特征筛选方式

- P414 贝叶斯神经网络慢啊

参考文献:

[1] Trevor Hastie, Robert Tibshirani, Jerome Friedman. The Elements of Statistical Learning, Second Edition

[2] ESL CN