- 1redis-哨兵模式

- 2安装oh my zsh失败: 连接 raw.githubusercontent.com (raw.githubusercontent.com)|0.0.0.0|:443... 解决办法_链接raw.github

- 3Python内置函数详解,进阶必备_python 内置函数定义

- 4网络协议---MPL(2):RFC 7731文档翻译_mpl2协议

- 5wayland xmodmap 键盘按键映射失效,转 evremap。wps fcitx5 输入法失效

- 6GDCM:gdcm::LO的测试程序_mv.gdcm.into

- 7【自然语言处理】第3部分:识别文本中的个人身份信息_pipeline("ner", grouped_entities=true)的输出是什么

- 8java通过maven导入本地jar包的三种方式

- 9git创建远程分支并关联本地分支_git创建远程branch

- 10基于 KubeBlocks 的 PikiwiDB(原Pika) 云化下一站

ZYNQ+NVMe 小型化全国产存储方案

赞

踩

1、背景说明

针对小型化的存储场景,使用单片ZYNQ7045/7100(复旦微FMQL45T900/FMQL100TAI)FPGA,实现数据接口、存储、文件系统管理、导入导出等功能。

实现规格:

1) 2盘组成RAID阵列,双盘4TB容量

2)EXT4标准文件系统

3)EXT4文件系统下2GB/s的写、读速度;自定义文件系统4GB/s的写、读速度。

4)万兆网网盘导出、千兆网盘导出、FTP导出

2、设计方案

2.1 FPGA设计方案

2.1.1 NVMe控制器

FPGA实现NVMe控制器,配合PCIe(软核/硬核),实现对NVMe电子盘的驱动控制功能。

PCIe实现2.0/3.0等不同的速率规格,可以针对不同的速率要求情况。

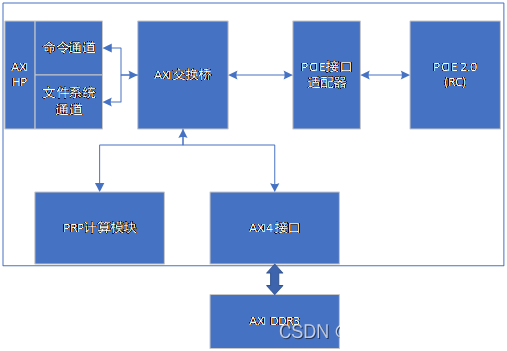

NVME控制器主要由PCIE接口适配器、AXI交换桥、PRP计算模块以及命令/文件系统通道模块构成。

PCIE接口适配器通过逻辑实现AXI的Master接口以及Slave接口到PCIE的接口转换。由AXI的Master接口实现盘主动读写内存的功能,由AXI的Slave接口实现PS对盘的SQ/CQ队列的读写。

PRP计算模块实现解析盘请求的PRP2地址,计算、传送内存页地址给盘,从而实现大于4KB的读写请求的内存地址传送功能。

命令通过通过解析PS传送过来的SQ指令,填充RPR1、PRP2地址,使数据通道始终指向PL DDR,以及文件系统数据始终指向PS DDR,文件系统通道由盘主动读写PS DDR实现。

数据通道通过盘解析SQ指令,通过AXI桥,主动访问PL DDR实现。

2.1.2 PCIE控制器

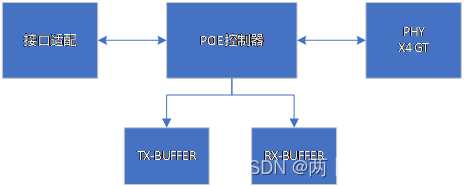

PCIE控制器主要完成PCIE协议传输层以及数据链路层协议。组TLP包发送给PHY控制器;对PHY层数据解析成TLP、LCRC、Sequence number等字段;实现ACK/NCK协议保证报文的可靠性;流控制管理,根据链路层报文更新credit值。

PHY控制器主要实现PMA/PCS层协议,实现高速串行总线的串并转换以及8B/10B编码等功能。接口适配功能将TL层自定义接口转换成标准的AXI Stream总线接口。

PCIE控制器可使用软核实现,也可以使用器件内的硬核。

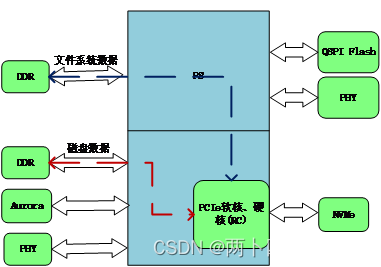

2.2 软件设计方案

SOC处理器PL和PS协同工作,共同完成数据高速实时记录、传输、存储、加卸载和文件管理等功能。 SOC内部采用异构的架构,PL完成带宽要求高、实时性要求高的底层协议转换处理,如以太网UDP协议处理、NVMe协议处理等,PS完成数据量比较小的处理,如文件系统管理、以太网L3以上的相关处理等。同时,PS还负责单板管理、版本在线升级、温度、电源电压等健康检测。

FPGA内部实现接口处理,包解析处理,对于要记录和加载的数据,经过包解析后会送到核心交换模块,进行存储接口的调配以及和PS的文件系统管理的交互。

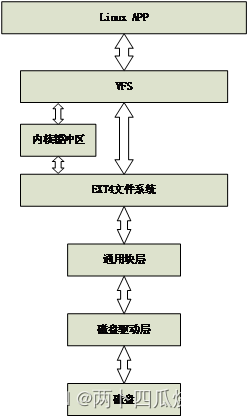

软件驱动方案如下:

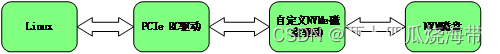

2.2.1 NVMe磁盘驱动设计

Linux应用层接受相关读写NVMe磁盘指令,通过PCIe硬核驱动将控制命令队列发送给自定义NVMe磁盘驱动,自定义驱动程序根据数据类型不同,然后将队列存放于PS端的DDR中,并通过门铃告知NVMe磁盘。磁盘接收到门铃通知后,去相应地址读取指令并解码,然后执行相关读写流程。

2.2.2 NVMe EXT4文件系统管理

Linux系统应用层接受读写磁盘命令。触发系统调用函数,进程由用户态转换到内核态,文件系统通过目录项检索缓存,如果没有则创建文件。通过虚拟文件系统接口调用具体文件系统读写函数,此处为ext4文件系统。

经过文件系统的管理,创建磁盘管理的IO请求,此处IO请求分为,文件系统管理IO请求与原始数据读写请求。将修改后的IO请求发送给磁盘驱动,磁盘解码命令,并执行相关IO请求。

Linux ext4文件系统读写控制流程如下:

3、测试结果

3.1 硬件测试平台说明

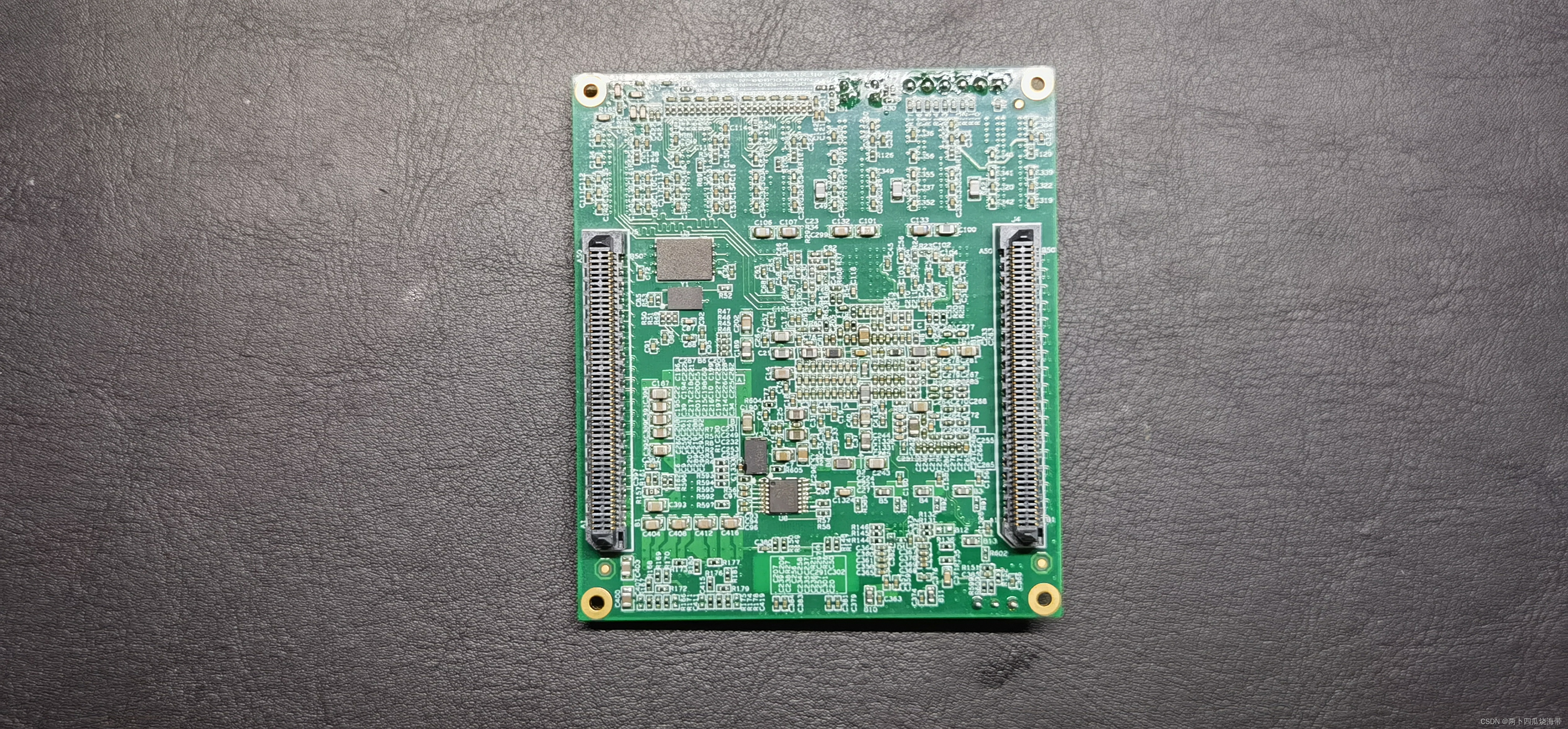

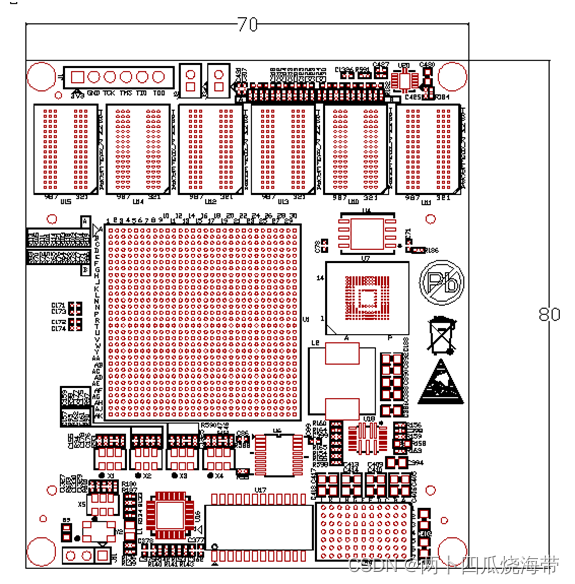

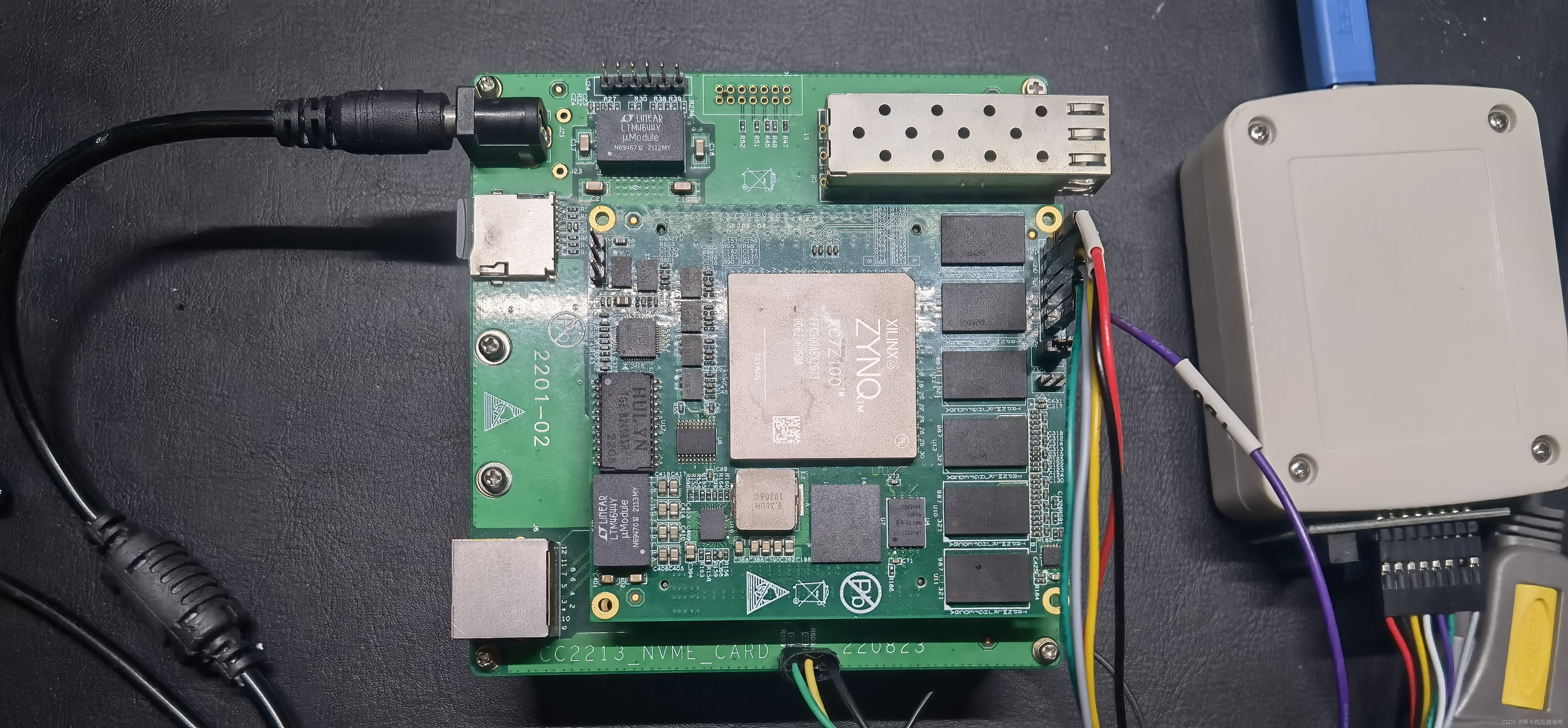

使用XILINX的ZYNQ7100作为测试核心板,如下图所示:

核心板背面为连接器

核心板的尺寸为 70mm x 80mm

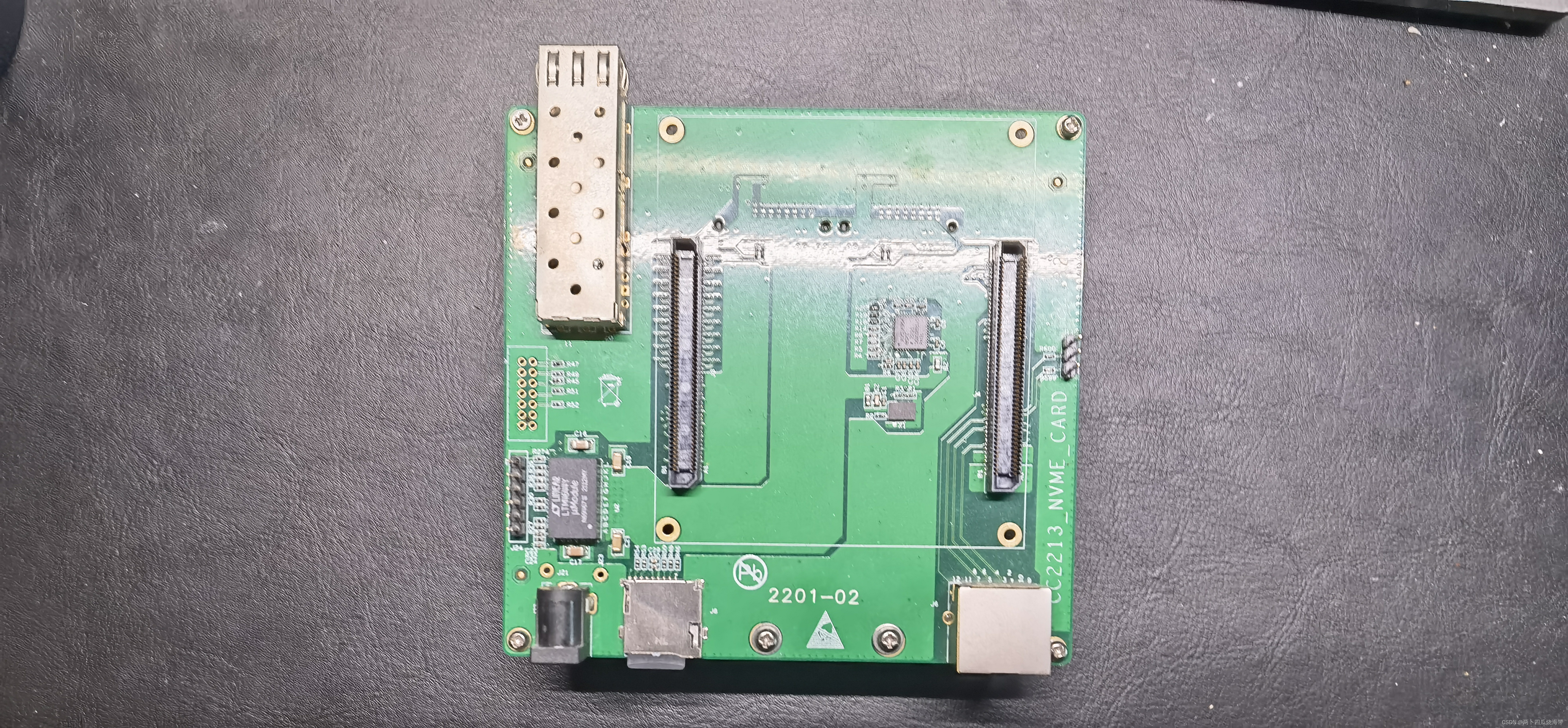

底板上放两块NVMe的电子盘,核心板插在底板上进行测试。

整体硬件测试平台如下图:

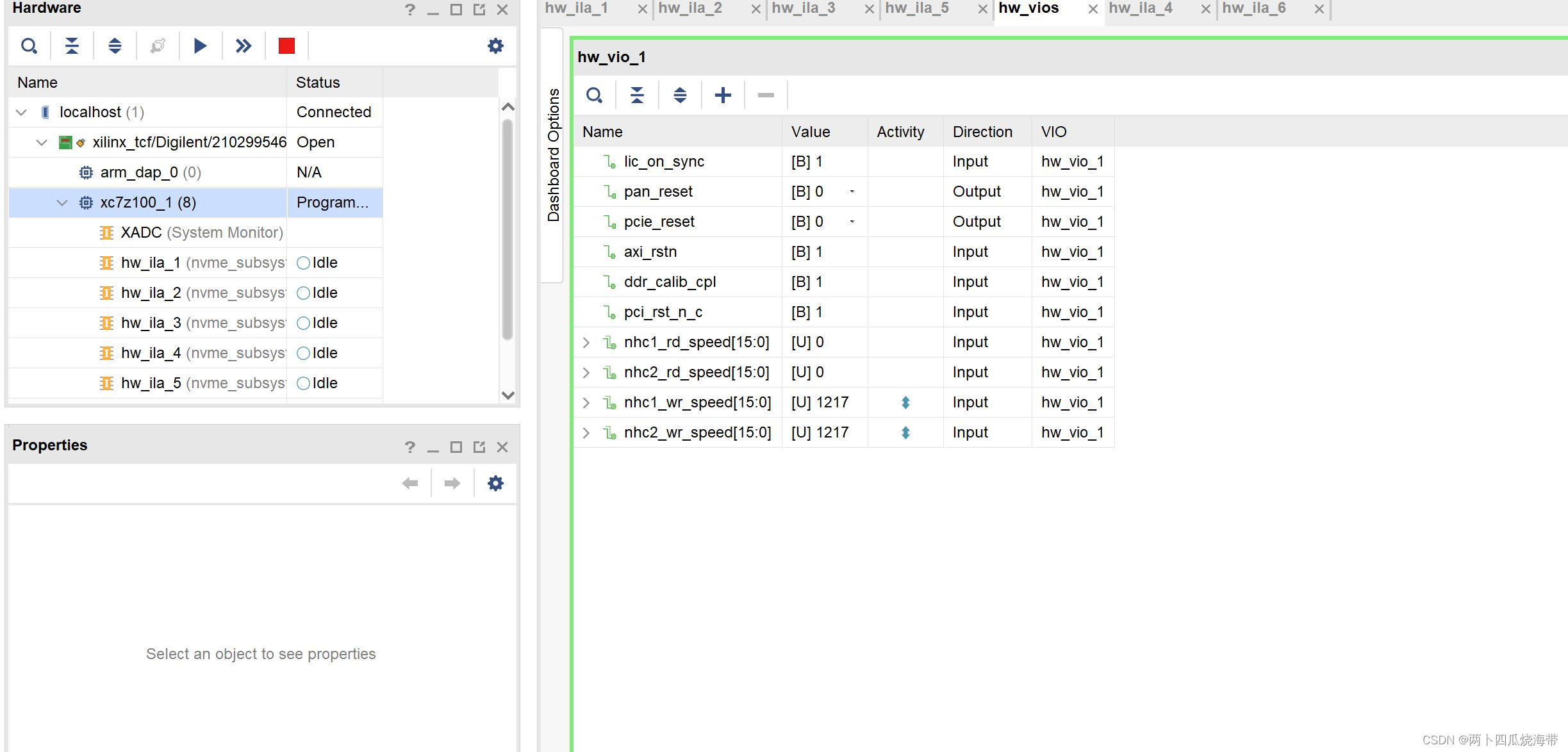

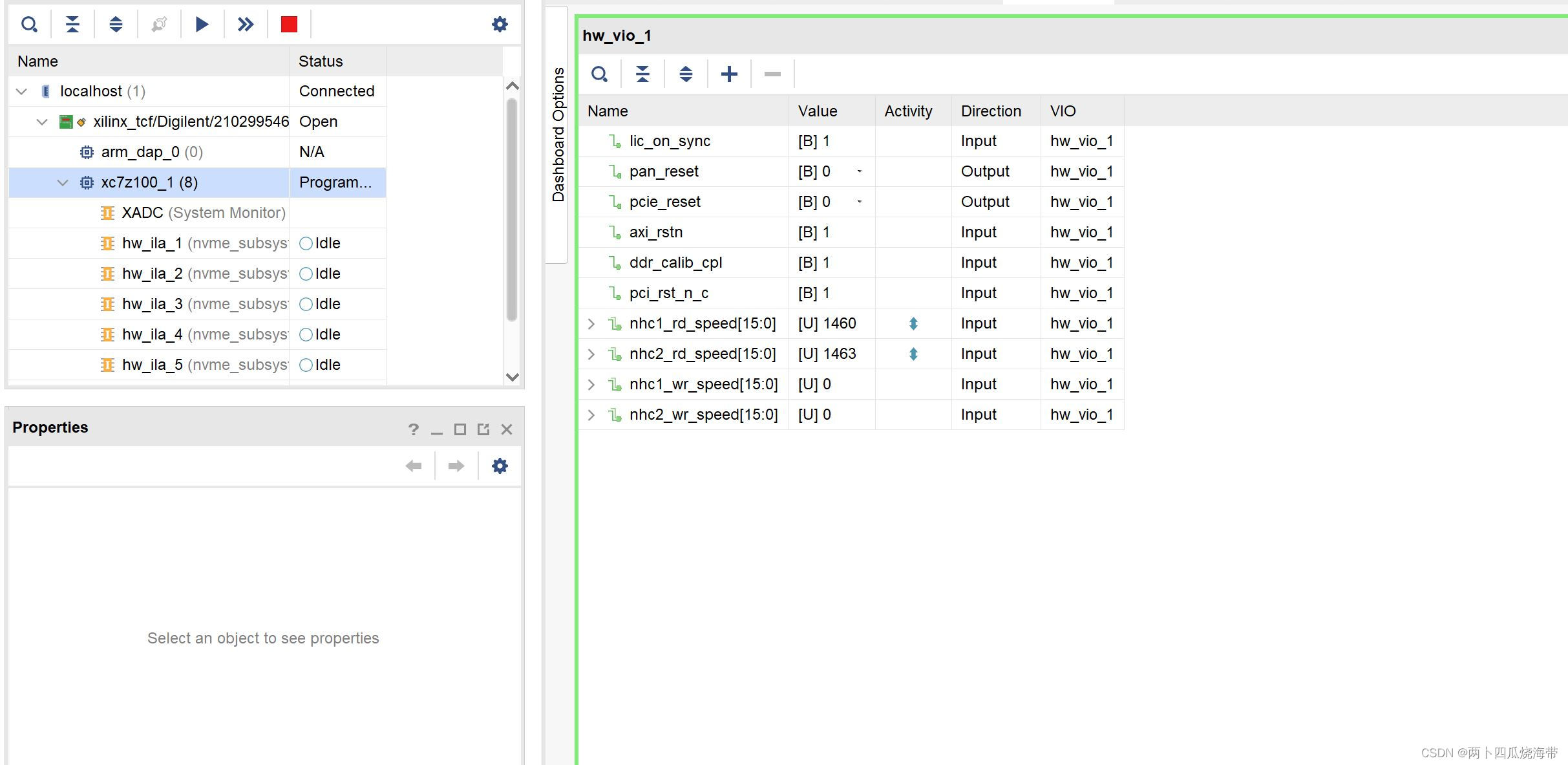

3.2 裸机测试,PCIE Gen2

每个盘写入1.2GB/s, Raid0可达到2.4GB/s

每个盘读出1.4GB/s, Raid0可达到2.8GB/s

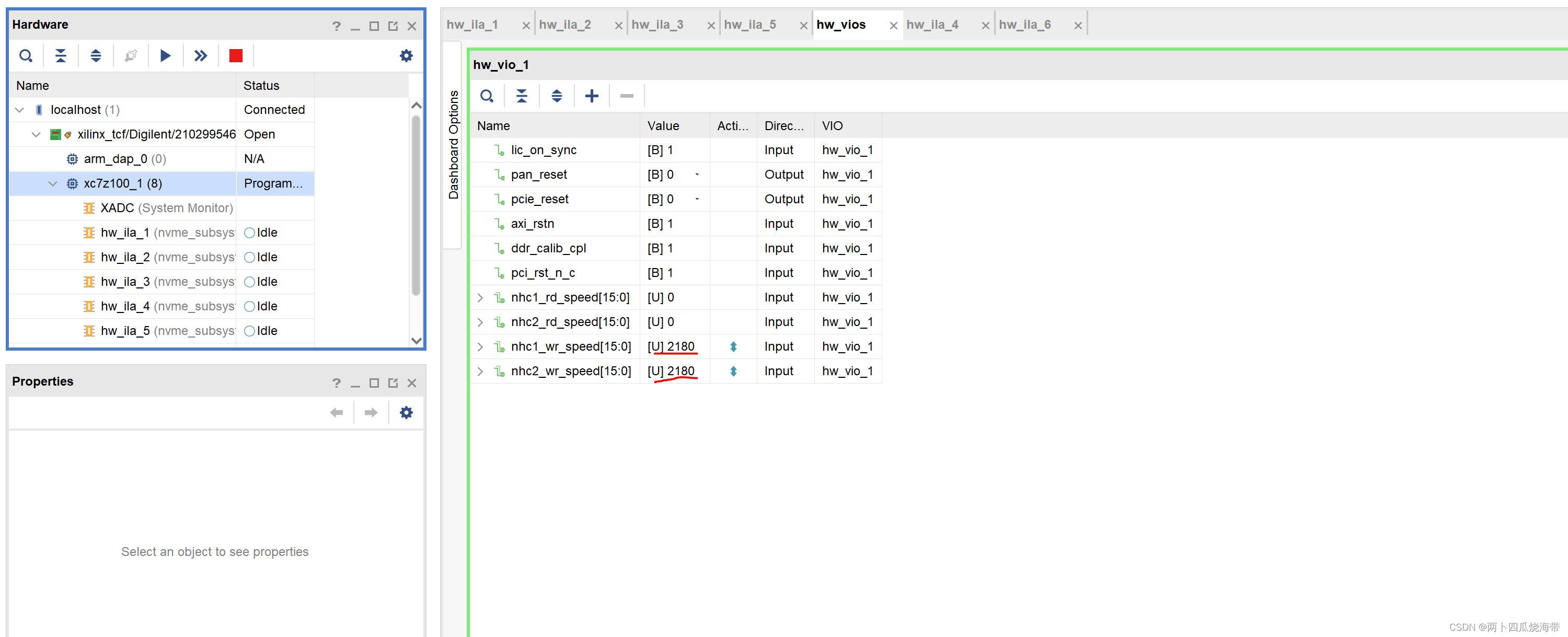

3.3 裸机测试,PCIE Gen3

每个盘写入2.1GB/s, Raid0可达到4.2GB/s

每个盘读出1.7GB/s, Raid0可达到3.4GB/s

3.4 带文件系统测试,PCIE Gen2

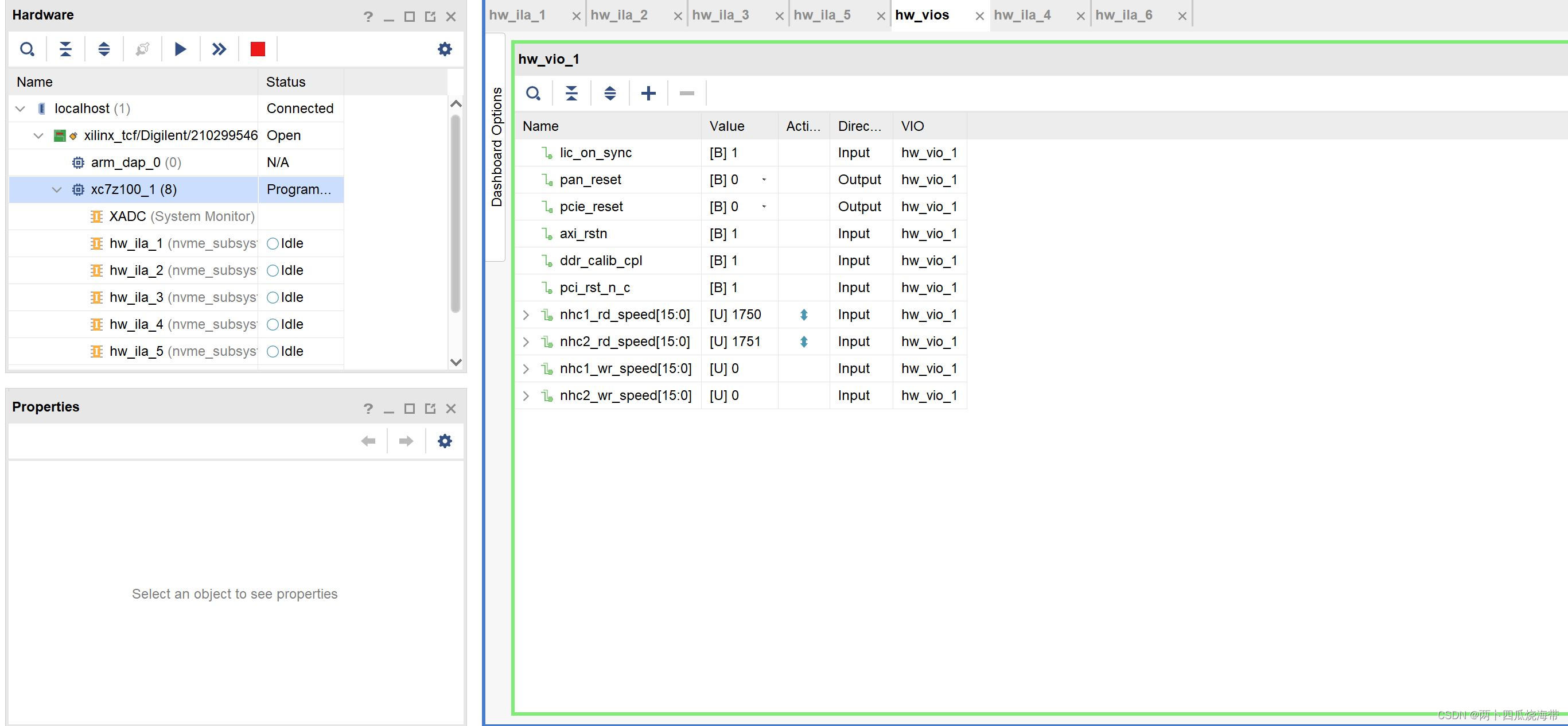

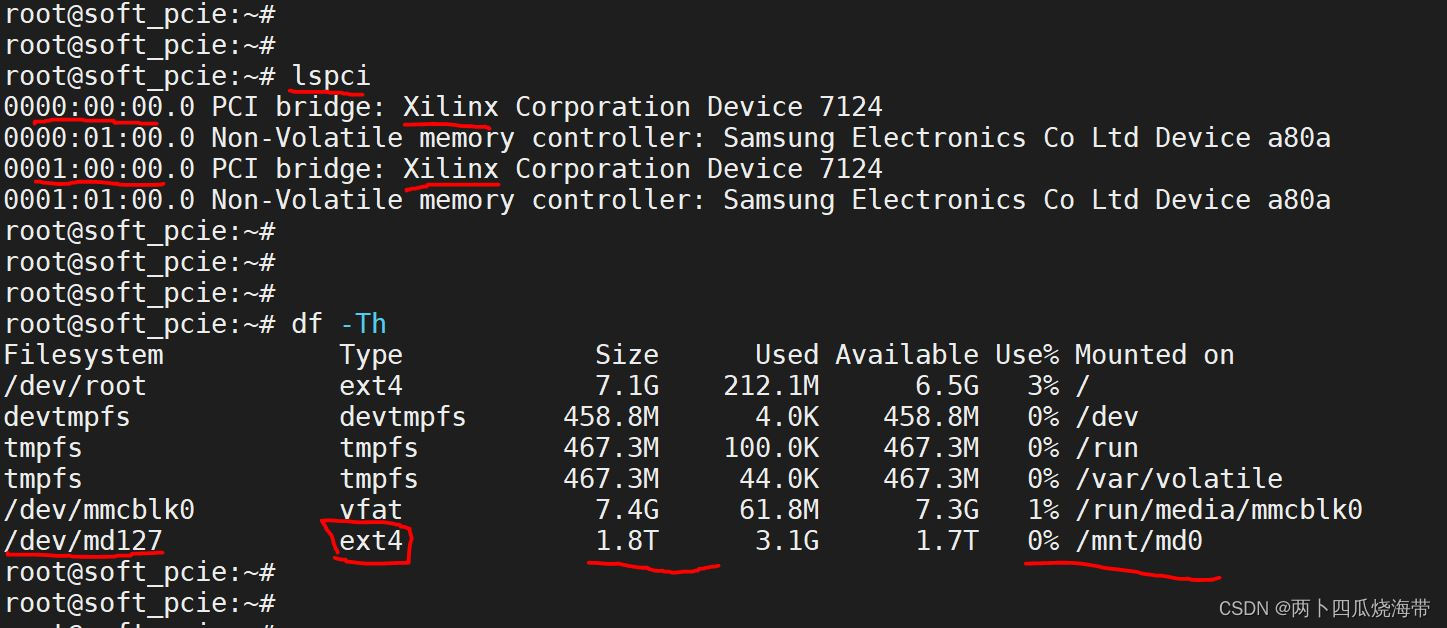

可以看到,在系统下有两个Xilinx的PCIe设备。

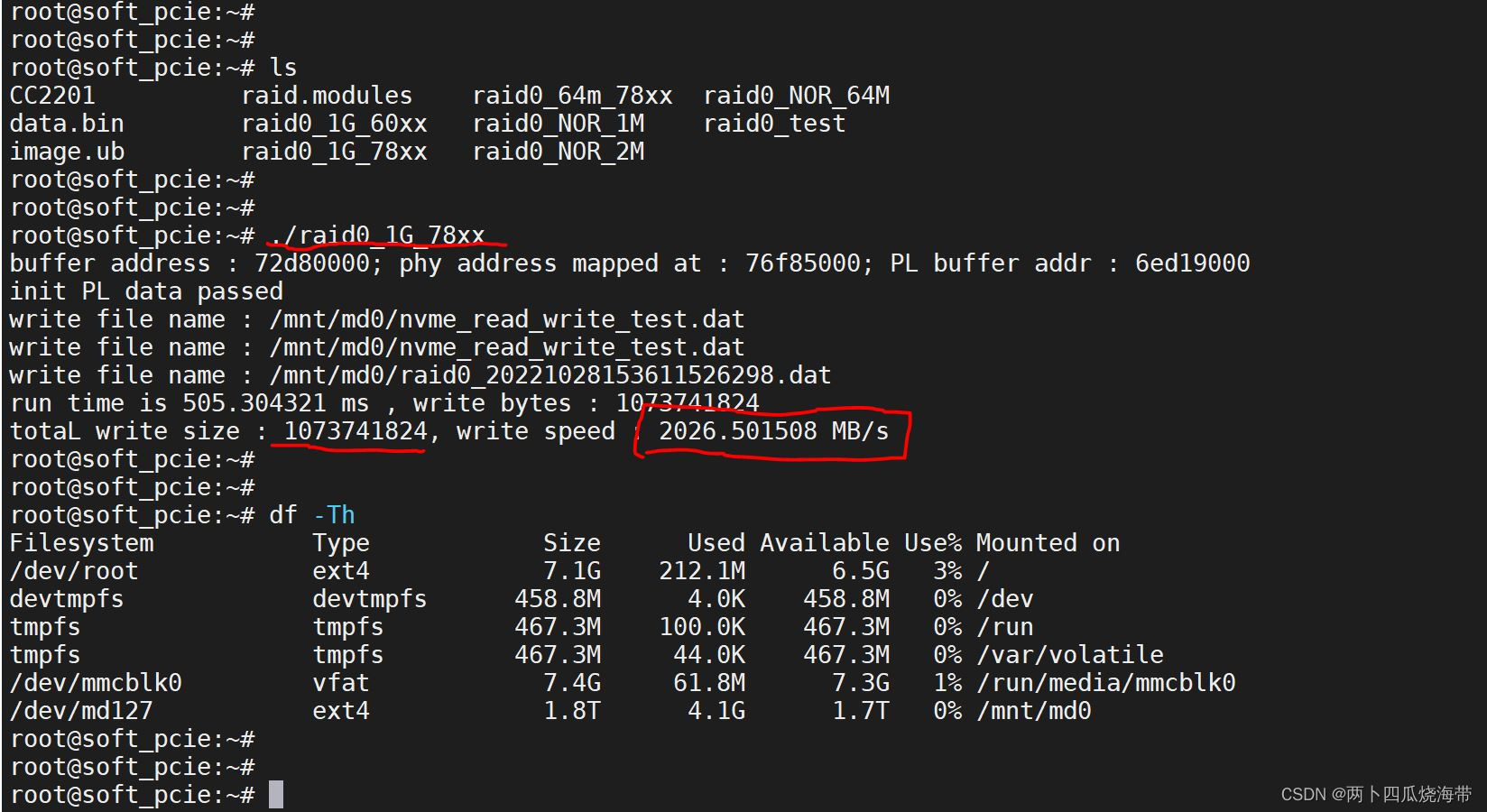

2块1TB的盘组成RAID0阵列,文件系统为ext4。

写入1GB的数据,可以看到速度为2GB/s

4、总结

按照本文方式处理,使用ZYNQ标准的文件系统下可以达到2GB/s的存储带宽。该方案的文件系统采用标准的Linux内核系统,移植性好,成本低,运行也稳定。

通过PCIE核的更换,PCIe核的增加,也能够适应不同的存储带宽核存储容量的需求。

如果有技术实现细节相关的讨论,欢迎来电交流,13882182579。