- 1时序图中if else画法_时序图 if else

- 2桌面运维岗面试三十问

- 3brew mysql 失败_Mac mysql安装失败解决方法

- 4FPGA设计之时序约束---常用指令与流程_input_delay_max

- 5【实战】TF-IDF,WORD2VEC,机器学习算法,深度学习算法在新浪新闻分类表现。_word2vec svm新闻文本分类

- 6【2022研电赛】兆易创新杯全国二等奖:自动驾驶汽车路面目标智能检测系统_电子大赛 智能识别

- 7git合并远程库并将代码合并完提交到自己的分支的流程_合并其他人的代码后提交自己的代码

- 8Gitlab设置中文

- 9some 术语 1

- 10SQL Server 中,删除表数据有以下几种方式_sqlserver删除表

YOLO系列创新点集合_yolov5创新

赞

踩

一、ACON激活函数

Ma, Ningning, et al. “Activate or not: Learning customized activation.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021.

论文地址:

https://arxiv.org/pdf/2009.04759.pdf.

论文简介

ReLU激活函数在很长一段时间都是最佳的神经网络激活函数,主要是由于其非饱和、稀疏性等优秀的特性,但是它也同样会产生神经元坏死的严重后果。而近年来人们使用NAS搜索技术找到的Swish激活函数效果非常好,但是问题是Swish激活函数是使用NAS技术暴力搜索出来的,我们无法真正解释Swish激活函数效果这么好的真正原因是什么?

在这篇论文中,作者尝试从Swish激活函数和ReLU激活函数的公式出发,挖掘其中的平滑近似原理(Smooth Approximation),并且将这个原理应用到Maxout family激活函数,提出了一种新型的激活函数:ACON family 激活函数。通过大量实验证明,ACON family 激活函数在分类、检测等任务中性能都优于ReLU和Swish激活函数。

ACON family

作者提出一种新颖的Swish函数解释:Swish函数是ReLU函数的平滑近似(Smoth maximum),并基于这个发现,进一步分析ReLU的一般形式Maxout系列激活函数,利用Smoth maximum将Maxout系列扩展得到简单且有效的ACON系列激活函数:ACON-A、ACON-B、ACON-C。

同时提出meta-ACON,动态的学习(自适应)激活函数的线性/非线性,控制网络每一层的非线性程度,显著提高了表现。另外还证明了ACON的参数P1和P2 负责控制函数的上下限(这个对最终效果由很大的意义),参数β \betaβ负责动态的控制激活函数的线性/非线性。

参数β \betaβ负责动态的控制激活函数的线性/非线性,这种定制的激活行为有助于提高泛化和传递性能

meta-ACON激活函数中参数β \betaβ,通过一个小型卷积网络,并通过Sigmoid函数学习得到。

ACON激活函数的性质:

ACON-A(Swish函数)是ReLU函数的平滑近似(Smoth maximum).

ACON-C的一阶导数的上下界也是通过P1和P2两个参数来共同决定的,通过学习,能获得性能更好的激活函数.

参数β \betaβ负责动态的控制激活函数的线性/非线性,这种定制的激活行为有助于提高泛化和传递性能.

meta-ACON激活函数中参数β \betaβ,通过一个小型卷积网络,并通过Sigmoid函数学习得到.

二、引入transformer

Bottleneck Transformers for Visual Recognition

Aravind Srinivas, Tsung-Yi Lin, Niki Parmar, Jonathon Shlens, Pieter Abbeel, Ashish Vaswani

YOLOv5主干特征提取网络为CNN网络,CNN具有平移不变性和局部性,缺乏全局建模长距离建模的能力,引入自然语言处理领域的框架Transformer来形成CNN+Transformer架构,充分两者的优点,提高目标检测效果,对小目标以及密集预测任务会有一定的提升效果。

原理:

BoTNet是一种简单却功能强大的backbone,该架构将自注意力纳入了多种计算机视觉任务,包括图像分类,目标检测和实例分割。通过仅在ResNet的最后三个bottleneck blocks中用全局自注意力替换空间卷积,并且不进行其他任何更改,在目标检测方面显著改善了基线,同时还减少了参数,从而使延迟最小化。

Transformer中的MHSA和BoTNet中的MHSA的区别:

归一化,Transformer使用 Layer Normalization,而BoTNet使用 Batch Normalization。

非线性激活,Transformer仅仅使用一个非线性激活在FPN block模块中,BoTNet使用了3个非线性激活。

输出投影,Transformer中的MHSA包含一个输出投影,BoTNet则没有。

优化器,Transformer使用Adam优化器训练,BoTNet使用sgd+ momentum

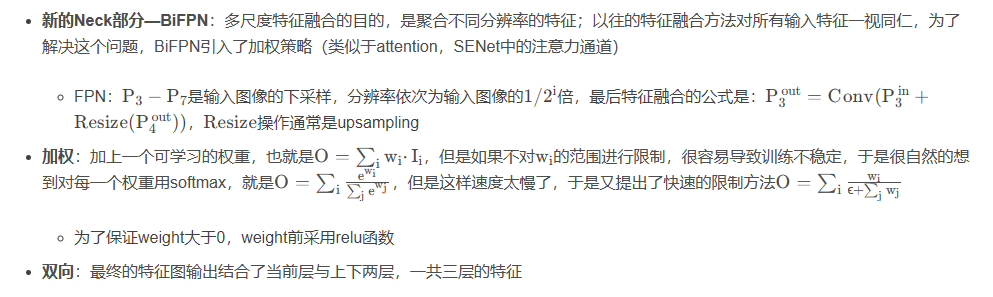

三、BiFPN特征融合

[Cite]Tan, Mingxing, Ruoming Pang, and Quoc V. Le. “Efficientdet: Scalable and efficient object detection.” Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2020.

论文简介

本文系统地研究了用于目标检测的神经网络结构设计选择,并提出了几个关键的优化方法以提高效率

首先,提出了一种加权双向特征金字塔网络(BiFPN),该网络可以实现简单快速的多尺度特征融合

其次,提出了一种Compound Scaling方法,该方法可以同时对所有主干网络、特征网络和盒类预测网络的分辨率、深度和宽度进行统一标度

基于这些优化措施和EfficientNet backbone,开发了一个新的对象检测器系列,称为EfficientDet

双向加权特征金字塔BiFPN

对于多尺度融合,在融合不同的输入特征时,以往的研究(FPN以及一些对FPN的改进工作)大多只是没有区别的将特征相加;然而,由于这些不同的输入特征具有不同的分辨率,我们观察到它们对融合输出特征的贡献往往是不平等的。

为了解决这一问题,作者提出了一种简单而高效的加权(类似与attention)双向特征金字塔网络(BiFPN),它引入可学习的权值来学习不同输入特征的重要性,同时反复应用自顶向下和自下而上的多尺度特征融合:

四.非极大值抑制NMS算法改进Soft-nms

YOLOv5默认采用NMS算法,主要是通过IoU来筛选出候选框。NMS主要就是通过迭代的形式,不断的以最大得分的框去与其他框做IoU操作,并过滤那些IoU较大(即交集较大)的框。NMS缺点:1、NMS算法中的最大问题就是它将相邻检测框的分数均强制归零(即将重叠部分大于重叠阈值Nt的检测框移除)。在这种情况下,如果一个真实物体在重叠区域出现,则将导致对该物体的检测失败并降低了算法的平均检测率。2、NMS的阈值也不太容易确定,设置过小会出现误删,设置过高又容易增大误检。采用soft nms进行改进。

原 理:

NMS算法是略显粗暴,因为NMS直接将删除所有IoU大于阈值的框。soft-NMS吸取了NMS的教训,在算法执行过程中不是简单的对IoU大于阈值的检测框删除,而是降低得分。算法流程同NMS相同,但是对原置信度得分使用函数运算,目标是降低置信度得分.1、Soft-NMS可以很方便地引入到object detection算法中,不需要重新训练原有的模型、代码容易实现,不增加计算量(计算量相比整个object detection算法可忽略)。并且很容易集成到目前所有使用NMS的目标检测算法。2、soft-NMS在训练中采用传统的NMS方法,仅在推断代码中实现soft-NMS。3、NMS是Soft-NMS特殊形式,当得分重置函数采用二值化函数时,Soft-NMS和NMS是相同的。soft-NMS算法是一种更加通用的非最大抑制算法。

五.锚框K-Means算法改进K-Means++

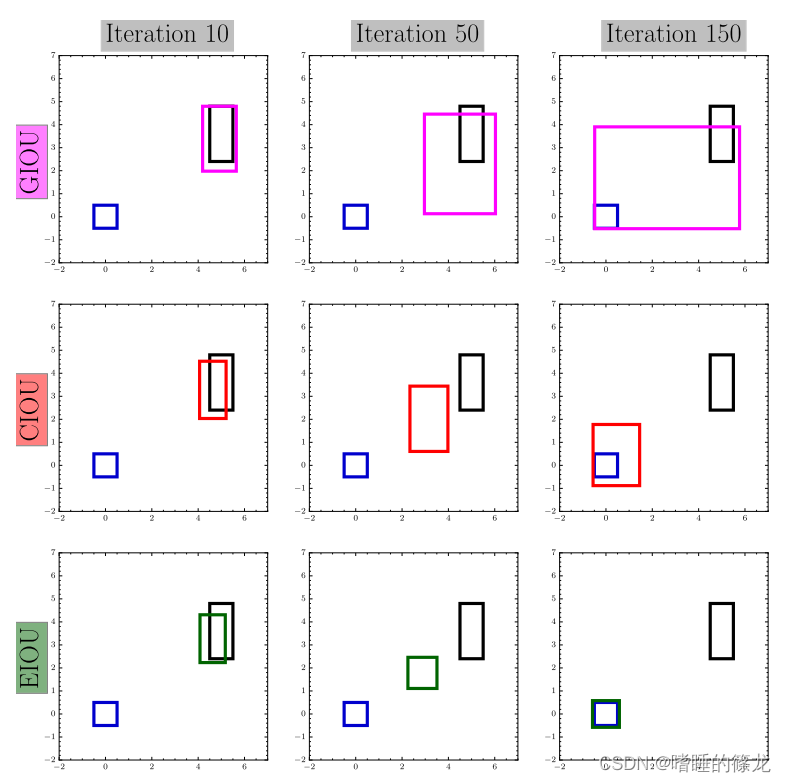

六.结合EIoU、Alpha-IoU损失函数

Zhang, Yi-Fan, et al. “Focal and efficient IOU loss for accurate bounding box regression.” arXiv preprint arXiv:2101.08158 (2021).

CIoU损失是在DIoU损失的基础上添加了衡量预测框和GT框纵横比v vv,在一定程度上可以加快预测框的回归速度,但是仍然存在着很大的问题:

在预测框回归过程中,一旦预测框和GT框的宽高纵横比呈现线性比例时,CIoU中添加的相对比例的惩罚项便不再起作用

根据预测框w和h的梯度公式可以推知,w和h在其中一个值增大时,另外一个值必须减小,它俩不能保持同增同减

为了解决这个问题,EIoU提出了直接对w和h的预测结果进行惩罚的损失函数:

下图是GIoU、CIoU和EIoU损失预测框的迭代过程对比图,红色框和绿色框就是预测框的回归过程,蓝色框是真实框,黑色框是预先设定的锚框:

GIoU的问题是使用最小外接矩形的面积减去并集的面积作为惩罚项,这导致了GIoU存在先扩大并集面积,再优化IoU的走弯路的问题

CIoU的问题是宽和高不能同时增大或者减小,而EIoU则可以

Alpha-IoU

He, Jiabo, et al. “$\alpha $-IoU: A Family of Power Intersection over Union Losses for Bounding Box Regression.” Advances in Neural Information Processing Systems 34 (2021).

由于IoU Loss对于bbox尺度不变,可以训练出更好的检测器,因此在目标检测中常采用IOU Loss对预测框计算定位回归损失(在YOLOv5中采用CIoU Loss)

而本文提出的Alpha-IoU Loss是基于现有IoU Loss的统一幂化,即对所有的IoU Loss,增加α \alphaα幂,当α \alphaα等于1时,则回归到原始各个Loss