热门标签

热门文章

- 1Java获取cpu和内存相关参数_java获取内存信息

- 2前端技能树,面试复习第 27 天—— React Diff 算法的原理,和 Vue 有什么区别 | 虚拟 DOM | key 的原理,为什么要用_react和vuediff算法区别

- 3vue2引入Element UI组件去创建新页面的详细步骤--项目阶段2

- 4批处理命令实现批量创建快捷方式_批处理创建快递方式

- 52021全球程序员收入报告,字节跳动年薪274万元排第5!

- 6好用的URL

- 7力扣206.反转链表(C++)_力扣206题c++测试

- 8Android网络编程(六)OkHttp3用法全解析_android studio 网络编程 okhttp3 用法

- 924届双非日常实习测开面经-腾讯、字节、英伟达、OPPO、深信服、Red Hat面经大合集_英伟达 面经

- 10pythonw. exe_pythonw.exe或python.exe?

当前位置: article > 正文

斯坦福用几百块钱训练的alpaca,体验一下基于llama的7b和13b模型,据说比gpt3.0还牛,结果怎样??你能信?_ggml-alpaca-7b-q4.bin

作者:Monodyee | 2024-02-09 19:18:54

赞

踩

ggml-alpaca-7b-q4.bin

好久没写代码了,上头了,强撸了!

1、自己买个GPU服务器(如果不训练,可以随便买个高内存的即可),有些网站很便宜,小时起租!

2、alpaca和模型下载地址:GitHub - antimatter15/alpaca.cpp: Locally run an Instruction-Tuned Chat-Style LLM

git clone GitHub - antimatter15/alpaca.cpp: Locally run an Instruction-Tuned Chat-Style LLM

cd alpaca.cpp

3、模型下载:ggml-alpaca-7b-q4.bin 、ggml-alpaca-13b-q4.bin ,不知道哪里下载的我可以放出网盘地址

4、编译:make chat

5、运行起来:./chat -m ggml-alpaca-13b-q4.bin ,记得放到同一个目录哦

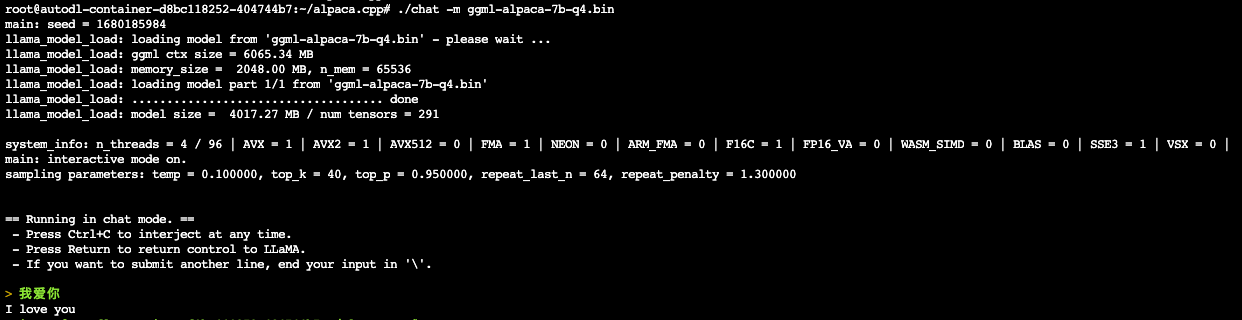

7b效果如下:

虽然我的服务器配置相当可以了,但是速度还是不快哦!毕竟是斯坦福大学训练的模型,对中文的确支持的不好

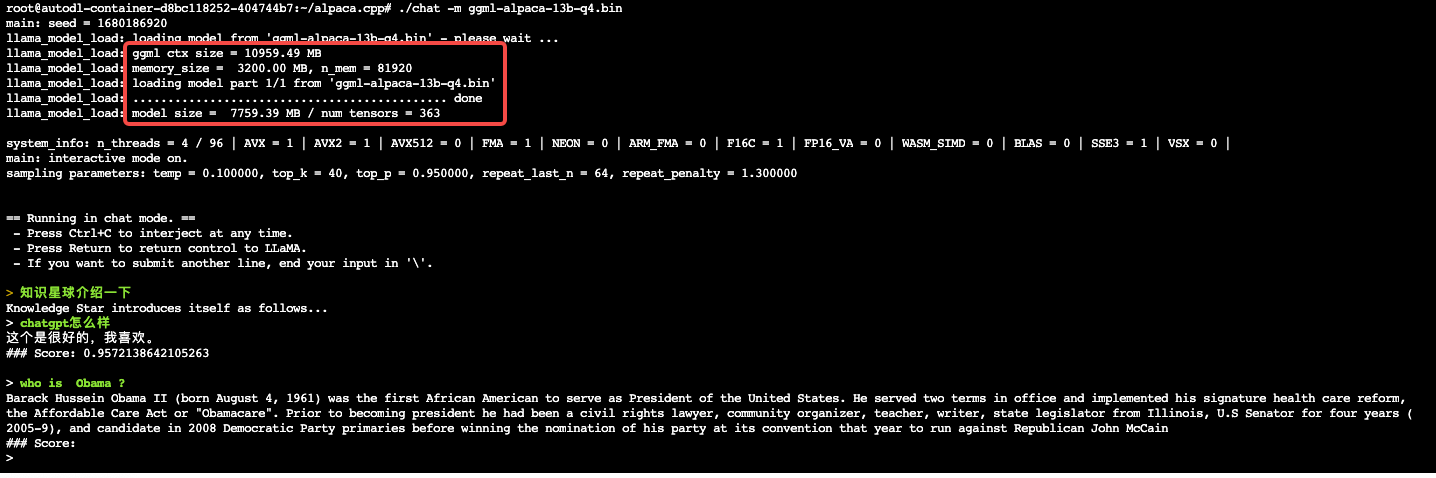

13b效果如下:

后续:

1、中文的大语言模型已经有人训练出来了

2、中文的alpaca模型也训练出来了

3、上面两个模型搞定跑起来之后,是否能训练自己的模型呢?你猜

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Monodyee/article/detail/72729

推荐阅读

相关标签