热门标签

热门文章

- 1TypeError: ***() got an unexpected keyword argument ‘***‘ self._target(*self._args, **self._kwargs)_typeerror: draw_wrapper() got an unexpected keywor

- 2Mac 下安装RabbitMQ及配置RabbitMQ可远程访问_mac rabbitmq 连接外部服务

- 3使用RandomSearchCV优化GaussianNB模型参数并进行可视化_gaussiannb参数

- 4《自然语言处理实战入门》 第一章: 自然语言处理(NLP)技术简介

- 5java project clean_如何在Java maven项目的命令提示符中执行'project> clean'

- 6HarmonyOS 鸿蒙应用开发 (七、HTTP网络组件 axios 介绍及封装使用)_axios retrofit 鸿蒙

- 7软件体系结构基本概念汇总_仓库风格的体系结构由哪两个构件组成

- 8三维von Mises-Fisher分布的均值方差

- 9鸿蒙学习-数据持久化_鸿蒙数据持久化

- 10微信小程序打开红包的css_微信小程序-css动画

当前位置: article > 正文

flash-attn安装报错ERROR: Could not build wheels for flash-attn, which is required to install pyproject

作者:weixin_40725706 | 2024-03-20 03:25:58

赞

踩

error: could not build wheels for flash-attn, which is required to install p

安装flash-attn时build报错,或者即使安装成功,但却import不进来,可能是你安装的flash版本不一致!导致flash-attn安装错误。

可在下面的网页上下载对应版本的离线包再安装:

https://github.com/Dao-AILab/flash-attention/releases/

-

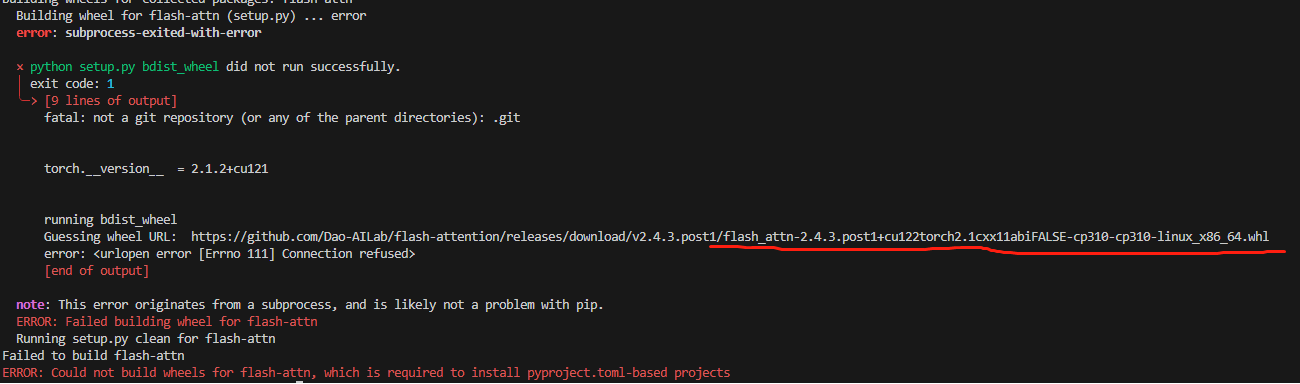

报错1

我build时的报错信息如下:

Failed to build flash-attn ERROR: Could not build wheels for flash-attn, which is required to install pyproject.toml-based projects

-

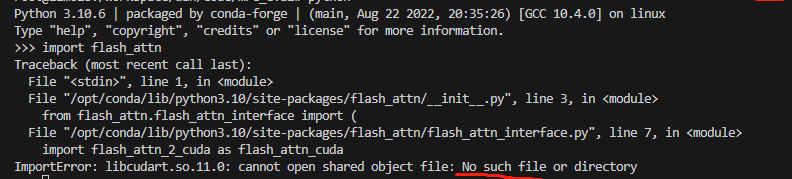

报错2

以及我换了其他不合适的版本即使安装成功后,在import的过程中报错:

ImportError: libcudart.so.11.0: cannot open shared object file: No such file or directory

网上找了一圈,怀疑可能是安装的版本不对。

上面贴的网页里面releases了很多版本,找到与自己环境匹配的版本下载,比如我的环境是:

-

python3.10

-

cuda_11.7

-

torch 2.0

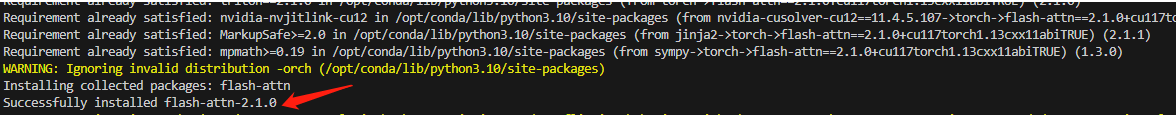

下载的版本为:flash_attn-2.3.5+cu117torch2.0cxx11abiFALSE-cp310-cp310-linux_x86_64.whl

注意:cxx有True和False两个版本,可以都试一下。我用的是cxxFALSE版本。

下载完之后,使用以下命令进行安装:

pip install flash_attn-2.3.5+cu117torch2.0cxx11abiFALSE-cp310-cp310-linux_x86_64.whl --no-build-isolation

问题解决!

Reference:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/270332

推荐阅读

相关标签