热门标签

热门文章

- 1c语言程序设计实验指导书 实验四 选择结构程序设计,C语言程序设计实验三选择结构程序设计答案《西北民大电气学院》...

- 2阿里巴巴内部Jetpack宝典意外流出!深度好文_阿里巴巴jetpack宝典

- 3sed批量替换文件内容_sed替换\t

- 4ArcGIS Pro 和 ArcMap 10个不同

- 5微信支付开发,基于SpringBoot+Vue架构的Java在线支付项目_vue+springboot 微信支付demo

- 6Oracle数据库开发——从小白到大神学习笔记

- 7Spring MVC异步上传、跨服务器上传和文件下载_文件异步上传

- 8互联⽹名词⼤全——商业模式篇_络借贷信息中介服务平台

- 9上海亚商投顾:指数全天冲高回落 两市炸板率超50%_炸板换手50

- 10Oracle-job跑批卡住案例(代码逻辑问题)_oracle存储过程执行卡住

当前位置: article > 正文

使用Ollama本地部署大模型

作者:weixin_40725706 | 2024-03-22 20:42:47

赞

踩

ollama

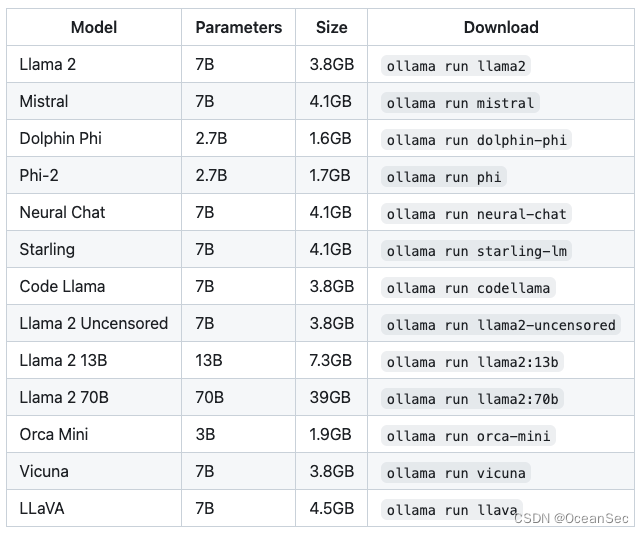

Ollama 是一个简明易用的本地大模型运行框架,目前已经有 32 K star。随着围绕着 Ollama 的生态走向前台,更多用户也可以方便地在自己电脑上玩转大模型了,使用 Ollama 本地部署大模型在 mac 上尤其简单

- GitHub地址:https://github.com/ollama/ollama

安装 Ollama

macOS

Windows

目前还没有快速安装,后边会出 WSL2 安装版

Linux & WSL2

curl https://ollama.ai/install.sh | sh

- 1

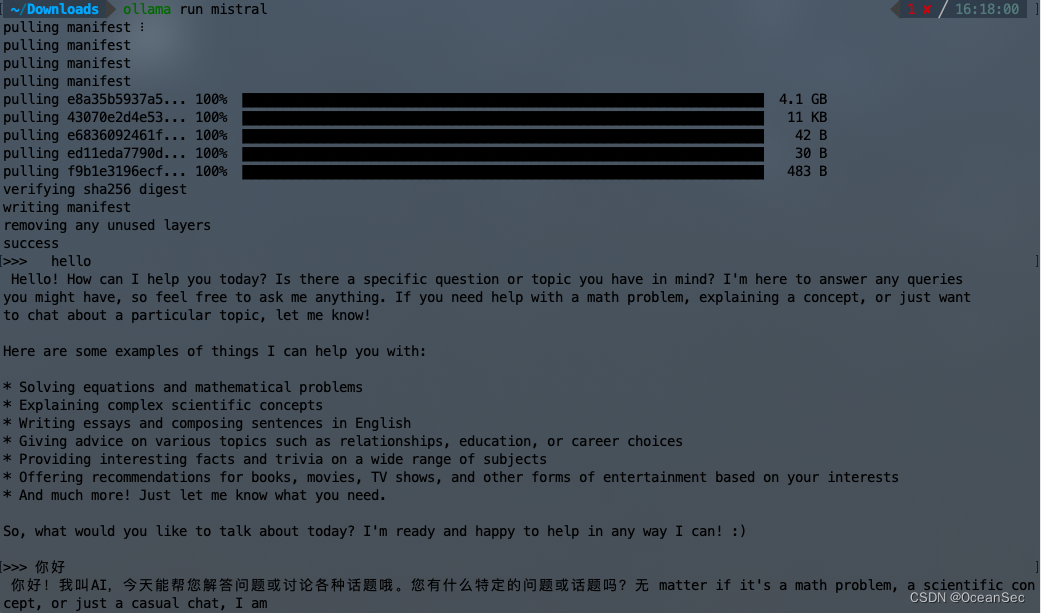

安装之后,使用一条命令就可以运行大模型了,比如 llama2

ollama run llama2

- 1

安装后便可以直接使用

注意: 应该至少有8 GB 的 RAM 可用于运行7B 型号,16 GB 可用于运行13B 型号,32 GB 可用于运行33B 型号

web 交互

安装好之后便可以命令行的形式使用,若是觉得命令行的形式不够易用,Ollama 有一系列的周边工具可供使用,包含了网页、桌面、终端等交互界面及诸多插件和拓展

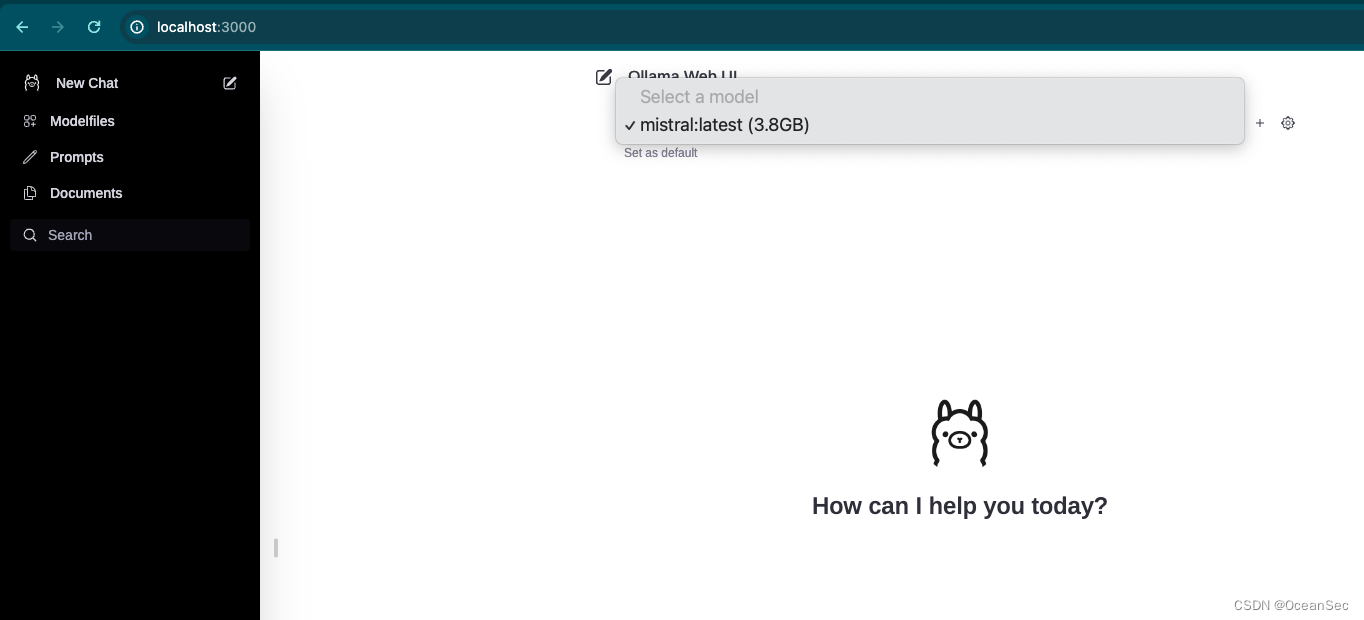

Ollama WebUI 具有最接近 ChatGPT 的界面和最丰富的功能特性,可以 Docker 部署

安装

-

安装 Docker

-

确保已经安装了最新的 Ollama

-

Docker 启动

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v ollama-webui:/app/backend/data --name ollama-webui --restart always ghcr.io/ollama-webui/ollama-webui:main- 1

要自己构建容器,请遵循以下步骤

docker build -t ollama-webui . docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v ollama-webui:/app/backend/data --name ollama-webui --restart always ollama-webui- 1

- 2

启动之后可以访问 http://localhost:3000

选择我们之前安装的模型即可

除了安装在自己的电脑上,ollama webui 还提供了多种安装方式,如:不同机器安装、一起安装 Ollama 和 Ollama Web UI

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/290764

推荐阅读

相关标签