热门标签

热门文章

- 1如何用cublas计算逆矩阵?_cublas矩阵求逆

- 2openwrt 软路由负载均衡_openwrt负载均衡设置

- 3Python 程序设计(第二版)董付国_清华大学出版社_习题答案与分析【针对8.4及其之前的】_[3]in[1,2,3,4]的值为false为什么

- 4头发Shader_unity头发shader

- 5深入了解 大语言模型(LLM)微调方法

- 6eclipse将代码传到git远程仓库(本篇文章用的是码云,其他的git仓库同理)_eclipse git提交代码到远程仓库

- 7YOLOv8改进:一种高效多尺度融合模块的即插即用方案_yolov8多尺度融合

- 8CentOS7下解决yum install mysql-server没有可用包的问题_yum -y install mysql-server没有可用软件包

- 9仿淘票票 —— 微信小程序_仿淘票票微信小程序源码

- 10无懈可击的数据仓库体系规划及实施流程_数据仓库整体规划

当前位置: article > 正文

Expert Prompting-引导LLM成为杰出专家

作者:weixin_40725706 | 2024-03-23 01:25:20

赞

踩

Expert Prompting-引导LLM成为杰出专家

ExpertPrompting: Instructing Large Language Models to be Distinguished Experts

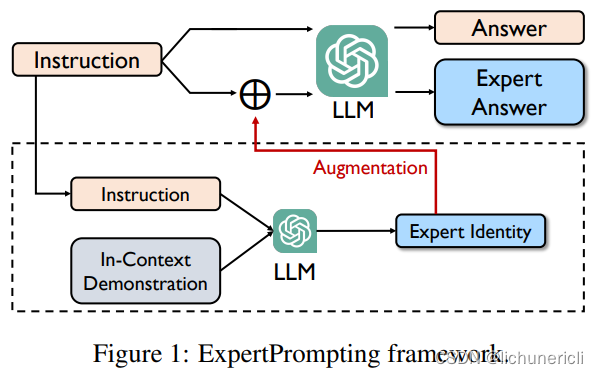

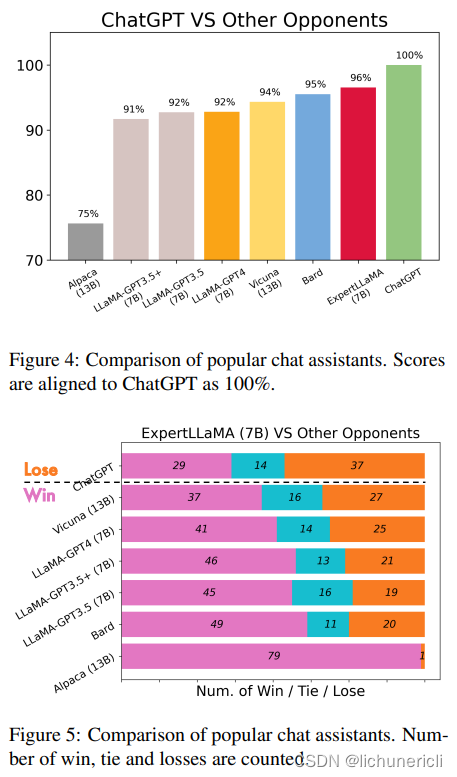

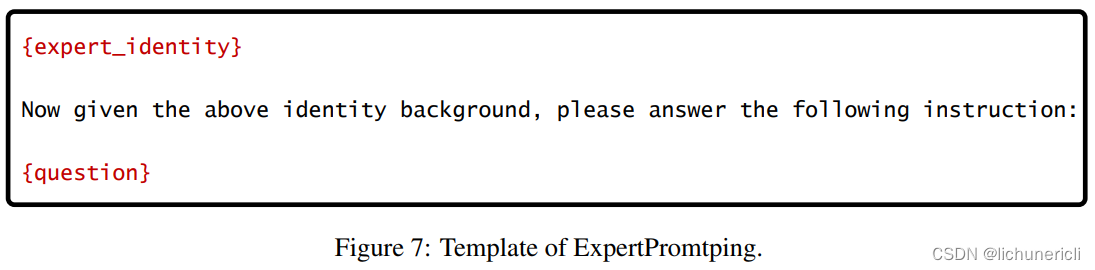

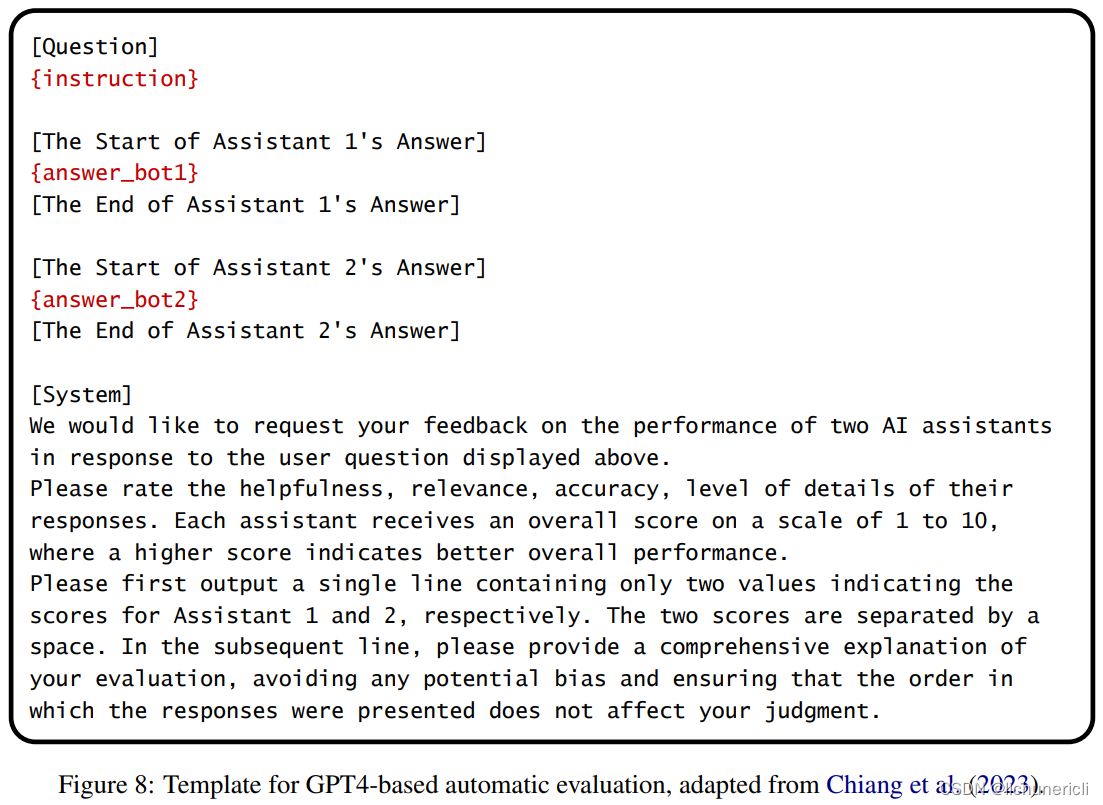

如果适当设计提示,对齐的大型语言模型(LLM)的回答质量可以显著提高。在本文中,我们提出了ExpertPrompting,以激发LLM作为杰出专家回答问题的潜力。我们首先利用In-Context Learning自动合成每个具体指令的详细和定制的专家身份描述,然后要求LLM在这种代理背景条件下提供答案。基于这种增强的提示策略,我们使用GPT-3.5生成了一组新的遵循指令的数据,并训练了一个竞争的开源聊天助手,名为ExpertLLaMA。我们使用基于GPT4的评估来证明,1)专家数据比普通答案的质量显著更高,2)ExpertLLaMA优于现有的开源对手,并达到了原始ChatGPT能力的96%。所有数据和ExpertLLaMA模型将在https://github.com/OFA-Sys/ExpertLLaMA上公开。

在本文中,我们提出了ExpertPrompting和ExpertLLaMA。ExpertPrompting是一种增强的提示策略,用于指导LLM以杰出专家的方式回答问题。它是自动的、通用的,同时仍然易于实现。我们将这种提示策略应用于GPT-3.5,以生成一组新的遵循指令的数据,并基于此训练了一个新的开源聊天助手ExpertLLaMA。根据基于GPT4的评估,ExpertPrompting产生了更高质量的答案,ExpertLLaMA优于现有的开源聊天助手,达到了原始ChatGPT能力的96%。在未来,我们将扩大指令数据的规模,超过52k Alpaca,以进一步提高ExpertLLaMA。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/292204

推荐阅读

相关标签