热门标签

热门文章

- 1springboot整合dubbo3 及其中遇到的坑_springboot3 dubbo

- 2肺癌新易感位点的发现及多基因遗传评分在肺癌风险预测中的应用--基于中国超大型前瞻性队列研究_肺癌prs

- 3AI重复率怎么检测的?本科论文aigc检测率为多少?_aigc论文检测多少算正常

- 4微软应用商店下载应用教程(附带power shell命令)_windows 命令行从商店下载

- 5异常检测(Anomaly Detection)

- 6kafka总结

- 7【计算机毕设文章】私人健身和教练预约管理系统_bruce shive.research direction in object-oriented

- 8CentOS7 YUM安装RabbitMQ3.8.19高可用集群_rabbitmq3.8.19延迟插件安装下载

- 9JAVA JDK下载安装环境变量配置与安装视频教程2022年(超详细)_jdk环境变量视频

- 10Qt5.15.2安装_qt5.15.2安装教程

当前位置: article > 正文

intelliJ IDEA进行spark配置和开发_spark的idea怎么创建scale

作者:weixin_40725706 | 2024-05-18 19:25:14

赞

踩

spark的idea怎么创建scale

前言:一直在使用python做数据处理,阅读spark官方文档时到后半部分的MLlib机器学习部分有些机器学习方法竟然没有python,很是遗憾,遂着手准备学学scale,毕竟原生语言,开发起来应该是丝丝入扣,顺滑平坦。

1.下载intelliJ IDEA

下载传送门

建议下载找个注册码安装Ultimate版本。

(在安装时不要一直点,看清楚意思再进行选择,尽量多的把能装上的语言都装上,这样会少不少麻烦。)

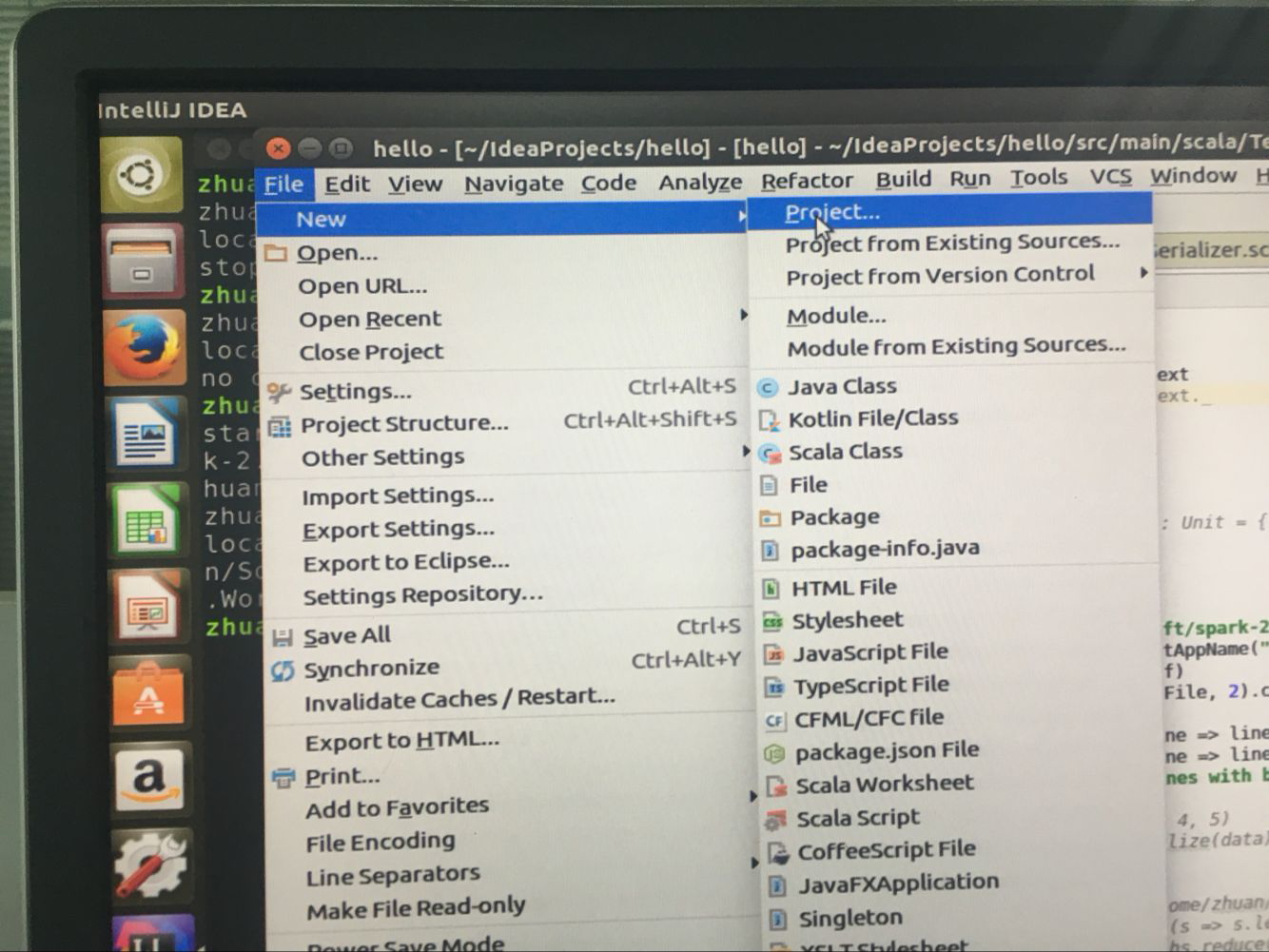

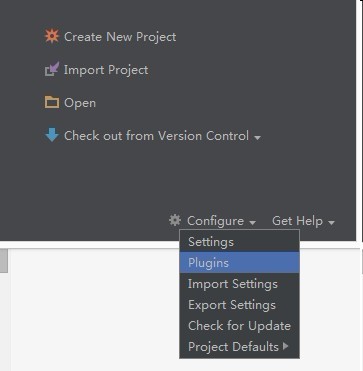

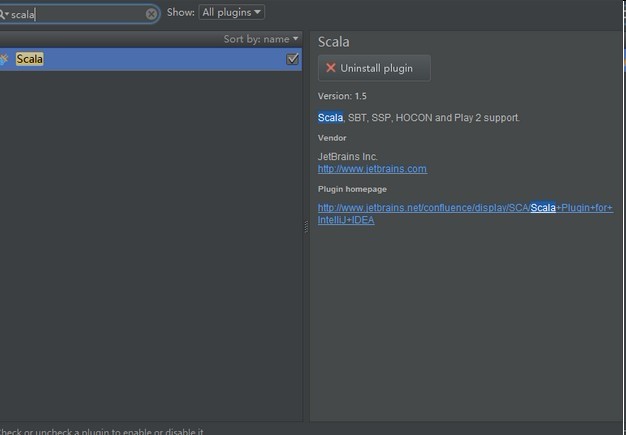

如果错过安装时候还是错了安装scale插件,那么按如下步奏走:

进入idea主界面

在线安装:

选择Plugins :

输入scala:

选择右侧的安装即可

2.安装好之后

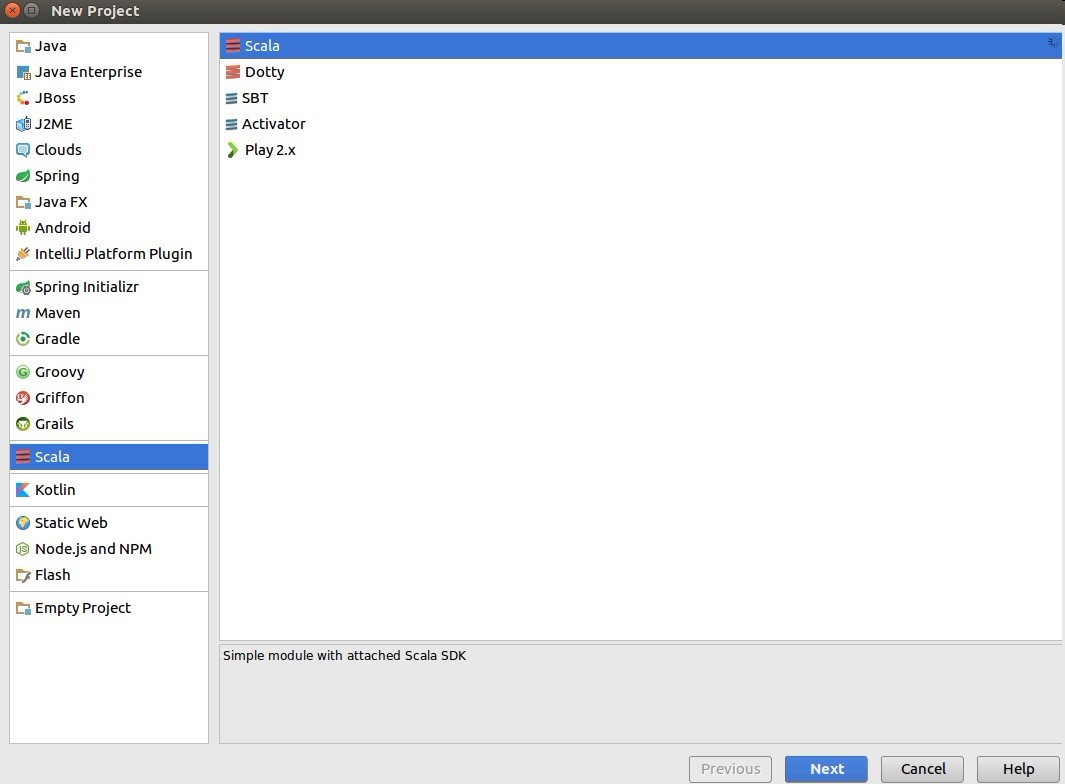

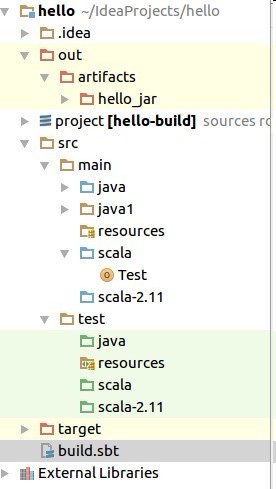

file->new->project->选择scale

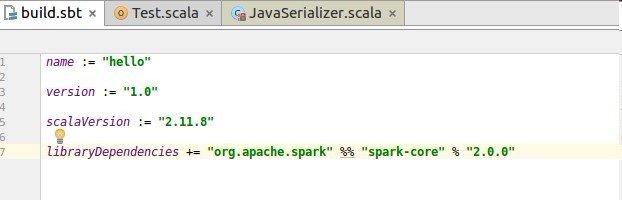

3.新建scale项目完成后,按如下目录进行配置

打开项目,目录如下:

找到build.sbt添加如下配置:

libraryDependencies += “org.apache.spark” %% “spark-core” % “2.0.0”

配置完成如下:

在src->scala->

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/589523

推荐阅读

相关标签