- 12019-01-11亲测Navicat Premium for Mac破解_miibijanbgkqhkig9w0

- 2Flutter优化加载网络图片及异常捕获_flutter 网络图片加载优化

- 3unity3d 鼠标点击或触摸 控制角色对象行走_unity如何把人物变为可点击对象

- 4第6章 Spring Security 的 Web 安全性(2024 最新版)

- 5Git 中.gitignore 使用和.gitignore 无效的解决方法_git .gitignore在代码库内看不到

- 6React Hooks 实战案例_玩转react hooks小册下载

- 7Springboot-响应JSON_spring boot jsonresponse

- 8更改SQL Server的1433端_sql2019端口号换了怎么登陆

- 9小程序 本地存储setStorage 和getStorageSync的运用_storagesetstringsync

- 101.6 课程资源-深度学习-Stanford吴恩达教授_深度学习 教授

大语言模型的自然语言生成能力和测评

赞

踩

为了更加清晰准确地了解以ChatGPT为代表的大语言模型的能力,前面两篇文章分别专题整理了大语言模型的自然语言理解和自然语言推理方面的测评工作,本篇继续整理对大语言模型在自然语言生成方面一些能力测评工作。

自然语言生成(NLG)是大语言模型在生成特定文本方面的能力,包括摘要生成、对话生成和问答等多个任务。

摘要生成(Summarization)

【能力描述】 生成给定句子或文本的简洁摘要。 【测试数据集举例】 ELIFE: eLife 是一本生物医学和生命科学领域的可开放获取的期刊。ELIFE数据集在 eLife 发表的文章中,部分文章被选中成为摘要的对象,由专家编辑根据文章本身和作者回答的问题撰写的工作的简化摘要。摘要旨在以非专业人士可以理解的语言解释科学文章的背景和意义。 【测试数据实例】

截图:eLife数据集在HuggingFace可以下载。每一个数据记录都包括文章原文(article),摘要(summary)等属性。 【相关模型】 ChatGPT等 【评估的方法结果】 摘要的量化评估指标比较复杂。在Pu, D. and Demberg, V. 等的工作重综合评估,包括但不限于: - Flesch 阅读难度(FRE):是一个衡量给定文本可理解性的度量标准。该指数依赖于每个词的平均音节数和每个句子的平均词数。得分越高表示文本更易理解。 - Coleman-Liau 指数(CLI):是文本难度级别的一种度量标准,考虑了每个句子的平均字符数和每 100 个词的平均句子数。得分越高表示文本更具挑战性。 - Dale-Chall 可读性分数(DCR):是通过比较文本中复杂词汇的数量与常用词汇表的列表来计算的。得分越高表示文本更具挑战性。 - Rouge 分数(Lin,2004)来评估 ChatGPT 在文本摘要任务中的性能,以便将其效果与最先进的模型进行比较。 - N-gram 新颖性:评估摘要在多大程度上重新使用了原始文本中的词序列

论文截图:部分对比人类生成摘要和ChatGPT产生摘要的测试结果, ChatGPT可以在一定程度上根据提供的提示生成不同难度级别的摘要。值得注意的是,ChatGPT为专家风格摘要生成的句子比普通人风格摘要的句子更复杂。然而,两种类型摘要之间的阅读难度得分差异的幅度要比人工撰写的摘要中观察到的幅度小得多。 另外,测试发现,ChatGPT的摘要稍微更多从源文本中复制内容。大模型生成的文本与人工撰写的文本之间存在显著差异。通过提供人类写作风格的目标示例,可以减少这些差异。ChatGPT生成的摘要中还存在幻觉和不准确性的问题。大语言模型在摘要任务上具有一般性能,仍有待提高。 【一些评论】 人类生成摘要是一件相对费脑、比较困难的工作。摘要生成能力的价值没有充分反映在测评结果中。况且,eLife数据集中的摘要是由人类专家生成的(并不能代表普通人的水平)。测试的指标对于生成摘要的质量也难以清晰直接地量化。 |

对话任务(Dialogue)

【能力描述】 大语言模型的对话能力指的是它在模拟对话过程中所展现出来的语言理解、生成和交流能力。它可以接收用户输入的文本信息,并以自然流畅的方式产生回应,就像两个人在进行真实对话一样。 【测试数据集举例】 MuTual:MuTual是一个用于多轮对话推理的检索式数据集,其改编自中国高中英语听力理解测试数据。 【测试数据实例】

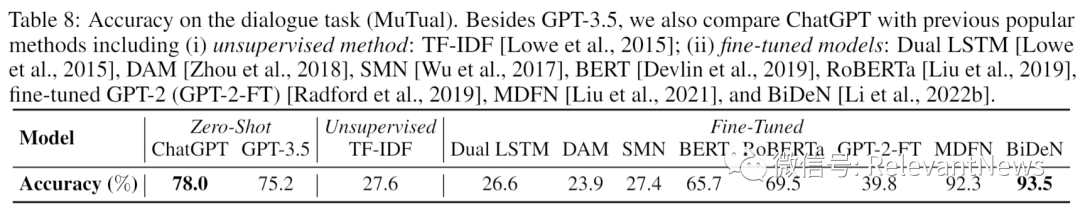

截图:MuTual数据集样例:左侧是对话语境;右侧是候选的回应,其中红色的是正确的回应 【相关模型】 ChatGPT, GPT4等 【评估的方法结果】

【一些评论】 在另外一些测评工作中,对话还被分为(1)基于知识的开放域对话和(2)面向任务的对话。评估结果显示,与基于知识的开放域,ChatGPT的性能相对较低。在面向任务的对话中,ChatGPT的性能可接受。ChatGPT在以下问题出现时容易出现错误:长期多轮依赖、基本推理失败和外在幻觉。 |

问答任务(Question Answering)

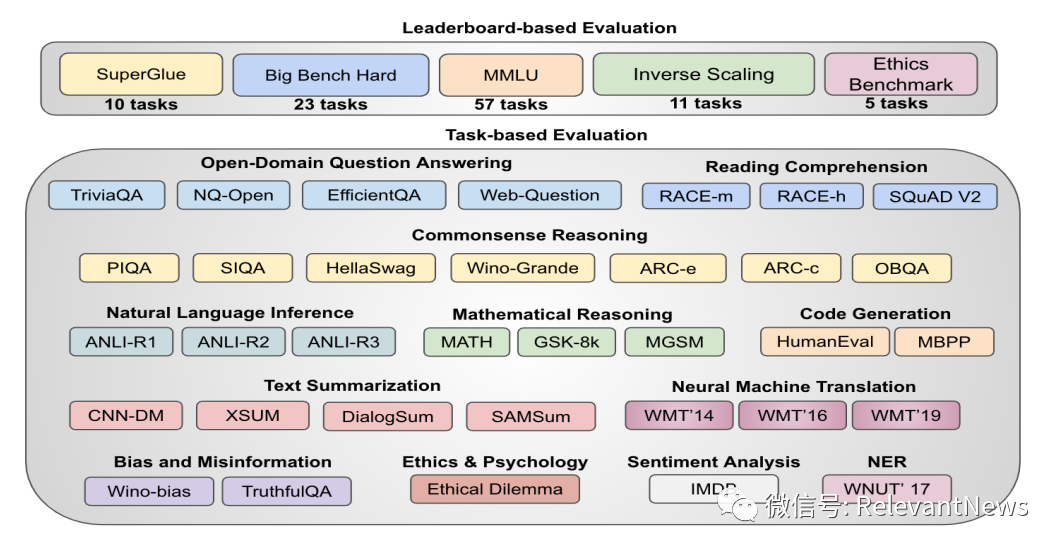

【能力描述】 问答是人机交互领域的关键技术之一,已广泛应用于搜索引擎、智能客服和智能问答等场景。衡量问答模型的准确性和效率对于这些应用具有重要意义。 【测试数据集】 问答测试数据集有很多。在Laskar 2023一文中对ChatGPT在多样的学术数据集上的表现进行彻底评估,涵盖了问题回答、文本摘要、代码生成、常识推理、数学问题解决、机器翻译、偏见检测和道德考虑等任务。测评所使用的数据集如下:

论文截图:Laskar测评中所使用的测评数据集 【相关模型】 ChatGPT等 【评估的方法结果】 Laskar等总结出一些一般观察结果。详细结果请见原文。

【一些评论】 注意:问答其实是一个综合的任务,所完成的各项任务与前面所提到的各类自然语言理解,推理和生成任务,以及本文没有讨论的其它能力如多语言能力等皆有重合。 |

无论是摘要、对话或问答任务,虽然都还有很多的不足之处,但以ChatGPT为代表的大语言模型已经展现出较高的实用性。另外,大量的评测工作、方法和数据集出现,对我们理解和发展大语言模型能力有很大帮助;但是,对于我们全面、深入和系统化地探究大模型能力,建立相关标准而言,评测工作还有很大的发展空间。

注:本文也是基于《A Survey on Evaluation of Large Language Models》一文的调研工作进行整理和扩展。光荣属于原论文作者。除了自然语言理解、推理和生成等方面的能力测评以外,原论文还覆盖了大模型在各专业领域(如数学,医学,工程学,教育等)的能力测评,以及大模型的事实性、健壮性、伦理、可信度等方面。有兴趣的朋友可追踪原文:https://arxiv.org/pdf/2307.03109.pdf。

部分资料来源

Pu, D. and Demberg, V. (2023). Chatgpt vs human-authored text: Insights into controllable text summarization and sentence style transfer.

Md Tahmid Rahman Laskar, M Saiful Bari, Mizanur Rahman, Md Amran Hossen Bhuiyan, Shafiq Joty, Jimmy Xiangji Huang, A Systematic Study and Comprehensive Evaluation of ChatGPT on Benchmark Datasets, 2023. https://arxiv.org/abs/2305.18486.

Bang 2023: A Multitask, Multiingual, Multimodal Evaluation of ChatGPT on Reasoning, Hallucination, and Interactivity

Qin 2023: IS CHATGPT A GENERAL-PURPOSE NATURAL LANGUAGE PROCESSING TASK SOLVER? https://arxiv.org/pdf/2302.06476.pdfI

论文截图:Qin等就对话任务进行的准确性测评

论文截图:Qin等就对话任务进行的准确性测评