热门标签

热门文章

- 1【YOLOv8】 用YOLOv8实现数字式工业仪表智能读数(三)

- 2Linux 内核配置项详解 myimx6_inet xfrm mode transport

- 3springboot/java/php/node/python研究生考试报名分析系统【计算机毕设】

- 4Flutter开发项目入门_fluter开发

- 5顶会系列(七):NIPS2016-2022论文总接收数据分析_机器学习 nips 综述

- 6windows10系统-11-高效软件和系统更新_idm universal patch

- 7【Java-TesseractOCR】通过Java实现OCR_tesseract ocr java

- 8(ubuntu)Docker 安装redis 详情过程_ubuntu docker redis

- 9Streamer-Sales:开源数字人直播带货系统

- 10dom4j

当前位置: article > 正文

Q*s‘ AGI

作者:weixin_40725706 | 2024-07-24 20:10:18

赞

踩

Q*s‘ AGI

最近这段时间,不论是产业界还是学术界,均发表了不少围绕「Q*」的探索和实验,同时随着OpenAI的「草莓QQ糖·(皮一下)」计划的曝光与训练的进行,似乎又为当前围绕Q*、AGI、AI4S等领域带来了不少业界争鸣和讨论,而且周围更多的朋友、同事甚至是跨领域人士(比如我所投身的生物医疗健康领域)也不像一年前大家都像在迷雾中摸索那样,而变得更加理性和system2了呢~。

结合近期几篇围绕Q*发表的内容,通过与身边和远方并未谋面伙伴的持续交流探索,自己也有一些更深入的思考和未来待解决的疑惑,比如上篇笔记所提及的关于:

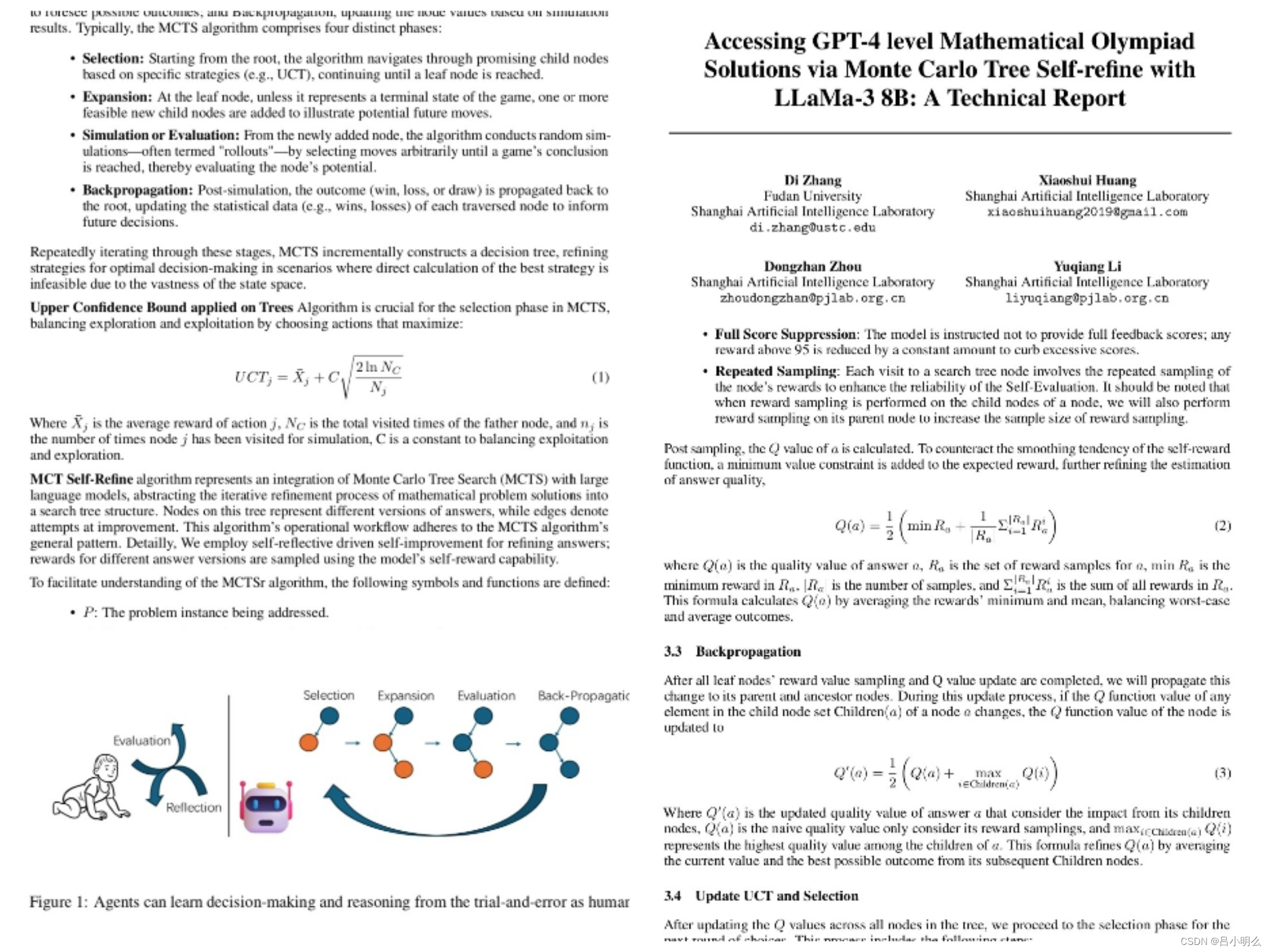

① Q*如何在LLM tokenize下平衡探索与利用的问题 即EE dilemma问题及相关MCTS或A*上对于UCB或UCT上的进一步创新;

② 对于system2复杂推理,上述各种Q*方法所构建Reward的监督指引的机制是否对于LLM这种tokenize流形分布期望是有效且完备呢?

③ 以及也许是解决上述②后在终极形态下实现LLM自隐式学习和自探索生成框架能够最终得以平滑而自然的实现。

④ 当然实现③绝不仅限于此,我想还应包括更进一步的RL下针对开放世界self-play机制的进一步漫长探寻,而不仅仅是现在更多的基于简单粗暴的“超级llm teacher对students的alignment”,感觉应该存在着更加优美而平滑的方法或机制..

⑤..

希望能与希望涉足这一领域的小伙伴进一步探索合作:)

感慨的是:当前的情况发展与自己在今年年初所写的一篇长文进行了某种程度的merge,感兴趣的大伙可以翻看阅读我的历史专栏或置顶

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/weixin_40725706/article/detail/876560

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。