- 1完全背包问题-动态规划_动态规划 全背包问题。有n种重量和价值分别为wi、vi(1≤i≤n)的物品,

- 2Parallels Desktop 19 for Mac 发布, 简化 macOS 和 Windows 交互_parallels desktop 19 百度云

- 3时序数据处理模型:RNN与LSTM总结_处理时序 信息的网络模型

- 4顺序表的操作例题——已知一个顺序表L, 其中的元素递增有序排列,设计一个算法,插入一个元素x (x为int 后保持该顺序表仍然递增有序排列(假设插入操作总能成功)。_设计一个算法,判断顺序表l中所有元素是否是递增有序的。

- 5结构体链表 (创建)_结构体链表的创建

- 6【人工智能 | 知识表示方法】状态空间法 & 语义网络,良好的知识表示是解题的关键!(笔记总结系列)_状态空间法总结

- 7阿里P7架构师开源分享2023最新897道java面试题答案

- 8el-tree饿了么elementUI tree树结构插件设置全部展开折叠_饿了么ui树形组件

- 9时间频度,时间复杂度的计算

- 10ffmpeg和ImageMagick使用_failedtoexecutecommand `"gswin64c.exe

打赢GPT-4V之多模态模型:CogVLM2最新落地经验分享_cogvlm2-llama3-chat-19b

赞

踩

CogVLM2是智谱AI推出的新一代多模态大模型,相较于前一代的CogVLM,在关键性能指标上有显著的提升,并且在多模态处理领域展现出了卓越的能力。

CogVLM2优化了经典架构,集成了一款50亿参数的强大视觉编码器以及一个70亿参数的视觉专家模块。

这一设计创新性地在大语言模型中整合视觉处理能力,通过独特的参数设置,实现了视觉与语言序列的精细交互,既增强了视觉理解能力,又保持了模型在处理语言任务上的高效性。

尽管参数量仅为19B,CogVLM2在性能上接近或甚至在某些方面超越了GPT-4V,这标志着在较少参数下也能实现高级别的多模态理解和生成能力。

该模型不仅支持中文和英文,还适用于处理长达8K文本长度和高达1344*1344分辨率的图像,适合需要进行多模态对话和图像理解的研究者和开发者。

github项目地址为:https://github.com/THUDM/CogVLM2。

一、环境安装

1、python环境:

为了兼容库的安装,建议安装python版本在3.10以上。

2、pip包安装:

- pip install torch==2.0.1+cu118 torchvision==0.15.2+cu118 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118

-

- pip install Xformers==0.0.22 tiktoken -i https://pypi.tuna.tsinghua.edu.cn/simple

-

- pip install -r basic_demo/requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

3、模型下载:

- git lfs install

-

- # 英语模型 git clone https://huggingface.co/THUDM/cogvlm2-llama3-chat-19B

-

- #中英双语模型

-

- git clone https://huggingface.co/THUDM/cogvlm2-llama3-chinese-chat-19B

4、模型推理和微调的显卡配置要求

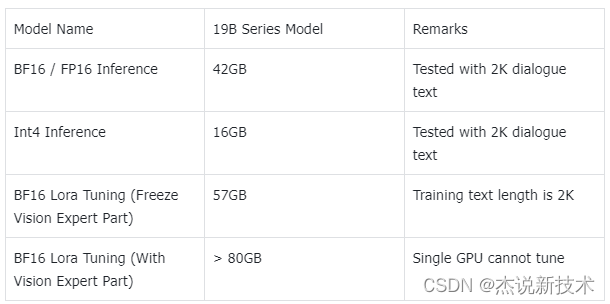

在模型推理方面,该模型的BF16/FP16推理需要42GB显存,而Int4量化版本需要16GB显存,这意味着在不同硬件配置下都能有较好的部署灵活性。详细配置说明如下:

二、功能测试

1、命令行运行测试:

(1)单张显卡测试

如果想模型都运行在一张第一张显卡上,同时该显卡显存在48G以上,我们可以通过下面命令运行:

CUDA_VISIBLE_DEVICES=0 python basic_demo/cli_demo.py(2)多张显卡测试

如果一张显卡跑不动该模型,可以将模型的不同层分布在不同的GPU上,命令如下:

python basic_demo/cli_demo_multi_gpu.py在 cli_demo_multi_gpu.py 中,我们使用了infer_auto_device_map函数来自动分配模型的不同层到不同的GPU上。你需要设置 `max_memory` 参数来指定每张GPU的最大内存。例如,如果你有两张GPU,每张GPU的内存为23GiB,你可以这样设置:

device_map = infer_auto_device_map( model=model, max_memory={i: "23GiB" for i in range(torch.cuda.device_count())}, # set 23GiB for each GPU, depends on your GPU memory, you can adjust this value no_split_module_classes=["CogVLMDecoderLayer"] )(3)web端测试

如果想在web端与模型进行交互对话,可以执行命令:

chainlit run basic_demo/web_demo.py

2、python接口代码测试:

未完......

更多详细的内容欢迎关注:杰哥新技术