- 1HarmonyOS 鸿蒙开发DevEco Studio:使用真机进行调试_华为真机调试开发

- 2NeurIPS2021 VALUE:快来刷榜吧!微软提出视频多模态新基准,同时含检索、caption、QA等多个任务!...

- 3龙像封面图片AI玩法,龙年不可错过的搞钱方式,月售8000+单

- 4《Java并发编程实战》读书笔记——AQS、CountDownLatch和CyclicBarrier_java countdownlatch 不可重用, cyclicbarrier 可重用

- 5OWASP Top 10:2021_owasp_2017_a06

- 6leaky_relu_leaky relu

- 7每天一个数据分析题(一百六十六)

- 8数据库系统课程设计(高校成绩管理数据库系统的设计与实现)_数据库学生成绩管理系统课程设计

- 9pip换源命令(一行命令完成)

- 10盛最多水的容器_containmaxwater

LLM 模型融合实践指南:低成本构建高性能语言模型

赞

踩

编者按:随着大语言模型技术的快速发展,模型融合成为一种低成本但高性能的模型构建新途径。本文作者 Maxime Labonne 利用 mergekit 库探索了四种模型融合方法:SLERP、TIES、DARE和passthrough。通过配置示例和案例分析,作者详细阐释了这些算法的原理及实践操作。

作者的核心观点是:相比训练全新模型,融合现有模型可以以更低计算成本获取类似或更优异的效果。

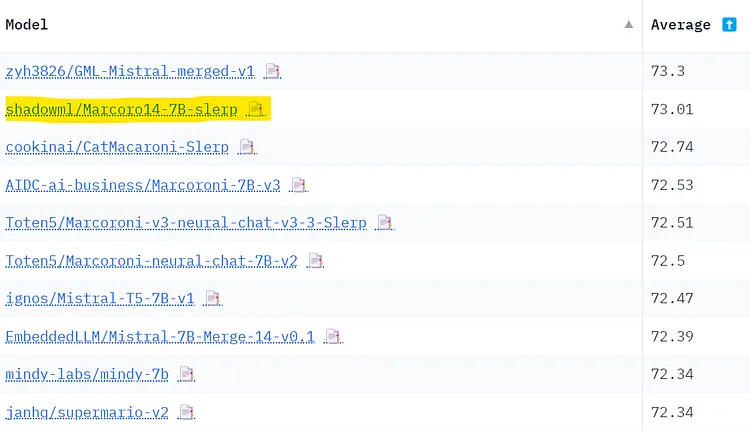

文章通过模型融合生成了性能优异的 Marcoro14-7B-slerp 。在 Open LLM Leaderboard 和 NousResearch 两个基准测试上,它都是同参数量模型中的佼佼者。案例验证了作者主张的模型融合存在的高性价比。当然模型融合也存在一定问题,如训练数据污染和可能在各种评测排行榜的分数偏高。本文提供了模型融合技术与工程实践的详尽指南,对AI实践者具有重要参考价值。

作者 | Maxime Labonne

编译 | 岳扬

Image by author

模型融合(Model merging)是一种将两个或更多个大语言模型(LLM)合并为一个模型的技术。这是一种相对较新的实验性方法,可以以较低成本(无需 GPU)创建新模型。 令人惊讶的是,这种技术的效果还比较出奇,使用模型融合技术在 Open LLM Leaderboard[1]上产生了许多最先进的模型。

在本教程中,我们将使用 mergekit [2]库来实现这一技术。更具体地说,我们将回顾四种模型融合方法,并提供相关的配置示例。然后,我们将使用 mergekit 创建一个模型:Marcoro14–7B-slerp[3],该模型已成为 Open LLM Leaderboard(02/01/24)上表现最佳的模型。

相关代码已上传至 GitHub[4] 和 Notebook[5]。个人建议使用 LazyMergekit[6] 项目,来轻松运行 mergekit。

特别感谢 mergekit 库的作者 Charles Goddard[7] 审阅本文。

Image by author

01 声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/不正经/article/detail/161380?site

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。