- 1centos 安装 nvidia的两种方式_centos guazainvidia

- 2四川对口高考计算机本科收分,四川对口升学高考分数线

- 3python pyqt5 数据库,Python PyQt5:将图像数据存储到phpmyadmin数据库中

- 4Python基本语法(笔记)_from student import student是什么意思

- 5C#学习笔记之不安全代码_c#允许不安全代码

- 6基于微信小程序求职招聘系统设计与实现 毕业设计论文大纲提纲参考

- 7fopen /open,read/write和fread/fwrite区别_fopen,fread,fwrite和open,read,write有什么本质上的不同

- 8Android 之app->build.gradle->android->buildTypes->release->manifestPlaceholders的使用_build.gradle manifestplaceholders

- 9微信小程序中如何实现微信支付_微信小程序支付功能怎么实现

- 10r语言如何计算t分布临界值_「SPSS数据分析」SPSS差异分析(2)比较均值和T检验...

防止抓取html代码,robots.txt只允许抓取html页面,防止抓取垃圾信息!

赞

踩

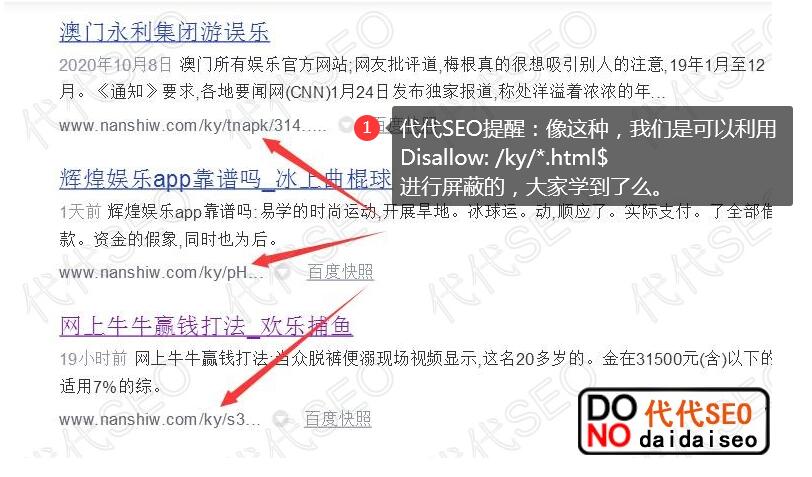

今天我们代代SEO为大家详细的讲解下“robots.txt只允许抓取html页面,防止抓取垃圾信息!”代代SEO在做网站这么多年中,经常会遇到客户的网站被挂马的情况,原因是自己维护网站不利,或者用的是市面上开源的CMS,直接下载源码安装使用,也不管里面有没有漏洞和后门,所以造成了,后期被挂马入侵,产生大量垃圾违法页面被百度抓取。

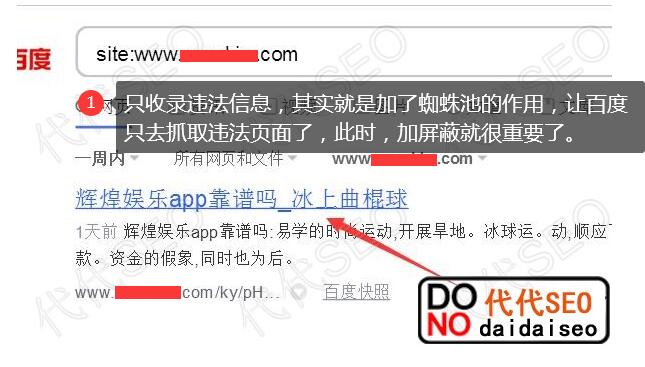

被挂马的一些人很奇怪,为什么自己的网站正常发布的内容不被收录,但是垃圾页面违法内容却被百度大量收录,其实很简单,哪些挂马人员直接在哪些违法页面上,挂了蜘蛛池,所以就会造成这个问题,就算我们尽管解决了网站被挂马的问题,网站上的垃圾页面,还是不断会被百度抓取,死链生效也是需要很长时间,这个时候怎么办那?我们可以使用robots.txt来解决这个问题。

实现原理:

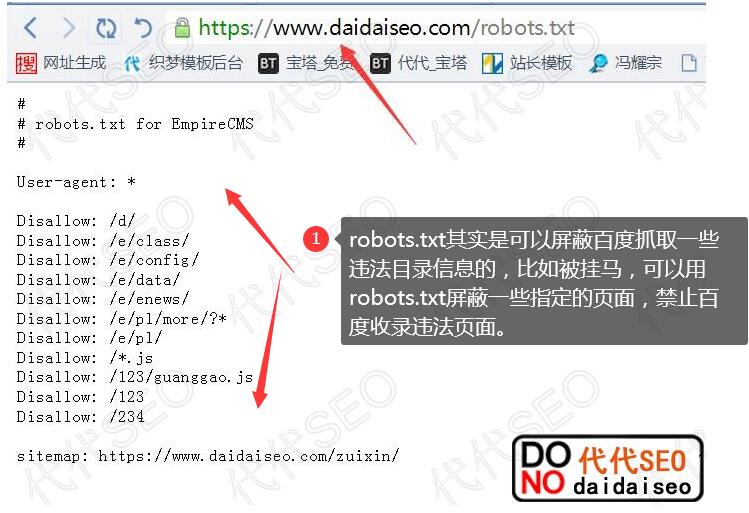

我们可以使用robots.txt限制用户只能抓取HTMl页面文件,并且可以限制指定目录的HTML,和屏蔽指定目录的HTML文件,下面做一个robots.txt的写法,大家可以自己研究下,实际应用到自己的网站上面去。

可以解决的挂马形式:

这个robots编写规则,就是主要针对上传类的挂马,比如增加xxx.php?=dddd.html;xxxx.php;上传也不会被百度抓取,降低网监风险。

#适用于所有搜索引擎

User-agent:*

#允许首页根目录/和不带斜杠、例如www.daidaiseo.com/www.daidaiseo.com

Allow:/$

Allow:$

#文件属性设置为禁止修改(固定属性,入口只能是index.html/index.php)

Allow:/index.php

Allow:/index.html

#允许静态生成目录的抓取,此处是允许抓取页面中所有的html文件

Allow:/*.html$

#禁止所有带参数的html页面(禁止抓取挂马html页面)规则可以自己定义

Disallow:/*?*.html$

Disallow:/*=*.html$

#允许单一入口,只允许,带?号的index,其他的html,带符号,一律不允许。

Allow:/index.php?*

#允许资源文件,允许网站上,图片的抓取。

Allow:/*.jpg$

Allow:/*.png$

Allow:/*.gif$

#除了以上的,禁止抓取网站内任何文件,或者页面。

Disallow:/

比如我们的网站被挂马,后戳一般都是。php?unmgg.html、或者dds=123.html。这类,只要URL中带有?、=这类符号,当然你可以往里面加更多格式,比如带下划线“_”你可以用“Disallow:/_*.html$”这种方式进行防御。

再比如:挂马的是一个目录,正常的URL,比如“seozt/1233.html”,大家可以加一条禁止规则“Disallow:/seozt/*.html$”,这条规则是告诉搜索引擎,只要是seozt目录下的html文件,全部不能被抓取,大家懂了么,其实很简单,自己多熟悉下就行了。

这种写作优势在于:

首先,蜘蛛会抓取你很多核心目录,php目录,模板目录,会浪费很多目录资源,对吧,我们如果屏蔽目录,就会在robots.txt暴露我们的目录,别人也能分析出我们使用的是什么程序对吧,这个时候,我们用反向模式操作,直接允许html,拒绝其他所有,则可以有效的避开了,暴露目录的风险,对吧,好了,今天就讲解到这里,希望大家可以明白。

- 代码html><html lang="en"> [详细] -->

赞

踩