- 1反光衣实时识别检测系统-自动识别是否规范穿着反光工作服---豌豆云

- 2【力扣经典面试题】122. 买卖股票的最佳时机 II

- 3CPU体系结构的种类、特点及应用场合_cpu的特点

- 4Python实用教程系列——推导式和Lambda表达式_python 推导式和lambda

- 5【Spring Cloud Alibaba】1.新版SpringCloudAlibaba整合Dubbo,配置多注册中心——Nacos+Zookeeper_基于dubbo zookeeper nacos

- 6职场中干好工作的18准则

- 7上百所大学计算机考研有变化!22计算机考研太难了!

- 8【小黑送书—第十二期】>>一本书讲透Elasticsearch_《一本书讲透 elasticsearch》pdf下载一本书讲透elasticsearch:原理、进阶

- 9JDK1.8下载与安装完整教程

- 10数据结构——堆(C语言)_c语言中int i; 是在堆上

CVPR'23论文一览 | 多模态/3D检测/BEV/跟踪/点云等多个方向!

赞

踩

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【全栈算法】技术交流群

1. 目标跟踪

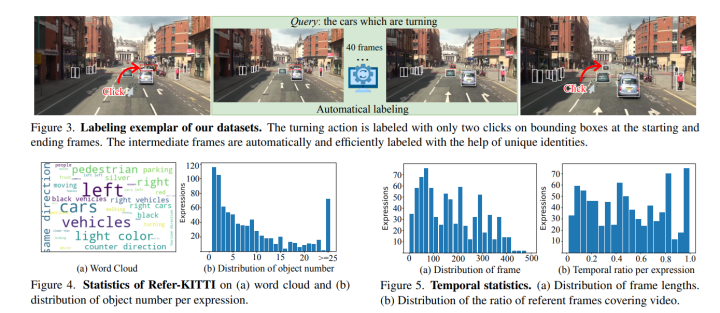

Referring Multi-Object Tracking

研究背景:多目标跟踪(MOT)是指在视频中检测并跟踪多个感兴趣的对象,并为它们分配唯一的ID。现有的MOT方法通常依赖于视觉信息来进行跟踪,但忽略了语言信息的作用。语言信息可以提供更丰富和更具辨识度的语义线索,帮助区分不同的对象和处理遮挡等情况。因此,本文提出了一种新颖且通用的指代理解任务,称为指代多目标跟踪(RMOT)。其核心思想是利用语言表达作为语义提示来指导多目标跟踪的预测。本文提出了一个端到端的RMOT框架,包括三个主要模块:(1)基于Transformer的联合编码器,用于将视频帧和语言表达进行特征融合;(2)基于图卷积网络(GCN)的关系推理模块,用于建模对象之间的空间关系和运动关系;(3)基于匈牙利算法(HA)的匹配策略模块,用于将不同帧中相同ID的对象进行关联。实验效果:本文在两个新构建的数据集上进行了实验,并与当前最先进的MOT方法进行了比较。实验结果表明,RMOT框架在各项评价指标上均显著优于其他方法,并且能够有效地处理复杂场景下的多目标跟踪问题。

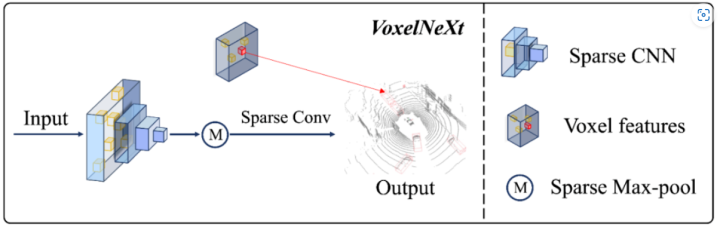

VoxelNeXt: Fully Sparse VoxelNet for 3D Object Detection and Tracking

它的研究背景是,目前自动驾驶场景的3D检测框架大多依赖于dense head,而3D点云数据本身是稀疏的,这无疑是一种低效和浪费计算量的做法。因此,作者提出了一种纯稀疏的3D检测框架VoxelNeXt。它的核心思想是直接根据稀疏体素特征来预测对象,不再需要稀疏到密集的转换、锚点或中心代理。

在实验方面,VoxelNeXt在nuScenes数据集上取得了更好的速度精度权衡,并且首次展示了完全稀疏的基于体素的表示对于LIDAR 3D对象检测和跟踪的有效性。在nuScenes、Waymo和Argoverse2基准测试中进行了大量实验,验证了该方法的有效性。没有任何花哨的东西,该模型在nuScenes跟踪测试基准测试中超越了所有现有的LIDAR方法。该方法在取得检测速度优势的同时,还能很好地帮助多目标跟踪。VoxelNeXt在nuScenes LIDAR 多目标跟踪榜单上排名第一。

2. 点云相关

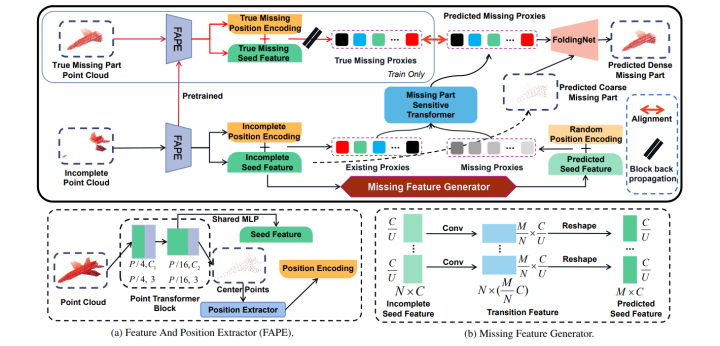

ProxyFormer: Proxy Alignment Assisted Point Cloud Completion with Missing Part Sensitive Transformer

来看研究背景:点云是一种常用的三维数据表示形式,但由于设备缺陷或视角限制等原因,采集到的点云往往是不完整的。因此,从部分点云恢复完整点云在许多实际任务中具有重要意义,而其中的关键之一在于缺失部分的预测。但是,在现有的点云补全方法中,通常使用编码器-解码器结构来生成完整点云,但这种结构存在以下问题:(1)编码器无法充分捕捉局部特征和全局上下文;(2)解码器无法有效感知缺失部分的位置信息;(3)生成的点云质量受限于采样密度和重建误差。

为了解决上述问题,本文提出了一种新颖的点云补全方法,称为ProxyFormer,它将点云补全分为两个阶段:(1)代理生成阶段,使用一个基于Transformer的编码器来从部分点云中提取局部特征和全局上下文,并生成一组代表完整点云形状和结构的代理;(2)代理对齐阶段,使用一个缺失部分敏感的Transformer来从随机正态分布中转换出合理的位置信息,并使用代理对齐机制来细化缺失代理。这使得预测的点代理更加敏感于缺失部分的特征和位置,并能够适应不同程度和模式的缺失。本文在ShapeNet、Completion3D和KITTI等公开数据集上进行了广泛的实验,并与当前最先进的方法进行了比较。实验结果表明,ProxyFormer在各项评价指标上均取得了优异或接近最优的性能,并且能够生成高质量、高密度、高多样性和高鲁棒性的完整点云。

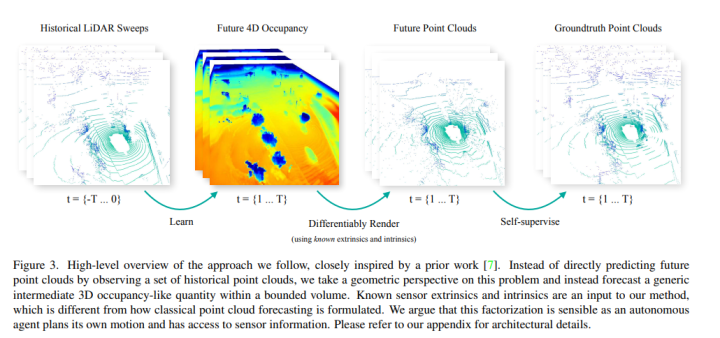

Point Cloud Forecasting as a Proxy for 4D Occupancy

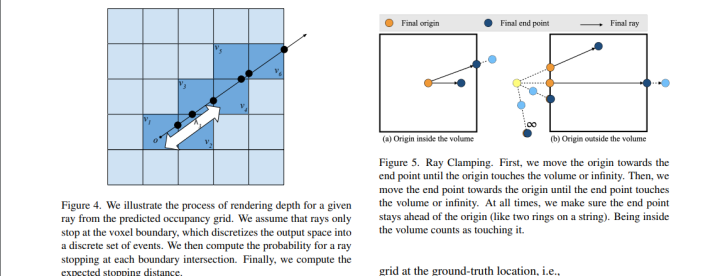

4D占据预测是指在给定当前时刻的三维场景表示(如点云、体素网格等)后,预测未来时刻的三维场景表示。它可以描述场景中物体的运动和变化,对于自动驾驶等应用有着重要的价值。现有的4D占据预测方法大多基于有监督学习,需要大量标注数据或者依赖于传感器内外参数(intrinsics and extrinsics)。然而,在实际场景中,标注数据很难获得,而且传感器参数可能会受到噪声和误差的影响。因此,如何利用无监督学习来提高4D占据预测的性能和鲁棒性,是一个新颖且具有挑战性的问题。

本文提出了一种名为PCF(Point Cloud Forecasting)的方法,它包括两个主要步骤:1) 利用一个基于图神经网络(Graph Neural Network)和循环神经网络(Recurrent Neural Network)的编码器-解码器模型,对输入点云进行编码和解码,并输出未来时刻的点云;2) 利用一个基于凸优化(Convex Optimization)和投影算法(Projection Algorithm)的后处理模块,将输出点云转换为四维占据,并与输入点云进行对齐。本文在KITTI数据集上进行了实验,并与其他基准方法进行了比较。实验结果表明,PCF方法可以有效地利用无监督学习来提高4D占据预测的性能,并且在不同噪声水平下都具有较好的鲁棒性。与其他基准方法相比,PCF方法在KITTI数据集上分别提升了9.8%和7.6% 的平均端到端误差(AEE)。

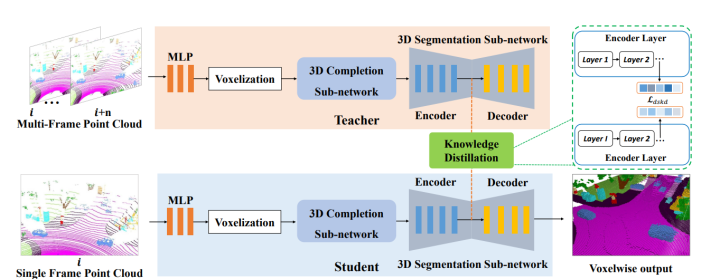

SCPNet: Semantic Scene Completion on Point Cloud

由于稀疏和不完整的输入、大量不同尺度的对象以及移动对象固有的标签噪声,训练深度模型进行语义场景完成(SSC)是具有挑战性的。

因此,作者提出了以下三种解决方案:1)重新设计完成子网络。我们设计了一种新颖的完成子网络,它由多个多路径块(MPBs)组成,用于聚合多尺度特征,并且不会产生损失性下采样操作。2)从多帧模型中提取丰富的知识。我们设计了一种新颖的知识蒸馏目标,称为密集到稀疏知识蒸馏(DSKD)。它将多帧教师的密集、基于关系的语义知识转移到单帧学生身上,显著提高了单帧模型的表示学习。3)完成标签纠正。我们提出了一种简单而有效的标签纠正策略,它使用现成的全景分割标签来删除动态对象在完成标签中的痕迹,极大地提高了深度模型的性能,特别是对于那些移动对象。

在实验方面,在两个公共SSC基准测试中进行了广泛实验,即SemanticKITTI和SemanticPOSS。我们的SCPNet在SemanticKITTI语义场景完成挑战中排名第一,并超过了竞争激烈的S3CNet。

3. 多模态感知

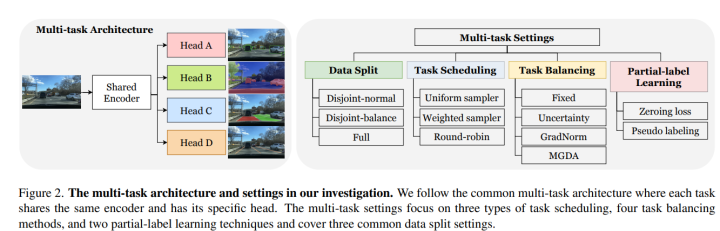

Visual Exemplar Driven Task-Prompting for Unified Perception in Autonomous Driving

自动驾驶中的统一感知是指同时解决多个感知任务,如目标检测、语义分割、深度估计等。现有的统一感知方法通常使用多任务学习的框架,但存在以下问题:(1)不同任务之间的特征表示可能存在冲突或干扰;(2)不同任务之间的难度和重要性可能不平衡;(3)不同任务之间的数据分布和标注质量可能不一致。研究动机:为了解决上述问题,本文提出了一种有效的多任务框架,称为VE-Prompt,它引入了视觉示例通过任务特定的提示来指导模型学习高质量的任务特定表示。视觉示例是指基于边界框和颜色标记生成的图像片段,它们提供了目标类别的准确视觉外观,并进一步缩小了性能差距。

本文提出了一个端到端的VE-Prompt框架,包括三个主要模块:(1)基于Transformer的编码器,用于将输入图像和视觉示例进行特征融合;(2)基于卷积层的解码器,用于从编码器输出中提取多个感知任务所需的信息双向投影变换是一种能够将图像特征从透视视角(Perspective View)映射到鸟瞰视角(Bird-Eye View)或反之的技术。它通过计算透视视角和鸟瞰视角之间的坐标转换关系,并利用双线性插值(Bilinear Interpolation)来生成新的图像特征。双向投影变换可以保持两种视角之间的空间一致性,并且可以通过反向传播进行优化;(3)基于注意力机制和损失函数的优化模块,用于调节不同任务之间的权重和优先级。实验效果:本文在KITTI数据集上进行了实验,并与当前最先进的统一感知方法进行了比较。实验结果表明,VE-Prompt框架在各项评价指标上均显著优于其他方法,并且能够有效地处理自动驾驶中复杂场景下的多个感知任务。

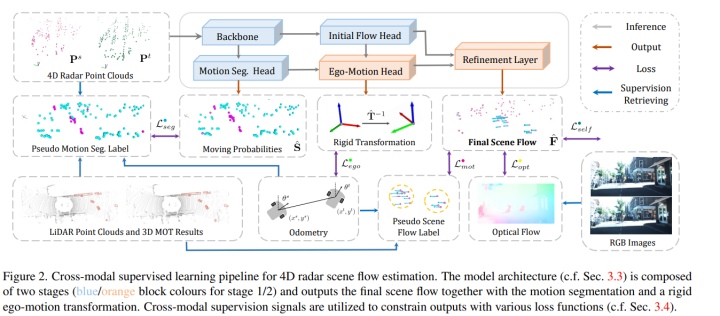

Hidden Gems: 4D Radar Scene Flow Learning Using Cross-Modal Supervision

研究背景:4D雷达场景流是指在连续的两帧雷达点云中,每个点的三维位置和三维速度。它可以描述场景中物体的运动状态,对于自动驾驶等应用有着重要的价值。现有的4D雷达场景流估计方法大多基于手工设计的特征或者有监督学习,需要大量标注数据或者依赖于精确的传感器校准。然而,在实际场景中,标注数据很难获得,而且传感器校准可能会受到噪声和误差的影响。因此,如何利用现代自动驾驶车辆中共同存在的多种传感器(如里程表、激光雷达、相机等)来提供跨模态(cross-modal)的监督信号,从而提高4D雷达场景流估计的性能和鲁棒性,是一个新颖且具有挑战性的问题。本文提出了一种名为CMFlow(Cross-Modal Scene Flow)的方法,它包括两个主要步骤:1) 利用里程表和激光雷达提供刚体运动变换(rigid ego-motion transformation)和运动分割(motion segmentation)作为监督信号,训练一个基于点云卷积神经网络(PointConvNet)的初步场景流估计器;2) 利用相机提供光流(optical flow)作为监督信号,训练一个基于图神经网络(Graph Neural Network)和注意力机制(Attention Mechanism)的后处理模块,对初步场景流进行校正和优化。本文在KITTI数据集上进行了实验,并与其他基准方法进行了比较。实验结果表明,CMFlow方法可以有效地利用跨模态监督信号来提高4D雷达场景流估计的性能,并且在不同噪声水平下都具有较好的鲁棒性。与其他基准方法相比,CMFlow方法在KITTI数据集上分别提升了11.8%和10.7% 的平均端到端误差(AEE)。

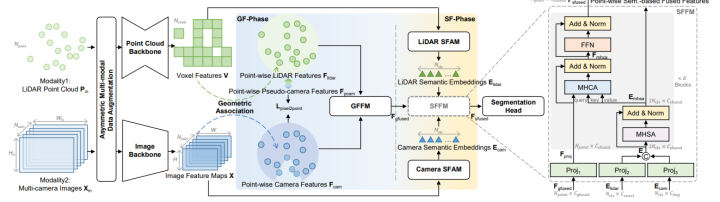

MSeg3D: Multi-modal 3D Semantic Segmentation for Autonomous Driving

它的研究背景是,LiDAR和摄像头是自动驾驶中可用于3D语义分割的两种模态。流行的仅使用LiDAR的方法由于激光点不足,严重受到小型和远距离物体分割不良的影响,而鲁棒的多模态解决方案尚未被充分探索。

因此,作者提出了一种多模态3D语义分割模型(MSeg3D),它具有联合内部模态特征提取和跨模态特征融合,以减轻模态异构性。MSeg3D中的多模态融合包括基于几何的特征融合GF-Phase、跨模态特征补全和基于语义的特征融合SF-Phase在所有可见点上。多模态数据增强通过对LiDAR点云和多摄像头图像分别应用非对称变换来重新激活,这有助于模型训练具有多样化的增强变换。

在实验方面,MSeg3D在nuScenes、Waymo和SemanticKITTI数据集上取得了最先进的结果。在多摄像头输入故障和多帧点云输入下,MSeg3D仍然表现出鲁棒性,并改善了仅使用LiDAR的基线

4. 3D目标检测

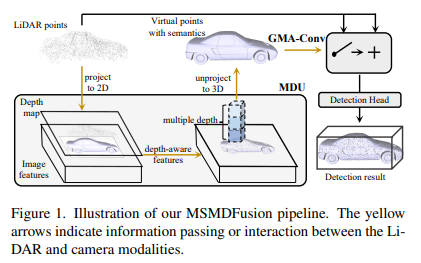

MSMDFusion: Fusing LiDAR and Camera at Multiple Scales with Multi-Depth Seeds for 3D Object Detection

自动驾驶系统中,融合激光雷达和相机信息是实现准确和可靠的三维物体检测的关键。这是一个具有挑战性的问题,因为需要将两种不同模态之间的多粒度几何和语义特征进行有效地结合。现有的方法主要通过将二维相机图像中的点提升到三维空间,来探索相机特征的语义密度。然而,这些方法存在两个主要的缺陷:1) 它们忽略了不同尺度下相机特征之间的差异性;2) 它们依赖于固定深度值或者预设锚框(anchor box)来生成候选框(candidate box),这会导致低效率和低精度。本文提出了一种名为MSMDFusion(Multi-Scale Multi-Depth Fusion)的方法,它包括两个主要步骤:1) 利用一个基于卷积神经网络(Convolutional Neural Network)和注意力机制(Attention Mechanism)的多尺度特征提取器(Multi-Scale Feature Extractor),对激光雷达点云和相机图像进行特征提取,并在不同尺度下进行特征融合;2) 利用一个基于多深度种子生成器(Multi-Depth Seed Generator)和候选框生成器(Candidate Box Generator)的多深度种子融合模块(Multi-Depth Seed Fusion Module),根据不同类别和不同深度范围生成多深度种子,并利用激光雷达点云对其进行调整和筛选,最后输出候选框。本文在KITTI数据集上进行了实验,并与其他基准方法进行了比较。实验结果表明,MSMDFusion方法可以有效地利用多尺度多深度种子来融合激光雷达和相机信息,并且在三维物体检测任务上取得了最先进的结果,在KITTI数据集上分别达到了69.1% 的平均精确率(mAP)和71.8% 的标准化检测分数(NDS)。

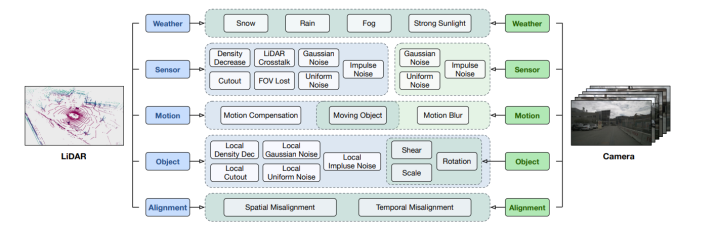

Benchmarking Robustness of 3D Object Detection to Common Corruptions in Autonomous Driving

尽管现有的3D检测器性能优异,但它们缺乏对现实世界中由恶劣天气、传感器噪声等引起的腐败的鲁棒性,引发了对自动驾驶系统安全性和可靠性的担忧。

因此,作者的动机是全面严格地对3D检测器的退化鲁棒性进行基准测试。为此,他们设计了27种考虑现实世界驾驶场景的LiDAR和摄像头输入的常见退化类型。通过在公共数据集上合成这些退化,他们建立了三个退化鲁棒性基准测试——KITTI-C、nuScenes-C和Waymo-C。

在方法方面,作者对24种不同的3D对象检测模型进行了大规模实验,以评估它们的腐败鲁棒性。根据评估结果,他们得出了几个重要的发现,包括:1)运动级别腐败是最具威胁性的,导致所有模型性能显著下降;2)LiDAR-摄像头融合模型表现出更好的鲁棒性;3)仅使用摄像头的模型对图像腐败极其脆弱,显示出LiDAR点云不可或缺。

5. 深度估计

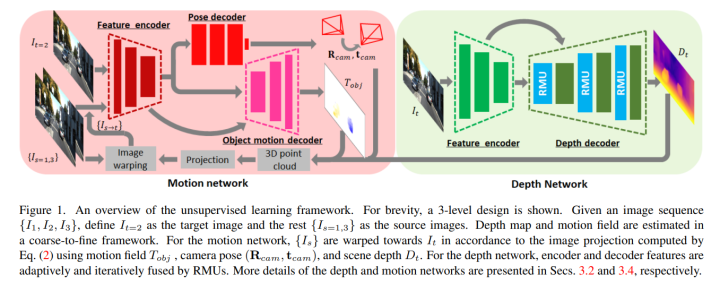

RM-Depth: Unsupervised Learning of Recurrent Monocular Depth in Dynamic Scenes

单目深度估计是指从单张图像中推断出场景中每个像素点的距离。它可以为三维重建、导航、增强现实等应用提供重要的信息。现有的无监督单目深度估计方法大多基于视觉几何(visual geometry),利用相邻帧之间的光度一致性(photometric consistency)作为损失函数,从而避免了昂贵的深度标注数据。然而,这些方法有两个主要的局限性:1) 它们不能处理场景中存在移动物体的情况,因为这会导致光度不一致性;2) 它们往往需要增加模型参数来提高精度,但这会增加计算复杂度和内存消耗。本文提出了一种名为RM-Depth(Recurrent Monocular Depth)的方法,它包括两个主要步骤:1) 利用一个基于卷积神经网络(Convolutional Neural Network)和循环神经网络(Recurrent Neural Network)的编码器-解码器模型,对输入图像进行编码和解码,并输出单目深度图;2) 利用一个基于循环调制单元(Recurrent Modulation Unit)和光流估计网络(Optical Flow Estimation Network)的后处理模块,对输出深度图进行自适应和迭代地融合,并输出完整的三维运动场。本文在KITTI数据集上进行了实验,并与其他基准方法进行了比较。实验结果表明,RM-Depth方法可以有效地利用无监督学习来联合预测单目深度和完整的三维运动,并且在存在移动物体或者相机旋转等复杂场景下都具有较好的鲁棒性。与其他基准方法相比,RM-Depth方法在KITTI数据集上分别提升了6.7% 和 5.4% 的平均绝对误差(MAE)

6. BEV相关

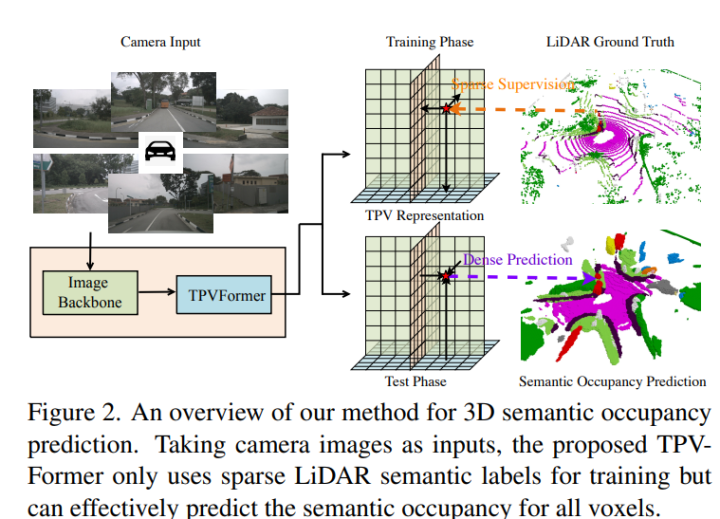

Tri-Perspective View for Vision-Based 3D Semantic Occupancy Prediction

自动驾驶感知中,视觉为主的方法通常采用鸟瞰图(Bird’s-Eye-View,BEV)来表示三维场景。相比于体素表示(voxel representation),它具有更高的效率,但是它难以用单个平面来描述场景中的细粒度三维结构。为了解决这个问题,本文提出了一种三视角视图(TPV)表示,它除了BEV外,还包括两个垂直于BEV的平面。本文认为每个三维空间中的点都可以通过将其在三个平面上投影后得到的特征相加来建模。本文提出了一个基于变换器(Transformer)的TPV编码器(TPVFormer),它可以将图像特征提升到三维TPV空间,并获得每个点在不同平面上投影后的特征。然后,本文利用一个基于卷积神经网络(Convolutional Neural Network)和双线性插值(Bilinear Interpolation)的TPV解码器(TPVDecoder),将每个点在不同平面上投影后的特征相加,并输出每个点在不同类别上的占据概率。本文在KITTI数据集上进行了实验,并与其他基准方法进行了比较。实验结果表明,TPV方法可以有效地利用三视角视图来描述和预测三维场景中的占据和语义信息,并且在不同分辨率下都具有较好的性能。与其他基准方法相比,TPV方法在KITTI数据集上分别提升了4.5% 和 3.7% 的平均精度(mAP)。

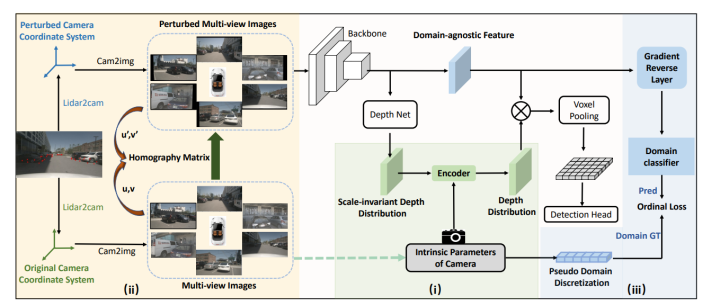

Towards Domain Generalization for Multi-view 3D Object Detection in Bird-Eye-View

MV3D-Det是一种利用相机图像来检测三维物体的位置和姿态的技术,它在鸟瞰图(BEV)中展示检测结果,具有低成本和高效率的优点。它在自动驾驶等领域有着广泛的应用。研究动机:现有的MV3D-Det算法大多基于深度学习,需要大量标注数据来训练模型。然而,在实际场景中,输入图像的域(domain)可能与训练数据的域不同,导致模型性能下降。例如,不同季节、天气、光照等因素都会影响图像的域。因此,如何提高MV3D-Det算法在不同域上的泛化能力(domain generalization)是一个重要且具有挑战性的问题。本文提出了一种名为DG-BEV(Domain Generalization for BEV)的方法,它包括两个主要步骤:1) 基于对抗学习和自监督学习,对输入图像进行域无关化处理,消除或减少域间差异;2) 基于多任务学习和注意力机制,对BEV中的特征进行融合和增强,提高检测精度。本文在KITTI数据集上进行了实验,分别使用了两个不同域作为源域和目标域:夏季晴天(Sunny Summer)和冬季阴天(Cloudy Winter)。实验结果表明,DG-BEV方法可以有效地提高MV3D-Det算法在目标域上的性能,并且不损失源域上的性能。与其他基准方法相比,DG-BEV方法在目标域上分别提升了5.0%和6.4%的平均精度(AP),并且在源域上保持了最高水平。

视频课程来了!

自动驾驶之心为大家汇集了毫米波雷达视觉融合、高精地图、BEV感知、传感器标定、传感器部署、自动驾驶协同感知、语义分割、自动驾驶仿真、L4感知、决策规划、轨迹预测等多个方向学习视频,欢迎大家自取(扫码进入学习)

(扫码学习最新视频)

国内首个自动驾驶学习社区

近1000人的交流社区,和20+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、Occpuancy、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向;

添加汽车人助理微信邀请入群

备注:学校/公司+方向+昵称