无锡VALSE 2023感悟收获(NLP方向)_valse2023汇报ppt

赞

踩

1、之前导师让我调研一些能支撑prompt learning/tuning这一套东西有效的佐证(大佬的文章、top文章之类),从那以后我就一直都在留意。我看到的大都是一笔带过,大体都是说之所以有效是因为通过提示模板将下游任务重构成了预训练任务的形式云云,那为什么将下游任务重构成预训练任务的形式就能有效呢?刘鹏飞老师的报告解开了(或许是部分解开了?)我一直以来的疑惑。

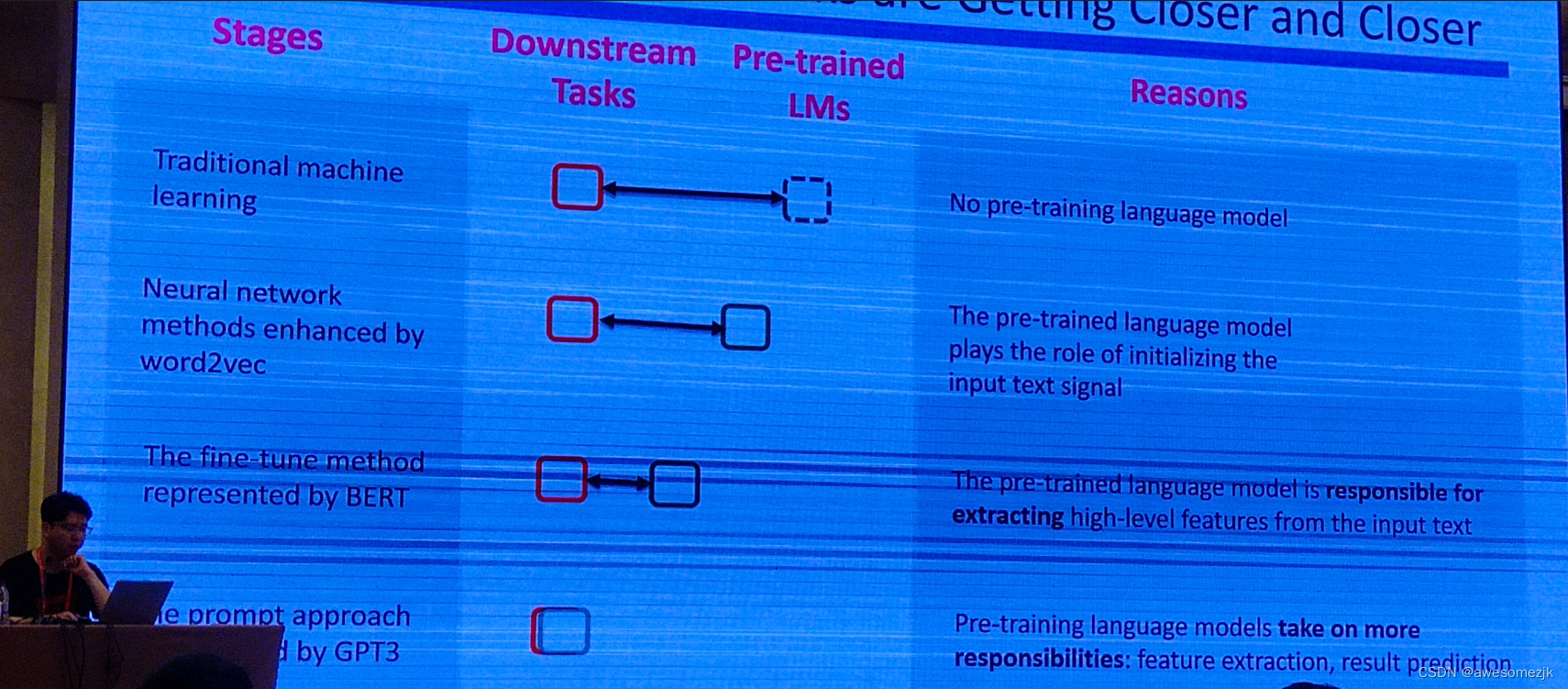

刘鹏飞老师通过NLP的四个发展阶段——传统机器学习阶段,基于word2vec的神经网络阶段,pre-train fine-tuning阶段以及当前的prompt阶段——来展示下游任务与预训练任务越来越接近,而下游任务与预训练任务越接近,预训练模型就可以在进行下游任务时承担更多的工作(,所以预训练模型就能将自己学习到的能力更全面更充分运用到下游任务上?而不是像之前的发展阶段预训练模型的能力在下游任务上只是部分得到发挥(我自己的理解,这么表述可能还是没能抓住刘鹏飞老师观点的本质,PPT原文如下图)),如果你能想到一种让下游任务与预训练任务更接近的方法,那肯定会比prompt好。

或许是前后呼应?刘鹏飞老师后来的报告内容也设想了未来在预训练的时候就加入prompt engineering,使得模型在预训练时就习惯提示模板,从而进行下游任务时不需要给输入文本进行提示模型就能直接预测(希望没理解错,其实讲这里的时候我没太跟上,刘老师语速略有些飞快加上会场音响问题)。

2、接上,今年5月在苏州中国图象图形大会上黄民烈老师也表达了一种相近的观点,现在大模型很多人调不起,不得不采取一些参数高效微调方法(PEFT),软提示微调就是其中一种PEFT方法。既然要微调软提示,且软提示的初始化也是个问题(一般是随机初始化),为何不在大模型预训练的时候就带着软提示一起预训练?这样在未来需要微调的时候就可以直接微调这个“原厂自带”的,具备良好初始化参数的,更容易与自家模型“谈心”的软提示。果然大佬就是大佬,都想一块去了。

3、邱锡鹏老师在聊MOSS的时候稍微提到了多轮对话,说多轮对话其实就是把前面所有的对话全部拼接到一起,作为前文输入到模型中让模型去做下一个token生成。我在想,假如现在有三轮对话:

第一轮对话:

User:这家餐厅好好吃。

MOSS:blablabla。。。

第二轮对话:

User:什么是自然语言处理?

MOSS:blablabla。。。

第三轮对话:

User:我明天还要来这家餐厅

MOSS:blablabla。。。

这时User发起了第四轮对话,问:这家餐厅明天营业吗?

那么这时候第二轮对话其实并不是(或者说不应该是)这一轮对话的前文,此时是否会采取一些工程上的技巧将第二轮对话识别出来,不将其作为第四轮对话的前文呢?还是说第二轮对话会和其它轮对话一样被平等对待,照样作为前文输入到模型中,让模型自己硬着头皮去分辨后再做下一个token预测呢?

4、其实当时在会场准备了个问题打算请教刘鹏飞老师的,草稿都写好了(如下图所示),但是听会场其他人的提问,相比之下感觉我的问题有些naive和莫名其妙,所以最后就没问。(我在想不是个tutorial吗,为什么大家的问题都那么高级)