- 1用多模态信息做 prompt,解锁 GPT 新玩法

- 2C++之正则表达式_c++ 正则表达式

- 3图系列|7篇动态时空图网络学习必读的顶会论文

- 4Python中的Assert语句简明教程_python中assert

- 5mysql 添加索引,ALTER TABLE和CREATE INDEX的区别

- 6Flink CDC 3.0 详解_flinkcdc 3.0.1

- 7使用sk-learn库实现k-means算法对iris数据分类_使用sklearn中的kmeans算法对iris数据集进行聚类分析

- 8PostgreSQL技术大讲堂 - 第30讲:多表连接方式_pgsql 关联查询多张表

- 9RC滤波器(高通/低通)

- 10本周重要AI资讯_kimi用的国外开源

Towards Open Set Deep Networks(CVPR 2016)

赞

踩

Bendale A , Boult T . Towards Open Set Deep Networks[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2016

摘要

深度网络在各种视觉识别问题上产生了显著收益,导致了学术和商业应用。最近在深度网络的工作强调,很容易生成人类永远不会将其分类为特定对象的图像,但深度网络把这些图像分类为给定类的置信度很高,深度网络很容易被人类认为没有意义的图像愚弄。深度网络的封闭集特性迫使它们从已知类中进行选择,导致此类事件。在现实世界中识别是开放集,即识别系统在测试时拒绝未知/看不见的类。我们提出了一种适应深度网络进行开放集识别的方法,通过引入一个新的模型层OpenMax,它估计一个输入来自未知类的概率。估计未知概率的一个关键因素是将元识别概念应用于网络倒数第二层的激活模式。OpenMax允许拒绝呈现给系统的“欺骗”和不相关的开放集图像;OpenMax大大减少了由深度网络造成的明显错误的数量。证明了OpenMax概念提供了有界开空间风险,从而正式提供了一个开集识别解决方案。我们使用来自ImageNet2012年验证数据上的Caffe Model-zoo的预训练网络,以及数千张“欺骗”和开放集图像,来评估所得到的开放集深度网络。所提出的OpenMax模型显著优于基本深度网络和具有softmax概率阈值设置的深度网络的开放集识别精度。

1 介绍

由于在视觉和学习的研究进展,计算机视觉数据集已经从几百张图像增长到数百万张图像,并从几个类别增长到数千个类别。近年来对深度网络的研究显著改善了视觉识别[26,3,11]的许多方面。丰富的表示、可伸缩的分类方法和大型数据集的共同进化已经导致了许多商业应用[5,28,16,6]。然而,在动态和不断变化的现实世界中部署识别系统时,广泛的操作挑战发生。绝大多数的识别系统是为静态封闭世界设计的,其中主要的假设是所有类别都是已知的。深度网络,就像许多经典的机器学习工具一样,被设计用于执行封闭集识别。

最近在开放集识别[20,21]和开放世界识别[1]方面的工作,已经形式化了在测试时需要拒绝未知对象的设置中进行识别的过程。虽然人们总是可以用一个“其他”类来训练以表示不感兴趣的类(已知的未知KU),但它不可能用所有未知对象的可能例子来训练。因此,需要设计视觉识别工具,正式解释“未知的未知”[18]。虽然已经开发了一系列的算法来解决这个问题[4,20,21,25,2],但利用深度网络进行开放集识别仍然是一个未解决的问题。

在大多数深度网络[11,26,3]中,最后一个全连接层的输出被输入给SoftMax函数,从而在N个已知类标签上产生概率分布。虽然深度网络总是有一个最可能的类,但人们可能希望,对于未知输入,所有类的概率都是低的,阈值化不确定性将拒绝未知类。最近的论文展示了如何产生“欺骗”[14]或“垃圾”的[8]图像,这些图像在视觉上远离期望的类,但产生高概率/置信度分数。他们强烈认为,对不确定性的阈值并不足以确定什么是未知的。在第3节中,我们表明,将深度网络扩展到对SoftMax概率设置阈值在一定程度上提高了开放集识别,但并不能解决欺骗图像的问题。在深度网络的理论/实践中,即使有阈值概率,也不满足在[20]中提到的开集识别的正式定义。这就引出了本文中提出的第一个问题:“如何使深度网络适应于支持开放集识别?”

SoftMax层是问题的一个重要组成部分。我们提出了另一种替代方案,OpenMax,通过允许它预测未知类来扩展SoftMax层。OpenMax包含了识别系统故障的可能性。这种可能性用于估计属于一个未知类的给定输入的概率。对于这个估计,我们将元识别[22,32,9]的概念应用于深度网络。我们使用来自深度网络的倒数第二层(在SoftMax之前的全连接层,例如,FC8)的分数来估计输入是否与已知的训练数据“很远”。我们将该层中的分数称为激活向量(AV)。这些信息被纳入到我们的OpenMax模型中,并用于描述识别系统的故障。通过除去已知类概率之和为1的限制并拒绝远离已知输入的输入,OpenMax可以在操作过程中正式处理未知/不可见的类。我们的实验表明,所提出的OpenMax和元识别思想的组合很容易解决深度网络的开放集识别,并拒绝高置信度欺骗图片。

虽然欺骗/垃圾图像,对人类观察者来说,显然不是来自于感兴趣的一类,对抗性图像[8,27]提出了一个更困难的挑战。这些对抗性图像在视觉上与训练样本难以区分,但被设计成使深度网络产生高可信度但不正确的答案。这与标准的开放空间风险不同,因为对于任何给定的输出类,对抗性图像在输入空间中“接近”一个训练样本。

在我们的开放深度网络中的一个关键见解是,“开放空间风险”应该在特征空间中测量,而不是在像素空间中测量。在之前的工作中,大多数问题[20,21,1]的开放空间风险不在像素空间中测量。因此,我们问“是否存在一个特征空间,理想情况下是在深度网络中的一个层,使这些对抗图像远离训练样本,即在这层中未知的、欺骗的和对抗的图像在开放集识别问题中会成为异常值?”在2.1节中,我们研究了在深度网络中测量开放空间风险的特征空间/层的选择。我们证明,在倒数第二个网络层的整体激活模式上,极值元识别启发距离归一化过程为未知图像、欺骗图像甚至许多对抗图像的OpenMax归一化提供了拒绝概率。在图1中,我们展示了我们模型的激活模式的一些例子,输入图像、欺骗图像、对抗性图像(系统能拒绝的)和开放集图像。

总结了本文的贡献:

1.利用激活向量的多类元识别来估计深度网络故障的概率。

2.利用元识别和OpenMax形成开放集深度网络,并证明了所提出的方法可以管理深度网络的开放空间风险。

3.实验分析开放集深度网络在保持测试图像准确性的同时,拒绝未知类、欺骗图像、由对抗图像产生的明显错误的有效性。

理解:

- 对softmax输出概率设置阈值在一定程度上提高了开集识别,但是不能解决欺骗图片的问题。

- 将深度网络的倒数第二层(softmax前的全连接层)的输出叫做激活向量,对其进行一些计算来估计输入是否与已知的训练数据“很远”。

- openmax和元识别相结合来解决深度网络开放识别问题。

- 在倒数第二个网络层的整体激活模式上,极值元识别启发距离归一化过程为未知图像、欺骗图像甚至许多对抗图像的OpenMax归一化提供了拒绝概率。

2 开放集深度网络

打开深度网络的一种自然方法是对输出概率应用一个阈值。我们认为这是拒绝不确定的预测,而不是拒绝未知的类别。预计来自未知类的图像都会有较低的概率,即非常不确定。这只适用于一小部分未知输入。在第3章我们的实验表明,阈值化不确定的输入是有帮助的,但仍然是用于开放集识别的相对较弱的工具。Scheirer等人[20]将开放空间风险定义为与标记距已知训练样本“很远”的数据相关的风险。这项工作只提供了一个一般的定义,并没有规定如何测量距离,也没有规定要测量这种距离的空间。为了使深度网络能够处理开放集识别,我们必须确保它们能够管理/最小化其开放空间风险,并具有拒绝未知输入的能力。

基于[21,1]中的概念,我们寻求选择一个层(特征空间),在其中我们可以建立一个紧凑度减弱概率模型,可以通过阈值来限制开放空间的风险。我们发展了这个模型作为一个基于与已学习模型的距离的衰减概率模型。在接下来的章节中,我们将详细阐述估计从已知训练数据距离的空间和元识别方法,然后是一种将这种距离纳入深度网络决策函数的方法。我们称我们的方法为OpenMax,作为SoftMax函数的替代品,作为网络的最后一层。最后,我们证明了整个模型是一个紧凑度减弱概率模型,因此,它满足一个开集识别的定义。

2.1 多类元识别(Alg.1计算MAV和Weibull拟合参数)

我们的第一步是确定何时一个输入很可能不是来自一个已知的类,也就是说,我们想要添加一个元识别算法[22,32]来分析分数,并识别深度网络的评估是否可能不正确。先前的元识别工作使用了最终的系统分数,基于极值理论(EVT)分析了它们的分布,发现这些分布遵循威布尔分布。虽然人们可以独立使用每个类的分数并使用EVT考虑它们的分布,但这不会产生一个紧凑度减弱概率,因为欺骗的图像显示分数本身不是来自一个接近已知输入训练数据的紧凑空间。此外,对类后识别分数(SoftMax层)的集合直接进行EVT拟合对于深度网络没有意义,因为最终的SoftMax层被有意地重正则化以遵循逻辑分布。因此,我们分析倒数第二层,它通常被视为每类的估计。这个每类的估计被SoftMax函数转换为最终的输出概率。

我们采用的方法是,来自倒数第二层网络的值(以下简称激活向量(AV))不是一个独立的每类分数估计,而是提供了哪些类是“相关”的分布。在2.2中我们讨论了基于图1的一个示例。

我们的整体EVT元识别算法总结在Alg 1.中。 为了使用AVs识别离群值,我们采用最近类均值[29,12]或最近非离群值[1]的概念,并将它们应用于激活向量中的每个类,作为第一近似。虽然更复杂的模型,如最近类多质心(NCMC)[13]或NCM森林[17],可以提供更准确的建模,但为了简单起见,本文只关注使用单一的平均值。每个类被表示为一个点,一个平均激活向量(MAV),只计算正确分类的训练样本的平均(Alg 1 的第2行).

给定MAV和一个输入图像,我们测量它们之间的距离。我们可以直接对距离设置阈值,例如,使用[1]的 cross-class验证方法来决定一个大概的最大距离阈值。在[1]中,这些特征通过度量学习来使它们规范化,这使得一个单一的共享阈值可行。然而,不同类别的AV缺乏一致性带来了更大的挑战,因此,我们寻求每个类别的元识别模型。在Alg 1 的第3行,我们使用libMR[22]FitHigh函数对所有正确的正训练实例和相关的µi之间的最大距离进行威布尔拟合。这得到了一个参数ρi,它用于估计一个输入相对于第i类的异常值的概率。

给定ρi,一个简单的拒绝模型将为用户定义一个阈值,决定一个输入是否应该被拒绝,例如,确保90%的训练数据被拒绝的概率接近于零。虽然实现起来很简单,但很难校准一个绝对的元识别阈值,因为它依赖于未知的未知数。因此,我们选择使用在Sec2中描述的OpenMax算法,它能够连续调整。

我们注意到,我们的校准过程只使用了正确分类的数据,其中类j排名第1。在测试中,对于输入x,假设类j具有最大的概率,那么ρj(x)提供了x是一个离群值并且应该被拒绝的Mr估计概率。我们对高级排名(例如,前10名)使用一个校准,但作为一个扩展,对不同级别的单独校准是可能的。注意,当每个样本有多个通道时,我们计算每个通道,每个类的平均向量µj,c和威布尔参数ρj,c。值得记住的是,我们的目标不是确定输入是哪个类,而是一个元识别过程,用于确定给定的输入是否来自未知类,因此应该被拒绝。

2.2 激活向量( activation vector)的解释

在本节中,我们基于图1说明激活向量和元识别的概念。

封闭集:假定输入是一个锤头鲨的有效输入,即图1中的第二组激活记录。激活向量显示了与大白鲨相关的AV维度的高分。所有的鲨鱼都与其他鲨鱼、鲸鱼和大型鱼类有许多直接的视觉特征和许多上下文的视觉特征,这就是为什么图1显示了这些群体中许多ImageNet类别的多个更高的激活值(亮黄绿色)。我们假设,对于大多数类别,存在一个相对一致的相关激活模式。MAV将该分布捕获为单个点。AV提供了一个空间,在那里我们根据每个类别的激活值来测量与输入图像的距离;如果是大白鲨,我们也预计虎鲨、锤头鲨以及鲸鱼的激活值会更高,但鸟类或棒球会非常弱或没有激活值。直观地看,这似乎是在训练过程中测量距离的合适空间。

封闭集:假定输入是一个锤头鲨的有效输入,即图1中的第二组激活记录。激活向量显示了与大白鲨相关的AV维度的高分。所有的鲨鱼都与其他鲨鱼、鲸鱼和大型鱼类有许多直接的视觉特征和许多上下文的视觉特征,这就是为什么图1显示了这些群体中许多ImageNet类别的多个更高的激活值(亮黄绿色)。我们假设,对于大多数类别,存在一个相对一致的相关激活模式。MAV将该分布捕获为单个点。AV提供了一个空间,在那里我们根据每个类别的激活值来测量与输入图像的距离;如果是大白鲨,我们也预计虎鲨、锤头鲨以及鲸鱼的激活值会更高,但鸟类或棒球会非常弱或没有激活值。直观地看,这似乎是在训练过程中测量距离的合适空间。

开放集:首先让我们考虑一个开放集图像,即一个来自未知类别的真实图像。这些数据将总是被深度网络映射到SoftMax提供最大响应的类,例如,图1中显示的岩石图像被映射到棒球,右边的鱼被映射到一个锤头鱼。有时开放集图像的置信度较低,但最大分数将产生相应的类。比较输入的AV和输入产生的最大响应的类的MAV,我们观察到它通常远离平均值。然而,对于一些开放集图像,提供的响应接近AV,但仍然有一个整体的低激活水平。如果输入是一个与已知类密切相关的“未知”类,或者如果对象足够小,它不能很好地区分,就会发生这种情况。例如,如果输入来自不同类型的鲨鱼或大型鱼类,它可能提供一个低激活值,但AV可能没有足够的不同而被拒绝。因此,除了直接估计一个类是否未知外,还需要对不确定性设置阈值进行开放集识别。

欺骗集:考虑一个欺骗输入图像,它是人为构造的,使一个特定的类(例如,棒球或锤头类)具有很高的激活分数,因此,可以以很高的可信度进行检测。虽然人为构建增加了感兴趣类的概率,但图像生成过程并没有同时调整所有相关类的分数,导致AV与模型AV“很远”。检查图1中每个类组的第三个元素,其中显示了来自欺骗图像的激活值。许多欺骗图像在视觉上是完全不同的,它们的激活向量也是不同的。许多激活度非常低的区域(深蓝色/紫色)可能是因为我们可以通过减少其他类的激活值来增加给定类的SoftMax的输出,这反过来又减少了SoftMax计算的分母。

对抗集:最后,考虑一个对抗性的输入图像[8,27,31],它被构造为接近于一个类,但被错误地标记为另一个类。图1的右下角显示了一个例子。如果对抗性图像被构造到一个附近的类,例如,从锤头鲨到大白鲨,那么本文提出的方法将无法检测到它——在MAV中没有捕获细粒度的类别差异。然而,对抗性图像可以在任何一对图像类之间构造,参见[27]。当目标类别足够远时,例如,这里的锤头和水肺的例子,或者更远,如锤头和棒球,对抗性图像将在激活向量上有显著差异,因此可以被拒绝。在我们的实验中,我们不考虑对抗图像,因为结果更多的是我们选择生成的对抗图像的函数——我们知道那是没有意义的分布。例如,如果我们选择随机类对(a,b)并从a到b生成对抗性图像,其中大多数将有很大的层次距离,很可能被拒绝。如果我们选择最接近的对抗性图像,很可能来自附近的类,激活将会很接近,它们将不会被拒绝。

OpenMax过程的结果是,开放集以及欺骗或对抗的图像通常会被拒绝。建立一个不被拒绝的欺骗或对抗的图片不仅意味着感兴趣的类获得了 高分,还意味着保持999个其他类的相对分数。至少,这些约束显著减少了对抗/欺骗图像的空间。希望任何满足所有约束的输入是一个也得到了人类支持类标签的图像,如[14]中图3里的一些欺骗的图像,如在对抗图像对中细粒度分离类别如公牛和大白鲨。

人们可能会想知道,单个MAV是否就足以表示具有不同方面/视图的复杂对象。而未来的工作应该检查可以捕获不同的视图/样本的更复杂的模型,例如,NCMC[13]或NCM森林[17]。如果深度网络实际上已经实现了视图独立识别的目标,那么倒数第二个激活向量的分布应该几乎是视图独立的。虽然鲨鱼的张开颚和侧视图在视觉上是完全不同的,多范例模型可能更有效地捕捉不同视角中不同的特征,但不同鲨鱼的张开颚仍然非常相似,它们的侧视图也是如此。因此,每个视图可能呈现一个相对一致的AV,允许单个MAV捕获两者。直观地看,虽然图像特征可能随视图而变化很大,但由AV所代表的“相关类”的相对强度应该更独立于视图。

2.3 OpenMax(Alg.2)

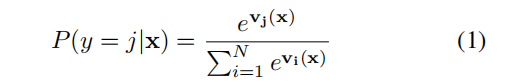

标准的SoftMax函数是类别概率分布的梯度对数归一化器——这是它通常被用作网络的最后一个完全连接层的主要原因。传统的定义在计算过程中每个节点有权值。基于caffe的深度网络[10]的倒数第二个网络层的分数,我们称之为激活向量,具有在产生它的卷积中执行的加权(也就是说是这层前面的网络加权得到的)。设v(x)=v1(x),…,vN(x)是每个类的激活级别,y=1,…,N。经过深度网络训练后,输入图像x生成激活向量v(x),SoftMax层计算:

其中,分母对所有类求和,以确保对所有类的概率求和为1。然而,在开放集识别中,在测试时将会出现一些未知的类,因此,要求概率之和为1是不合适的。

其中,分母对所有类求和,以确保对所有类的概率求和为1。然而,在开放集识别中,在测试时将会出现一些未知的类,因此,要求概率之和为1是不合适的。

为了使SoftMax适应于开集,设ρ为Alg.1 估计的每个类的元识别模型的向量。 在Alg.2中我们总结了OpenMax计算的步骤。为方便起见,我们将未知未知类定义为索引0。我们使用在x和µi间距离上的威布尔CDF概率(Alg.2的第3行),作为拒绝估计的核心。µi是使用与类别 i 相关的图像计算的,在训练过程中正确分类的图像(第一名)。我们期望距离的EVT函数只为少数顶级排名提供一个有意义的概率。因此,在Alg.2的第3行,我们计算α个最大激活类的权值,并使用它来缩放威布尔CDF概率。然后,我们计算修正后的激活向量与最高的分数的改变。我们为未知的未知类计算一个伪激活值,以保持总激活水平不变。包括未知的未知类,新的修正激活值计算OpenMax概率,如在等式2中。

当未知未知类(y=0)具有最大的概率时,OpenMax提供了支持显式拒绝的概率。这种元识别方法是确定未知未知类的第一步,我们的实验表明,单个MAV在检测欺骗图像方面相当有效,而且比仅仅对不确定性设定阈值更好。然而,在任何产生确定性估计的系统中,对不确定性设置阈值仍然是一种有效的元识别类型,不应被忽视。因此在Alg2的第9行,最终的OpenMax方法也拒绝了未知的和不确定的输入中。

为了选择超参数∈,η和α,我们可以使用一组训练图像加上开放集图像的采样进行网格搜索校准,优化F measure。这里的目标是总体规模/灵敏度选择的基本校准,而不是优化未知未知数空间上的阈值,这不能通过实验来完成。

注意,未知未知类的概率的计算本质上改变了所有估计的概率。对于一个固定的阈值和是未知的可能性很小的输入,OpenMax将比SoftMax拒绝更多的输入。图2显示了100个示例图像、50个训练图像和50个开放集图像以及欺骗图像的OpenMax和SoftMax的概率。非对角线性越多,OpenMax改变的概率就越大。基于不确定性的拒绝的阈值选择,将在保留训练示例和拒绝开放集示例之间找到平衡。欺骗图像没有用于阈值选择。

虽然这不是我们的实验评估的一部分,但请注意,OpenMax也通过其估计的概率提供了有意义的等级排序。因此,OpenMax直接支持一个被拒绝的前5类输出。同样重要的是要注意,由于激活分数vˆi(x)的重新校准,OpenMax通常不会产生相同的分数等级排序。

2.4 OpenMax紧凑度减小属性

虽然阈值化的不确定性确实提供了拒绝某些输入的能力,但它还没有被证明已经正式地限制了深度网络的开放空间风险。很容易看出,在激活向量方面,SoftMax的正标记空间不局限于训练空间附近,因为最大类分数的任何增加都增加了其概率,同时降低了其他类的概率。随着最大方向的充分增加,即使是其他维度的大变化,仍然会为领先类提供大的激活值。虽然理论上可能会说深度网络激活值是有限的,但[14]中的欺骗图像是令人信服的证据:SoftMax不能管理开放空间风险。

定理1(开放集深度网络):一个在激活向量上使用元识别进行扩展(正如在Alg2中)、同时SoftMax被改编为OpenMax(就像在公式2)的深度网络,提供一个开放集识别功能。

证明:元识别概率(威布尔的CDF)是||µi−x||的单调递增函数,因此1−ωi(x)是单调递减的。因此,它们构成了在[21]中所定义的紧致减弱概率的基础。由于OpenMax变换是元识别概率的加权单调变换,应用[1]的定理1和2,得到了:对未知的OpenMax概率设置阈值能够管理在AV特征空间中测量的开放空间风险。因此,它是一个开集识别函数。

理解:

- 元识别能够产生一个函数ρi,它用于估计一个输入相对于第i类是异常值的概率,接着要定义一个阈值决定一个输入是否应该被拒绝。openmax用来决定元识别阈值。

- Alg2最后一行表明模型有双重保险,有两种拒绝方案,概率最大的类为未知类(index=0)或者最大概率小于阈值∈。

3 实验分析

我们的评估是基于ImageNet大规模视觉识别竞赛(ILSVRC)2012年数据集,带有1K个视觉类别。该数据集包含大约130万(1.3M)张用于训练的图像(每个类别大约有1K到1.3K张图像),50K张图像用于验证,150K张图像用于测试。由于ILSVRC2012的测试标签不公开,就像其他人做的那样,我们报告了在验证集上[11,14,23]的性能。我们使用由Caffe软件包[10]提供的预先训练好的AlexNet(BVLCAlexNet)深度神经网络。据报道,BVLCAlexNet在ILSVRC2012验证集上获得了约57.1%的前第一名准确率。选择预先训练过的BVLCAlexNet是经过深思熟虑的,因为它是开源的,也是深度学习中使用最广泛的软件包之一。

为了确保适当的开放集评估,我们应用了一个类似于在[21,1]中给出的测试协议。在测试阶段,测试系统使用了:ILSVRC2012验证集的所有1000个类别、欺骗类别和以前的未见过的类别。以前未见过的类别是从ILSVRC2010中选择的。俄罗斯萨科夫斯基等人[19]指出,2010年ILSVRC中大约有360个类别被丢弃,并没有在2012年ILSVRC中使用。来自这360个类别的图像作为开放集图像,即看不见或未知的类别。

欺骗图像通常是人类完全无法识别为属于给定的类别但深度网络报告几乎确定它们来自特定的类别。我们使用Nguyen等人[14]提供的由进化算法或在像素空间中的梯度上升生成的欺骗图像。最终的测试集包括来自ILSVRC2012的50K封闭集图像(每个类别有50张图片),15K开放集图像(来自ILSVRC2010的360个不同类别)和15K欺骗图像(每个ILSVRC2012类别各有15张图像)。

训练阶段:如Alg.1所述,我们考虑倒数第二层(全连接层8,即FC8),用于计算平均激活向量(MAV)。通过考虑深度网络能够正确分类的训练实例来计算每个类的MAV向量。分别计算每个crop/通道的MAV。计算每个正确分类的训练实例与特定类的MAV之间的距离,得到特定类的距离分布。对于这些实验,我们使用的距离是标准化欧几里得距离和余弦距离的加权组合。补充材料显示:使用纯欧几里得和其他度量得到的结果,总体表现相似。在这些距离上估计了威布尔分布的参数。这个过程对ILSVRC2012中的1000个类重复这个过程。在一组小的保留数据的参数估计阶段,估计威布尔分布参数的尾部尺寸的精确长度。这个过程重复多次,以获得一个总体的尾巴大小为20。

测试阶段:在测试期间,每个测试图像都经过如Alg2中讨论的OpenMax评分校准过程。激活向量是一个测试图像的FC8层中的值,该测试图像由每个类和每个通道对应的1000x10维值组成。对于每个类中的每个通道,使用每个类的MAV和每个类的威布尔参数来对输入进行处理后比较。在测试过程中,计算与MAV相关的距离,并获得修正的OpenMax激活值,包括新的未知类(见Alg2的第5和第6行).OpenMax概率由每个通道计算,使用修正后的激活向量(Eq.2)产生1001x10维的概率输出。对于每个类,10个通道的平均值给出了总的OpenMax概率。最后,1001个类中概率最大的类是预测的类。然后,该最大概率服从于不确定性阈值(第9行)。在这项工作中,我们专注于严格的第1名预测。

评价:通过跟踪错误的分类,可以计算出封闭集系统的多类分类误差。对于开放集测试,评估必须跟踪由于已知类别上的标准多类分类而发生的错误,以及已知类别和未知类别之间的错误。正如在[25,20]中所建议的那样,我们使用f-measure来评估开放集的性能。对于开放集识别测试,f–measure优于准确率,因为它没有被ture negative所夸大。

对OpenMax/SoftMax概率值设置给定阈值,我们在整个数据集上计算TP、FP和FN。例如,使用验证集、欺骗集和开放集(见图3)对系统进行测试时,真阳性TP定义为验证集的正确分类,假阳性FP为验证集的错误分类,假阴性FN为欺骗集和开放集类别的图像被系统错误分类为已知的例子。图3显示了OpenMax和SoftMax在不同阈值下的性能。实验表明,所提出的OpenMax方法在开放集测试上始终获得更高的f-measure。

与1-vs-set算法的比较:由于在深度学习中这个相对较新的子领域缺乏可用的基线,我们考虑了一个开放集基线的线性模型。我们将1-vs-set开放集算法[20]应用于FC8数据。我们使用liblinear用1000个类的训练样本训练线性SVM。我们还使用[1]中引用的liblinear扩展训练了1-vs-set机器,在1000个类的训练数据上进行了改善。1-Vs-Set算法的总体f-measure仅为0.407,远低于OpenMax方法的0.595。

4 讨论

我们已经看到,在我们的OpenMax架构中,我们可以自动拒绝许多未知的开放集和欺骗图像,以及拒绝一些对抗性的图像,而对真实的分类率只有适度的影响。当使用元识别时,一个明显的问题是“我们如何处理被拒绝的输入?”虽然这最好由操作系统设计师来决定,但仍有多种可能性。**OpenMax可以作为一个在开放世界识别[1]的场景中的新颖检测器,之后人类给数据打标签然后系统增量学习新的类别。或者检测可以作为一个标志来引入其他模式[24,7]。**此外,人们还可以应用简单的图像处理方法(如高斯模糊、平滑等)消除噪声,噪声可能会导致错误分类。例如在1中,OpenMax拒绝有噪声的输入图片,但经过少量的高斯模糊,图像被重新处理并以0.79的概率被接受为锤头鲨。

我们使用非测试数据进行参数调优,为了简洁起见,我们只显示了SoftMax和OpenMax随共享的不确定性阈值的性能变化。补充材料显示了更大范围的OpenMax参数的变化。在未来的工作中,真正的类别拒绝的增加可能会通过增加AV模型的表达性来减轻,例如每个类别有多个MAVs。这可能允许它更好地捕捉同一对象的不同上下文,例如,桌子上的棒球有不同的上下文,因此,在AV中可能有不同的“相关”类别,而不是投手投棒球。

有趣的是,我们观察到OpenMax拒绝过程经常识别/拒绝深度网络错误分类的ImageNet图像,特别是有多个对象的图像。类似地,许多远离训练数据的样本在场景中也有多个对象。因此,OpenMax拒绝的其他用途可以是改进训练过程,并帮助开发更好的定位技术[30,15]。其中的一个例子如图5所示。