热门标签

热门文章

- 1Android之蓝牙开发——简易布局(蓝牙的打开、关闭、搜索已配对设备、发现远程设备、配对,显示配对状态)_安卓显示蓝牙的控件

- 2细讲动态规划坐标型_动态规划 交叉点

- 3python 投屏_python脚本调用scrcpy进行多设备投屏

- 4minio简单搭建使用_minio本地搭建

- 5OpenCV学习笔记(六)之拉普拉斯算子_高斯 - 拉普拉斯操作数 opencv

- 6文献阅读-深度学习跨模态图文检索研究综述_跨模态检索研究综述

- 7Git使用方法笔记3——Git LFS_git lfs用法

- 8大规模语言模型--LLaMA 家族_llama2 33b

- 9github上的typescript项目,如何运行_github上的typescript项目怎么跑起来

- 10Git使用记录

当前位置: article > 正文

尚硅谷物流数仓数据采集通道平台到数仓建模部分问题解决方案_尚硅谷物流大数据物流

作者:从前慢现在也慢 | 2024-05-08 13:18:37

赞

踩

尚硅谷物流大数据物流

1.数据库名字 要从tms01 修改到 tms

2.修改mysql主从复制里面的 tms01 修改到 tms

3.DataX配置文件生成器 configuration.properties里面 把tms01 修改到 tms

4.修改 mysql_to_hdfs_full.sh 脚本中 tms01 修改到 tms

5.flink-cdc / flink-cdc.sh运行问题

解决方案:

首先先到hadoop102 开启 start-cluster.sh

1.通过web UI提交任务

全类名 / Entrt Class

com.atguigu.tms.realtime.app.ods.OdsApp

- 1

参数 / Program Arguments

--HADOOP_USER_NAME atguigu --mock_date 模拟日期(按需填写)

- 1

2.通过shell 命令提交任务

./bin/flink run -c com.atguigu.tms.realtime.app.ods.OdsApp ./job/tms-realtime-1.0-SNAPSHOT-jar-with-dependencies.jar -p 2 --HADOOP_USER_NAME atguigu --mock_date 模拟日期(按需填写)

- 1

可以使用 nohup 挂后台运行

nohup ./bin/flink run -c com.atguigu.tms.realtime.app.ods.OdsApp ./job/tms-realtime-1.0-SNAPSHOT-jar-with-dependencies.jar -p 2 --HADOOP_USER_NAME atguigu --mock_date 模拟日期(按需填写) > /dev/null(按需填写) 2>&1 &

- 1

6.修改Hadoop104 Flume 配置文件 tms_kafka_to_hdfs.conf 配置中

添加

a1.sources.r1.useFlumeEventFormat = false

- 1

检查下面全类名路径是否有问题

a1.sources.r1.interceptors.i1.type = com.atguigu.tms.flume.interceptors.TimestampAndTableNameInterceptor$Builder

- 1

7.修改Hadoop104 Flume JVM内存大小

cd /opt/module/flume/conf

- 1

vim flume-env.sh

- 1

添加下列内容

export JAVA_OPTS="-Xms200m -Xmx400m -Dcom.sun.management.jmxremote"

- 1

修改下列内容

cd /opt/module/flume/

- 1

vim bin/flume-ng

- 1

JAVA_OPTS="-Xmx240m"

- 1

2023/07/04

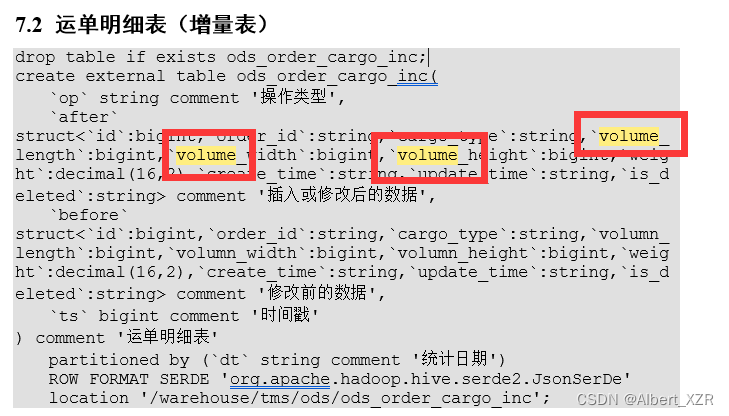

8.运单明细表建表语句

下图中的volume 都改成 volumn

目前就发现这些问题,有其他问题可以在下面留言~~

觉得不错点个赞吧~

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/554757

推荐阅读

相关标签