热门标签

热门文章

- 1基于transformers框架实践Bert系列2--命名实体识别

- 2统计git提交次数_git log提交次数

- 3苏州新导浅谈蓝牙定位在智能家居中的应用及未来发展_苏州蓝牙传输技术

- 4Kafka3.0.0版本——生产者回调异步发送消息 (API代码示例)_springboot3.0 kafka 回调函数

- 5【初阶数据结构】——带头双向循环链表(C描述)_带表头的对称循环双链表

- 6开源社区推广相关(二)|国内知名数据库专属社区 开放、便捷及专业 墨天轮(本文持续更新...)_国内通用型数据库 社区版

- 7Taskonomy: Disentangling Task Transfer Learning

- 8今日最佳AI论文5篇:高效微调、图生3D、AI Agent、大模型ChatGPT、图学习_ai大模型基于的论文

- 9set和map的区别

- 10git rebase执行失败恢复方法_git rebase 还原

当前位置: article > 正文

XTuner 大模型单卡低成本微调实战_2070显卡微调大模型

作者:从前慢现在也慢 | 2024-05-19 23:26:44

赞

踩

2070显卡微调大模型

微调背景

Finetune

LLM的下游应用中,增量预训练和指令跟随是经常会用到两种的微调模式

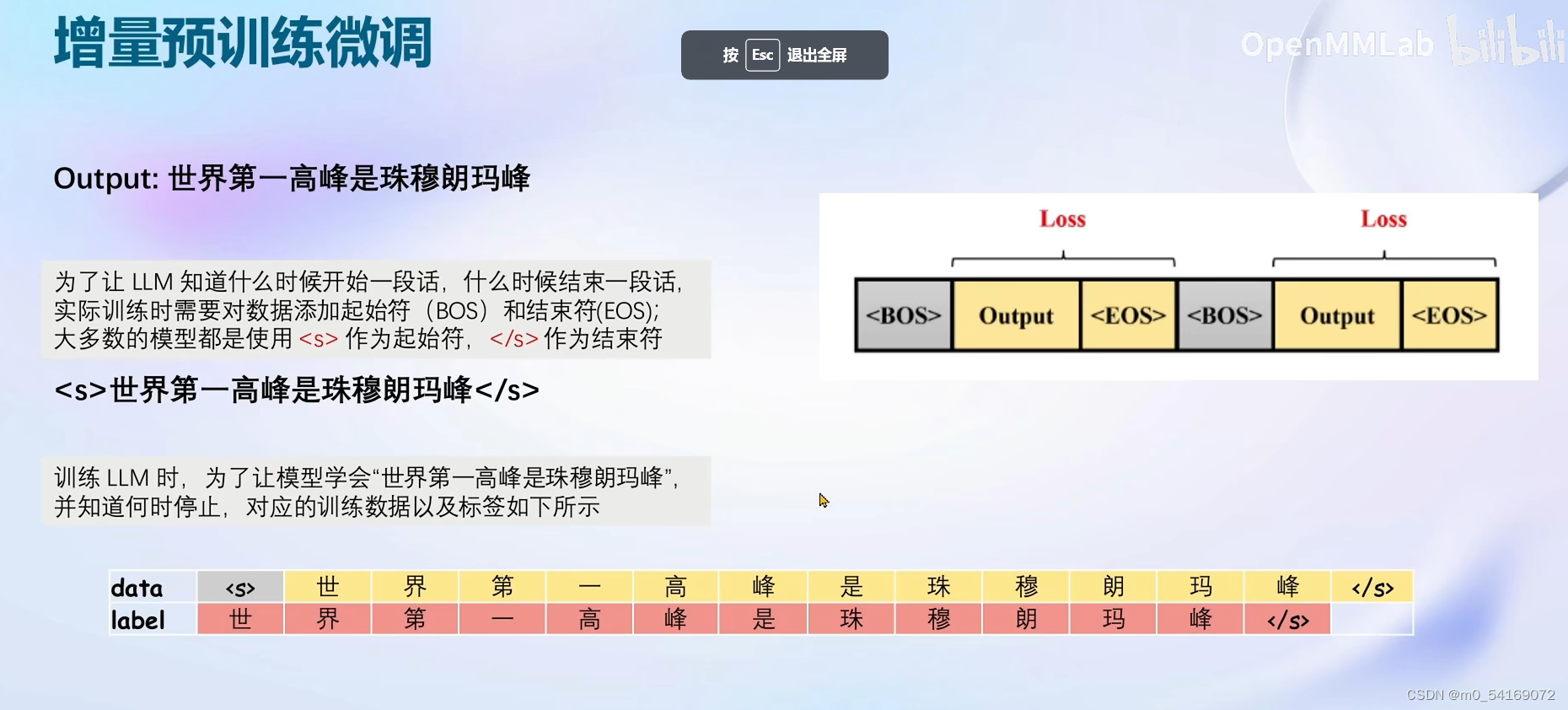

增量预训练微调

使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识

训练数据:文章、书籍、代码等

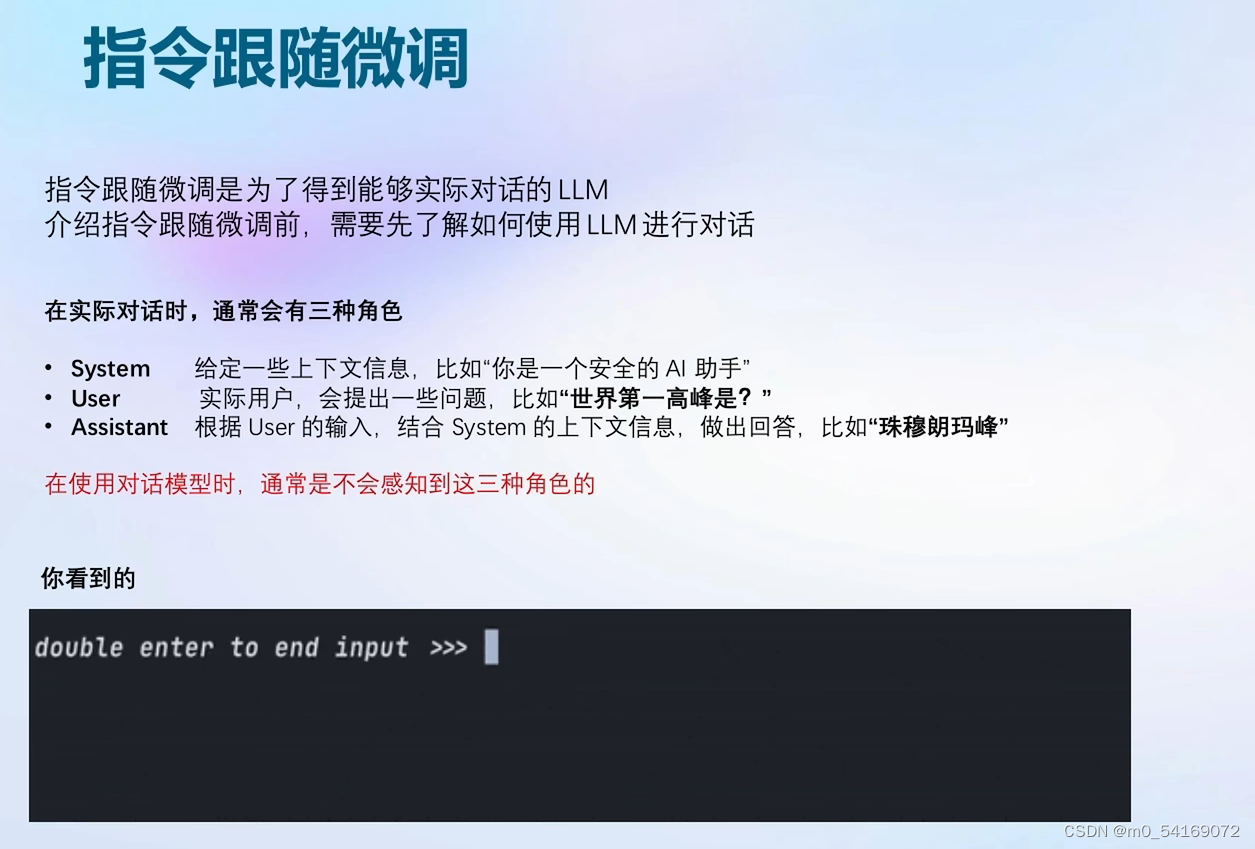

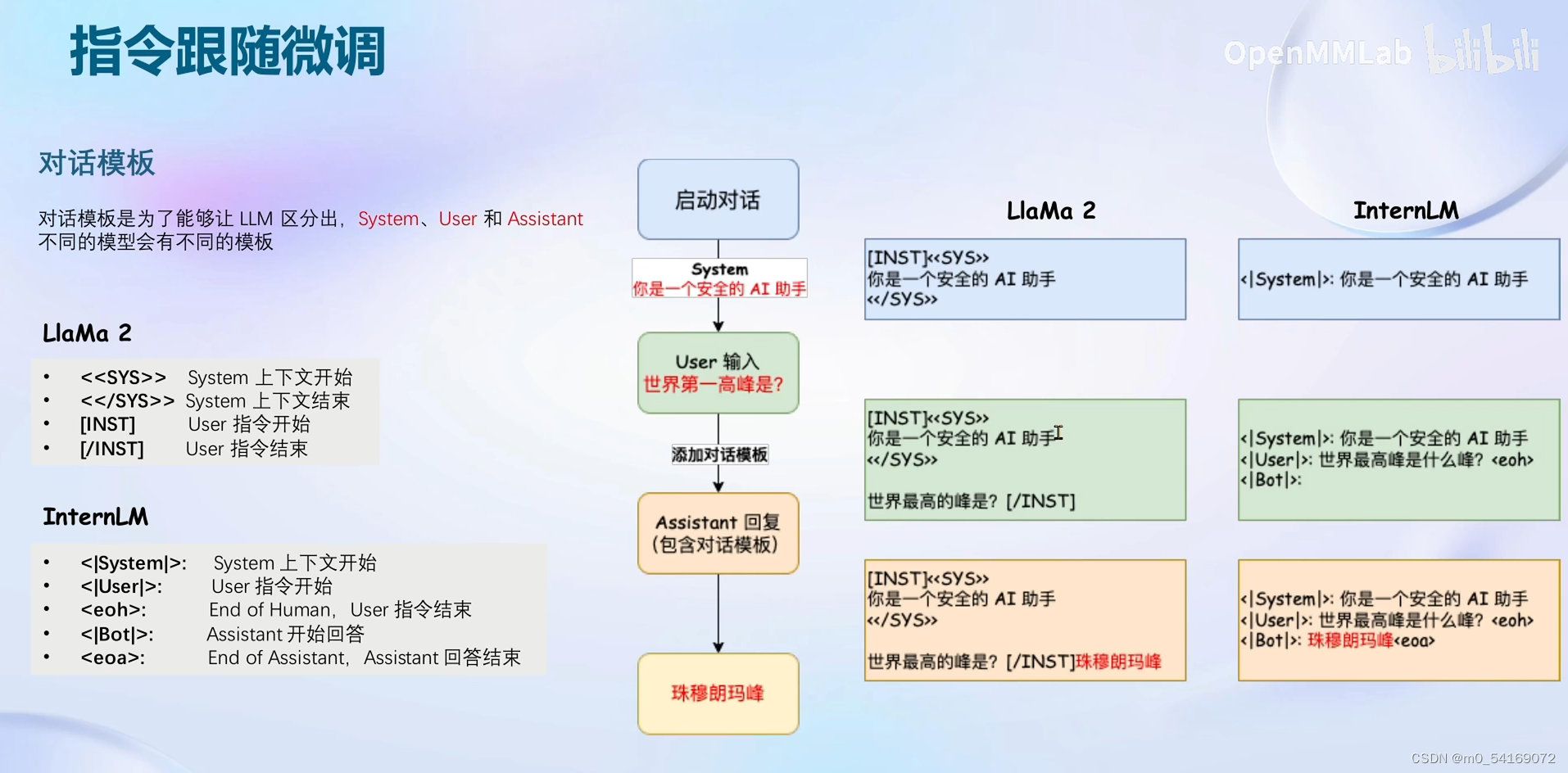

指令跟随微调

使用场景:让模型学会对话模板,根据人类指令进行对话

训练数据:高质量的对话、问答数据

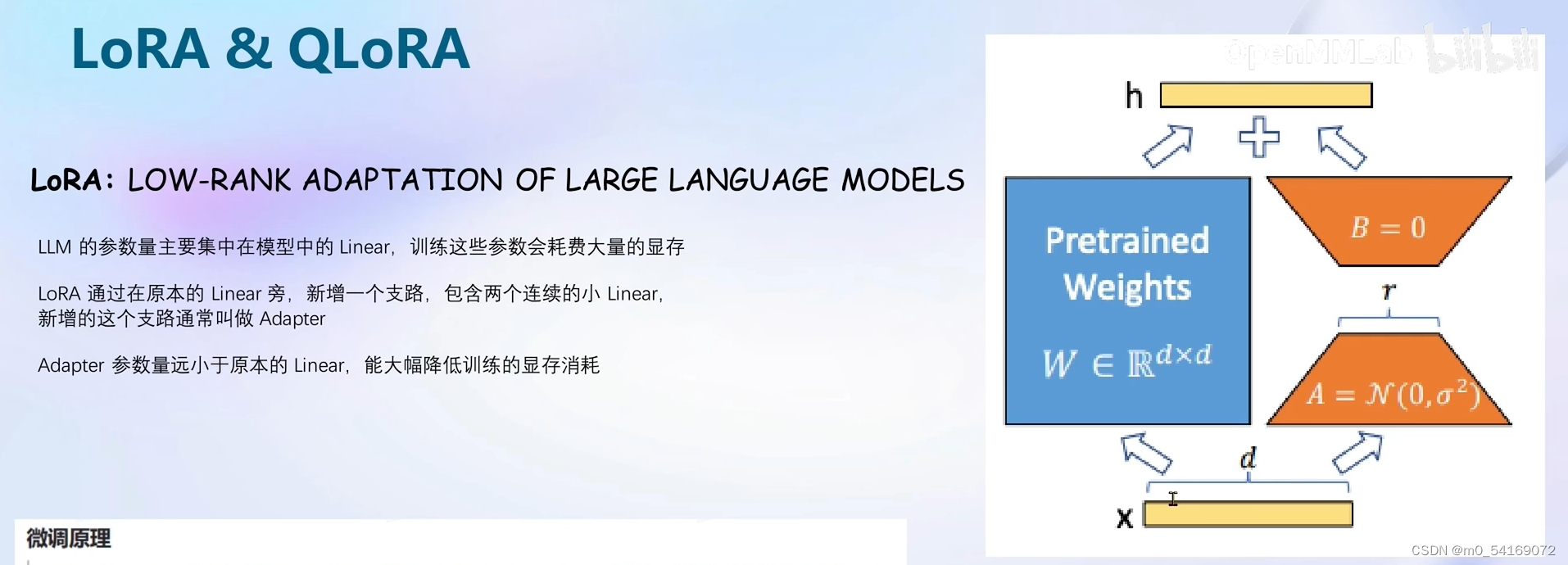

LORA & QLORA

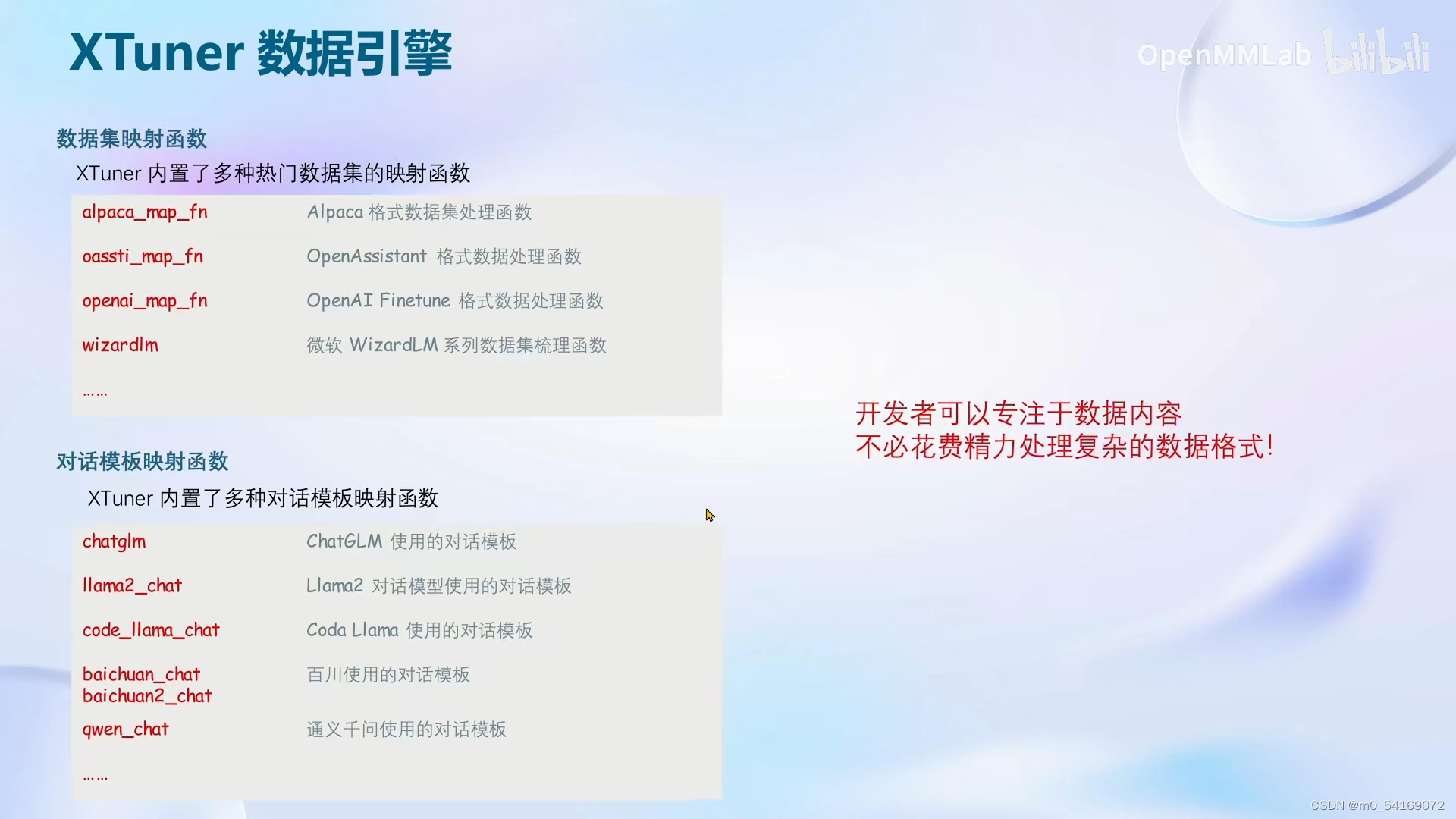

XTuner

8G显存使用LLM

课程实战

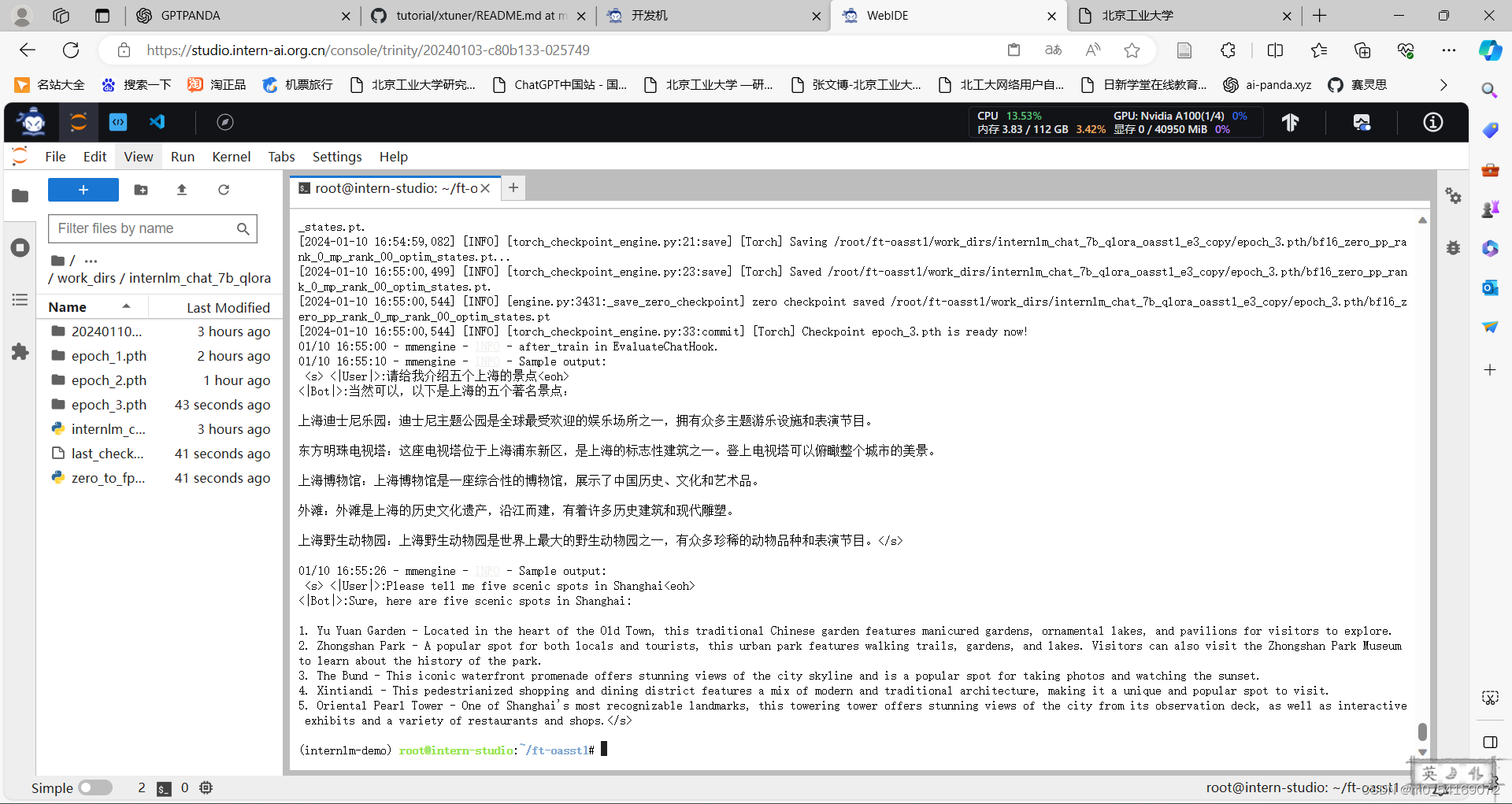

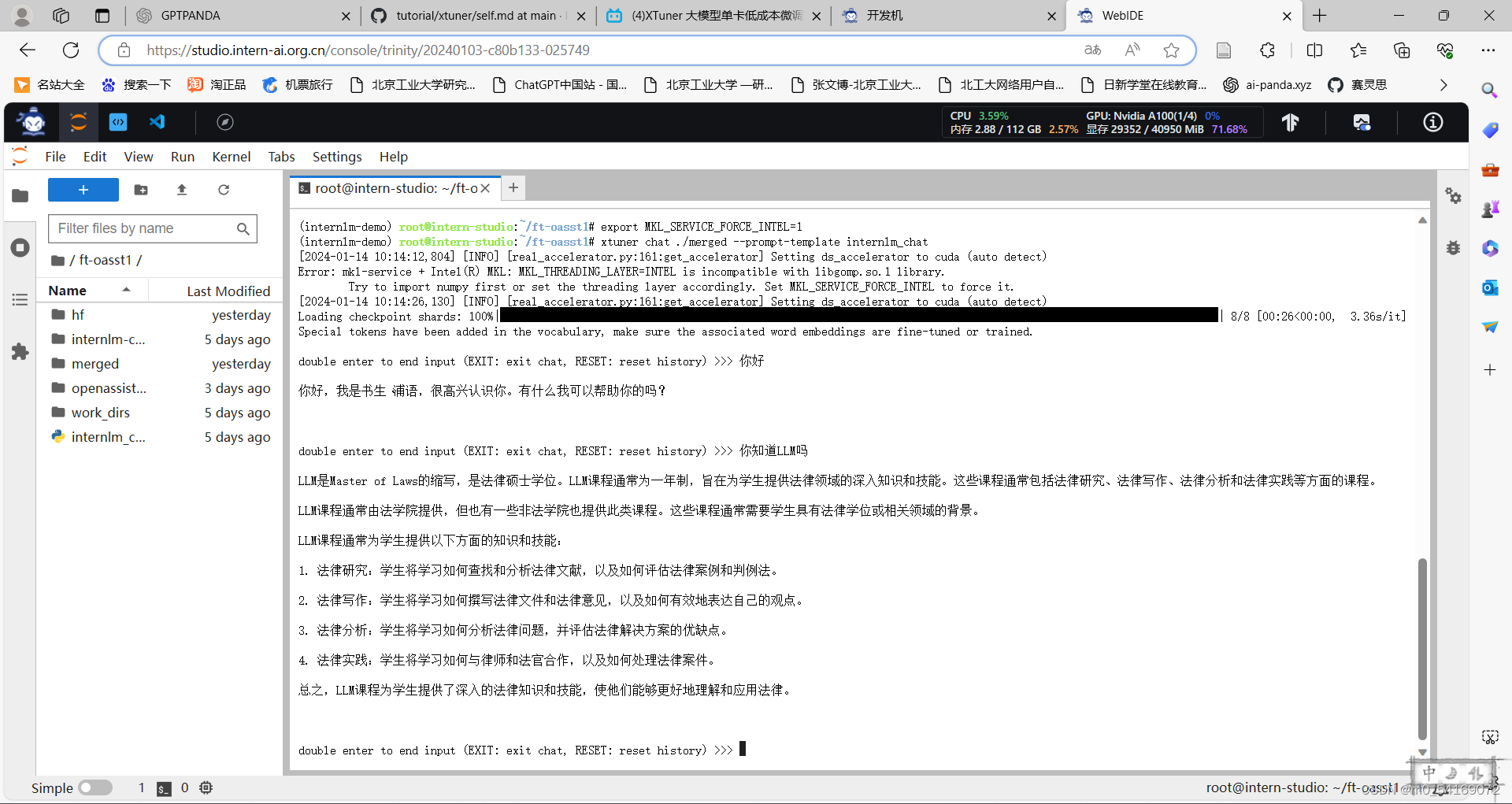

利用 QLoRA 算法在 oasst1 数据集上微调 InternLM-7B:

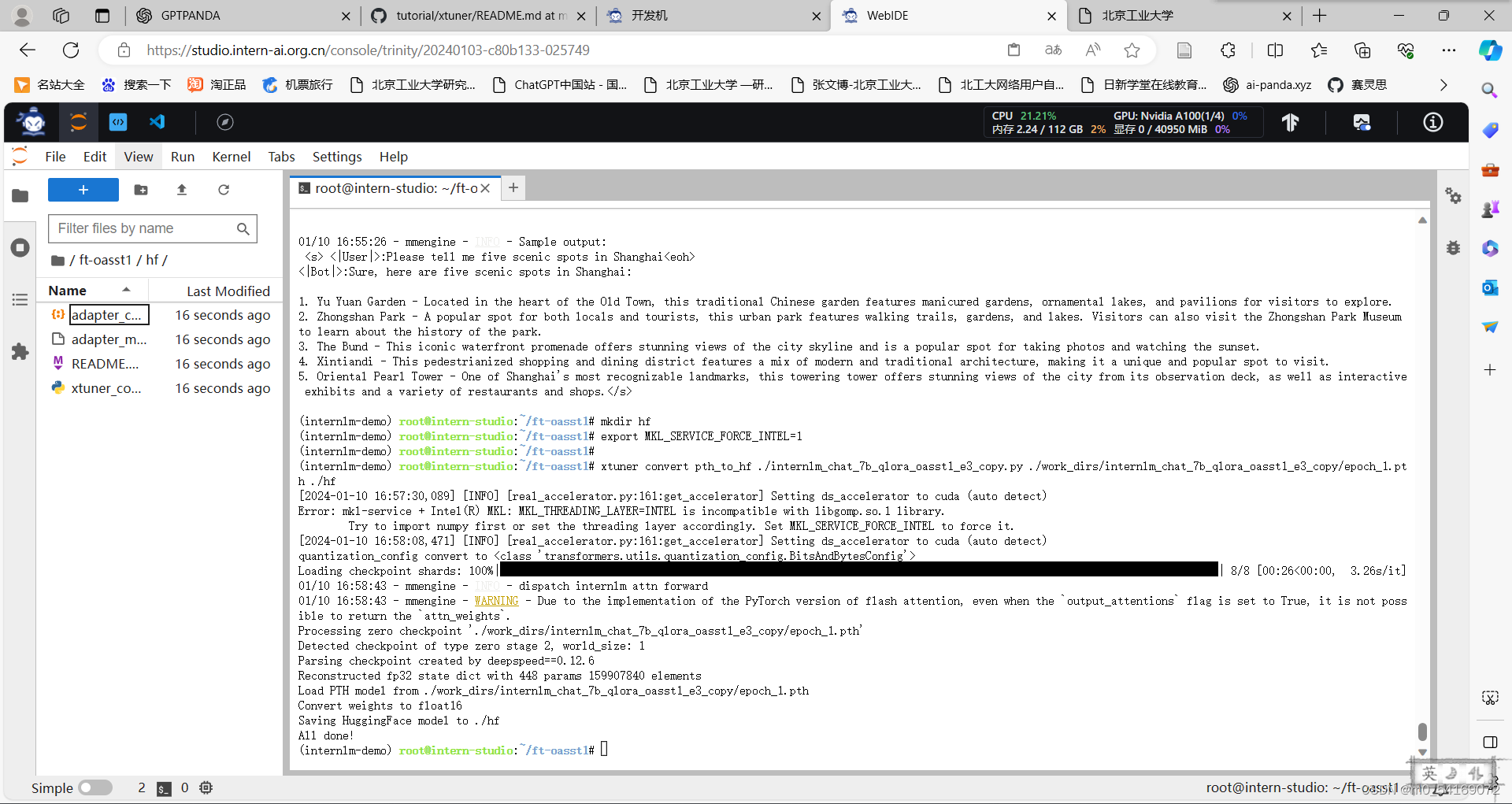

将得到的 PTH 模型转换为 HuggingFace 模型,即:生成 Adapter 文件夹

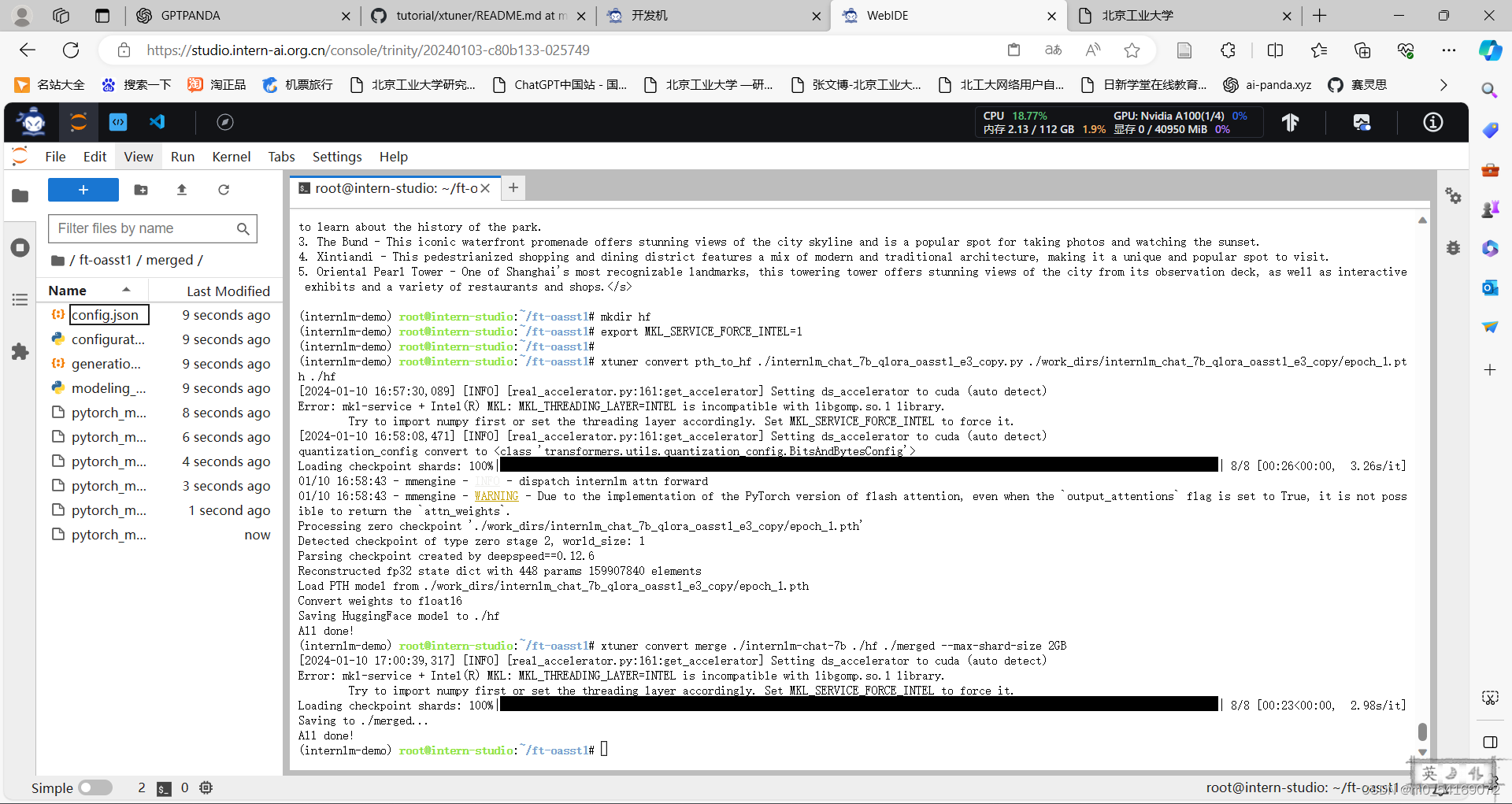

将 HuggingFace adapter 合并到大语言模型,与合并后的模型对话:

基础作业:

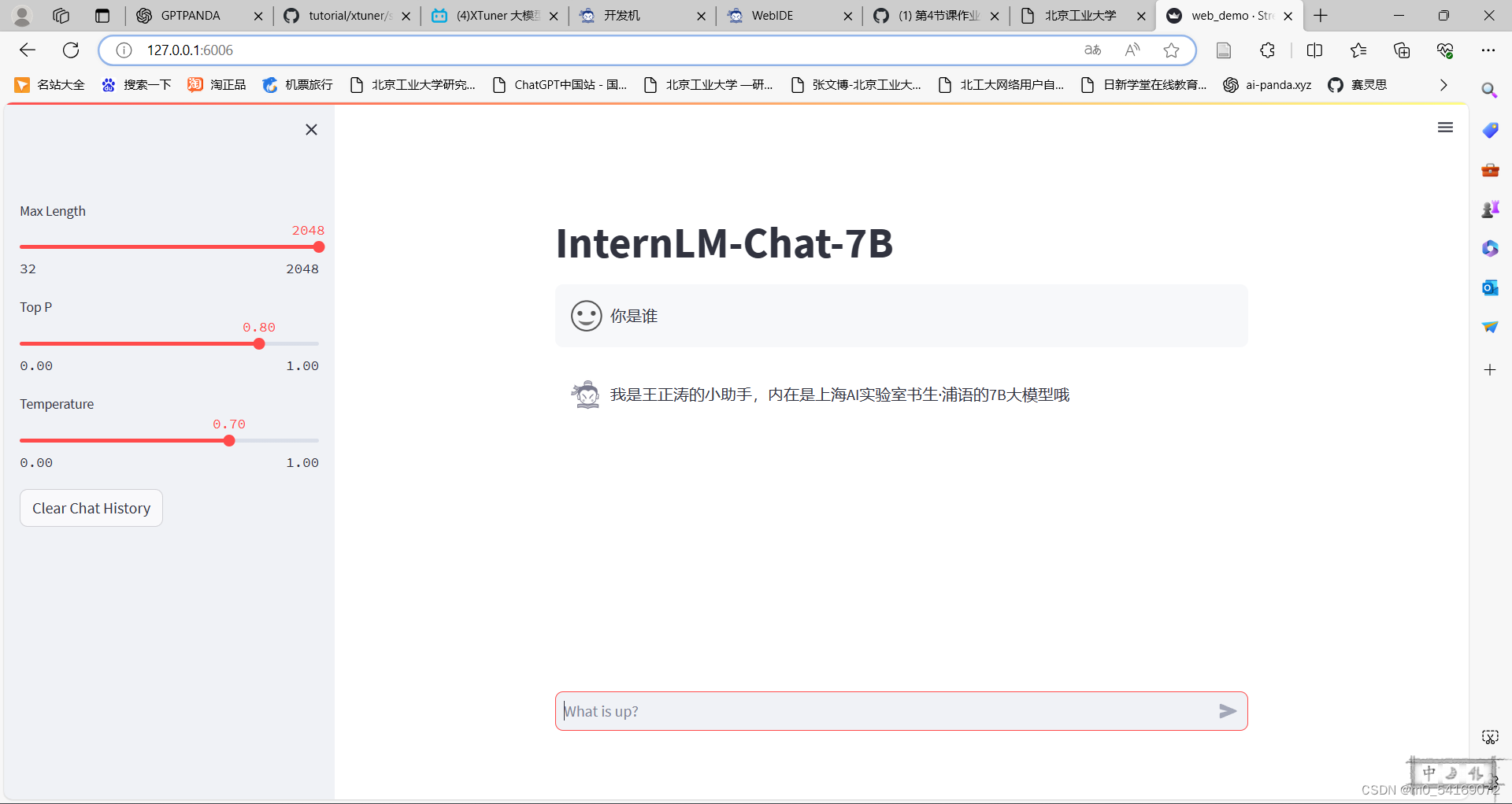

构建数据集,使用 XTuner 微调 InternLM-Chat-7B 模型, 让模型学习到它是你的智能小助手:

正在尝试将模型上传到Hugging Face,由于clash代理存在一些问题暂未成功,后期完成后会上传

课程参考:(4)XTuner 大模型单卡低成本微调实战_哔哩哔哩_bilibili

课程文档:tutorial/xtuner/README.md at main · InternLM/tutorial (github.com)

作业:tutorial/xtuner/self.md at main · InternLM/tutorial (github.com)

StreamlitAPIException: Failed to load the provided avatar value as an image

解决问题参考网站:【书生·浦语】大模型实战营——第四课作业-CSDN博客

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/595068

推荐阅读

相关标签