- 1景联文科技:用高质量数据采集标注赋能无人机技术,引领无人机迈入新纪元!

- 2AI赋能分层模式,解构未来,智领风潮

- 3huggingface-cli: command not found

- 4git基本操作命令整理。

- 5KAN网络技术最全解析—最热KAN能否干掉MLP和Transformer?(收录于GPT-4/ChatGPT技术与产业分析)

- 6实习记录小程序|基于SSM的实习记录小程序设计与实现(源码+数据库+文档)_实习日记生成器小程序

- 7spark 连接 mysql 出现 No suitable driver_no suitable driver spark

- 8MybatisPlus报错Error querying database. Cause: java.lang.IndexOutOfBoundsException: Index: 3, Size: 3_mybatisplus报错indexoutofbounds

- 9【通过EM算法实现GMM学习的3D可视化】三维数据的高斯混合模型的 3D 可视化研究(Matlab代码实现)_三维 高斯分布

- 10测绘院、国土局如何提升GIS系统数据的安全性?

创建第一个 Flink 项目_maven生成一个flink项目

赞

踩

一、运行环境介绍

Flink执行环境主要分为本地环境和集群环境,本地环境主要为了方便用户编写和调试代码使用,而集群环境则被用于正式环境中,可以借助Hadoop Yarn、k8s或Mesos等不同的资源管理器部署自己的应用。

环境依赖:

【1】JDK环境:Flink核心模块均使用 Java开发,所以运行环境需要依赖JDK,JDK版本需要保证在1.8以上。

【2】Maven编译环境:Flink的源代码目前仅支持通过 Maven进行编译,所以如果需要对源代码进行编译,或通过IDE开发Flink Application,则建议使用Maven作为项目工程编译方式。需要注意的是,Flink程序需要Maven的版本在3.0.4及以上,否则项目编译可能会出问题,建议用户根据要求进行环境的搭建。

【3】IDEA:需要安装scala插件以及scala环境等;

二、Flink项目 Scala版 DataSet 有界流

需求:同进文件文件中的单词出现的次数;

【1】创建Maven项目,pom.xml文件中配置如下依赖

<dependencies> <dependency> <groupId>org.apache.flink</groupId> <artifactId>flink-scala_2.12</artifactId> <version>1.10.0</version> </dependency> <!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-scala --> <dependency> <groupId>org.apache.flink</groupId> <artifactId>flink-streaming-scala_2.12</artifactId> <version>1.10.0</version> </dependency> </dependencies> <build> <plugins> <!-- 该插件用于将Scala代码编译成class文件 --> <plugin> <groupId>net.alchim31.maven</groupId> <artifactId>scala-maven-plugin</artifactId> <version>3.4.6</version> <executions> <execution> <goals> <!--声明绑定到 maven 的compile阶段--> <goal>compile</goal> </goals> </execution> </executions> </plugin> <plugin> <groupId>org.apache.maven.plugins</groupId> <artifactId>maven-assembly-plugin</artifactId> <version>3.0.0</version> <configuration> <descriptorRefs> <descriptorRef>jar-with-dependencies</descriptorRef> </descriptorRefs> </configuration> <executions> <execution> <id>make-assembly</id> <phase>package</phase> <goals> <goal>single</goal> </goals> </execution> </executions> </plugin> </plugins> </build>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

【2】resource目录中添加需要进行统计的文件文件及内容

![[点击并拖拽以移动] ](https://img-blog.csdnimg.cn/direct/09086c7451de40f09ffd4829860cadbc.png)

【3】WordCount.java文件内容如下,需要注意隐私转换问题,需要引入scala._

import org.apache.flink.api.scala._ /** * @Description 批处理 word count * @Author zhengzhaoxiang * @Date 2020/7/12 18:55 * @Param * @Return */ object WordCount { def main(args: Array[String]): Unit = { //创建一个批处理的执行环境 val env: ExecutionEnvironment = ExecutionEnvironment.getExecutionEnvironment //从文件中读取数据 var inputDateSet: DataSet[String] = env.readTextFile("E:\\Project\\flink\\src\\main\\resources\\wordcount.txt") //基于Dataset 做转换,首先按空格打散,然后按照 word作为key做group by val resultDataSet: DataSet[(String,Int)] = inputDateSet .flatMap(_.split(" "))//分词得到所有 word构成的数据集 .map((_,1))//_表示当前 word 转换成一个二元组(word,count) .groupBy(0)//以二元组中第一个元素作为key .sum(1) //1表示聚合二元组的第二个元素的值 //打印输出 resultDataSet.print() } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

【4】统计结果展示:

![[点击并拖拽以移动] ](https://img-blog.csdnimg.cn/direct/b4dcfbaac7de44cf94989a15d5306526.png)

三、Flink项目 Scala版 DataStream 无界流

【1】StreamWordCount.java文件内容如下

package com.zzx.flink import org.apache.flink.streaming.api.scala._ object StreamWordCount { def main(args: Array[String]): Unit = { // 创建一个流处理执行环境 val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment // 接受 socket 文本流 val inputDataStream: DataStream[String] = env.socketTextStream("hadoop1",6666); //定义转换操作 word count val resultDataStream: DataStream[(String,Int)] = inputDataStream .flatMap(_.split(" "))//以空格分词,得到所有的 word .filter(_.nonEmpty) .map((_,1))//转换成 word count 二元组 .keyBy(0)//按照第一个元素分组 .sum(1)//按照第二个元素求和 resultDataStream.print() //上面的只是定义了处理流程,同时定义一个名称。不会让任务结束 env.execute("stream word count word") } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

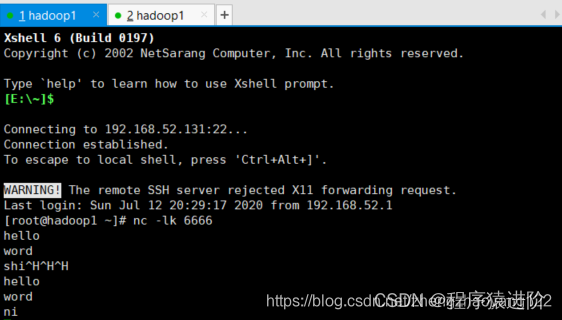

【2】我这里在Hadoop1中通过nc -lk xxx打开一个socket通信

【3】查看IDEA输出统计内容如下:输出word的顺序不是按照输入的顺序,是因为它有并行度(多线程)是并行执行的。最前面的数字是并行子任务的编号类似线程号。最大的数字其实跟你cpu核数是息息相关的。这个并行度也可以通过env.setParallelism进行设置。我们也可以给每一个任务(算子)设置不同的并行度;

![[点击并拖拽以移动] ](https://img-blog.csdnimg.cn/direct/6c86b06b344f4f74aff28fd65946cc9a.png)

【4】当我们需要将Java文件打包上传到Flink的时候,这里的host和port可以从参数中进行获取,代码修改如下:

package com.zzx.flink import org.apache.flink.api.java.utils.ParameterTool import org.apache.flink.streaming.api.scala._ object StreamWordCount { def main(args: Array[String]): Unit = { // 创建一个流处理执行环境 val env: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment // 接受 socket 文本流 hostname:prot 从程序运行参数中读取 val params: ParameterTool = ParameterTool.fromArgs(args); val hostname: String = params.get("host"); val port: Int = params.getInt("port"); val inputDataStream: DataStream[String] = env.socketTextStream(hostname,port); //定义转换操作 word count val resultDataStream: DataStream[(String,Int)] = inputDataStream .flatMap(_.split(" "))//以空格分词,得到所有的 word .filter(_.nonEmpty) .map((_,1))//转换成 word count 二元组 .keyBy(0)//按照第一个元素分组 .sum(1)//按照第二个元素求和 resultDataStream.print() //上面的只是定义了处理流程,同时定义一个名称。不会让任务结束 env.execute("stream word count word") } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28