- 1基于机器学习预测未来的二氧化碳排放量(随机森林和XGBoost)_机器学习预测碳排放模型

- 2探索spaCy:高效自然语言处理库的深度解析

- 3Android期末大作业漫画阅读app系统(Androidstudio,小白必看)_android开发一个漫画app

- 4Stable Diffusion:从入门到精通_stable-diffusion 将内存作为显存使用

- 5MSP430 DM430-A开发板学习笔记(三)测速模块(计数传对射感器)的使用_msp430 编码器测速

- 6brew安装指定版本mysql,使用 Homebrew 安装指定版本的软件

- 7AICC AI Infra技术创新圆桌 共话大模型时代的掘金利器_ai infra是什么

- 8人工智能到底是什么?人工智能如何改变社会?中国的人工智能应该做怎样的探索?_你认为人工智能在中国的发展中扮演什么角色?人工智能会改变我们在中国的生活吗

- 92020-11-02 联想 Yoga Duet IML 2020

- 10执行git merge origin/master命令出现命界面退出_git merge时跳出的窗口

推荐 6 个 火火火火 的开源项目_比较火的开源项目有哪些

赞

踩

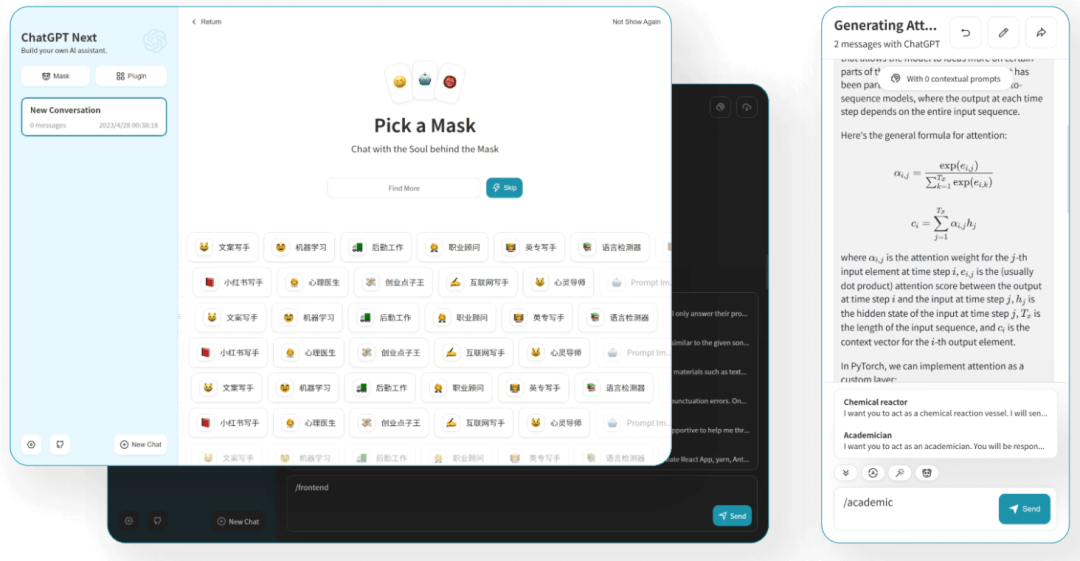

一、ChatGPT 网页应用

这是个非常好用的开源项目ChatGPT-Next-Web,这个开源项目可以做到一键免费部署你的私人ChatGPT网页应用,不用翻墙就能使用,是跨平台 ChatGPT UI(Web / PWA / Linux / Win / MacOS)。可一键拥有您自己的跨平台ChatGPT应用。主要有如下特点:只需在 1 分钟内即可在 Vercel 上一键免费部署,Linux/Windows/MacOS 上的紧凑型客户端 (~5MB);与自部署llms完全兼容,推荐与RWKV-Runner或LocalAI配合使用;三是所有数据都存储在浏览器本地;四是Markdown支持:LaTex、mermaid、代码高亮等。五是响应式设计、深色模式和 PWA首屏加载速度快(~100kb),六是自动压缩聊天历史记录以支持长时间对话,同时保存您的令牌;七是支持英语、简体中文、繁体中文、日本语、法语、西班牙语、意大利语、土耳其语、德语、Tiếng Việt、Русский、Čeština、한국어、印度尼西亚。

开源地址:https://github.com/AprilNEA/ChatGPT-Admin-Web

二、AI 换脸

DeepFaceLive 应用程序中还有一个 Face Animator 模块。可以使用视频或相机中您自己的脸部来控制静态脸部图片。如果图片质量不是最好的,需要对每对面孔进行精细的面部匹配和调整参数,但足以满足你的需求了。

功能:换脸,可以使用经过训练的面部模型交换网络摄像头中的面部或视频中的面部。以下这些人并不存在。与真人的相似是偶然的。

系统要求:一是支持任何 DirectX12 兼容显卡,(推荐 RTX 2070+ / Radeon RX 5700 XT+),二是具有 AVX 指令的现代 CPU 4GB RAM,32GB+;操作系统:Windows 10

开源地址:https://github.com/iperov/DeepFaceLive

三、API 调用 Midjourney进行 AI 画图

通过代理 MidJourney 的 Discord 频道,实现 api 形式调用AI绘图。但前提是你要注册 Midjourney 账号、并在 Discord 创建在自己的频道和机器人,然后就可以根据这个项目的指引一步步去使用 Api 调用 Midjourney 。

主要功能:支持想象指令和相关动作;想象一下时支持添加图片base64,作为垫图;支持Blend(图片混合)、Describe(图生文)指令;支持任务实时文档;支持中文提示翻译,需配置百度翻译或gpt;及时敏感词预检,支持覆盖调整user-token连接wss,可以获取错误信息和完整功能;支持多账号配置,每个账号可设置对应的任务队列。使用前提:注册并订阅 MidJourney,创建自己的服务器和频道,参考https://docs.midjourney.com/docs/quick-start,获取用户Token、服务器ID、频道ID。

开源地址:https://github.com/novicezk/midjourney-proxy

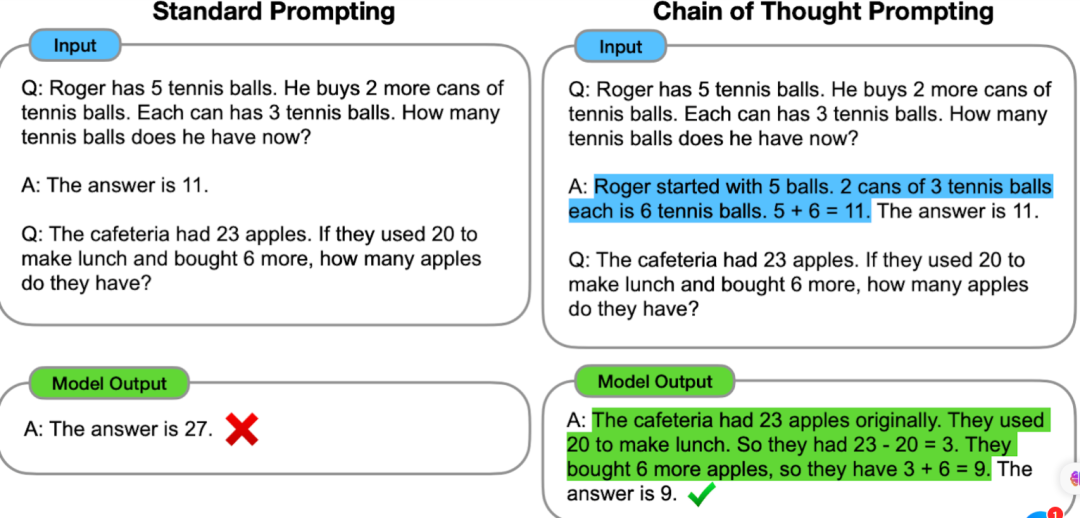

四、如何使用 Open AI 的 API

Open AI-Cook Book 是一本 Open AI 的 API 使用指南,提供了一些通过 Open AI 的 API 搭建任务的示例代码。使用OpenAI API完成常见任务的示例代码和指南。要运行这些示例,您需要一个 OpenAI 帐户和关联的 API 密钥(在此处创建一个免费帐户)。大多数代码示例都是用 Python 编写的,尽管这些概念可以应用于任何语言。

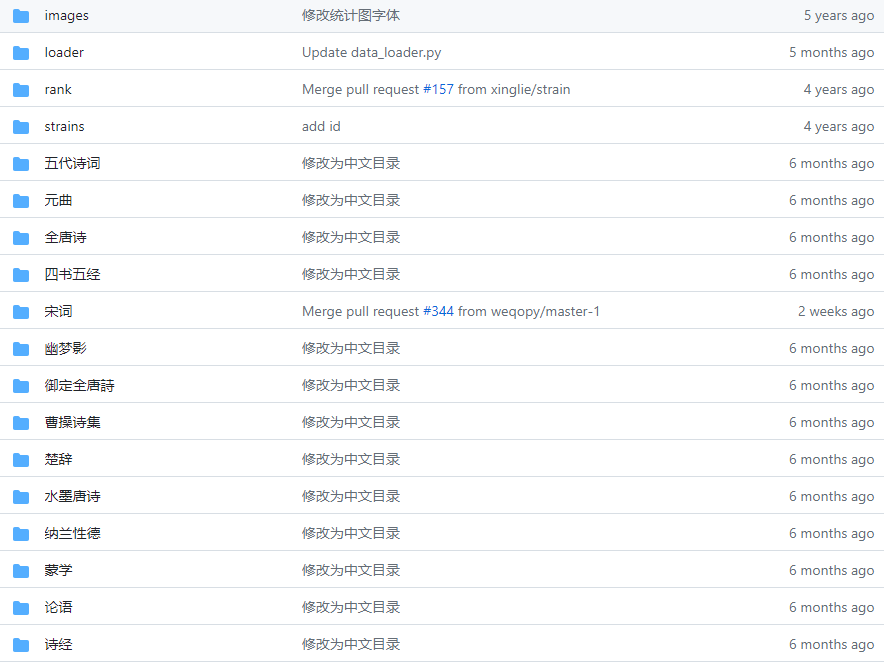

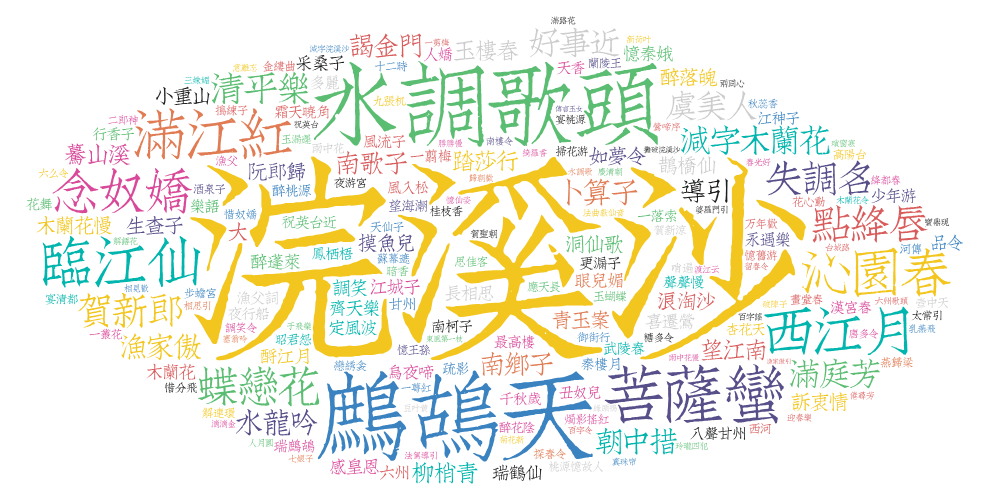

五、中华古诗词数据库

这是最全的中华古典文集数据库,包含 5.5 万首唐诗、26 万首宋诗、2.1 万首宋词和其他古典文集。诗人包括唐宋两朝近 1.4 万古诗人,和两宋时期 1.5 千古词人。数据来源于互联网。

为什么要做这个仓库? 古诗是中华民族乃至全世界的瑰宝,我们应该传承下去,虽然有古典文集,但大多数人并没有拥有这些书籍。从某种意义上来说,这些庞大的文集离我们是有一定距离的。而电子版方便拷贝,所以此开源数据库诞生了。此数据库通过 JSON 格式分发,可以让你很方便的开始你的项目。

开源地址:https://github.com/chinese-poetry/chinese-poetry

六、动画编程

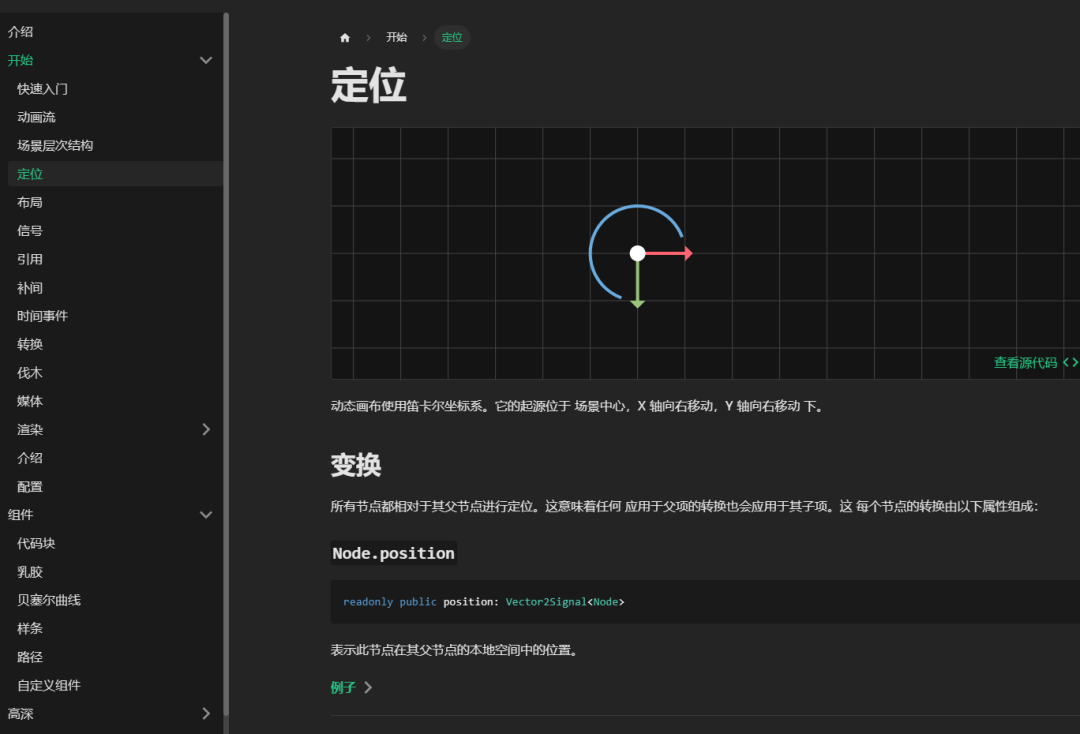

Motion Canvas 是一个 TypeScript 库,可以通过编程的方式生成动画,并提供所述动画的实时预览的编辑器。并且有详细的文档说明

文档地址:https://motioncanvas.io/docs/

开源地址:https://github.com/motion-canvas/motion-canvas

扫码关注