- 1ubuntu下使用cmake编译opencv4.8.0+ffmpeg4.2.2+cuda11.1_opencv ffmpeg版本

- 2小红书API接口封装 | 按搜索关键词采集笔记_婵小红api接口

- 3如何使用Docker本地部署Traefik并实现公网访问内网服务_traefik部署

- 4NLP深入学习:大模型背后的Transformer模型究竟是什么?(一)_大模型词嵌入和隐藏层

- 5C++|哈希结构封装unordered_set和unordered_map

- 6机器学习:朴素贝叶斯算法学习及案例实现_贝叶斯模型的应用案例

- 7最新绿豆APP源码苹果CMS影视插件版本/原生JAVA源码+反编译开源+免授权_绿豆源码

- 8金仓数据库 KDTS 迁移工具使用指南 (6. 注意事项)_kindbase kdts

- 9一分钟上手AI神器——Kimi (附_ 官方提示词)_kimi ai介绍

- 10AI自然语言处理NLP原理与Python实战:深度学习模型的选择_python nlp深度学习模型

深度测评:SD3模型表现如何?实用教程助你玩转Stable Diffusion 3 ,最强SD3模型使用攻略,附ComfyUI实操SD3模型到底如何?StableDiffusion3全面评测!_sd3模型有什么区别

赞

踩

深度测评:SD3模型表现如何?实用教程助你玩转Stable Diffusion 3 ,最强SD3模型使用攻略,附ComfyUI实操

SD3模型到底如何?StableDiffusion3全面评测!如何使用ComfyUI遍历题词 | 模型?

大家好,我是猫头虎。今天我要给大家带来一篇关于Stable Diffusion 3 (SD3) 模型的全面评测和使用指南。作为刚刚开源的最新一代模型,SD3在架构、性能和功能上都有了显著的提升。本期内容不仅会详细解析SD3的各项改进,还会教大家如何通过ComfyUI进行高效的批处理操作和提示词测试。无论你是AI绘画的新手还是老手,相信这篇文章都能给你带来实用的指导和灵感。话不多说,我们马上开始吧!

本文大纲

- SD第三代模型介绍

- SD3与之前架构的不同

- 基于SDXL的训练

- TVE解码部分的增强

- 提示理解的完善

- 三种Clip编码的采用

- 模型后缀的含义和特性

- SD3与之前架构的不同

- Config UI的批处理操作

- 工作流的介绍

- 基础工作流

- 提词强化工作流

- 传统放大工作流

- 动态提示词插件的使用

- 批量生成图像的方法

- 工作流的介绍

- 模型和资源的获取

- 访问LibLib网站获取模型和资源

- 下载和使用题词卡片

- 服务器配置和文件管理

- 模型比较和测试

- 不同模型的生成效果比较

- 提示词的调整和优化

- 在线生成与本地生成的对比

关键词

- SD第三代模型

- Config UI

- 批处理操作

- Clip编码

- 动态提示词插件

- 模型比较

- 在线生成

适合阅读人群

- 对AI模型和图像生成技术感兴趣的技术人员

- 需要使用或了解SD第三代模型的研究人员

- 对Config UI和批处理操作有需求的设计师和开发者

- 希望了解最新AI技术和资源获取方法的用户

术语解释

- SD3: SD第三代模型,基于SDXL进行训练,增强了TVE解码部分,改善了对提示的理解和元素融合能力。

- Config UI: 配置用户界面,用于管理和操作批处理工作流。

- Clip编码: 一种编码技术,SD3采用了三种Clip编码,增加了文本编码器,训练数据量更大。

- 动态提示词插件: 一种插件,可以在Manager中搜索“Dynamic”,安装后可以在新建节点处显示动态提示词,使用通配符文件进行随机调用。

- LibLib: 一个资源网站,提供模型和资源下载,支持在线生成。

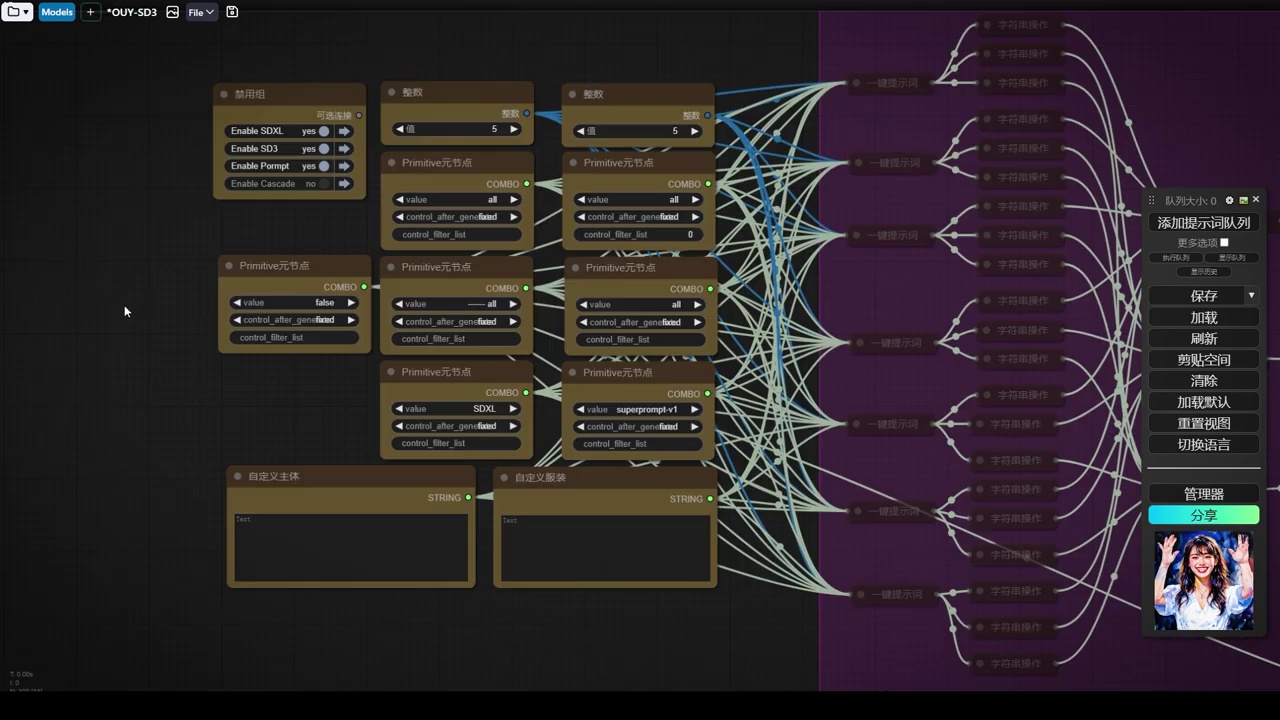

本期我们将探讨刚刚开源的SD第三代模型。此外,我们还会介绍一些config UI的批处理操作,以配合我们的提示词测试该模型。话不多说,我们直接进入SD官网。

- SD3架构基于SDXL训练,增强了TVE解码部分,通道数增至16。

- SD3改善了提示理解和元素融合,能更精确控制画面。

- 新一代模型采用三种Clip编码,增加了一个文本编码器,训练数据量达到2B参数。

- TUGIFACE官网提供不同后缀的模型,无后缀模型不含Clip编码,带Clip标识的包含基础Clip编码,T5XXL新增第三种Clip编码。

- 模型精度有FP16和8位,大参数模型提供FP16,体积达15G,官方模型至少需12G显存。

- Text Encoders部分需额外加载Clip模型,国内用户需下载并加载这些模型。

首先,我们要介绍的是SD3,它与之前的架构有何不同?SD3的架构基于SDXL进行训练。首先,我们可以看到TVE解码部分得到了大幅增强,现在通道数为16。其次,它对提示的理解及元素融合更为完善。简而言之,我们可以通过提示更精确地控制画面的某些部分。这一新一代模型采用了三种Clip编码。在SDXL中,我们有两个编码器,一个是L,一个是G。而这一代模型在此基础上增加了一个文本编码器,使得训练数据量更大,达到2B,相当于20E的参数,远超之前的SDXL。

现在,我们访问TUGIFACE官网,对于新手来说,可能不清楚应使用哪些模型。通过观察后缀,我们可以分辨出模型的特性。首先,无后缀的模型不包含Clip编码。其次,带有Clip标识的版本包含基础的Clip编码,即I和L,相当于XL模型。再往下,第三代模型T5XXL新增了第三种Clip编码模型。这里有两种精度:FP16和8位。通常,未经采样的模型精度为32位,采样后为FP16。对于大参数模型,仅提供FP16半精度,大小达到15G。此外,还提供8位精度,即半精度的半,更小。官方发布的模型体积较大,要求较高,至少需要12G显存,尽管官方称8G也可运行,但需配置虚拟内存。

在这四个模型中,Text Encoders部分会提供额外的Clip模型。如果加载的模型不包含Clip,则需下载并加载额外的Clip模型。下面两个模型同样如此,只需选择一个精度,如16位或8位,加上G和L,即构成三个Clip模型。对于国内用户,需下载并加载这些模型。

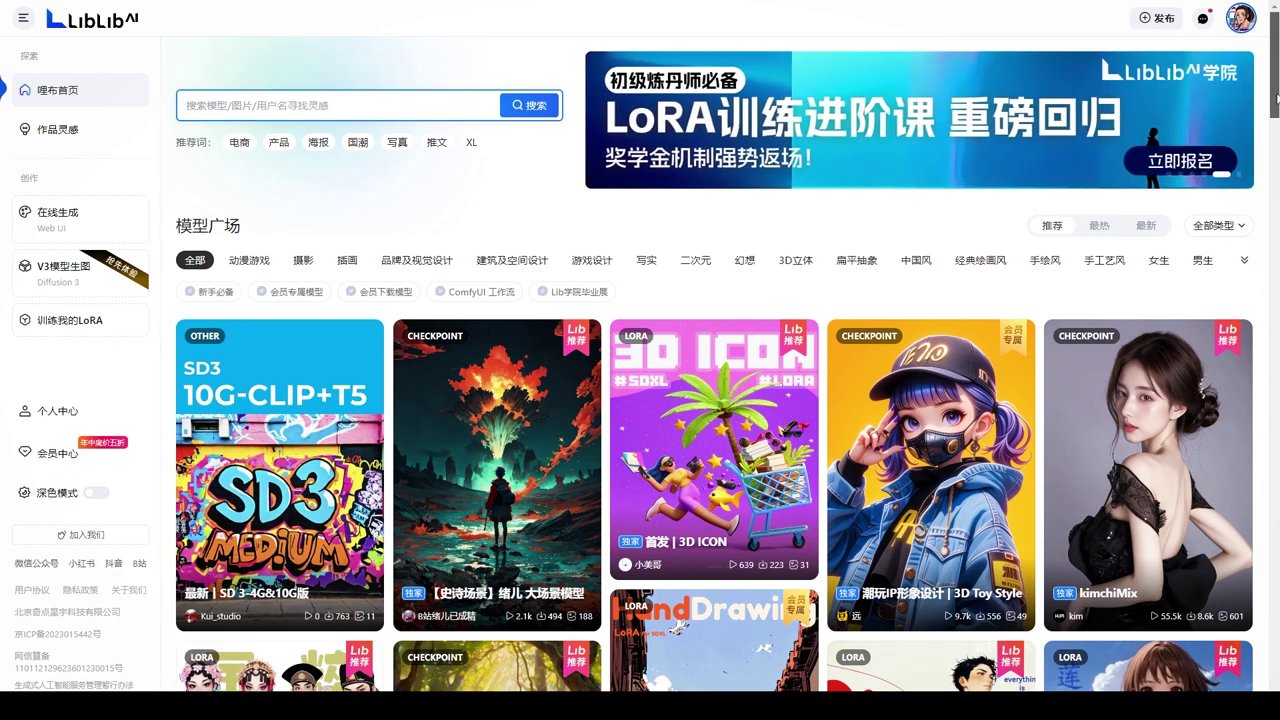

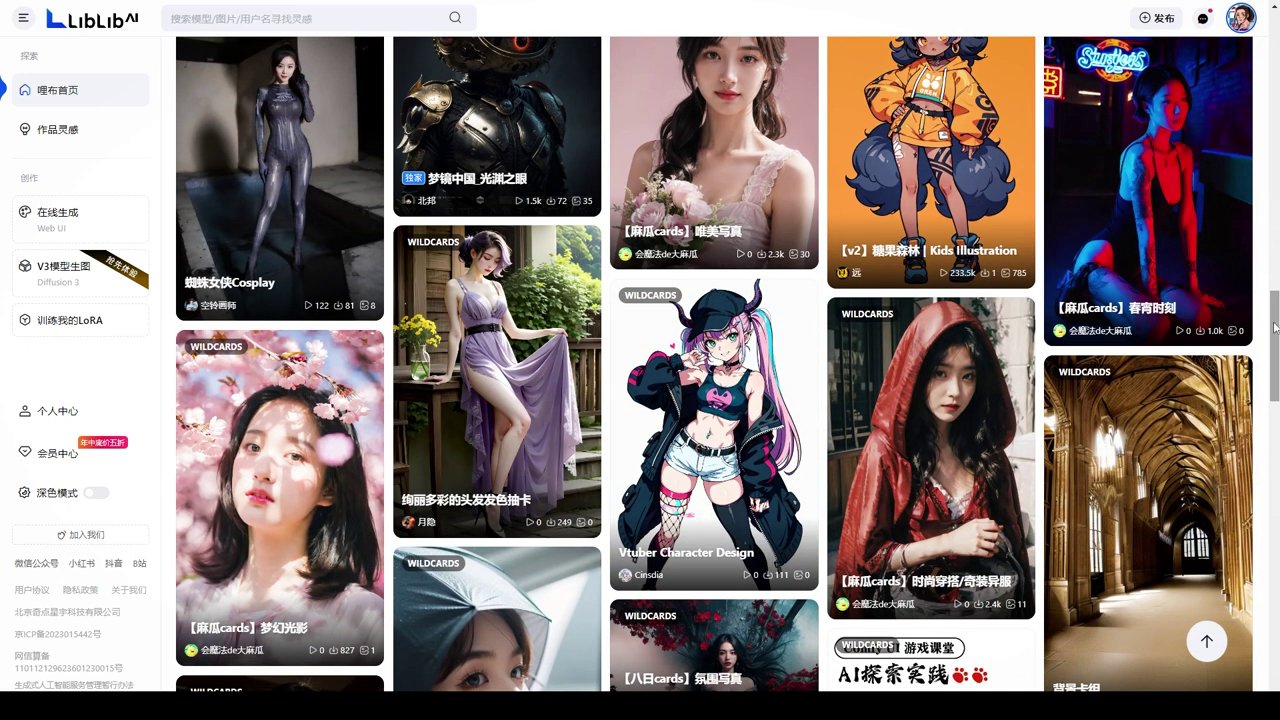

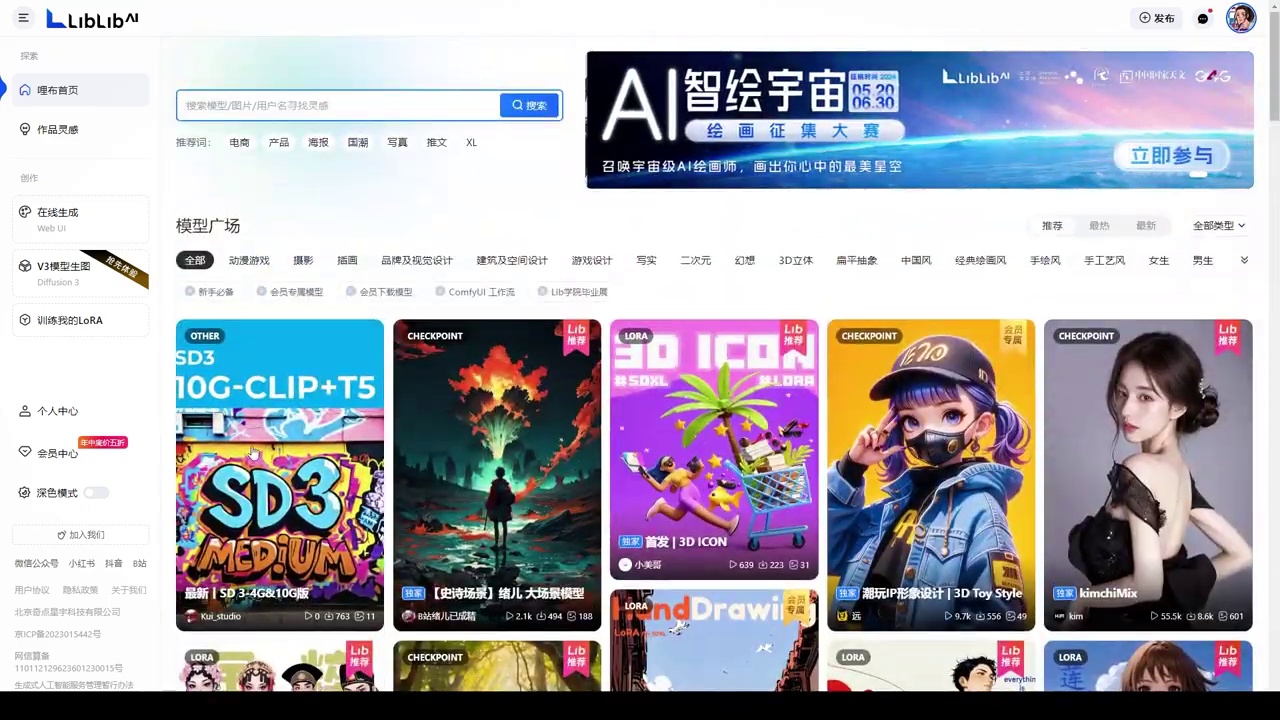

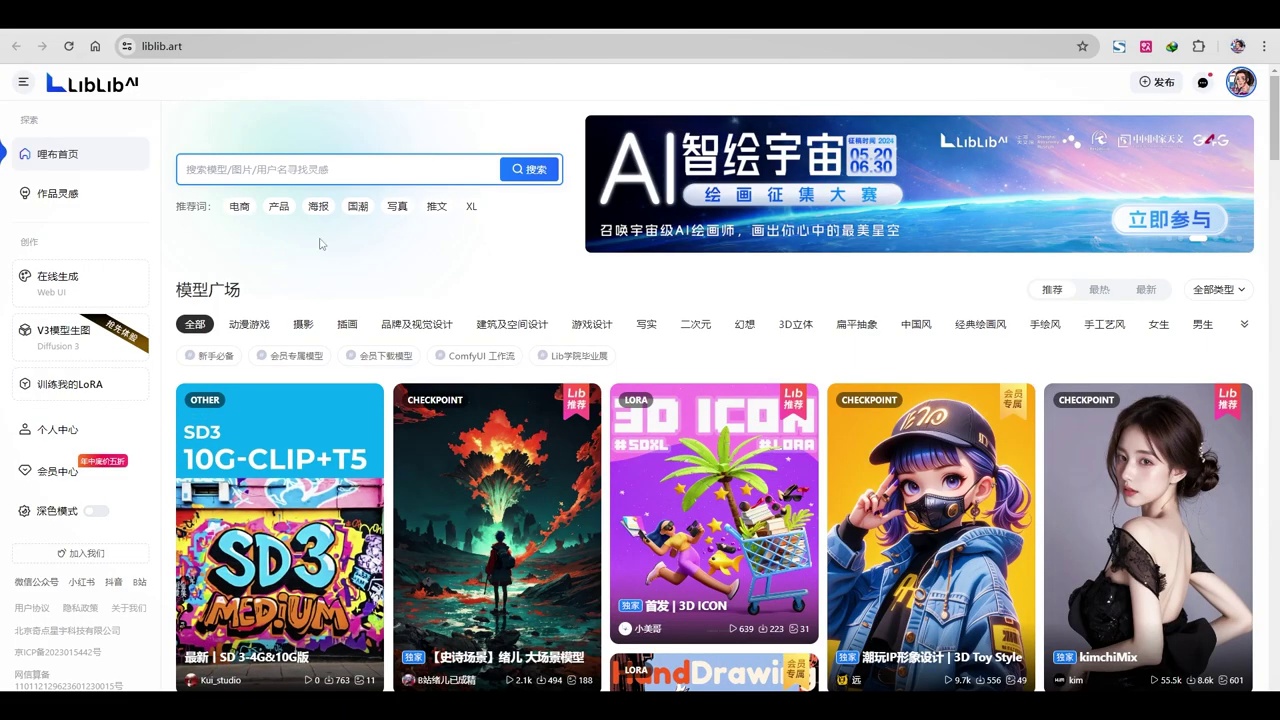

最佳访问的资源网站是LibLib。在之前讲解Stable Diffusion时,我曾提及此网站。目前,LibLibAI是国内较为完善的绘画模型资源网站,不仅提供常用模型,还可在其平台上查看相关内容。

平时都有一些激励活动,所以说有很多原创作者在这个地方玩游戏。

这些模型在CVT网站上不一定能找到,同时一些热门的模型也不一定能找到。

最重要的是,对于不熟悉网络配置的朋友们来说,这个功能非常便捷,可以直接访问,使用起来十分方便。

- SD3模型是目前排名第一的模型,已在其网站上架。

- SD3模型包含三个编码器,无需单独加载Clip编码模型。

- 王智能的信息将在视频简介下方提供。

- LibreView网站支持V3模型生成,其在线生成速度与4090相当。

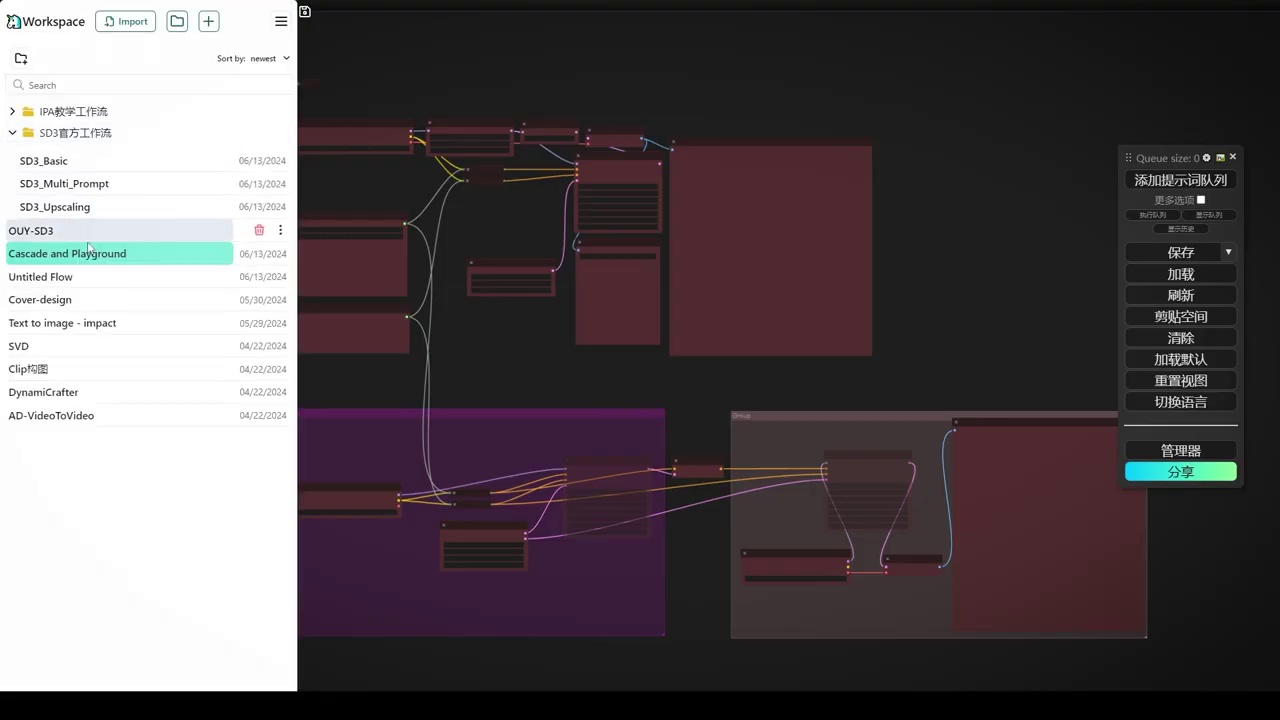

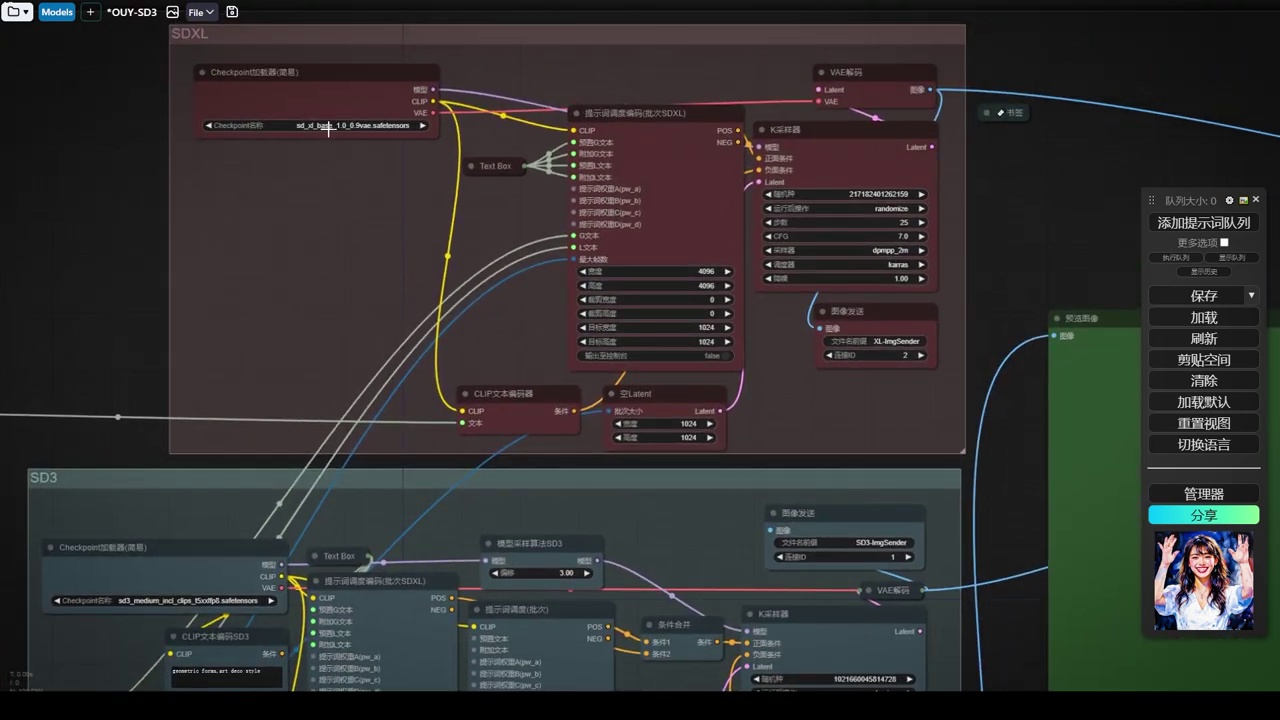

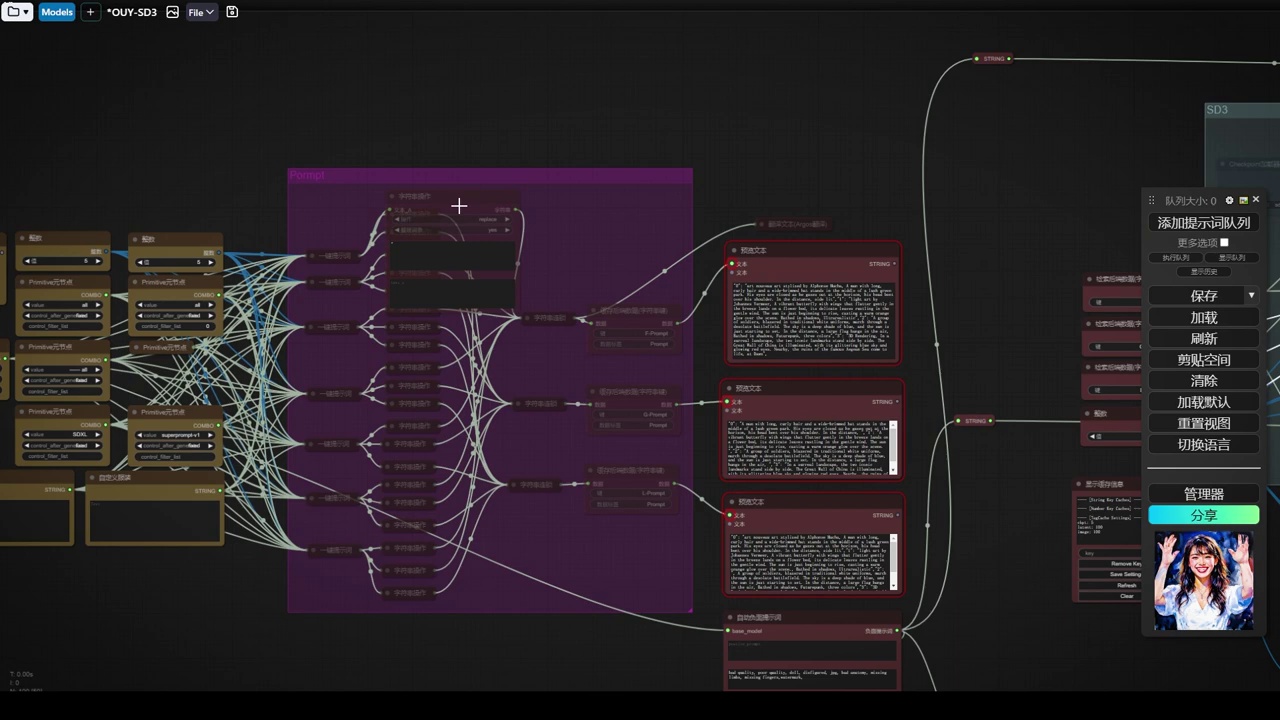

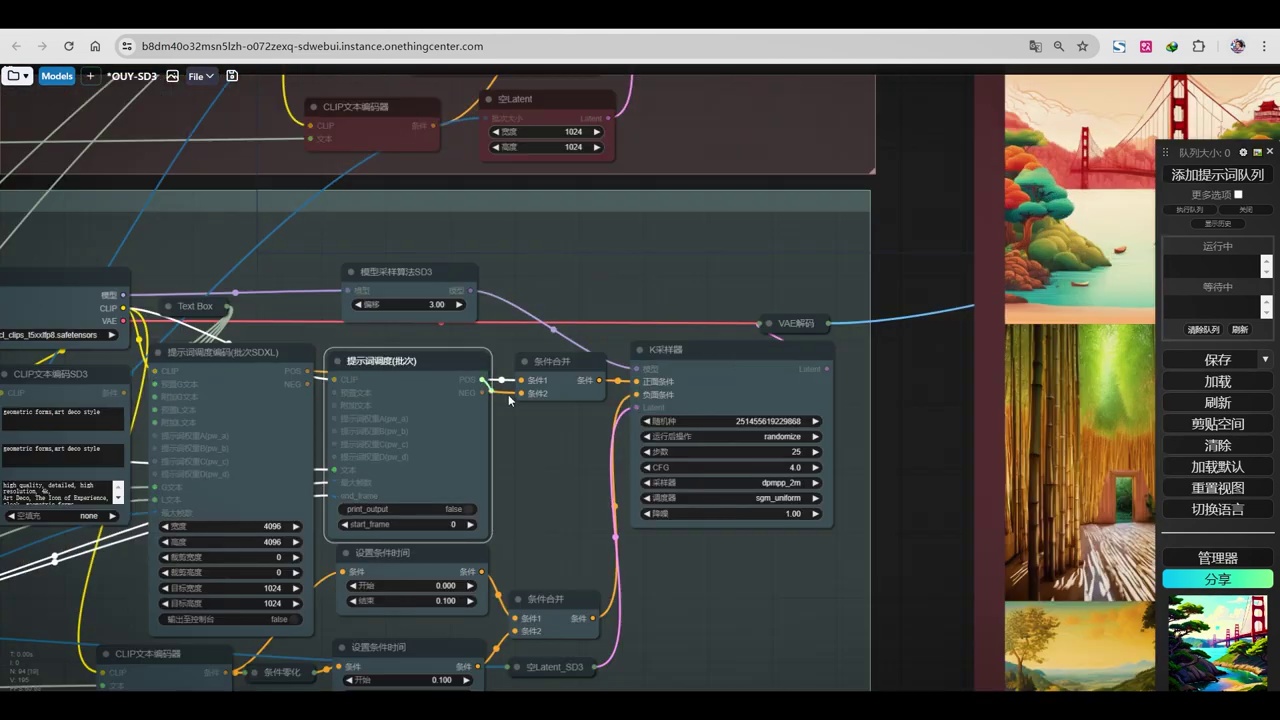

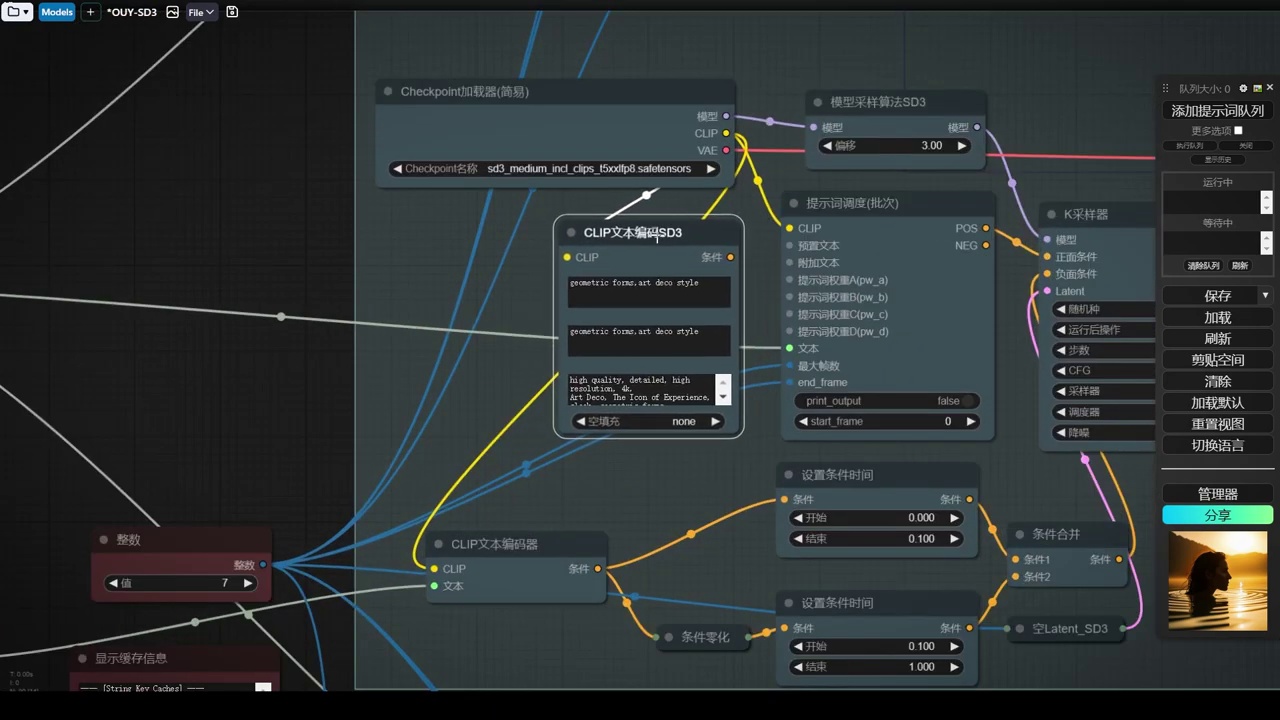

- Huggenface提供的Config UI样本工作流包括Basic基础工作流、Prompt强化工作流和传统放大工作流(Upscale)。

速度非常顺畅。目前排名第一的是SD3模型,该模型已在其网站上架。这是一个实际版本,包含三个编码器,无需单独加载Clip编码模型。王智能的信息将放在视频简介下方。LibreView网站支持V3模型生成,其在线生成速度与4090相当,推测使用了大算力提供前端实时生成模式。Huggenface提供了一个Config UI样本工作流,包括Basic基础工作流、Prompt强化工作流和传统放大工作流(Upscale)。这些工作流相对简单。

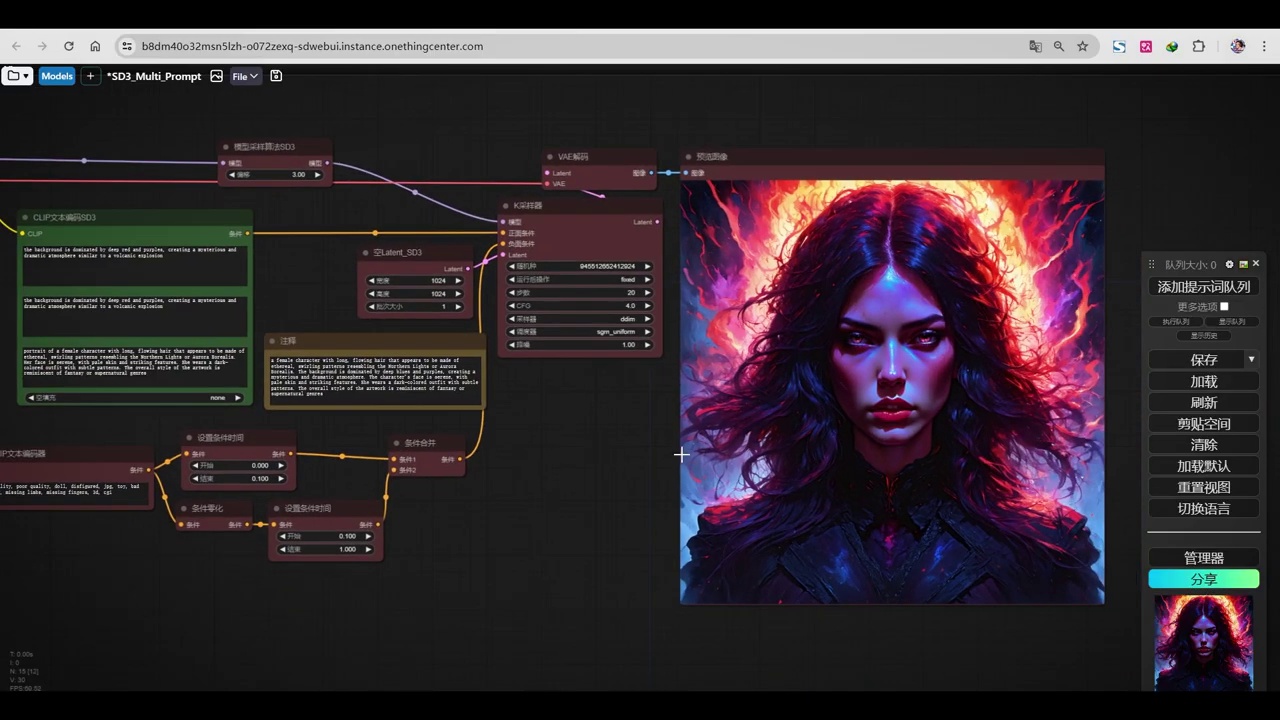

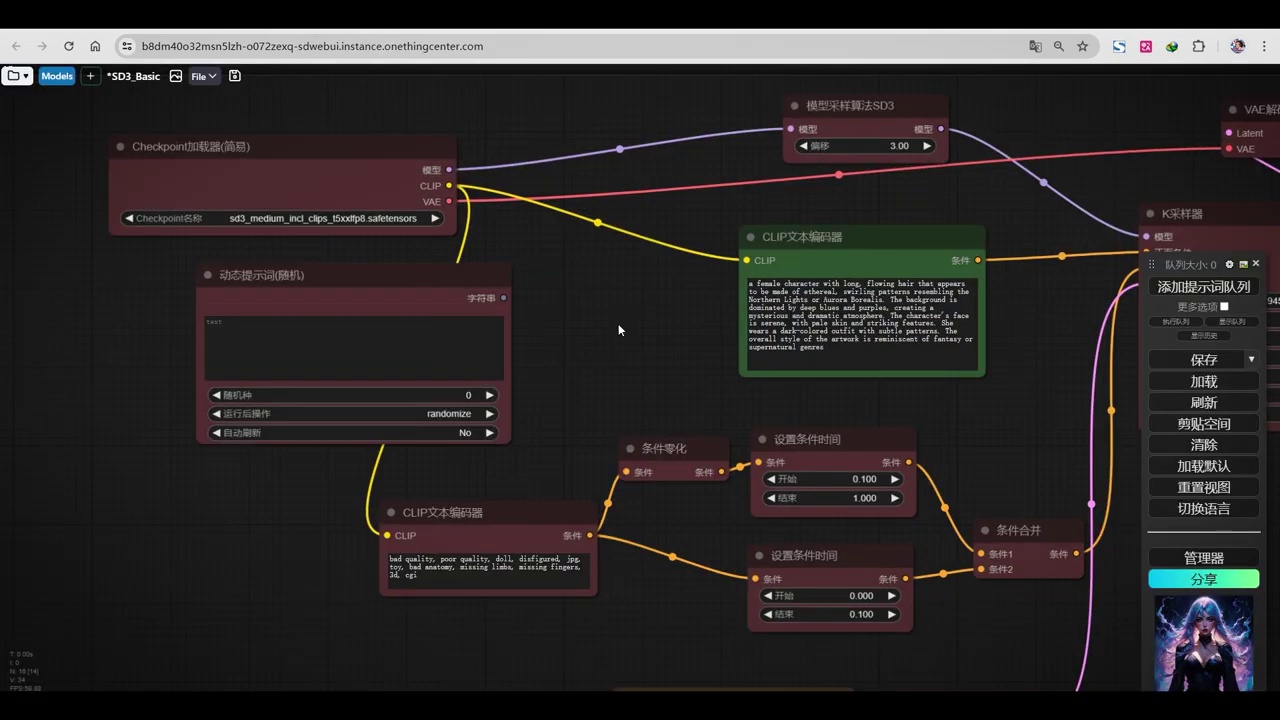

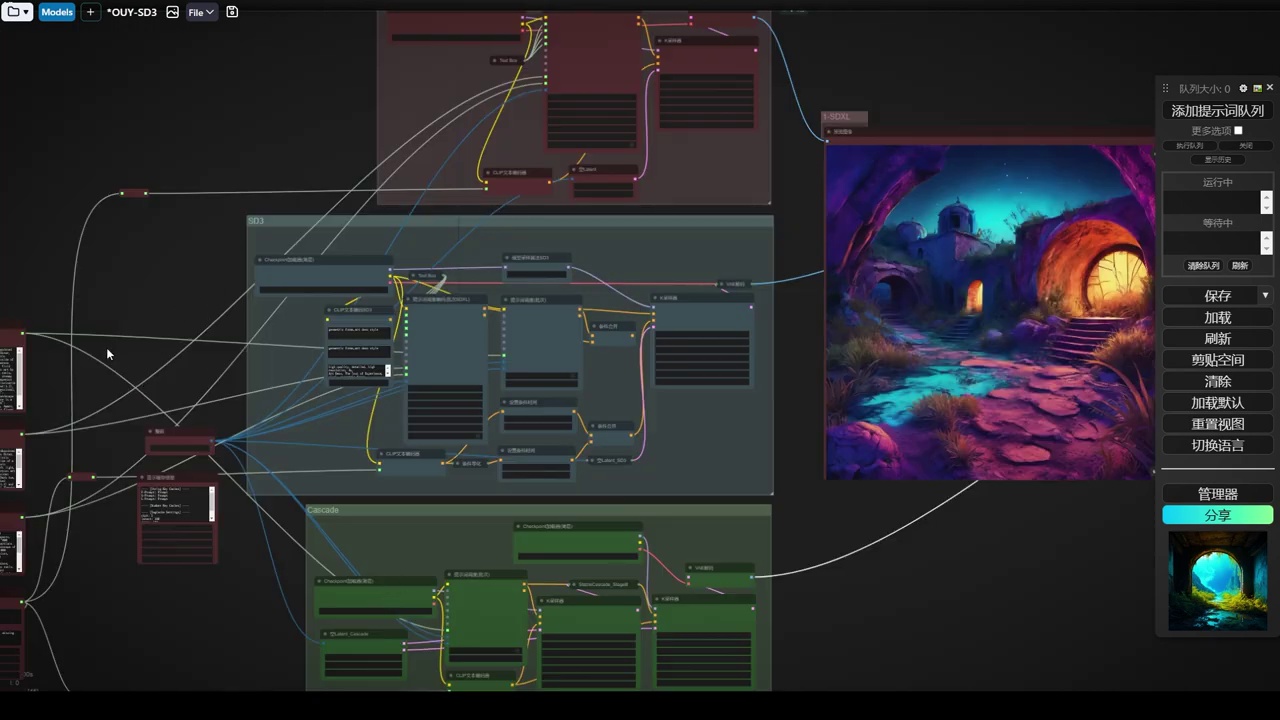

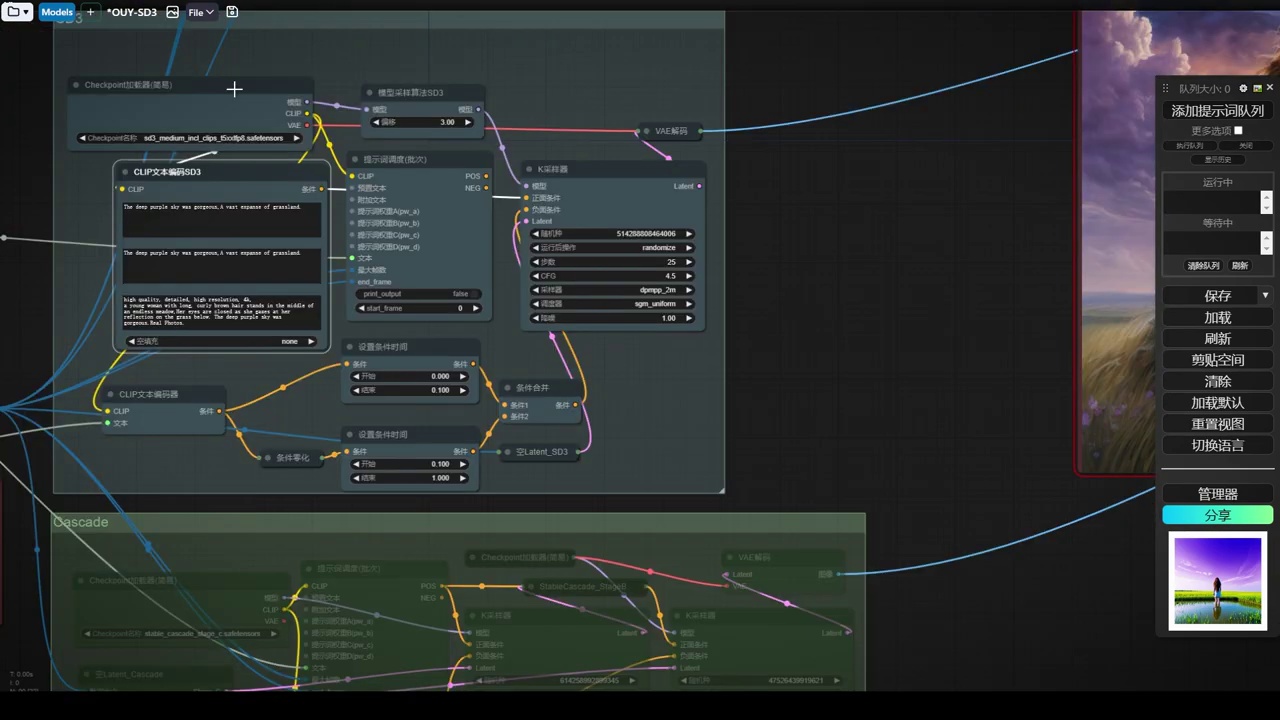

现在直接来到服务器。在服务器这边,我们来直接打开这个工作流。我已经等待半天了。

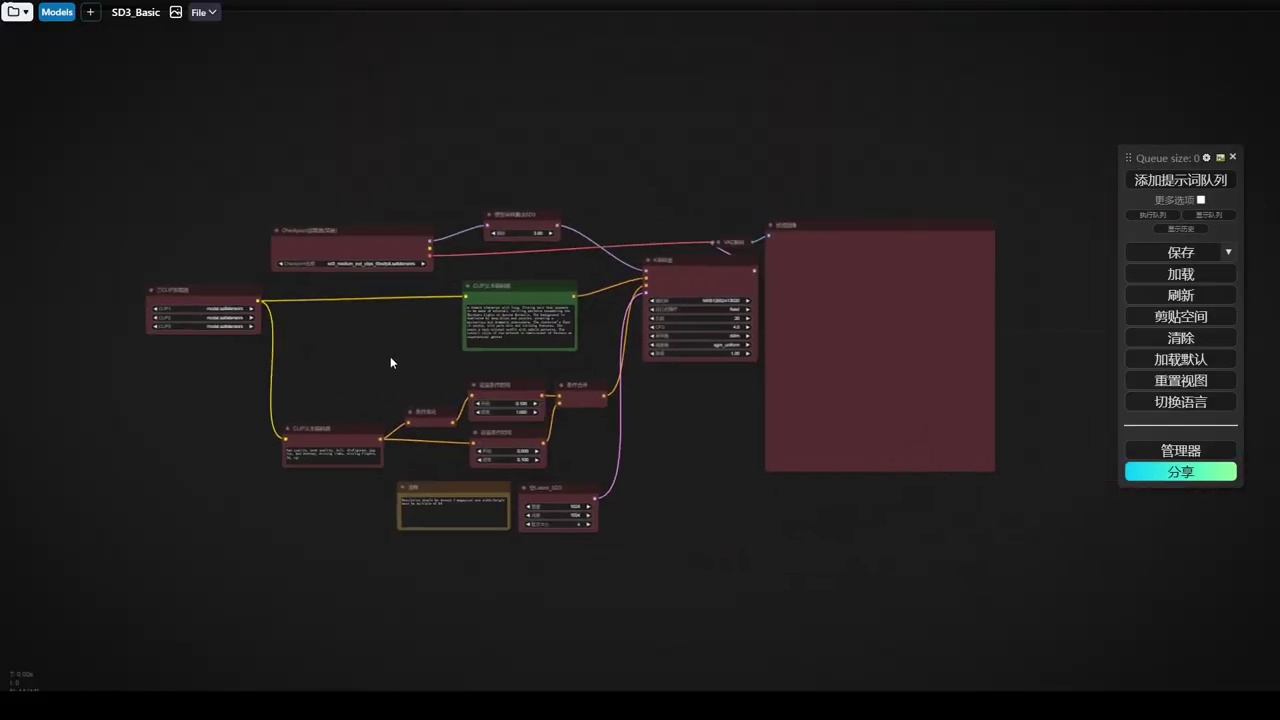

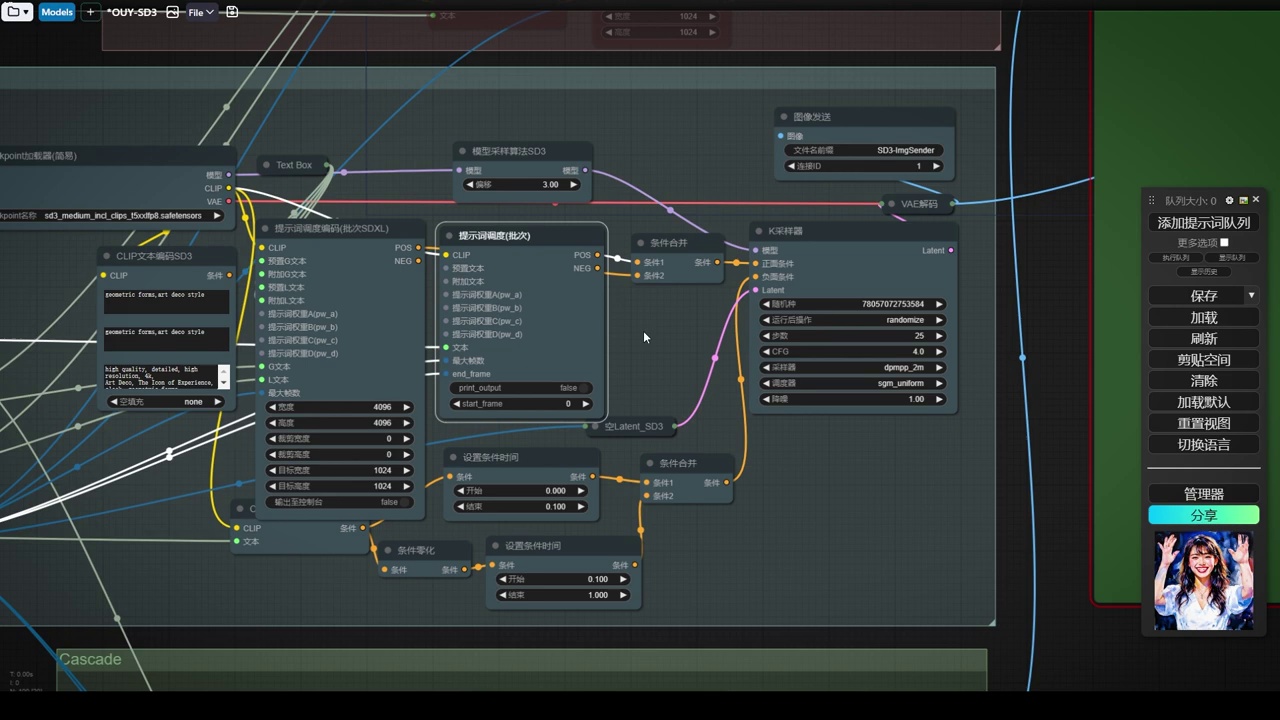

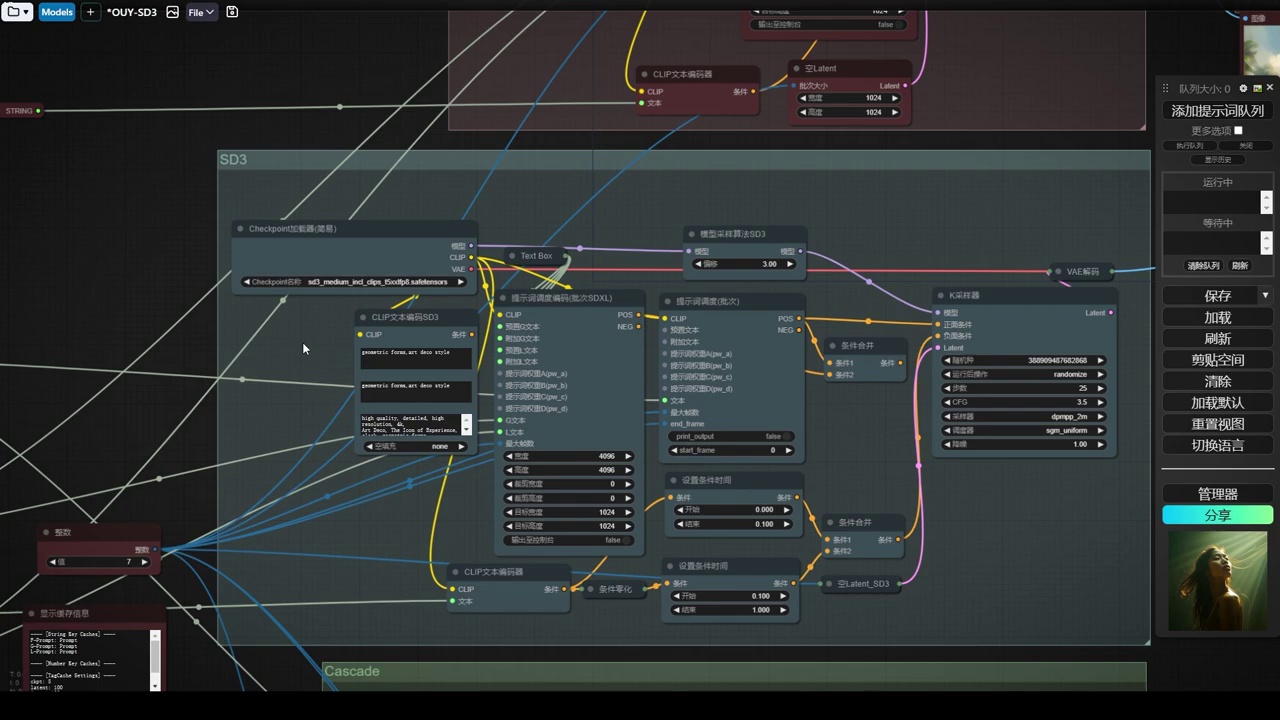

- 工作流中涉及三个Clip模型(Clip-L、Clip-G和T5的Clip)的单独加载,用于正向和负向文本编码器。

- 负面处理机制包括两条处理路径,一条无提词(条件归零),另一条有提词和强度设置,通过Combine合并,实现线性过渡效果,其中90%的时间无提词作用。

- SD3模型采样算法和模型管道处理算法,包括离散、连续和Cascade算法,以及CFG缩放等微调,用于优化模型性能。

- 使用官方提示词和模型参数(如采样器28部,CFG4.5)生成图像,模型已包含三个Clip模型,无需单独加载。

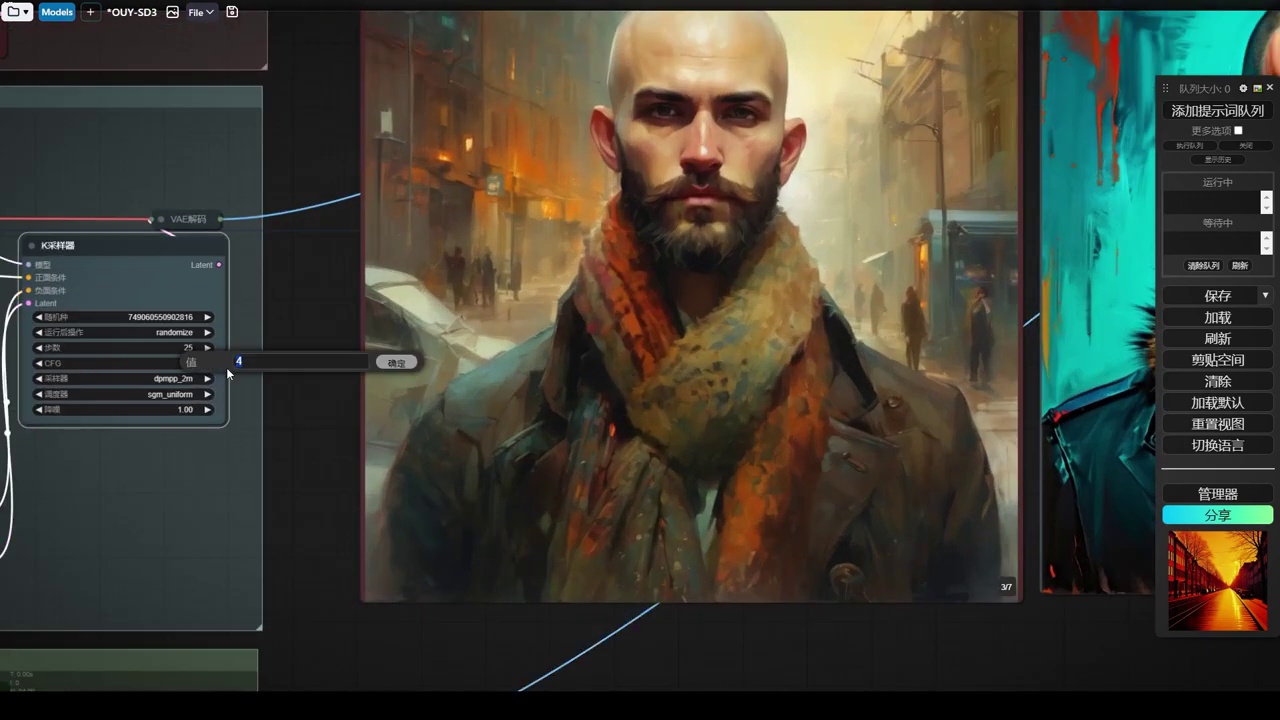

首先,我们来看一下这个最基础的工作流。在这里,我们简单分析一下。首先,我们可以看到官方提供的这边有一个单独加载的Clip,可以看到三个Clip加载器,模型中没有Clip。这种情况适用于我们所下载的是一个4G的,它没有打包任何的Clip模型。这时,我们需要下载三个Clip模型,如Clip-L、Clip-G和T5的Clip。将这三个模型加载下来,单独将Clip传给正向和负向两个文本编码器。这里只是单独加载模型,这是其一。其二,最有趣的是它的负面处理。我们可以看到负面这里有一堆东西。首先,它在负面这里分了两条线,最后用了一个Combine合并。上面这条是条件归零,即整个负面走了这条,它是没有任何提词的,相当于空的,因为它归零了。之后是一个时间设置。我们对比这两个时间设置,上面这条路线没有强度,相当于空提词,而下面这条路线有强度,有提词。之后在这两个强度上做了一个融合,其实是一个线性过渡,但由于Config UI没有Clip的线性过渡,我们可以看到没有强度的,相当于空提词。没有强度的开始时间从0.1到1结束,即90%的时间没有提词作用。只有前面的10%有提词效果,所以我们可以理解它将负面完全降低了。前面的10%有提词,后面就没有提词了,相当于做了一个缓出的效果。这个权重是一个缓出,特别厉害,即前面10%有作用,后面不想让提词发挥作用。因此,我们可以理解它的负面强度很高,它是要把强度降下来。我猜测因为三个Clip模型的加持,它对提词的理解过于强悍,所以这些操作不想让负面体现得太突出。因此,把负面强度降得很弱,只要有一点点就可以。这是第二点,它的负面处理。第三点,我们还可以看到SD3的模型采样算法。模型管道处理算法,不管我们在之前接触LCM也好,或者是Pelegram也好,都可以在模型管道做一些算法的优化,并不是特别主要。现在我们来看一下在高级里面找到模型。这里我们可以看到之前所有的离散算法、连续算法以及Cascade算法。这个连续就是我们之前Pelegram用的。下面SD3以及CFG缩放。这些都是一些微调,它不是说特别关键的一个组件,没有它就不能运行了。说到这里以后,我们就来用它官方的提示词来生成一下图像。当然要注意我们现在所加载的模型是实际的,里面包括了这3Clip模型。所以说我们Clip模型就不需要单独加载了,就可以直接从模型这里面来出了。给到正向,给到负向。我们来看一下这是它官方给到的采样器的参数,28部。所以说它的部数要求也不是特别高。然后CFG4.5明显可以感觉到它的风格性也特别强,我们CFG不能给特别高。同时也能感觉到它的编码强度也特别高,也就是因为它编码模型。那么再往下,采样器我们常用的2M。要注意的是这个调度器,它用的是SGM的,就和LCM的调度器类似。所以说它融合了一些这种精炼的东西,我感觉。这样的话我们先来直接来生成一下。

这一套题词的效果还是可以的,但是我感觉稍微有些油腻,这个脸上

- CFG值被略微降低。

- 尝试使用默认的OlerA进行测试,但效果不佳。

- 调度器的选择对结果有重要影响,当前使用的调度器效果最佳。

- 模型算法更改为默认模型,变化不大。

- 步数降低至25步,DDIM表现正常,而OlerA效果不佳。

- 为了提高速度,进一步降低步数测试,结果显示变化不大。

- 尝试不使用原先的负面条件进行测试。

反光特别高。接下来我们将进行一些调整。首先,我们将CFG值略微降低。之前尝试过DDIM,但发现常用的3M和DDPM效果不佳,均出现崩溃情况。这里我们尝试使用默认的OlerA进行测试。其次,调度器的选择也非常关键。之前尝试过其他调度器,但效果均不如当前使用的这个。接下来,我们将更改模型算法,使用默认模型,虽然变化不大。随后,我们将步数降低至25步,再次进行生成。结果显示,OlerA效果不佳,而DDIM则表现正常。DDIM是一种采样速度较快的算法。为了提高速度,我们可以进一步降低步数进行测试,结果显示变化不大。接下来,我们将尝试不使用原先的负面条件,直接进行测试。

- 当前效果不理想,细节展现不足,需注意负面模式。

- 探讨第二个工作流程——提词强化流程。

- 除文本编码外,其他组件相同,引入SD3文本编码。

- SD3文本编码包含Clip-L、Clip-G和T5三个独立Clip模型,各负责不同信息。

- 官方演示显示,新提词与之前相同,但效果有显著差异。

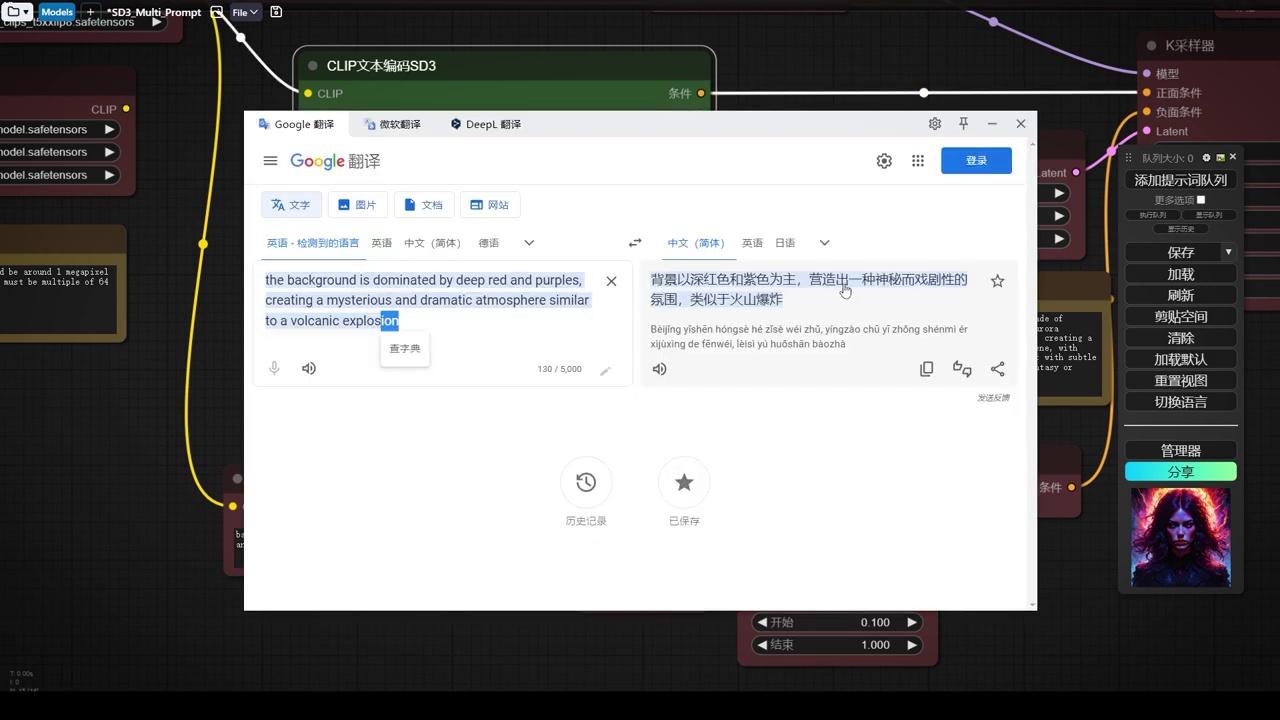

我们可以观察到,当前效果并不理想,细节未能充分展现,这是我们需要注意的第一点。我们必须按照其负面模式进行生成。接下来,我们将探讨第二个工作流程,即提词强化流程。通过比较可以发现,除文本编码外,其他组件均相同。这里特别引入了SD3文本编码,分别对应Clip-L、Clip-G和T5三个独立的Clip模型,它们各自负责不同的Clip信息。从官方演示中可以清晰理解,这一套提词与之前的提词相同,但效果存在显著差异,这是采用SD3方式生成的图像。现在,我们来进行对比分析,首先查看上文内容。

- Clip I和L主要提供背景色彩、整体氛围和背景形状或风格。

- T5 Clip描述了主体,即女性的肖像,包括她的神情、人物特点和艺术品的整体风格。

- 提到了基础案例的提示词。

大家可以看到,上面的Clip I和L提供的是氛围,包括背景色彩、整体氛围以及背景形状或风格。而最下面的T5 Clip则描述了主体,即女性的肖像,包括她的神情、人物特点以及艺术品的整体风格。此外,我们还了解到基础案例的提示词。

但是没有什么变化的吧。那么所产出的生成的这个效果呢?

这就是三种完全不同的CLIP模型的应用。

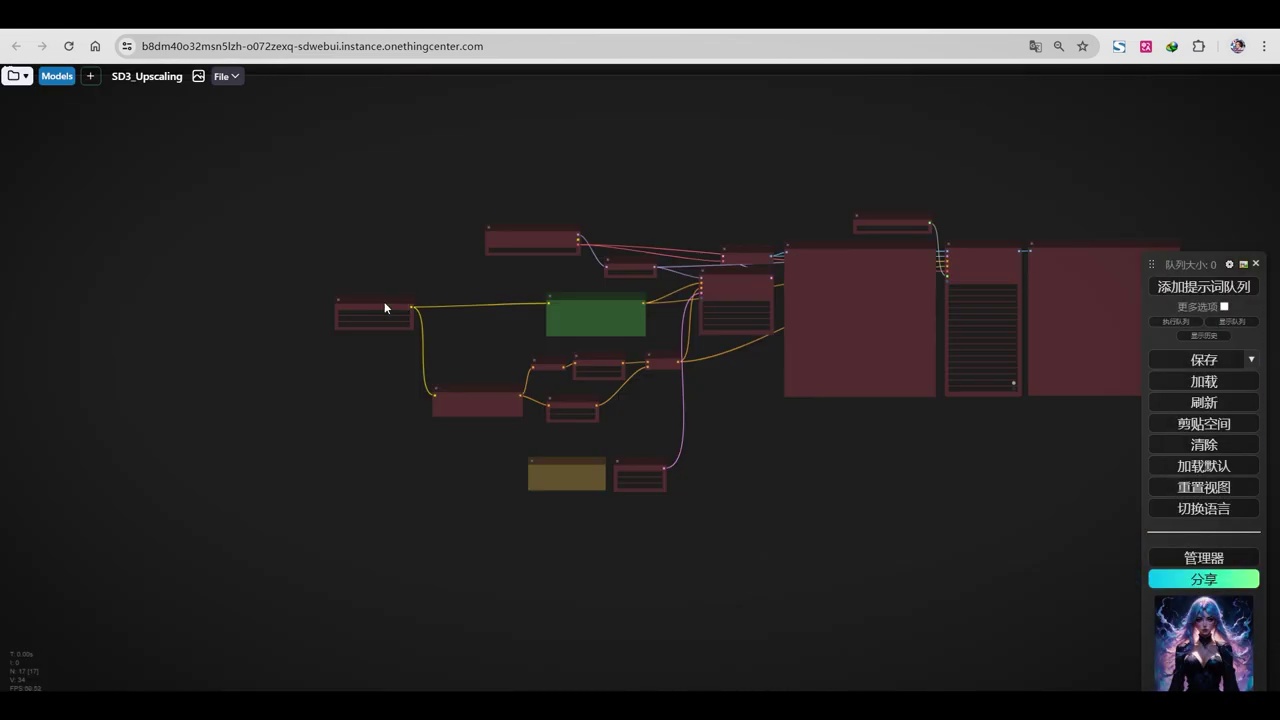

- 探讨了第三个工作流程,该流程主要涉及US放大和SD处理。

- 官方提供了三种不同的工作流。

- 由于SD开源时间短,节点进度未同步,无法使用独特方式遍历提示词。

- 目前只能使用单提示文本编码器进行图像测试。

- 讨论了遍历图像时的差异。

提示后,效果显著增强。接下来,我们探讨第三个工作流程,该流程并无特别之处。加载方式依旧简单,主要涉及后期放大。我们可以看到,流程中仅包含US放大,这便是其放大工作流。我认为此流程无需额外说明,仅涉及SD处理。至此,官方提供了三种不同工作流。随后,我们将进行简单测试。由于SD开源仅一天,部分节点进度尚未同步。我们无法使用独特方式遍历提示词,因此无法体现其特性。我们仅能使用单提示文本编码器进行图像测试。接下来,我们将简述如何遍历图像。首先,提及遍历,此处我们讨论的是差异。

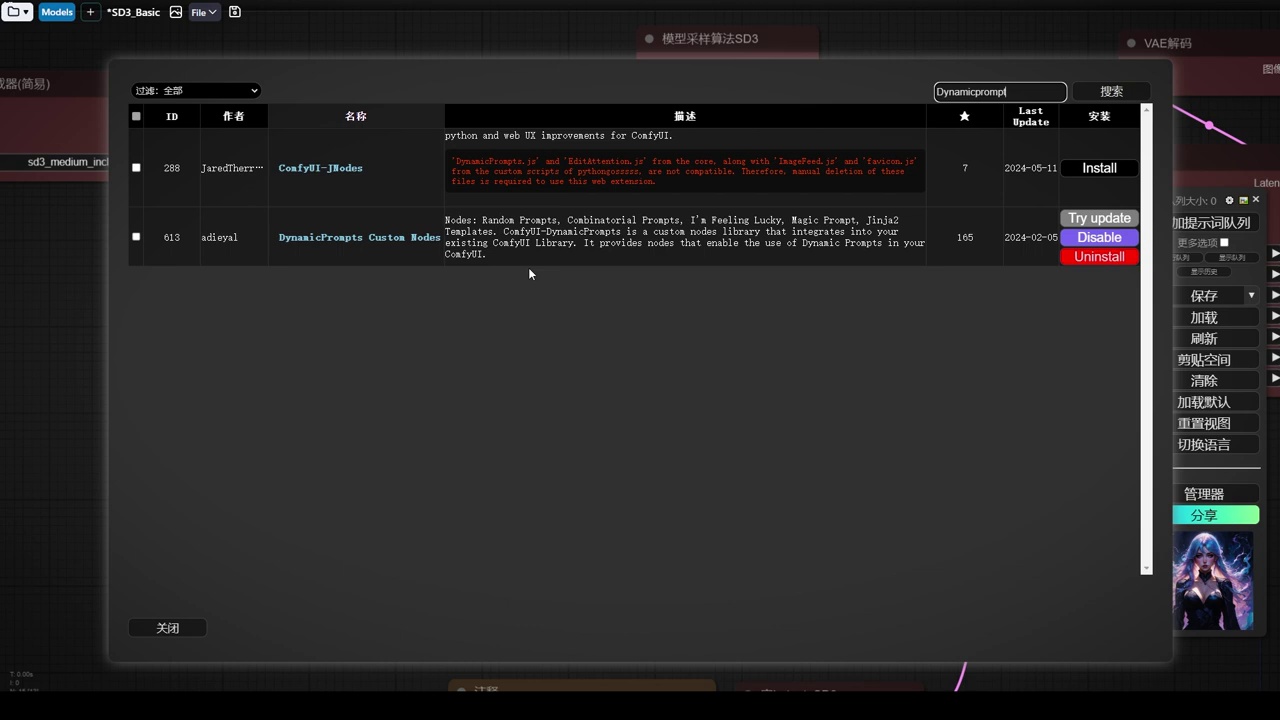

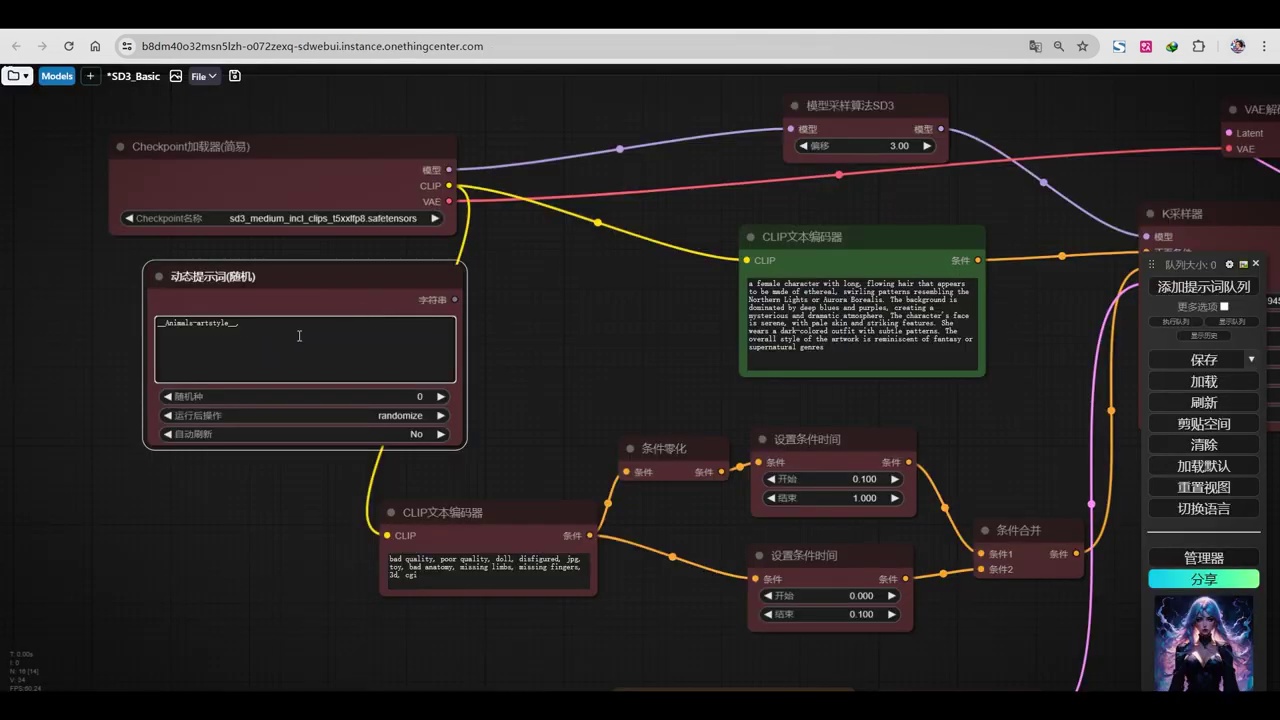

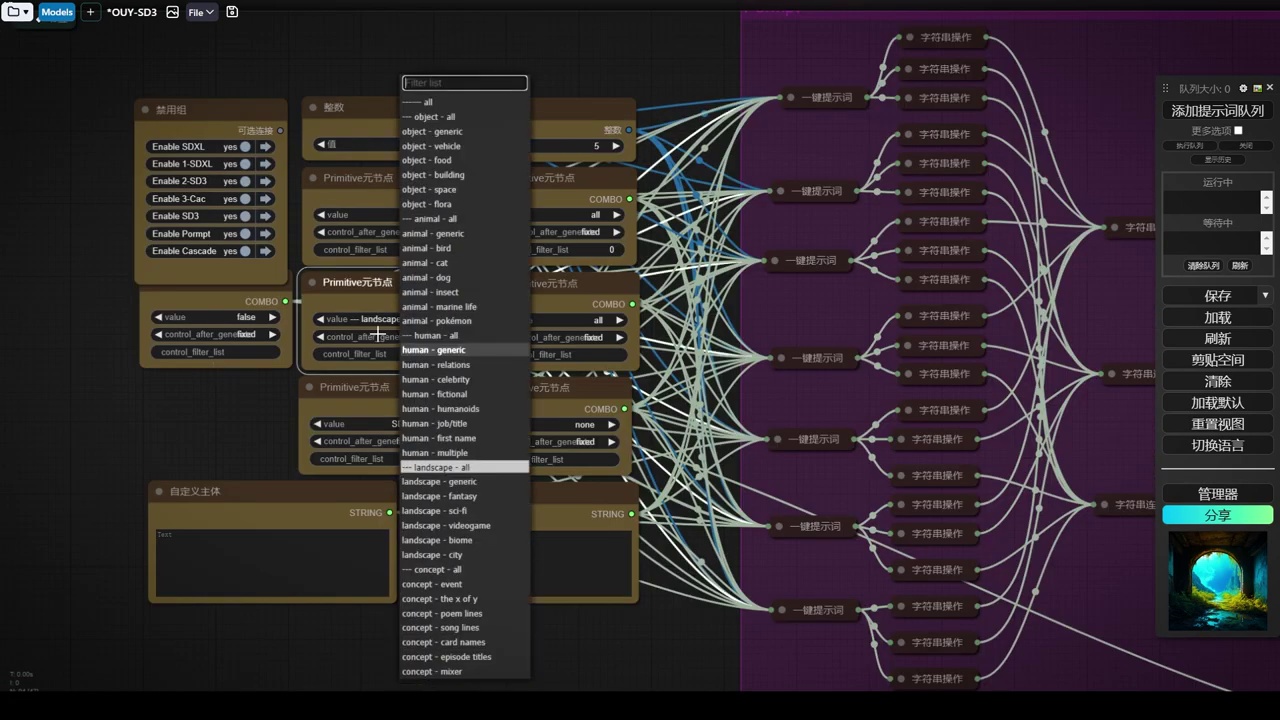

- 插件名为“Dynamic”,可在Manager中搜索安装。

- 该插件为题词插件,安装后新建节点显示动态提示词。

- 动态提示词节点是Program通配符的使用节点。

- 不使用此插件,可选择Inspire中的通配符。

- 文中提到将选择随机题词,以随机调用通配符文件。

插件即为这样一个插件,我们可在Manager中直接搜索“Dynamic”,它是一款便捷的题词插件。安装此插件后,新建节点处将显示动态提示词,该提示词节点实质上是Program通配符的使用节点。若不使用此插件,亦可选择Inspire中的通配符。接下来,我们将选择一个随机题词,以便随机调用通配符文件。

那么说到文档调用,我们还是要访问LibLib的网站,除了模型,我们还可以下载一些其他资源。

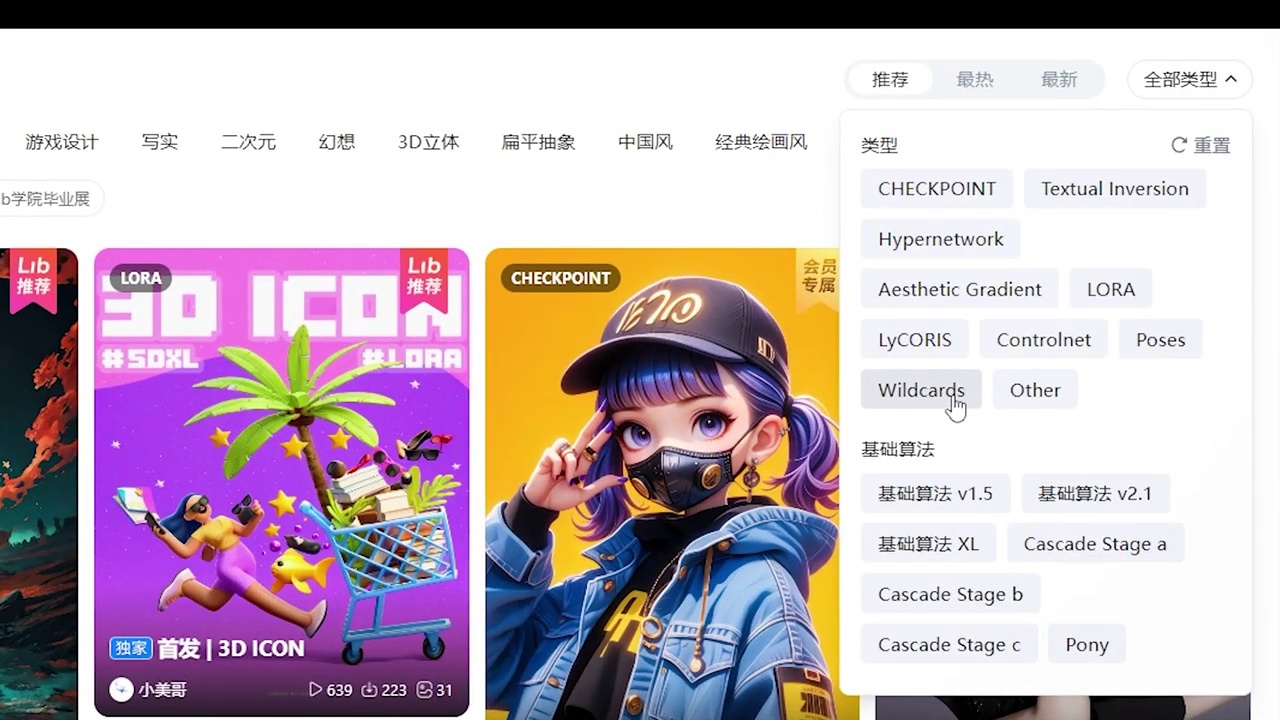

点击右侧,查看全部类型,您会注意到这里有一个Word Cards,即题词卡片。

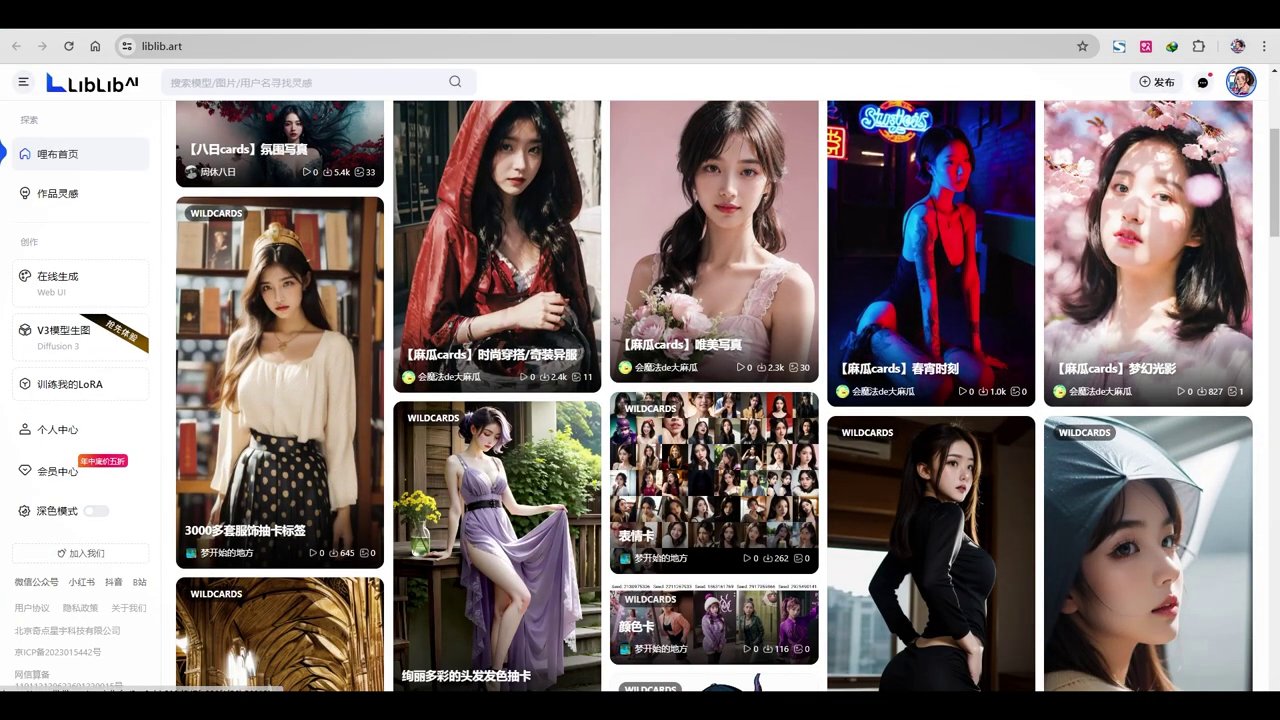

提斯卡吧是一个包含多种类型的平台,其中包括服装、人物、风格、场景以及视角等各类元素。

这里我下载了一些题词卡,解压后均为TXT文档。打开后,内容包括镜头、服装、各种职业服装、动物、人文景观及风格。我已上传部分至服务器,但未全部上传。

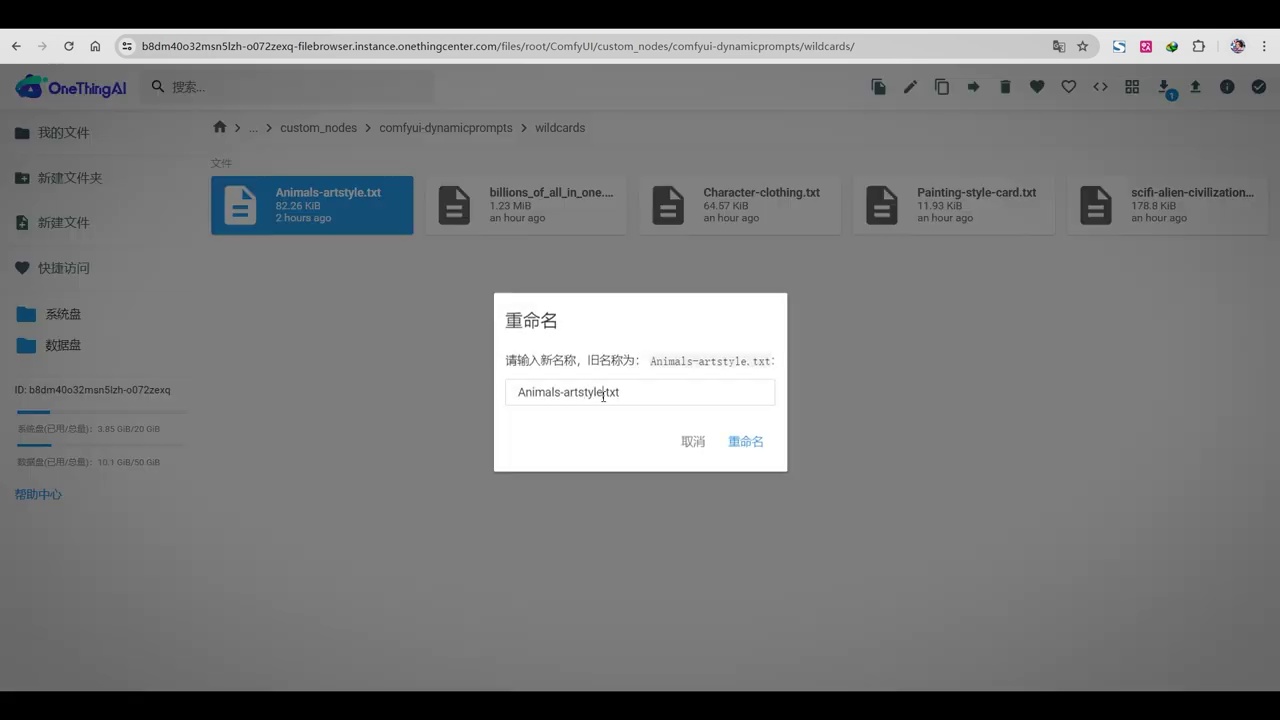

- 文件位置固定:服务器和本地在configurator目录下的文件位置是固定的。

- 自定义节点插件:在configurator下的custom_nodes文件夹中,存放了自定义节点插件。

- 安装的插件:dynamic_prompt是之前安装的插件,位于custom_nodes文件夹内。

- wildcards文件夹:在dynamic_prompt文件夹内,用于存放下载的txt文档。

- 文档内容:放入wildcards文件夹的txt文档包括动物、配置文件、角色服装、风格和场景,其中配置文件需要复杂指令。

之后,我们进入服务器的硬盘,在configurator目录下,无论是服务器还是本地,文件位置都是固定的。在configurator下,我们找到custom_nodes,即自定义节点插件文件夹,在其中找到之前安装的dynamic_prompt。在此文件夹内,我们可以看到wildcards文件夹,将我们刚才下载的txt文档放入其中。放入后,首先要注意它们的名称:第一个是动物(animals),第二个是配置文件,包含多种不同结构,需要复杂的指令,这是我测试时使用的;如果大家对此感兴趣,我们稍后再详细讨论。第二个是角色的服装,第三个是风格,第四个是场景,关于如何调用这些内容,我们将在后续进行说明。

接下来,我们将调用Config UI。首先,我们将测试一种风格,在此基础上,我们可以提供不同的动物或场景。随后,我们将涉及两个文档:第一个文档包含各种动物。

- 文件重命名并复制名称。

- 调用时切换至英文输入法。

- 使用Shift键和反斜杠键输入两个下划线。

- 粘贴文件名后再次输入两个下划线。

- 系统随机调用文档中的提示词。

- 需指定一种风格。

我们可以直接重命名该文件,复制其名称。在调用时,需切换至英文输入法,使用Shift键和反斜杠键,输入两个下划线,然后粘贴文件名,再次输入两个下划线。这样操作后,系统将随机调用文档中的任意一行提示词。接下来,我们还需指定一种风格。

- 复制风格卡的文件名。

- 使用特定的调用方式(两个下划线)嵌入文件名,结合动物与风格。

- 预览提示词,关闭采样器后运行程序。

- 屏幕显示动物描述及风格描述,风格描述紧跟在ART后。

- 提升文本变化器的输入,直接应用于文本变化器。

- 对负面提示进行简单修改。

同样,我们复制风格卡的文件名。返回后,使用相同的调用方式,即两个下划线,将文件名嵌入其中,再接两个下划线。这样,我们便结合了动物与风格。接着,预览提示词,关闭采样器后直接运行。此时,屏幕上显示出动物的描述及风格描述。ART后紧跟风格描述。随后,提升文本变化器的输入,直接应用于文本变化器。至于负面提示,稍作修改即可。

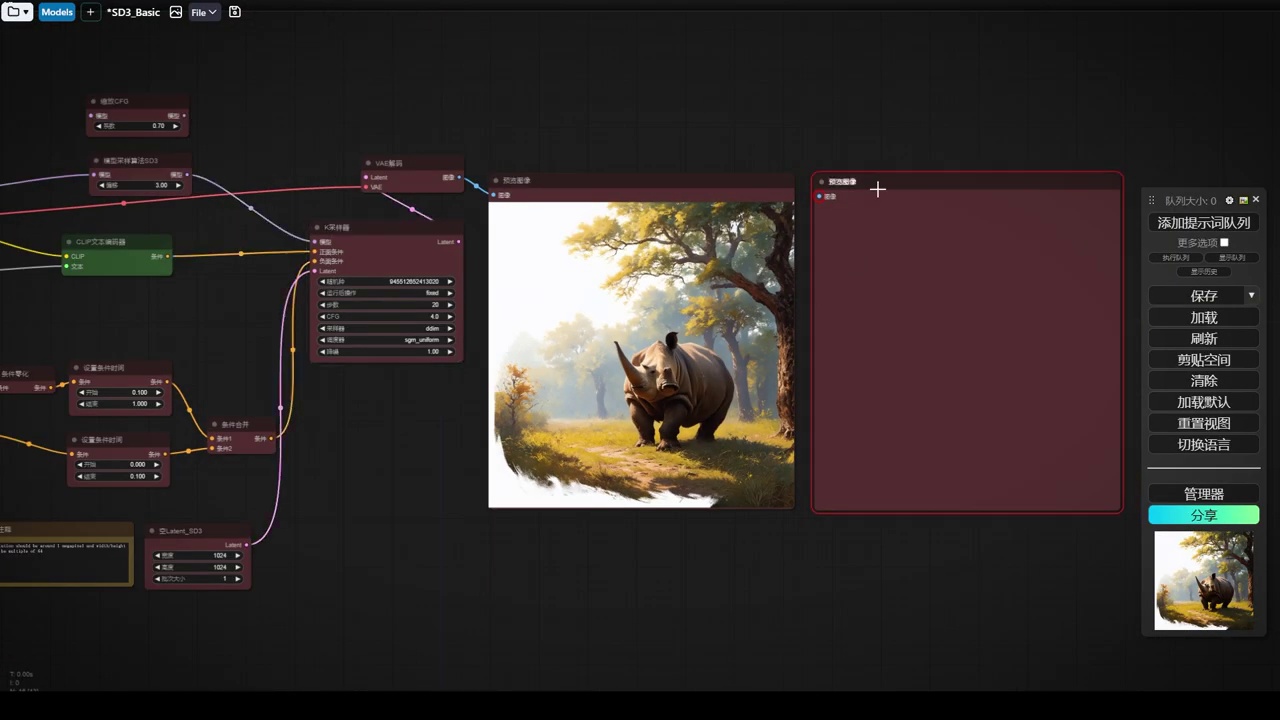

- 描述了使用某种风格生成图像的过程。

- 第一次生成的图像是犀牛,但看起来异常。

- 第二次生成的图像变为豹子,安全系数被调低至3。

- 光线对豹子来说仍然过强。

- 尝试生成小猫的图像,经过多次尝试后,艺术表现有所差异。

我们只需保留一些通用元素即可。这是我们采用该风格生成的图像。显然,这只犀牛看起来有些异常。我们重新生成一次,第二次生成的图像不再是犀牛,而是随机选择了其他动物,例如豹子。安全系数稍高,我们将其调低至3。光线对于豹子来说仍显过强。接下来是小猫的图像。经过几次尝试后,我们可以感受到在艺术表现上的差异。

- 尝试一次性生成多张图像,但系统重复生成相同图像。

- 需要实现批处理,生成多样化图像,类似于动画制作中的FIZZ节点。

- 使用Stream的合并功能和帧节点,设置不同组件生成不同内容。

- 通过设置帧和提示词,实现自动生成不同图像。

- 使用FIZZ批次调度,设置最大帧数,批量预览和生成图像。

- 尝试生成人物图像,通过修改提示词实现不同风格。

并不是特别好,只是中规中矩。接下来我们将进行一些变例测试,即一次性生成多张图像,例如4张、10张或5张。我们尝试将队列大小设置为2,生成两张不同的图像。但结果显示,由于我们只传递了一次提示词,系统重复生成了相同的图像。为了实现批处理,我们需要让系统生成多样化的图像。这涉及到使用批次处理,类似于动画制作中使用的FIZZ节点。按照之前的动画流程,我们可能需要手动输入提示词,但这并不方便。我们能否直接将提示词传递给系统,实现自动填写呢?这需要更精细的设置。

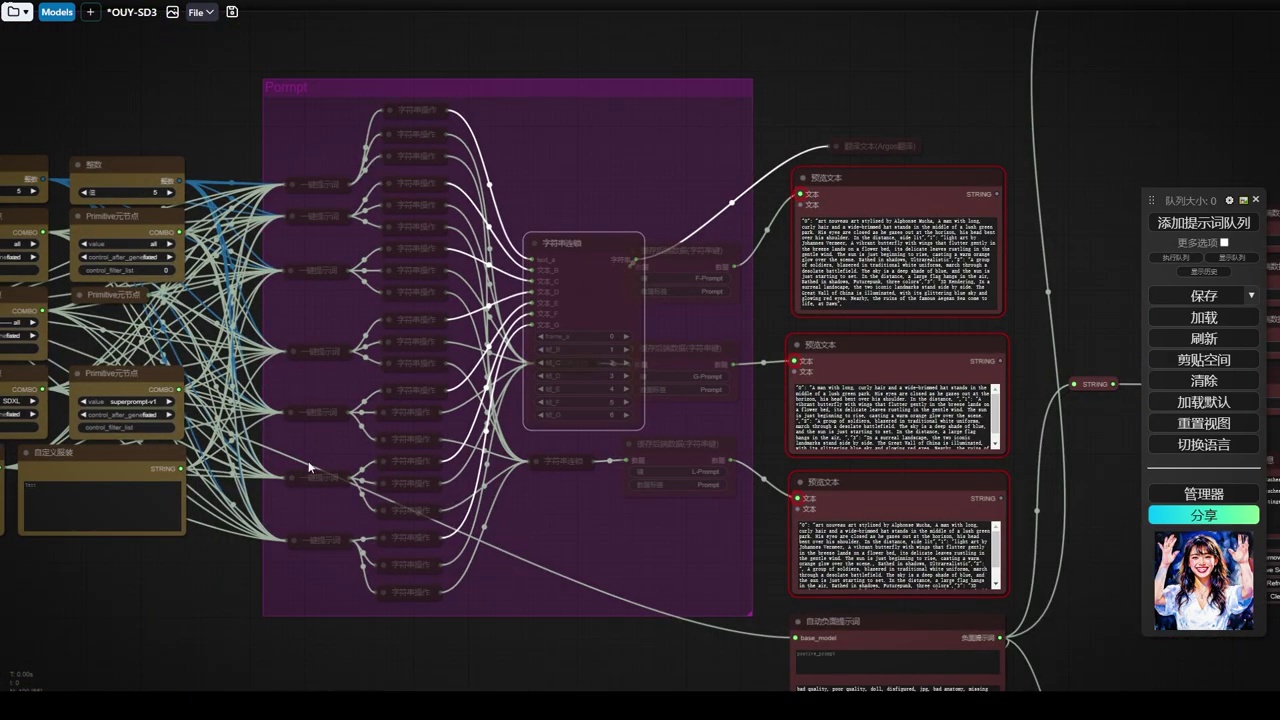

首先,我们需要使用Stream的合并功能。在帧节点中,我们可以看到字符串连锁,通过调整可以实现连锁效果,接收的即为提示词。我们可以设置对应的帧,将不同的组件生成不同的内容,传递给不同的帧。例如,我们将第一个组件设置为A,第二个设置为B,并复制这些自动生成提示词的节点。假设我们复制四张,以实现四张不同的图像。在输出字符串时,我们预览输出,可以看到文本前带有关键帧信息,如第0帧、第12帧和第24帧。这样,每个提示词前都生成了帧的格式。

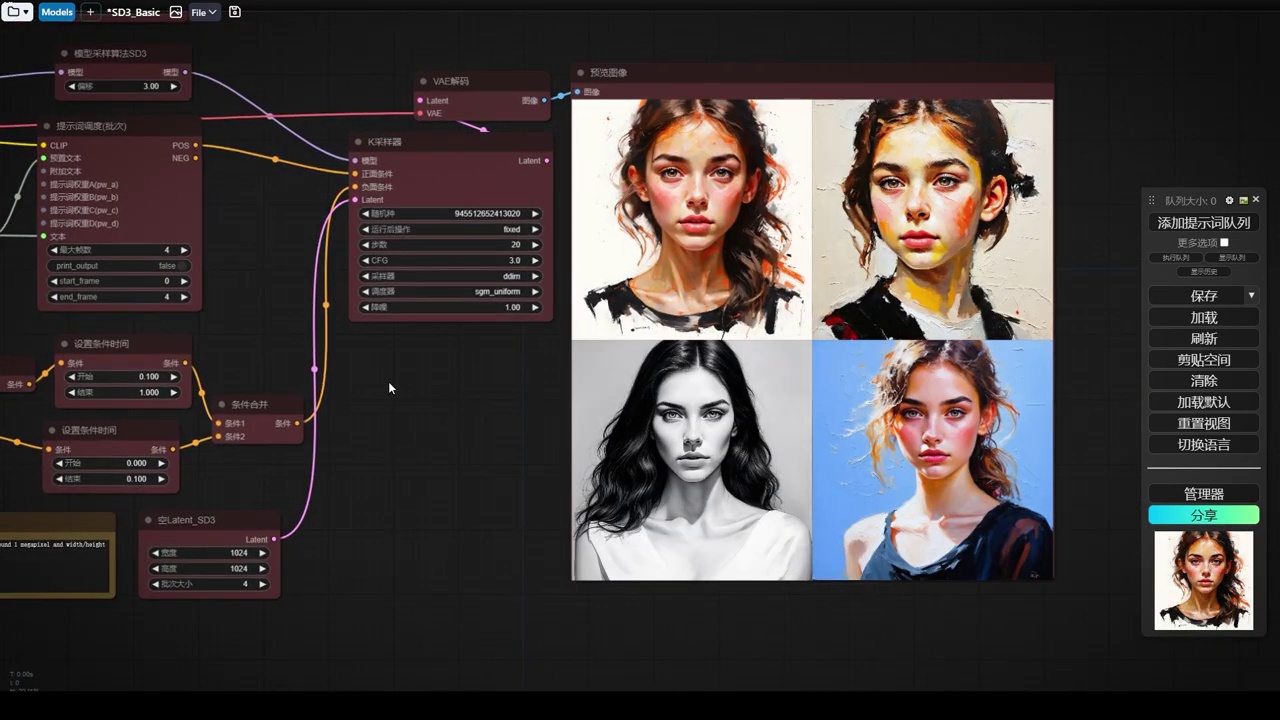

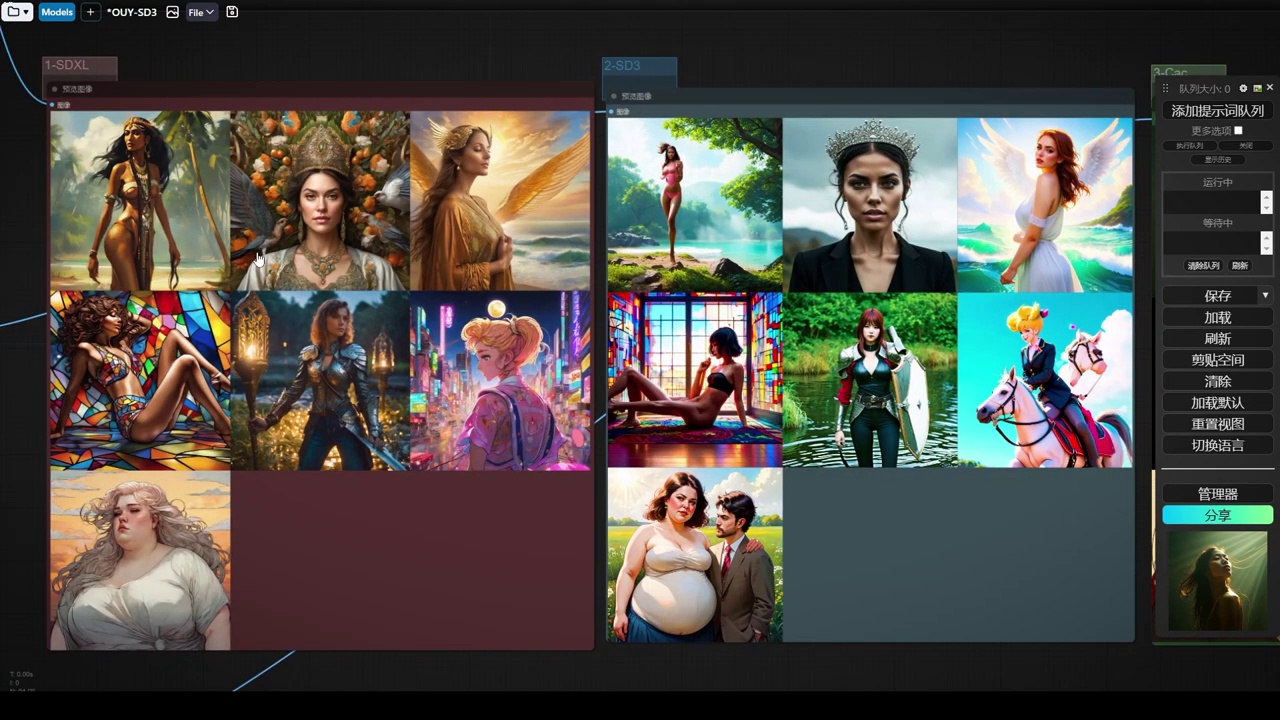

接下来,我们将每一帧设置为单独的提示词,如0123456。我们只需生成四个提示词。然后,我们使用FIZZ批次调度,找到提示词调度器。这样,我们可以将字符串输出提升为变量,设置最大帧数为4,相当于生成4张图像。通过编码器传递,我们可以批量预览各种提示词。设置结束帧为4,最终生成4张图像。打开采样器进行生成,我们可以看到不同风格的动物图像。

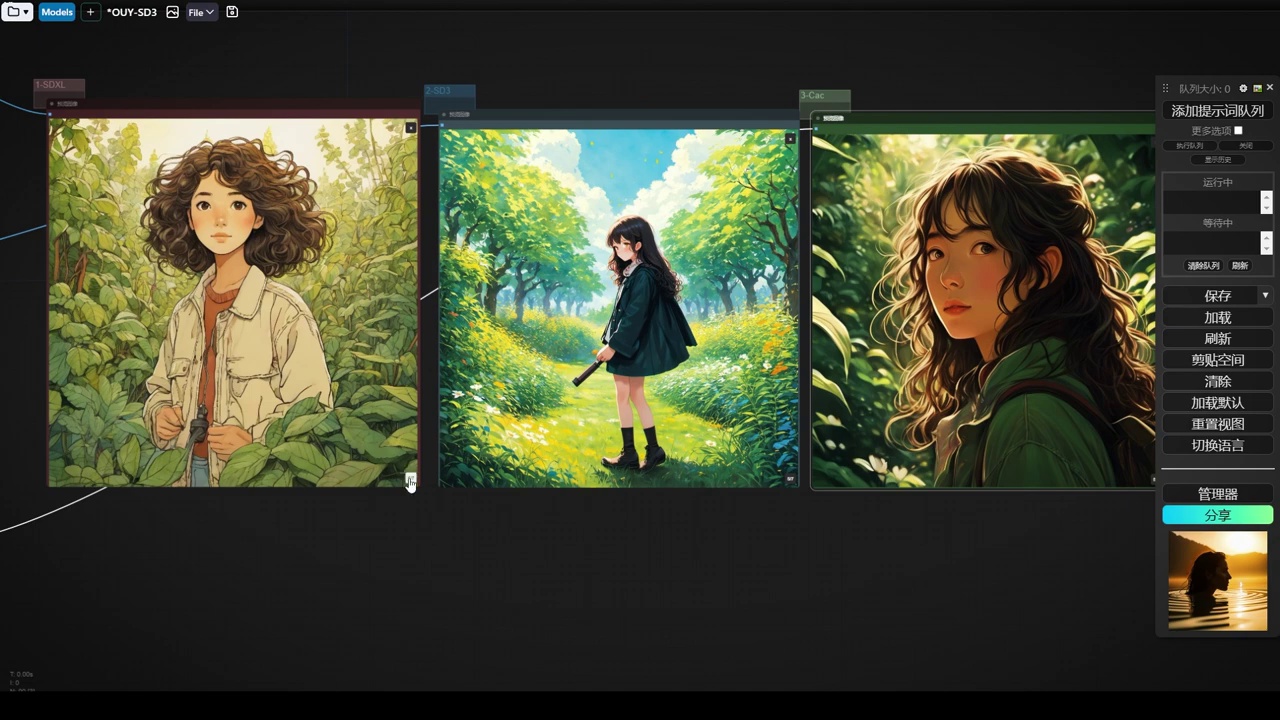

接下来,我们尝试生成人物图像。我们可以简单修改,去掉动物的提示词,只保留风格提示词。在批次中,我们可以设置一个置顶的文本,如“beautiful girl”,这样前置文本即为该女孩,后续文本则带有不同风格。再次生成,我们可以看到各种风格的女孩图像,如水彩风格、写实风格等。尽管对于肖像或近景构图效果尚可,但远景效果仍需改进。我们可以尝试添加肖像风格,以观察效果。

- 手动调整风格,包括水彩、幻想风、写实照片和动漫风格。

- 去除通用符,进行逐一修改。

- 添加正向提示词,设置在指定文本中,并将女孩添加到附加文本中。

- 重复添加正向提示词的操作。

之后,我们可以手动调整其风格。逐一修改,去除通用符,选择水彩、幻想风、写实照片和动漫风格。由于效果需要,我们添加一个正向提示词,简单地设置一个正向提示。将我们的女孩添加到附加文本中,并将正向提示词设置到指定文本中。接下来,我们再次添加一个正向提示词,简单地设置一个正向提示。将我们的女孩添加到附加文本中,并将正向提示词设置到指定文本中。接下来,我们再次添加一个正向提示词,简单地设置一个正向提示。

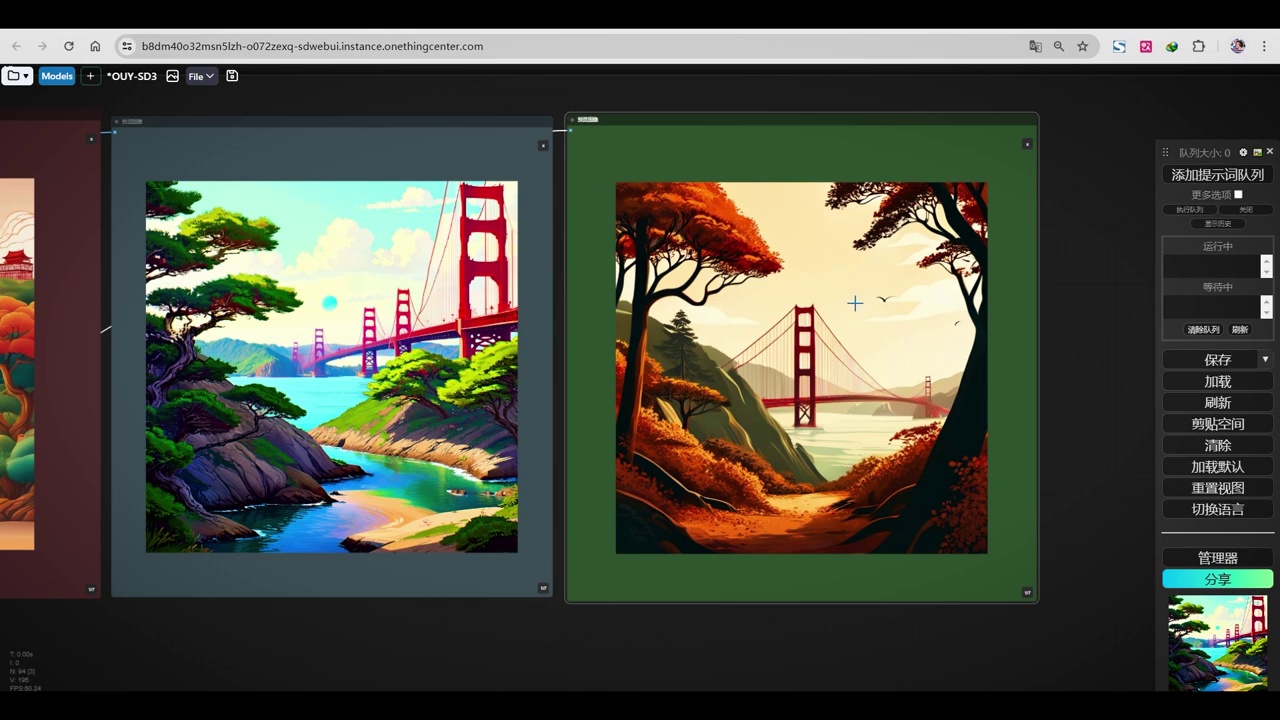

这里我们来看一下这个风格,第一个水彩的,第二个是写实的。

- 描述了几个手部模型的效果,指出它们存在问题,如多出一根手指、细节处理不佳。

- 提到这些模型是基础模型,细节未深入调校。

- 计划进行宏观分析和多模型比较,并已进行了一些调整。

第三个是幻想,第四个是Anime,但并不特别鲜明。接下来,我们尝试使用这只手,微笑着向观众招手,效果只能说一般。这个手多了一根手指,完全无法接受。而这一只也同样不理想。相比之下,这个稍好一些。我们再试一批,发现它们更为粗糙。由此可见,这个模型仅是一个基础模型,对细节的处理并未进行深入调校。接下来,我们将进行宏观分析,进行多模型的比较。在这里,我特意进行了一些调整。

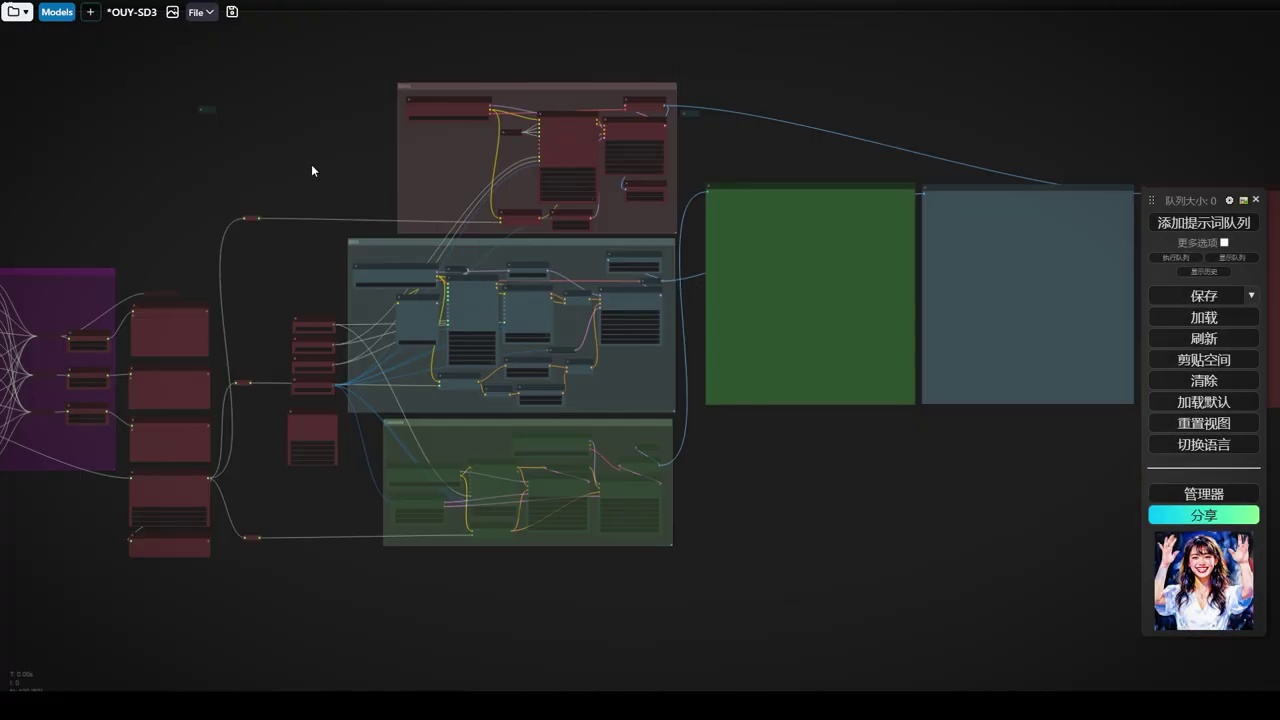

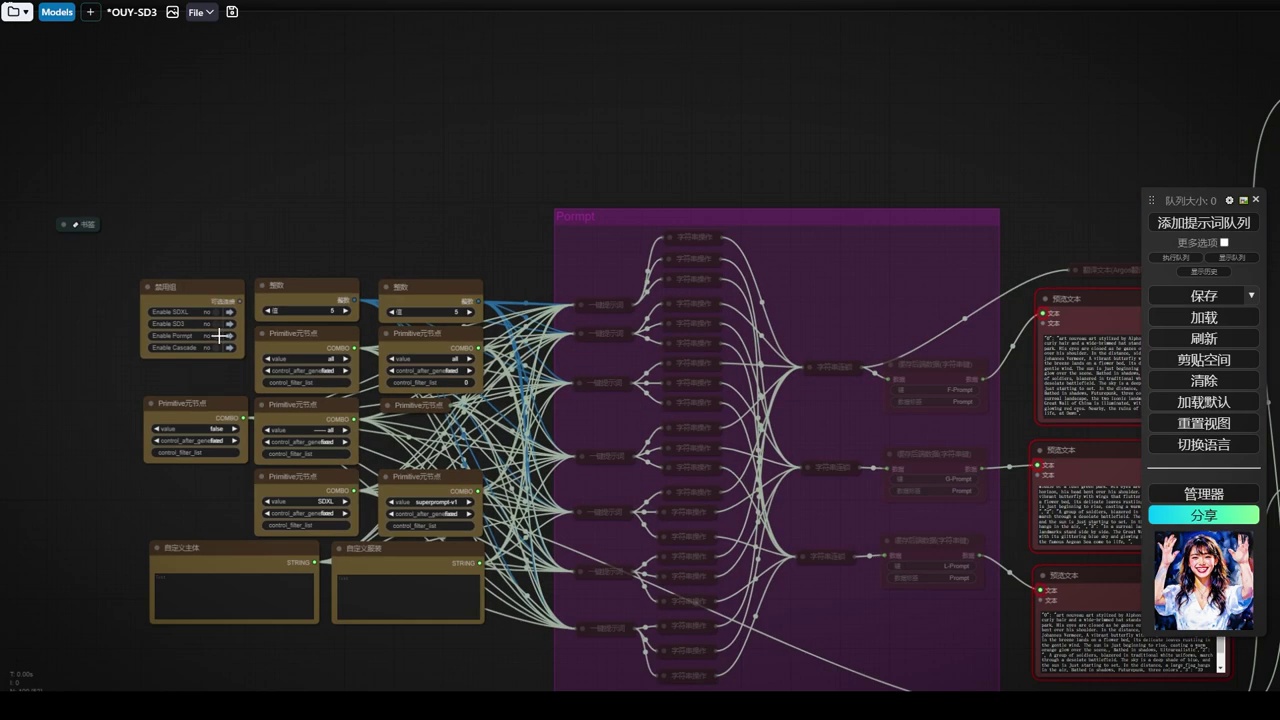

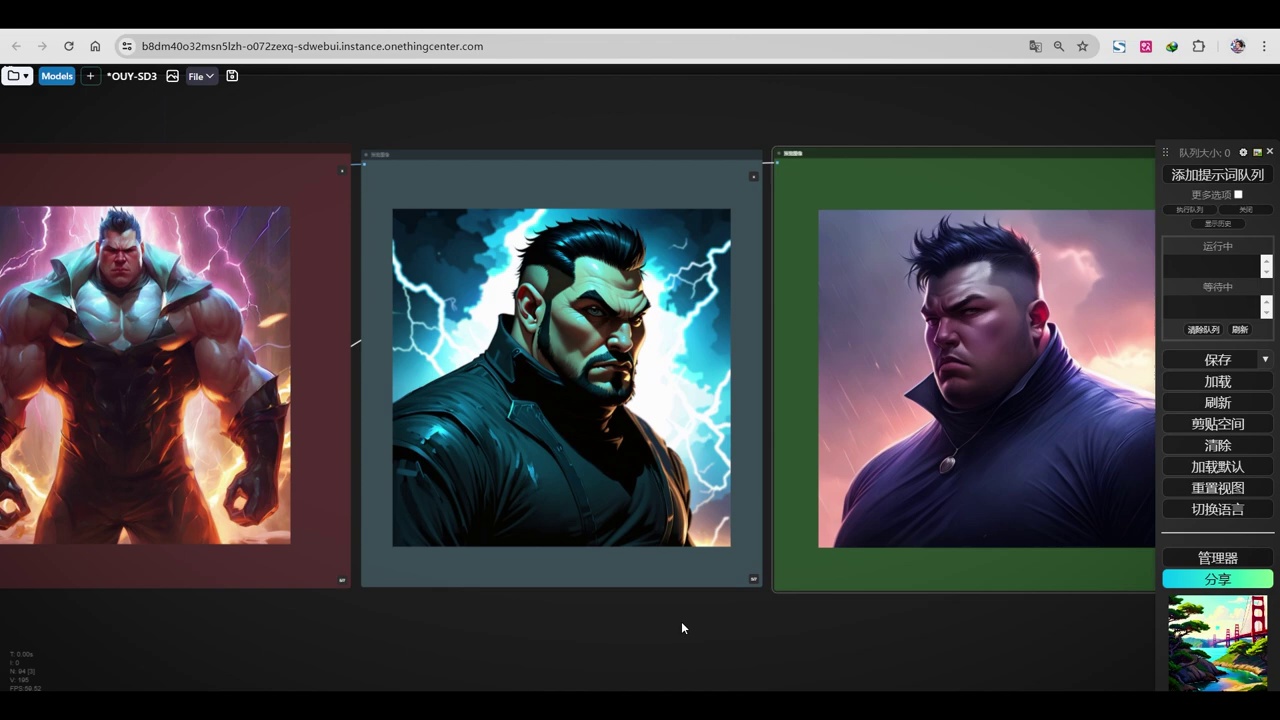

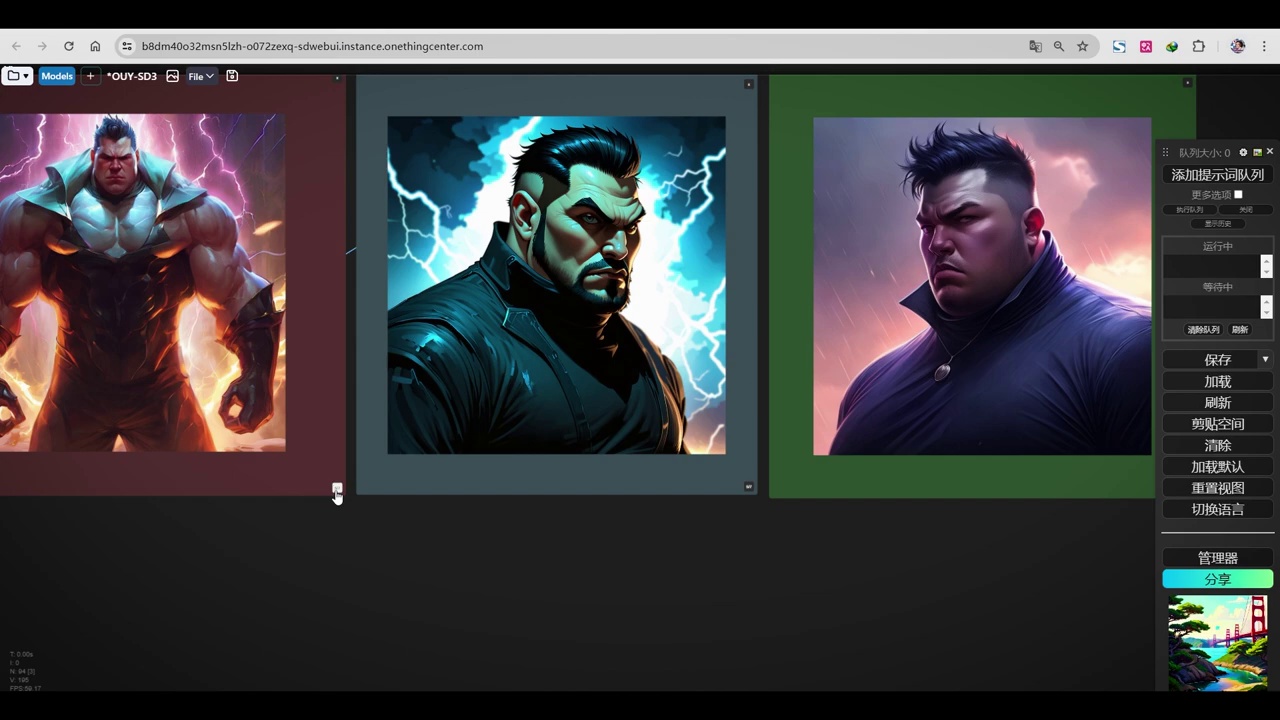

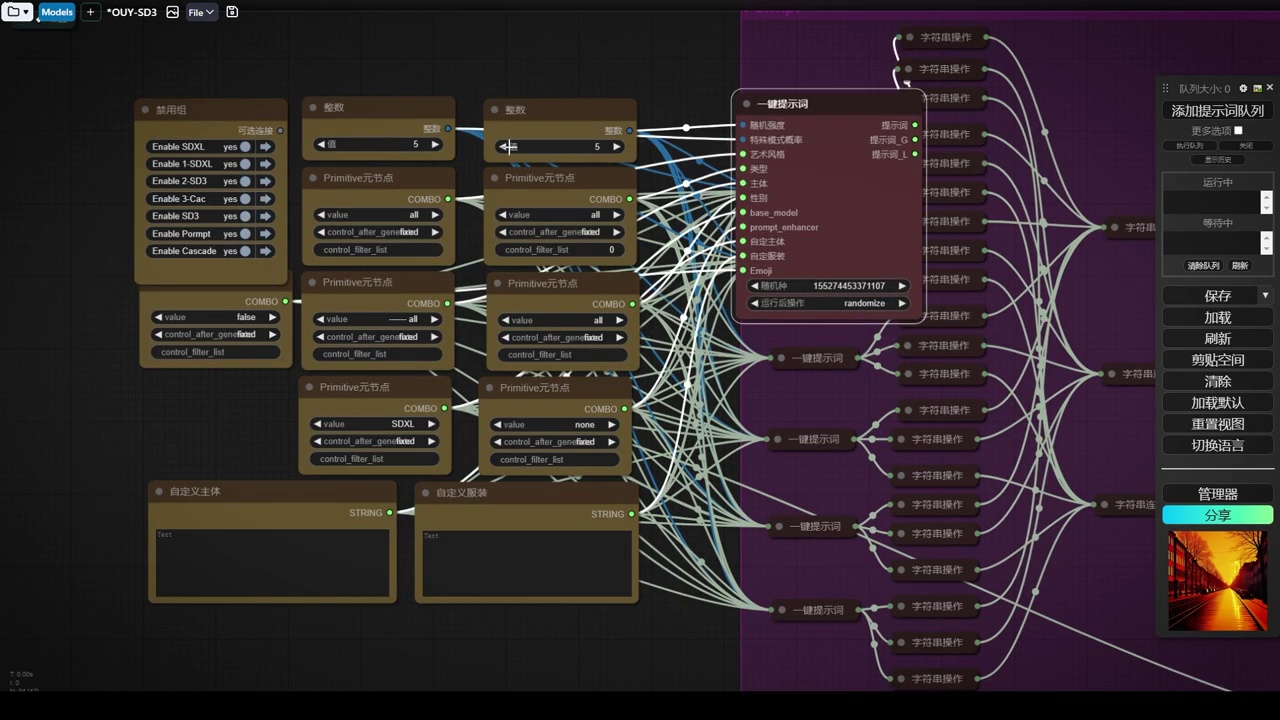

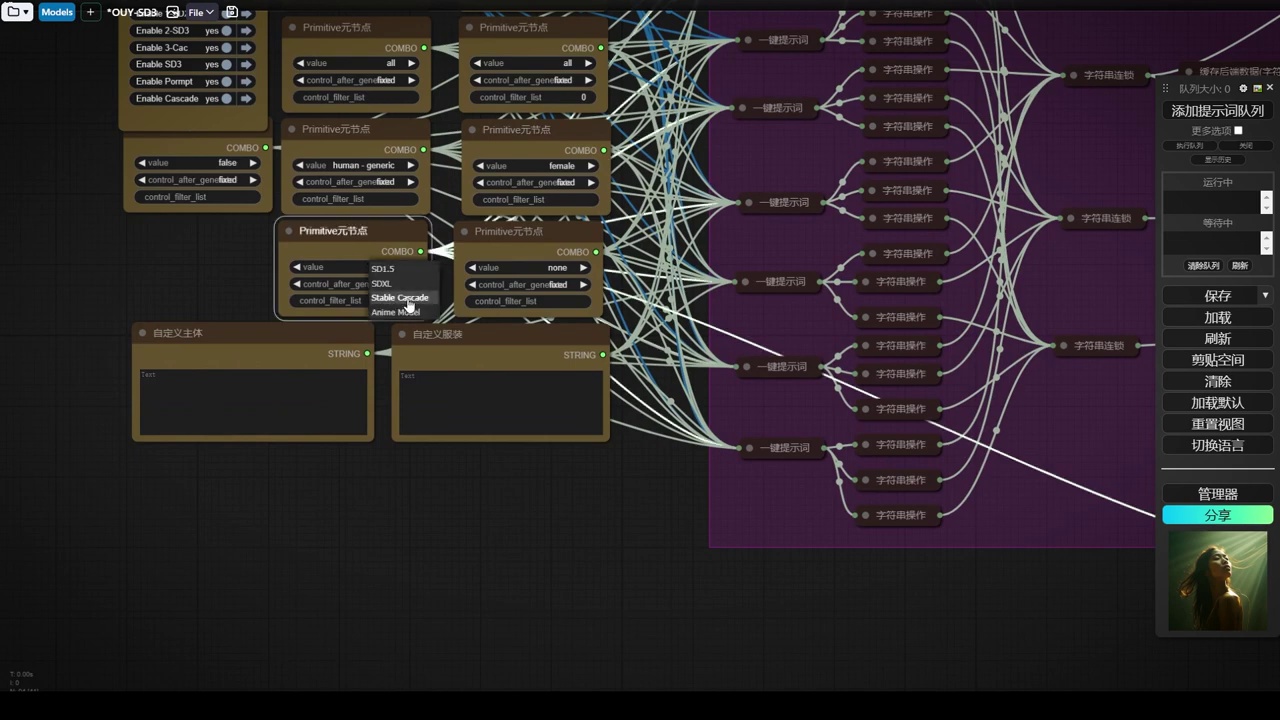

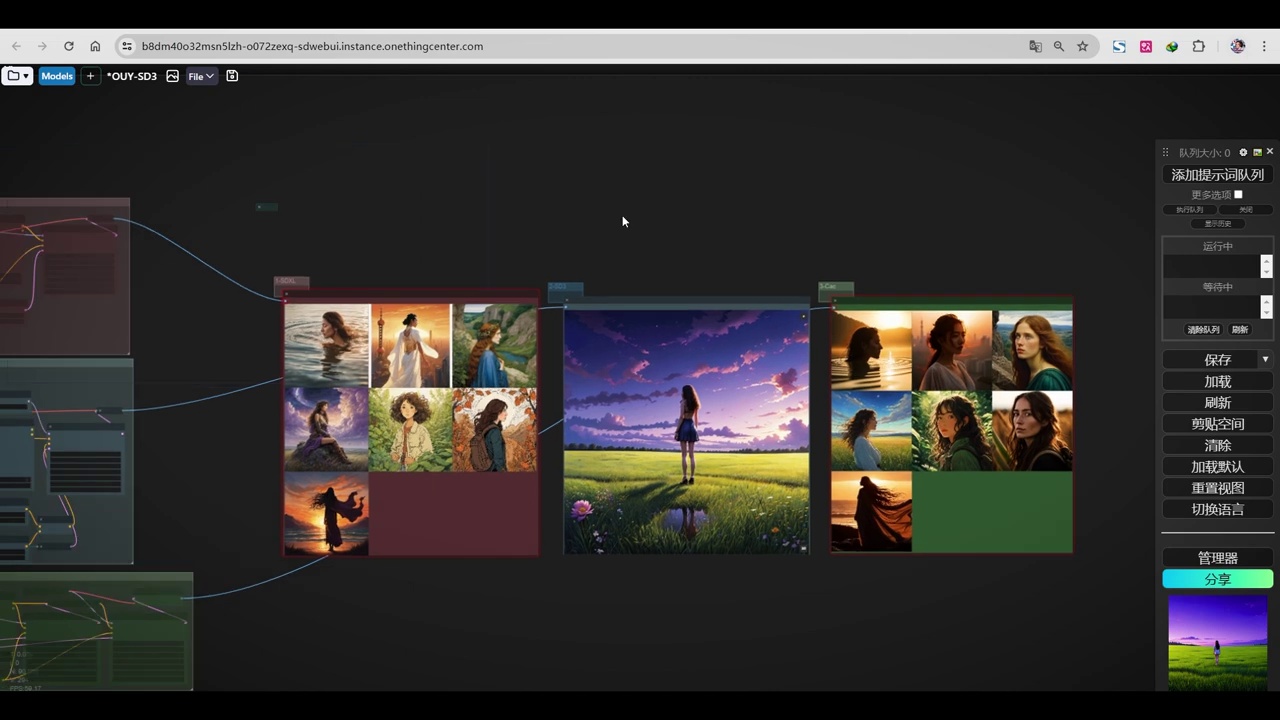

下午时间创建了一个测试工作流,该工作流规模较大,我们可以观察到。

这里放置了三种不同的模型,第一种是SDXL,我使用的是基础版本1.0的SDXL模型。

那么第三个呢就是Cascade,这三个模型生成了三个模型。

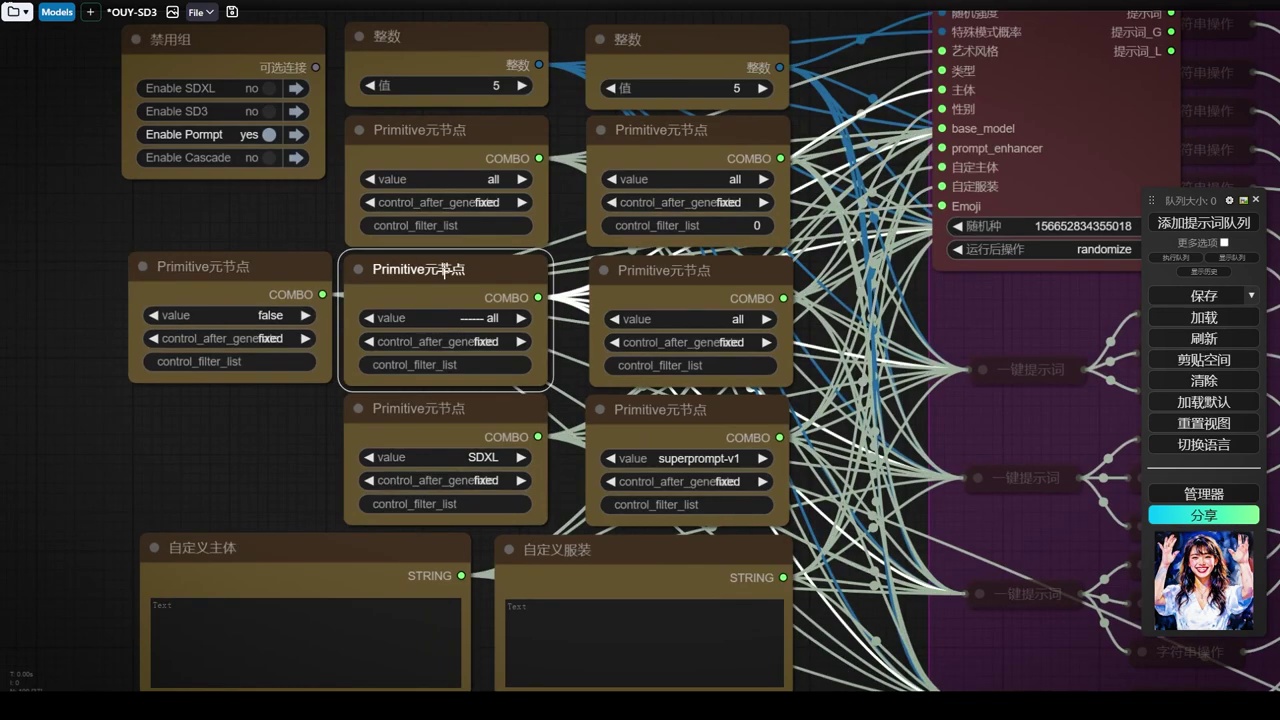

- 使用了SD中的一键题词插件,该插件支持GL和提示词通道。

- 插件允许选择不同风格、类型、主体和emoji表情。

- 目前插件未更新专门针对SD3的题词,因此统一使用SDXL的题词。

- 插件可以生成三个不同clip所需的文本,并随机选择艺术风格、类型、主体等。

- 作者对插件进行了调整,单独提升了题词所需的所有组件,包括随机强度。

我们来对比一下,同时这里我使用的是一键题词的插件,之前在SD中跟大家讲过的这个一键题词。在配置中,自然也是有的,这里可以看到它分为GL以及提示词,不同的通道,可以选择不同的风格、类型、主体,以及emoji表情等,非常丰富。我们需要生成哪一类的,目前还没有更新出专门针对SD3的题词,所以这里我们统一使用SDXL的,因为它包含了GL。第一个宏观提示词,我们可以给到SD的T5这样一个clip。这个题词很简单,我们可以预览一下,它会同时生成三个不同的clip所需的文本,我们直接预览并生成。我们设置任何东西时,它会直接随机选择,如艺术风格、类型、主体等,选好后直接出题词。可以看到我们这边的题词已经出来了,这个插件还是比较好用的,但不能保证题词的精度能适合SD3,所以我在这里做了一些工作。在题词这个组里,我把它需要的所有组件都单独提升出来了,包括随机强度等。

之后,我进行了字符串处理,因为一键提示词生成的提示词可能包含双引号。

- 双引号是ZIF节点的一种特殊格式。

- 零帧是ZIF节点处理的一种方式。

- 如果提示词中夹杂其他字符,ZIF节点无法正确识别。

- 为了解决识别问题,所有包含特定符号的提示词被替换为空。

- 对提示词的GLI进行了字符串操作测试,并得到了结果反馈。

这个双引号实际上是ZIF节点的一种特殊格式。我们在这里扩展一下,这是零帧,这是它的处理方式。随后,在零帧后输入的提示词中,如果出现额外的符号,例如提示词中间夹杂了其他字符,该节点将无法正确识别。因此,在字符串操作中,我将所有包含该符号的提示词替换为空,去除了该符号。接着,对提示词的GLI进行了字符串操作测试,最终结果反馈给我们。

- 创建了7个字符串连接。

- 生成的字符串被存入缓存。

- 可以预览缓存中的内容。

- 从缓存中读取数据,包括G、L和全局提示词F。

- 数据对接至生成工作流。

- 使用了“one button prompt”插件的自动负面提示词功能。

- 生成了一个负面提示词。

刚才我们提到的字符串连接,共提供了7个,因此我创建了7个连接。连接完成后,生成了字符串,我们将其存入缓存,以便保存。在此,我们可以进行预览。最后,我们从缓存中读取数据,包括G和L,而F则代表全局提示词。随后,我们将此对接至下方的生成工作流。此外,我还设置了一个自动负面提示词,这是我们“one button prompt”插件中的功能之一。我们可以看到,这里生成了一个负面提示词。

- 提供了三个不同的流程:SDXL、Cascade和SD3。

- SDXL流程中,输入的是G和L的文本。

- Cascade流程中,只有一个文本输入,使用全局提示词。

- SD3流程中,实验性地进行了提示词的分离,包括宏观提示词和SDXL的L和G输入,并通过Combine将两者结合。

- 提出了使用T5专门的编码器作为更好的文本处理方式,但由于其专业性,未被采用。

也给了他们三个流程。具体的方式,SDXL就不用说了,我输入的是G和L的文本。下面的Cascade只有一个文本输入,所以我给到的是全局提示词,即宏观的提示词。对于SD3,我实验性地做了一个提示词的分离。首先,我给它一个宏观的提示词,使用普通提示词的P次节点。同时,我还给它SDXL的L和G输入。最后,将这两个P次进行Combine。因此,这边是SDXL的P次加1.5的P次,一个接收全局宏观,一个接收SDXL。我只能通过这种方式传给它,但更好的方式是使用T5专门的编码器,即文本编码框。然而,由于它是T5专门的编码器,那样一个文本编码框。

由于文本编码框不支持批处理,因此无法进行此操作。希望未来FIZZ能够开启SD3调度功能,预计后续会进行更新,目前尚未更新,因此我们只能暂时使用现有流程。后续步骤与之前相同,即遵循此流程。

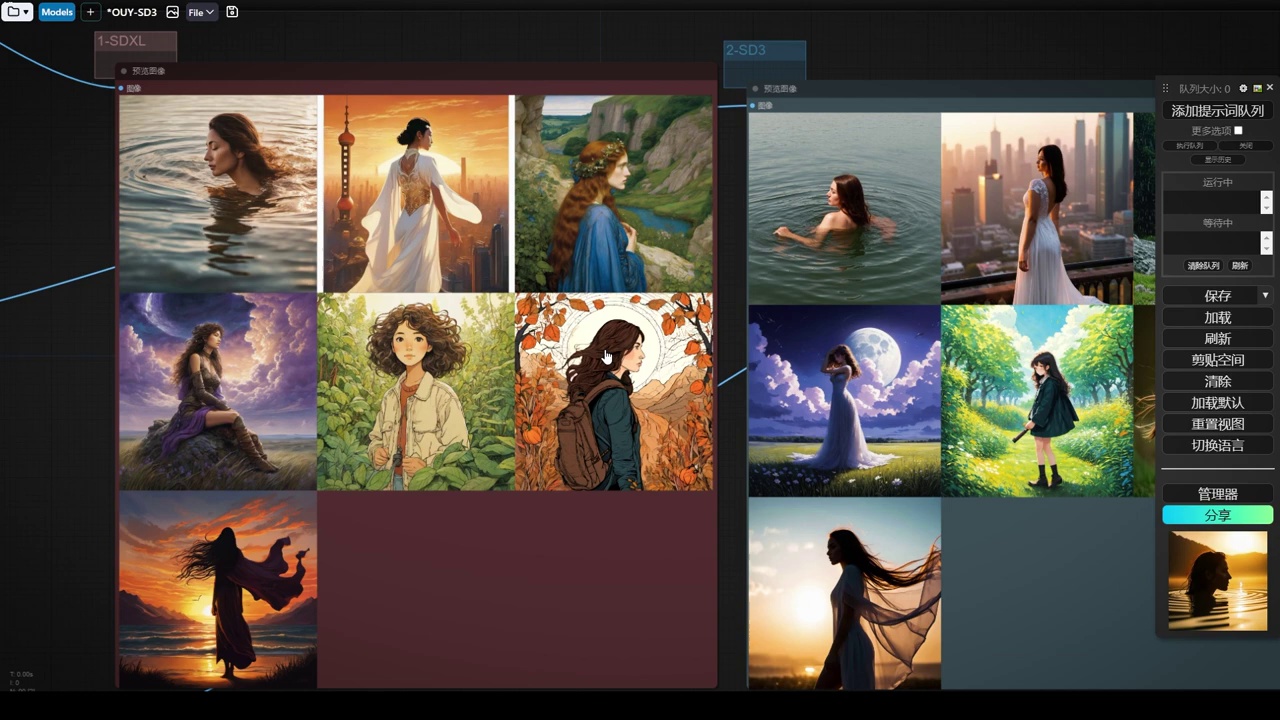

然后我们使用这个提示词,随意生成一些内容,首先打开我们的提示词组。

- 参数设置为7,用于生成7张不同图像。

- 关闭了其他所有组,只保留一个缓存,防止重复调用。

- 未设定风格主题,系统将随机选择并生成图像。

- 生成过程中,系统会逐一提示关键词。

- 生成完成后,相关文本将自动标记关键帧。

- 之后,关闭提示词功能,开启XL渲染、SD3渲染和Casket渲染。

我们将参数设置为7,以生成7张不同的图像。在此之前,我们已关闭其他所有组,以便只生成一个缓存,避免重复调用。目前未设定任何风格主题,系统将随机选择并生成7张图像。生成过程中,系统将逐一提示关键词。生成完成后,所有相关文本将自动标记关键帧。随后,我们可以关闭提示词功能,并开启XL渲染、SD3渲染和Casket渲染。

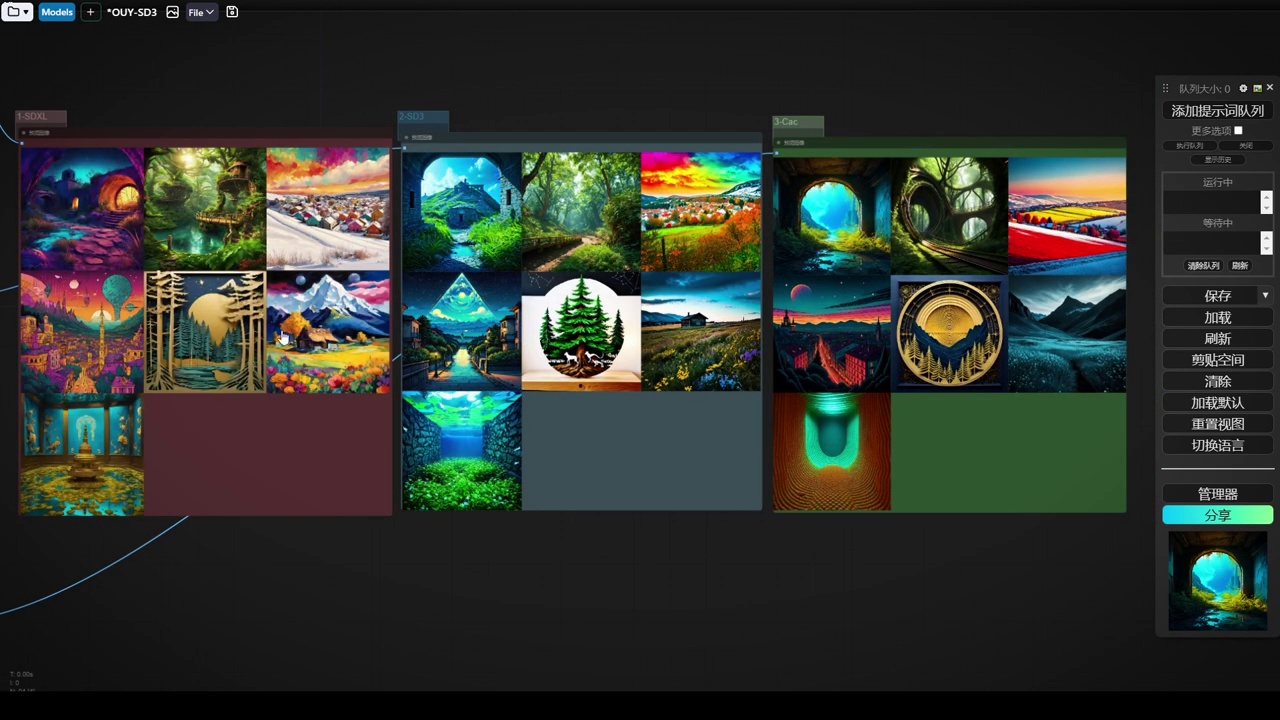

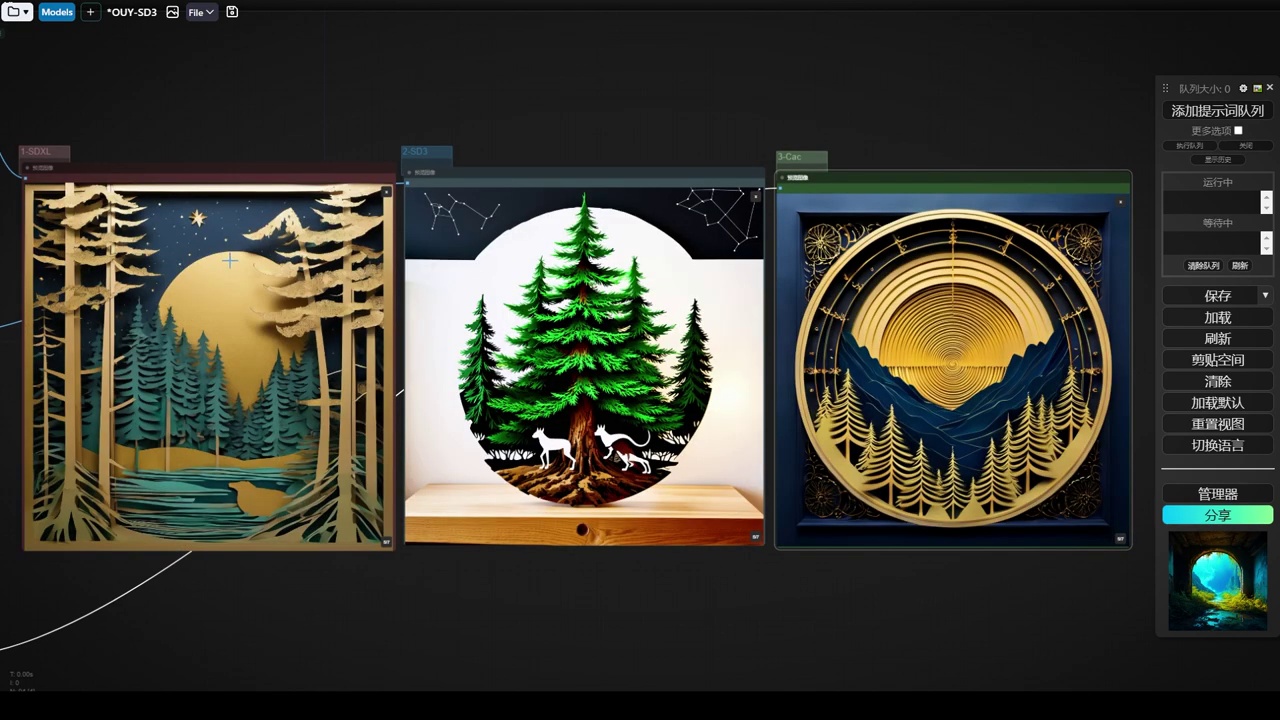

然后呢,我们来直接渲染声场。

最左边是Cascade,中间是SD3,右边是SDXL。

这三张我觉得Cascade比较好的,那SDXL也很适合。

对于人物而言,Cascade模型更具有风格性,特别是SD3模型。

该作品风格性不强,画面存在问题,可能是由于合并方式不当所致,但整体观感尚可。

- 提示词使用可能不准确,建议直接使用单独的提示词。

- 描述了三组不同的生成图像:

- 第一组是SDXL,内容为一组车的风景。

- 第二组是SD3,内容为一组车的风景,增加了一个人物,两侧均为车辆,无异常。

- 第三组是Cascade,内容为人物特写,展示的是SD4。

- SD3的图像风格中规中矩,无特定风格。

可能由于我提供的提示词不准确,我们直接使用单独的提示词更为保险,再进行一批生成。刚才未作标注,因此我表述有误。第一个是SDXL,第二个是SD3,第三个是Cascade。同样是一组车的风景,SD3显得更为中规中矩,无特定风格。第二个是SD3,增加了一个人物,两侧均为车辆,无异常。第三张为人物特写,展示的是SD4。

- SD3模型权重偏高,建议调整至3.5。

- 风景图像处理效果尚可,但人脸图像处理不佳。

- 图像变形问题源于基础数据质量不佳。

- 房间描述模糊导致图像风格不一致。

- 最后一张图像的水珠和水滴效果最佳,推荐使用SDXL模型。

SD3的权重仍然偏高,需要适当降低至3.5。对于风景图像,SD3表现尚可。第三张尝试了人脸图像,而最后一张与第一张相比略有变形,表明其基础数据质量不佳。由于此类图像非普通人能轻易生成,因此关键在于基础数据的质量。房间的描述较为模糊,导致生成的三张图像风格各异。最后一张图像中的水珠和水滴效果最佳,推荐使用SDXL模型。接下来,我们将继续查看下一组图像。

首先我们来看一组风景。我们来到设置界面,由于翻译插件的问题,我将这些名称进行了修改。但重新加载工作流后,它们又恢复了原样。这是无法避免的,只能重新查找。我们选择一个风景主题。

我们保持其他设置不变,直接生成。初步观察,SDX的表现更为出色。相比之下,SD3的表现较为平淡,但其色彩处理和想象力较为丰富。这主要涉及到风格训练的问题。我们已降低了相应的权重。

- 作者对SDXL、casekit和SD3的表现进行了评价,认为SDXL表现最好,其次是casekit,SD3排名第三。

- 作者指出,单独比较提示词时,这些工具的表现并不特别突出。

- 作者计划进行进一步的测试。

还是有一些过,这一张各有特色。接下来,我认为SDXL表现较好,其次是casekit,第三是SD3。通过这样的对比,大家应该能大致了解它们的水平。如果是单独比较提示词,它们并不显得特别突出。最后,我们将进行进一步的测试。

一组人物吧,测试一组女性。

大家应该都喜欢看这位美女,接下来我们进行调整,选择通用选项,其他设置保持不变,再次生成,可以看到效果仍然不尽人意。

一样最好的还是SDXL。要注意我现在用的这个SDXL

XL是基础模型,最原始的Base 1.0的模型。

能体现出来整体的风格。那Cascade呢,稍微有些一般吧。

对于动漫的可以看到它就不太强,而对于SD3真的就不太强。

我怀疑是否配置错误,因为我们使用的是PF8的精度,并非实际的PF8。

- 讨论了使用不同版本的提示词(SDXL、1.5版本、Cascade风格)对效果的影响。

- 指出如果需要提供Cascade的GHL张量,可能会导致SDXL调度编码报错,因为张量不一致。

是否因为此原因?还有一个问题,即此处的提示词,我提供的是SDXL风格提示词,若提供1.5版本或Cascade风格,我们尝试一下,观察其效果。若此处需提供Cascade的GHL张量,可能导致SDXL调度编码报错,因其张量不一致。

我们将直接统一设置为默认的 SDXL,不再使用其他选项如 G 或 L,取消这些设置,仅提供一个提示词,然后重新生成一轮。

其实用处不太大。

X4D XL 的质量略有下降,Casket 也未进行调整。

- OUYSD3 模型表现不佳。

- 其他两个模型在各方面优于 OUYSD3。

- OUYSD3 属于基础模型,风格训练不足。

- 尽管数据训练充分,但使用提示词测试时差距明显。

而 OUYSD3 呢,仍然表现不佳。相比之下,其他两个模型在各方面都要优于 OUYSD3。因此,OUYSD3 仍然属于基础模型,其风格训练不足。尽管在数据训练上可能更为充分,但直接使用提示词进行测试时,仍显示出明显的差距。

如果我们在此基础上采用这种方式进行丰富,观察是否能得到改善。这是第四章,我们直接复制第四章的提示词,并进行更为精彩的处理。

- 使用特定方法后,效果未达预期。

- 原因不明,可能与模型本身或版本有关。

- 建议尝试重新下载PF16版本。

- 提到liblib支持在线生成,将进行进一步验证。

可以看到,即使使用了该方法,效果仍不理想,具体原因尚不清楚,可能是模型本身的问题,也可能是需要重新下载PF16版本进行尝试。本期内容到此结束。最后,我们将再次复制提示词,因为之前提到liblib支持在线生成,我们将进一步验证这一点。

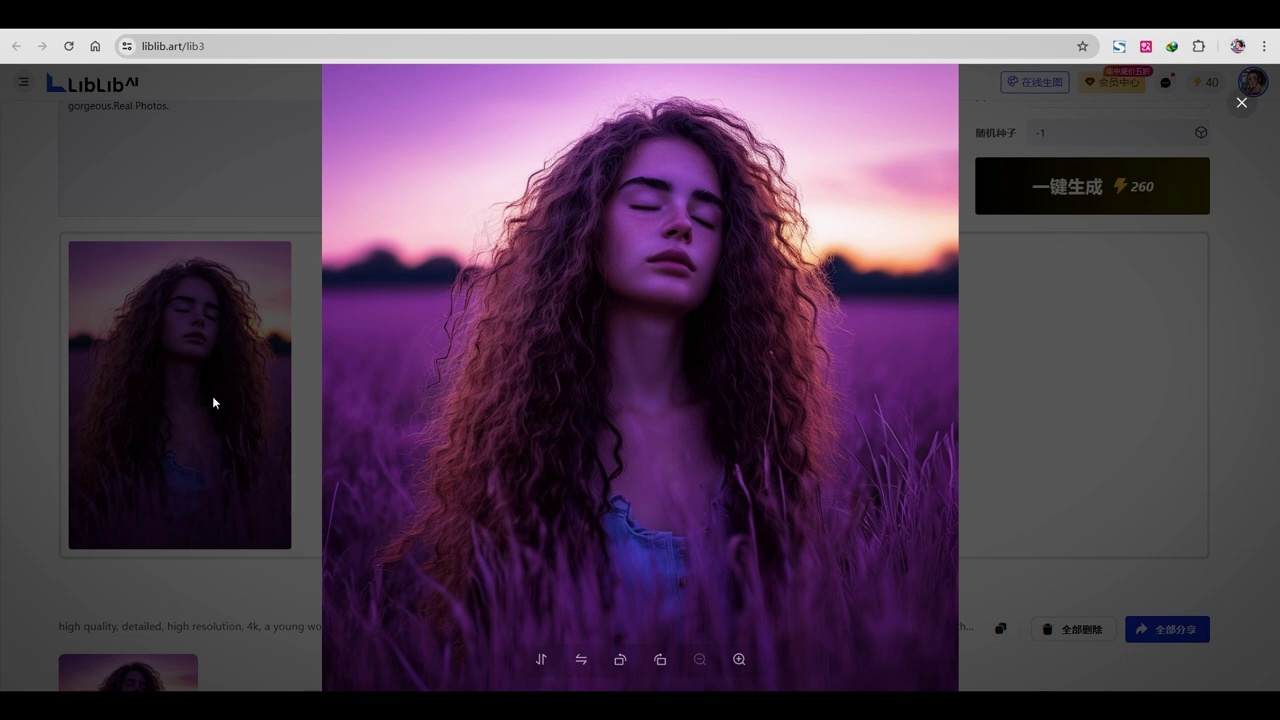

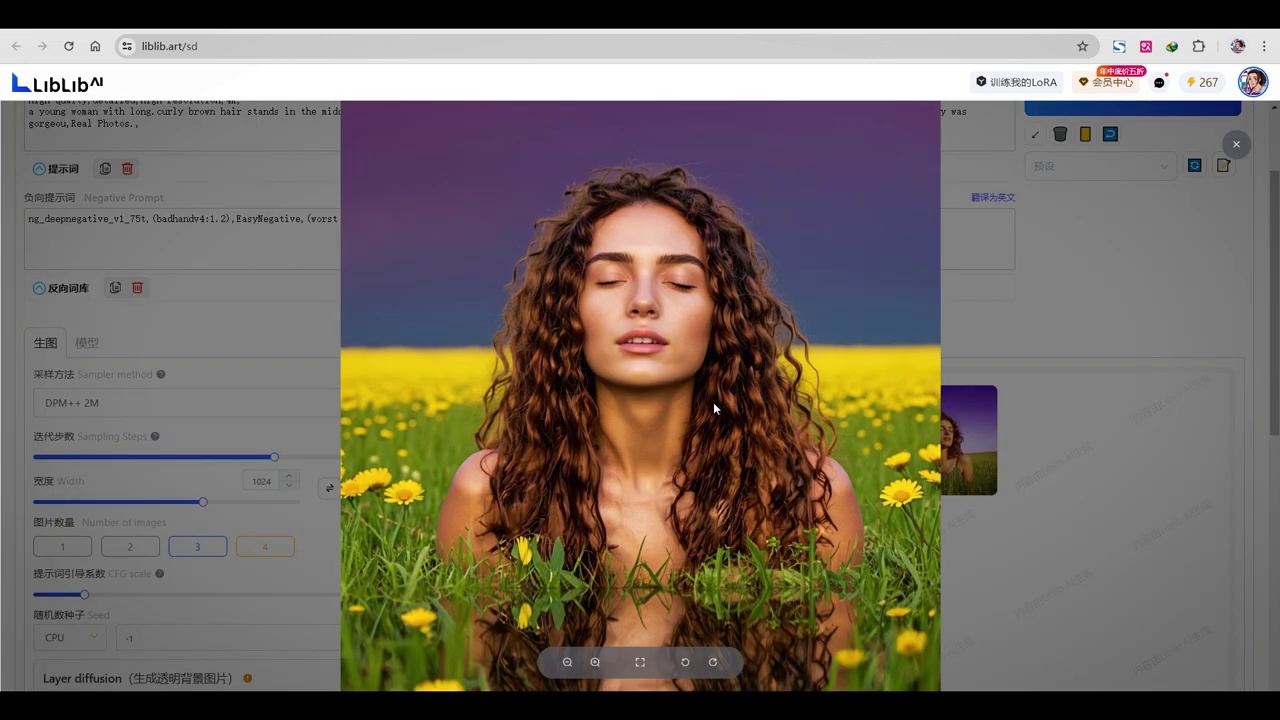

我们使用liblibartlib3的在线生图功能,直接复制了提示词。

- Liblibartlib3模型表现尚可,但仍需优化。

- 作者计划进一步探讨Liblibartlib3的具体问题。

- 作者之前偏好Cascade模型,但测试显示SD模型效果更佳。

- 作者将分享工作流,供大家测试不同模型和流程。

- 鼓励大家在评论区交流优化模型和流程的经验。

- 提供交流群供新手和有经验者共同探讨问题。

我们直接来生成。可以看到Liblibartlib3的表现还可以。那为什么本地生成的就不行呢?所以现在看来,它还是基础模型,还需要进一步的优化。如果大家还像我一样不甘心,我们之后会详细讨论它具体在哪一方面出了问题。之后我可能会再摸索一段时间,看一看到底它遵循什么规律。不可能比这两个都差。像之前我还是挺侧重于Cascade,我比较喜欢它的感觉。但是经过今天这么一测,其实SD的效果要更好。那么这就是这一期要跟大家分享的内容了。之后我也会把这个工作流发出来。大家如果想实验一下,想跑一下不同的模型或者跑一下不同的流程,具体是什么效果的话,可以用这个工作流。然后大家如果测出来哪些可行性,怎么优化这个模型出的图,也可以在评论区下方多多交流。如果还不太明白的小伙伴也可以加入我们的交流群。有很多大神们一起探讨,有什么问题也能及时解决。那么最后还要说的就是,这个新手不知道去哪下模型,如果有问题的话,可以在评论区下方多多交流。

- 目前存在两种版本的V3:在线生成的V3和高级版V3。

- 高级版V3可能通过调用官方API实现,其效果显著。

- 计划对比官方API调用与本地模型调用的效果,以验证是否使用的是优化后的高级模型。

现在我们可以看到,它现在分为在线生成的V3以及我们刚才使用的高级版V3。高级版V3应该是调用了官方的API,否则效果为何如此出色?如果有兴趣,之后我们可以再对比一下调用官方API和我们本地调用模型是否效果一致或相似。如果不一致,那就说明官方仅开源了其基础模型,通过API调用的是其优化后的高级模型。

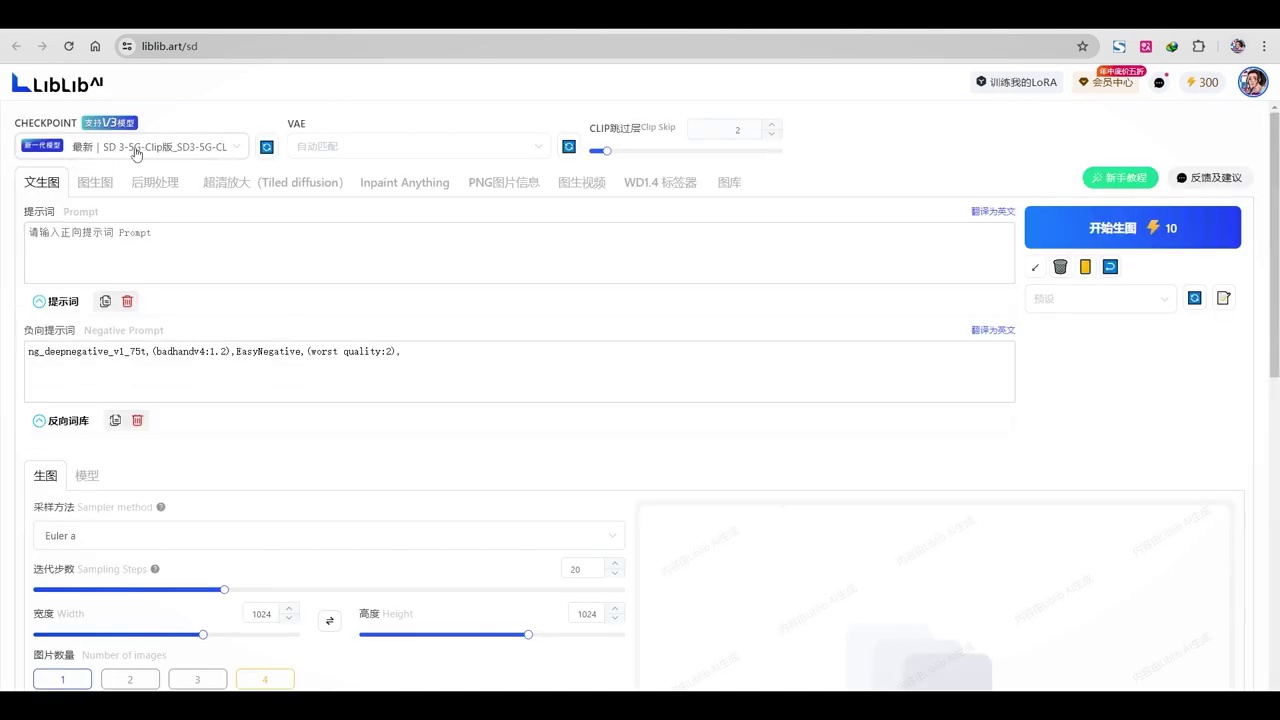

- Libu在线生成平台全面支持SD3模型的调用。

- 该平台可能是SD3上线最快的在线生成平台。

- 用户复制粘贴提示词并设置采样器。

- 默认选择2M,迭代步数设为25步,提示强度调整为3.5。

- 图片数量增加至3张,用于对比。

现在尝试在Libu的在线生成平台,可以看到它已全面支持SD3模型的调用,这应该是SD3上线最快的在线生成平台。我们将刚才的提示词复制并粘贴到这里,然后对下面的采样器进行设置。由于WebUI与CAPEI存在差异,我们默认选择2M。迭代步数设为25步,提示强度调整为3.5,图片数量增加至3张,以便于对比。

- 讨论了conf UI的Noise生成方式与SD生成方式的差异。

- 建议尝试将生成方式改为SD以观察效果改善。

- 指出使用web UI进行生成操作的便捷性。

现在我们来生成。这样的结果与API调用相似,差异可能源于conf UI的Noise生成方式与SD的生成方式不同,这一点我们之前已经讨论过。最后可以尝试将生成方式改为SD,看是否有改善。因此,习惯使用web UI的朋友在此处生成还是比较方便快捷的。这就是本期内容。

本期内容已全部分享完毕。若对您有所启发和参考价值,请不要忘记点击关注。后续还将有更多资讯、新闻及应用与大家分享。本期到此结束,下期再见。

本文总结

- SD第三代模型SD3基于SDXL进行训练,增强了TVE解码部分,改善了对提示的理解和元素融合能力。

- SD3采用了三种Clip编码,增加了文本编码器,训练数据量更大。

- 介绍了Config UI的批处理操作,包括不同工作流的使用和动态提示词插件的安装。

- 讨论了模型的获取和配置,以及如何通过LibLib网站下载和使用资源。

- 进行了不同模型的生成效果比较,探讨了提示词的调整和优化,以及在线生成与本地生成的差异。

金句摘抄

- “SD3的架构基于SDXL进行训练,首先我们可以看到TVE解码部分得到了大幅增强,现在通道数为16。”

- “这一新一代模型采用了三种Clip编码,在SDXL中,我们有两个编码器,一个是L,一个是G。”

- “对于国内用户,需下载并加载这些模型,最佳访问的资源网站是LibLib。”

- “在服务器这边,我们来直接打开这个工作流,我已经等待半天了。”

- “我们来看一下这个风格,第一个水彩的,第二个是写实的。”

QA

- SD3与之前的模型架构有何不同?

- SD3基于SDXL进行训练,增强了TVE解码部分,改善了对提示的理解和元素融合能力,并采用了三种Clip编码。

- Config UI的批处理操作包括哪些内容?

- Config UI的批处理操作包括基础工作流、提词强化工作流和传统放大工作流,以及动态提示词插件的使用。

- 如何获取和配置模型资源?

- 可以通过访问LibLib网站下载模型和资源,配置服务器和文件管理,以及使用题词卡片。

- 不同模型的生成效果如何比较?

- 通过调整提示词和优化设置,可以比较不同模型的生成效果,探讨在线生成与本地生成的差异。

- 如何使用动态提示词插件?

- 动态提示词插件可以在Manager中搜索“Dynamic”,安装后可以在新建节点处显示动态提示词,使用通配符文件进行随机调用。

结语

通过本篇文章的详细评测与教程,相信大家对最新的Stable Diffusion 3 (SD3) 模型有了更深入的了解。无论是模型的架构改进、性能提升,还是实际使用中的小技巧,我们都进行了全面的覆盖和解析。希望这些内容能为您的AI绘画创作提供帮助和灵感。

如果您觉得本期内容对您有所启发和参考价值,请不要忘记点击关注我们。关注不仅能让您第一时间获取最新的技术资讯和应用指南,还能帮助我们为您提供更优质的内容。此外,您也可以扫描下方的二维码,加入我们的交流社群。群内有众多AI技术爱好者和专业人士,大家可以在这里分享经验、解决疑问、共同进步。

期待与您在社群中交流,我们下期再见!