- 1AI绘画:数字时代的提示工程新兴应用_新兴领域ai制图等

- 2学习taro+react从0-1完整版5/7 --- 实现tabBar效果_taro 自定义tabbar

- 3ue4 行为树_simpleparallel

- 4一切皆是映射:自然语言处理(NLP)中的AI技术_自然语言处理、语言论证等其他ai领域

- 5主流框架选择:React、Angular、Vue的详细比较_vue angular react比较

- 6【顶级快刊】IEEE(Trans),审稿快仅2个月录用,入选CCF-B,现在投最快!_ieee trans期刊

- 7【智绘未来】气候变局中的智慧之眼:机器学习赋能气候变化预测与缓解

- 8研究生写爬虫险些锒铛入狱,起因竟是为爱冲锋?_写爬虫的违法还是用的人违法

- 9OpenCV与AI深度学习 | 实战 | YOLOv8自定义数据集训练实现手势识别 (标注+训练+预测 保姆级教程)_yolov8手势识别

- 10那些程序员们后知后觉的职涯经验_后知后觉 预判

Spark大数据分析与实战:基于Spark MLlib 实现音乐推荐_基于spark的音乐(1)_《spark大数据分析与实战》项目七sparkml实现电影获取目标用户数据 196推荐

赞

踩

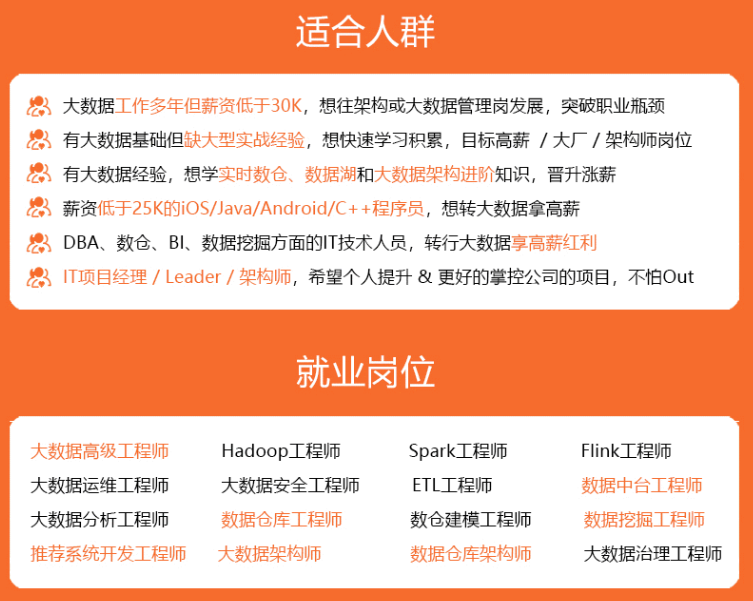

先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

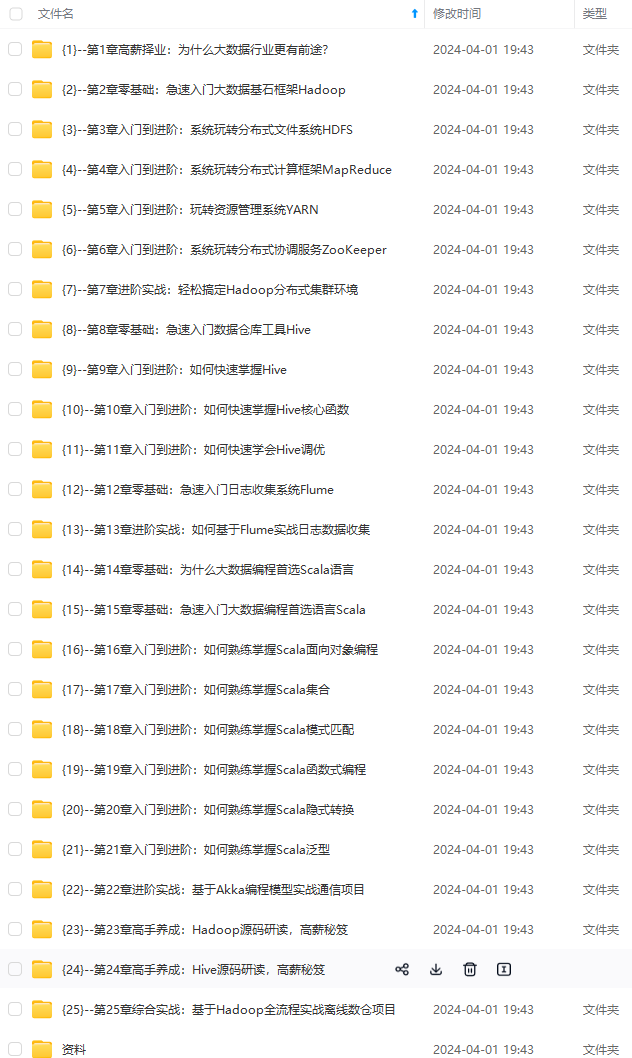

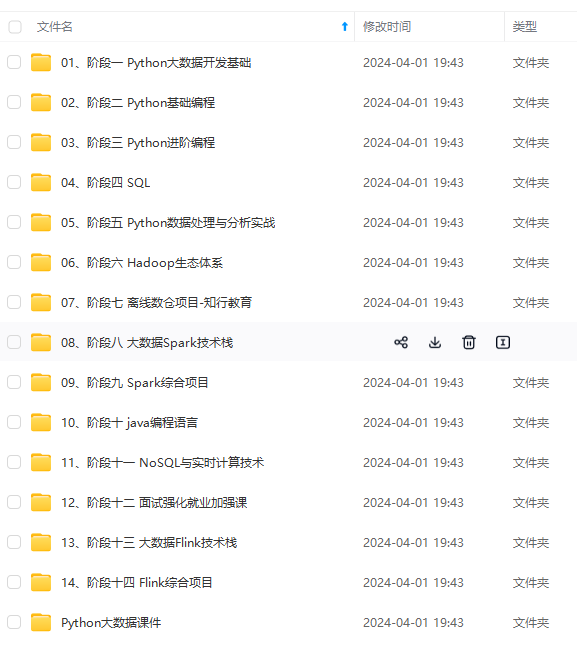

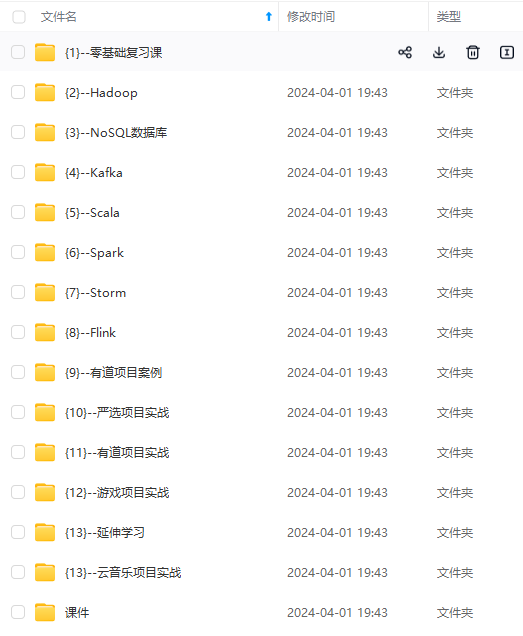

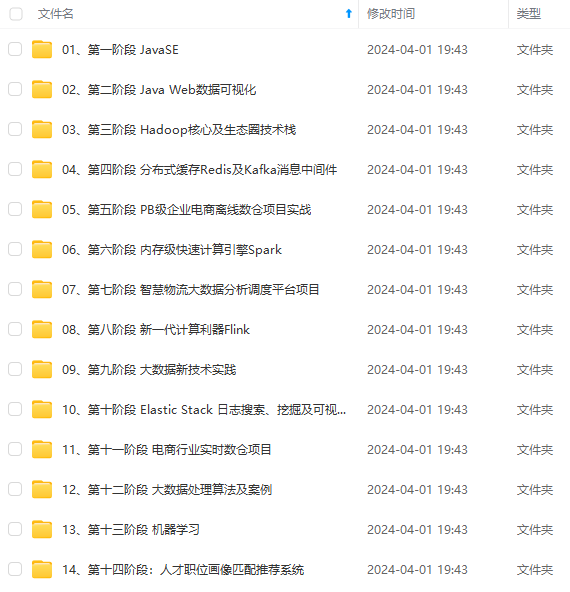

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

计算AUC评分最高的参数

利用AUC评分最高的参数,给用户推荐艺术家

对多个用户进行艺术家推荐

利用AUC评分最高的参数,给艺术家推荐喜欢他的用户

三、实验步骤:

- 安装Hadoop和Spark

- 启动Hadoop与Spark

- 将文件上传到 HDFS

- 实现音乐推荐

四、实验过程:

1、安装Hadoop和Spark

具体的安装过程在我以前的博客里面有,大家可以通过以下链接进入操作:

Hadoop的安装:https://blog.csdn.net/weixin_47580081/article/details/108647420

Scala及Spark的安装:https://blog.csdn.net/weixin_47580081/article/details/114250894

提示:如果IDEA未构建Spark项目,可以转接到以下的博客:

IDEA使用Maven构建Spark项目:https://blog.csdn.net/weixin_47580081/article/details/115435536

2、启动Hadoop与Spark

查看3个节点的进程

master

slave1

slave2

3、将文件上传到 HDFS

Shell命令:

[root@master ~]# cd /opt/data/profiledata\_06-May-2005/

[root@master profiledata\_06-May-2005]# ls

[root@master profiledata\_06-May-2005]# hadoop dfs -put artist\_alias.txt artist\_data.txt user\_artist\_data.txt /spark/input

- 1

- 2

- 3

- 4

4、实现音乐推荐

源代码:

package com.John.SparkProject import org.apache.spark.SparkConf import org.apache.spark.broadcast.Broadcast import org.apache.spark.ml.recommendation.{ ALS, ALSModel} import org.apache.spark.sql.functions._ import org.apache.spark.sql.{ DataFrame, Dataset, SparkSession} import scala.collection.mutable.ArrayBuffer import scala.util.Random /\*\* \* @author John \* @Date 2021/5/25 12:49 \*/ object project02 { def main(args: Array[String]): Unit = { /\*\* \* 前期环境配置以及数据准备 \*/ // 创建一个SparkSession对象 val conf = new SparkConf() .setMaster("local[2]") .setAppName("Project02\_RecommenderApp") .set("spark.sql.crossJoin.enabled", "true") val spark = new SparkSession.Builder() .config(conf) .getOrCreate() import spark.implicits._ // 导入 artist\_data.txt 文件 (每个艺术家的 ID 和对应的名字) // 字段名分别是: artistid artist\_name val rawArtistData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/artist\_data.txt") val artistIdDF = transformArtistData(rawArtistData) val artistIdDFtest = transformArtistData1(rawArtistData) // 导入 artist\_alias.txt 文件 (将拼写错误的艺术家 ID 或ID 变体对应到该艺术家的规范 ID) // 字段名分别是: badid goodid val rawAliasData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/artist\_alias.txt") val artistAlias = transformAliasData(rawAliasData).collect().toMap // 导入 user\_artist\_data.txt 文件 (用户音乐收听数据) // 字段名分别是 userid artistid playcount val rawUserArtistData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/user\_artist\_data.txt") // 整合数据 val allDF = transformUserArtistData(spark, rawUserArtistData, artistAlias) allDF.persist() // 拆分训练集和测试集 val Array(trainDF, testDF) = allDF.randomSplit(Array(0.9, 0.1)) trainDF.persist() // 查看一下指定 user 听过的艺术家 allDF.join(artistIdDFtest,"artist").select("name").filter("user='2093760'").show(5) /\*\* \* 根据题目要求参数 \* 给用户推荐艺术家 \*/ // // 根据题目要求构建模型 // val als = new ALS() // .setSeed(Random.nextLong()) // .setImplicitPrefs(true) // .setRank(10) // 模型潜在因素个数 // .setRegParam(0.01) // 正则化参数 // .setAlpha(1.0) // 管理偏好观察值的 基线置信度 // .setMaxIter(5) // 最大迭代次数 // .setUserCol("user") // .setItemCol("artist") // .setRatingCol("count") // .setPredictionCol("prediction") // // 用训练数据训练模型 // val model = als.fit(trainDF) // // 释放缓存资源 // trainDF.unpersist() // // 开始推荐 // val userID = 2093760 // val artistNum = 5 // val recommendDF = recommend(model, userID, artistNum, artistIdDF) // // val strings = recommendDF.map(\_.mkString("|")).collect() // println(strings.toBuffer) /\*\* \* 计算AUC评分最高的参数 \* 原理:循环指定参数暴力计算,根据AUC计算出评分最高的参数进行建模 \*/ // // 艺术家id数据,用于AUC评分 // val allArtistIds = allDF.select("artist").as[Int].distinct().collect() // val bAllArtistIds = spark.sparkContext.broadcast(allArtistIds) // // // 网格搜索 // val evaluations = // // 利用for循环,生成不同的超参数配置 // for (rank <- Seq(5, 30); // regParam <- Seq(4.0, 0.0001); // alpha <- Seq(1.0, 40.0)) // yield { // // 构建模型 // val als = new ALS() **网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。** **需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)**  **一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!** 究,那么很难做到真正的技术提升。** **需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)** [外链图片转存中...(img-2sTxoEaF-1713324293246)] **一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

- 115

- 116

- 117

- 118

- 119

- 120

- 121

- 122

- 123

- 124