热门标签

热门文章

- 1猿创征文|TiDB 开源分布式关系型数据库介绍及部署_开源分布式数据库推荐

- 2大模型:深度学习领域的“巨无霸”_深度学习 大模型

- 3【大模型搭建】部署Ollama,pull失败,手动构建方案_ollama pull timeout

- 4谷粒商城-分布式高级篇[商城业务-秒杀服务]_谷粒商城中信号量在哪里使用

- 5vue中如何使用axios_vue中使用nprm下载axios

- 6linux突破git clone下载限制_xn--4gq

- 7数据仓库_拉链表_拉链表实现思路

- 8Kafka Producer之幂等性

- 9产品经理工作流程_产品经理培训产品流程

- 10CPU与GPU渲染的差异有哪些?最佳3D渲染 GPU推荐_cuda核心数量对渲染有帮助吗

当前位置: article > 正文

分类预测 | Matlab实现GWO-CNN-SVM灰狼冰算法优化卷积支持向量机分类预测

作者:代码探险家 | 2024-07-10 16:34:53

赞

踩

分类预测 | Matlab实现GWO-CNN-SVM灰狼冰算法优化卷积支持向量机分类预测

分类预测 | Matlab实现GWO-CNN-SVM灰狼冰算法优化卷积支持向量机分类预测

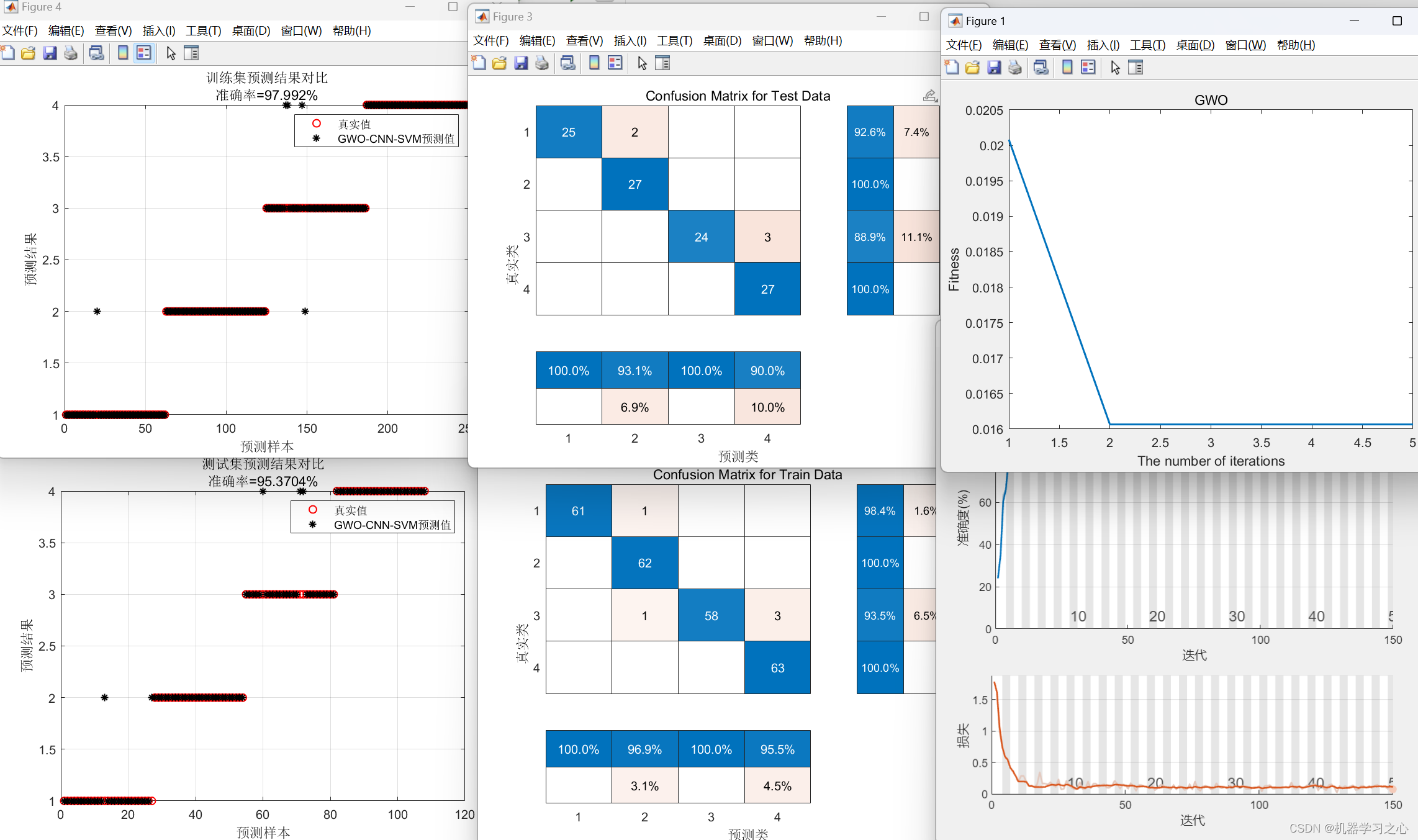

分类效果

基本描述

1.Matlab实现GWO-CNN-SVM灰狼冰算法优化卷积支持向量机分类预测(完整源码和数据)

2.优化参数为:学习率,批量处理大小,正则化参数。

3.图很多,包括分类效果图,混淆矩阵图。

4.附赠案例数据可直接运行main一键出图~

注意程序和数据放在一个文件夹,运行环境为Matlab2020及以上。

5.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。

6.输入多个特征,分四类。

程序设计

- 完整程序和数据获取方式资源处下载Matlab实现GWO-CNN-SVM灰狼冰算法优化卷积支持向量机分类预测

%% 优化算法参数设置

SearchAgents_no = 8; % 数量

Max_iteration = 5; % 最大迭代次数

%% 建立模型

lgraph = layerGraph(); % 建立空白网络结构

tempLayers = [

sequenceInputLayer([num_dim, 1, 1], "Name", "sequence") % 建立输入层,输入数据结构为[num_dim, 1, 1]

sequenceFoldingLayer("Name", "seqfold")]; % 建立序列折叠层

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中

tempLayers = [

convolution2dLayer([3, 1], 16, "Name", "conv_1", "Padding", "same") % 建立卷积层,卷积核大小[3, 1],16个特征图

reluLayer("Name", "relu_1") % Relu 激活层

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中

tempLayers = [

sequenceUnfoldingLayer("Name", "sequnfold") softmaxLayer("Name", "softmax") % softmax激活层

classificationLayer("Name", "classification")]; % 分类层

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中

lgraph = connectLayers(lgraph, "seqfold/out", "conv_1"); % 折叠层输出 连接 卷积层输入

lgraph = connectLayers(lgraph, "seqfold/miniBatchSize", "sequnfold/miniBatchSize");

% 折叠层输出连接反折叠层输入

lgraph = connectLayers(lgraph, "relu_2", "sequnfold/in"); % 激活层输出 连接 反折叠层输入

%% 参数设置

options = trainingOptions('adam', ... % Adam 梯度下降算法

'MaxEpochs', 500,... % 最大训练次数

'InitialLearnRate', best_lr,... % 初始学习率为0.001

'L2Regularization', best_l2,... % L2正则化参数

'LearnRateSchedule', 'piecewise',... % 学习率下降

'LearnRateDropFactor', 0.1,... % 学习率下降因子 0.1

'LearnRateDropPeriod', 400,... % 经过训练后 学习率为 0.001*0.1

'Shuffle', 'every-epoch',... % 每次训练打乱数据集

'ValidationPatience', Inf,... % 关闭验证

'Plots', 'training-progress',... % 画出曲线

'Verbose', false);

%% 训练

net = trainNetwork(p_train, t_train, lgraph, options);

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129036772?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/kjm13182345320/article/details/128690229

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/代码探险家/article/detail/806924

推荐阅读

相关标签