热门标签

热门文章

- 1解读百度⽂⼼⼀⾔_ai

- 2彻底关闭烦人的---FF新推荐

- 3QAnything 1.4.1 中的文档解析_qanything pdf解析

- 4【微命令】git config如何配置全局的用户和邮箱?(--global user.name、user.email;git config --help)_git config --global email

- 52024年Python人工智能学习路线_python ai学习,大厂的面试官_2024年python开发人工智能还需要什么呢

- 6mac protobuf java_Mac安装Protobuf编译Java

- 7kafka相关操作及问题汇总_error in ch.qos.logback.core.rolling.rollingfileap

- 8【OpenCv光流法进行运动目标检测】_光流法 opencv 测速

- 9对于软件外包的理解

- 10Sora是什么?究竟如何使用?_sora中文站

当前位置: article > 正文

【wails】(10):研究go-llama.cpp项目,但是发现不支持最新的qwen大模型,可以运行llama-2-7b-chat_unknown model architecture: 'qwen2

作者:代码探险家 | 2024-07-19 10:52:13

赞

踩

unknown model architecture: 'qwen2

1,视频演示地址

2,项目地址go-llama.cpp

下载并进行编译:

git clone --recurse-submodules https://github.com/go-skynet/go-llama.cpp

cd go-llama.cpp

make libbinding.a

- 1

- 2

- 3

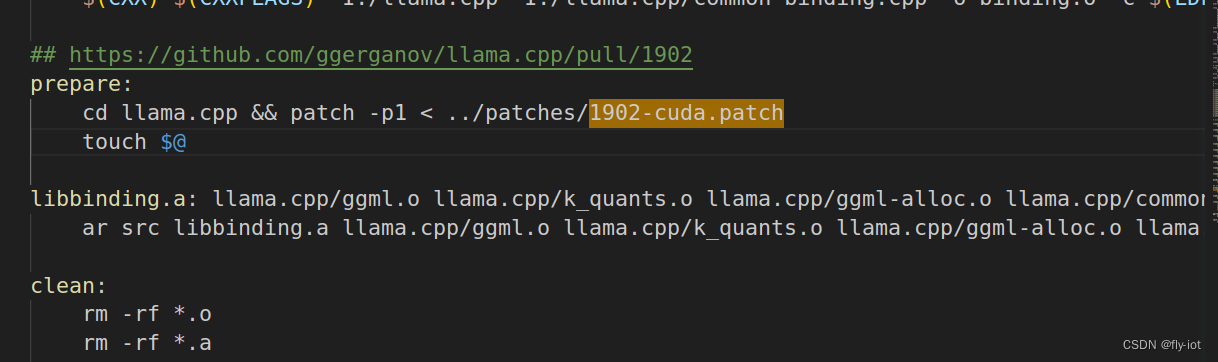

项目中还打了个补丁:

给

编译成功,虽然有一点 warning 警告信息,问题不大。

3,然后运行 llama-2-7b-chat 模型

LIBRARY_PATH=$PWD C_INCLUDE_PATH=$PWD go run ./examples -m "/data/home/test/hf_cache/llama-2-7b-chat.Q2_K.gguf" -t 14

LIBRARY_PATH=$PWD C_INCLUDE_PATH=$PWD go run ./examples -m "/data/home/test/hf_cache/qwen1_5-0_5b-chat-q6_k.gguf" -t 14

- 1

- 2

- 3

- 4

- 5

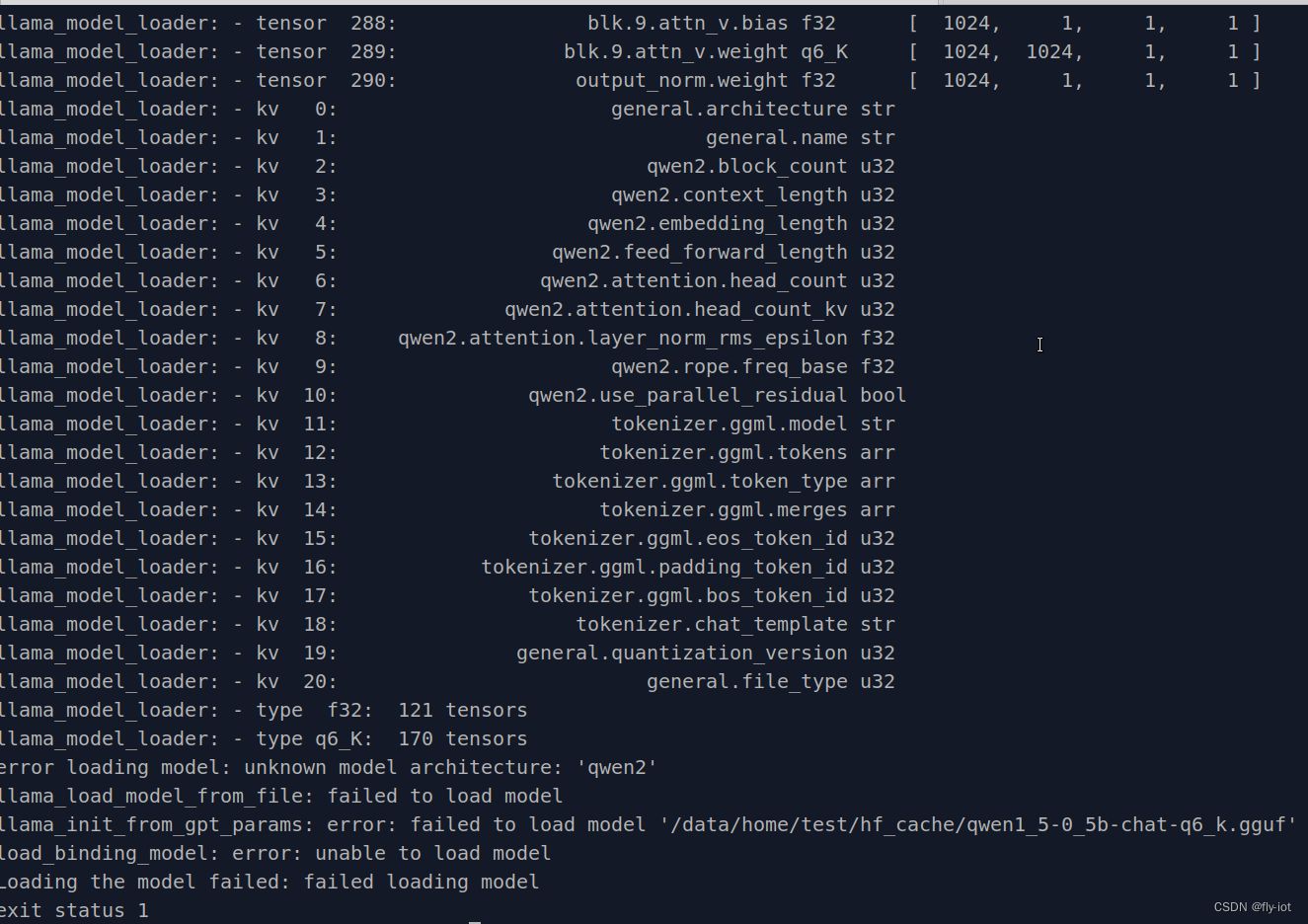

error loading model: unknown model architecture: 'qwen2'

llama_load_model_from_file: failed to load model

llama_init_from_gpt_params: error: failed to load model '/data/home/test/hf_cache/qwen1_5-0_5b-chat-q6_k.gguf'

load_binding_model: error: unable to load model

Loading the model failed: failed loading model

- 1

- 2

- 3

- 4

- 5

- 6

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/代码探险家/article/detail/851070

推荐阅读

相关标签