- 1C# 利用 UI 自动化框架与应用程序的用户界面进行交互来模拟点击按钮_c# ui自动化

- 2python爬取携程旅行网景点评论_携程评论爬取

- 3AIGC基于文本生成音乐,现在压力来到配乐行业这边|Github

- 4写一个判素数的函数,在主函数输入一个整数,输出是否为素数的信息_编写一个判定素数的函数,在主函数输入一个整数

- 55G移动通信网络整体架构_5g网络架构

- 6ZA303学习笔记九部署和管理Azure计算资源 Azure AD/配置MFA_微信小程序跟azure ad mfa

- 7文本数据清洗:去除噪声,提升模型性能_给文本去噪

- 8C语言 基本数据类型及大小

- 9Stable Diffusion WebUI 中文提示词插件 sd-webui-prompt-all-in-one

- 10python爬虫豆瓣读书top250+数据清洗+数据库+Java后端开发+Echarts数据可视化(一)_基于爬虫,数据清洗,echars数据可视化的项目

Grok----马斯克开源的AI大模型_grok ai下载

赞

踩

背景说明

惊喜不,意外不?马斯克又开始搞事情了,在当地时间2024年的3月17日,马斯克的AI创企xAI宣布正式开源混合专家AI大模型Grok-1,以及该模型的权重和网络架构,并向公众开放下载,免费还可商用,国内AI技术即将迎来重大突破。早在几天前3月11号,马斯克就曾说过要开源,果然是说到做到,很讲究信用啊。

模型介绍

Grok-1是一款基于混合专家系统(Mixture-of-Experts,MoE)技术构建的大语言模型,拥有3140亿参数,远超OpenAI GPT-3.5的1750亿。是迄今参数量最大的开源大语言模型,遵照Apache 2.0协议(因此,用户可以自由使用、修改和分发软件。)开放模型权重和架构。3140亿的参数这可是个不小的概念,是Llama 2的4倍。目前官网放出的信息如下:

- 基础模型在大量文本数据上训练,未针对任何特定任务进行微调。

- 314B参数的MoE,有25%的权重在给定token上处于激活状态。

- 2023年10月,xAI使用JAX和Rust之上的自定义训练堆栈从头开始训练。

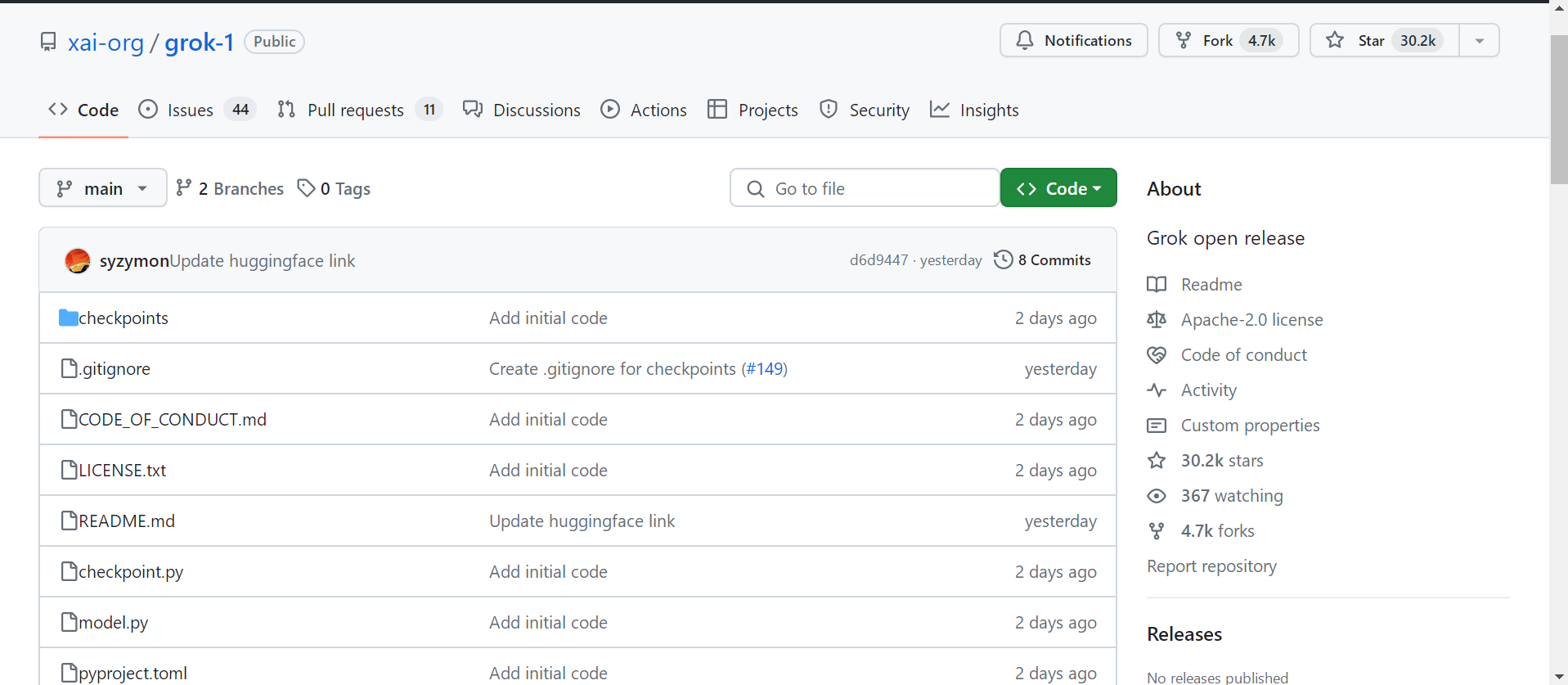

- 一经上线GitHub,Grok就狂揽了6k星,586个Fork。

项目的具体Github地址如下:https://github.com/xai-org/grok-1

环境搭建

下面介绍的内容仅是参考github说明给出的搭建环境的构思,由于没有高配GPU机器,并没有亲自搭建,读者仅供参考。

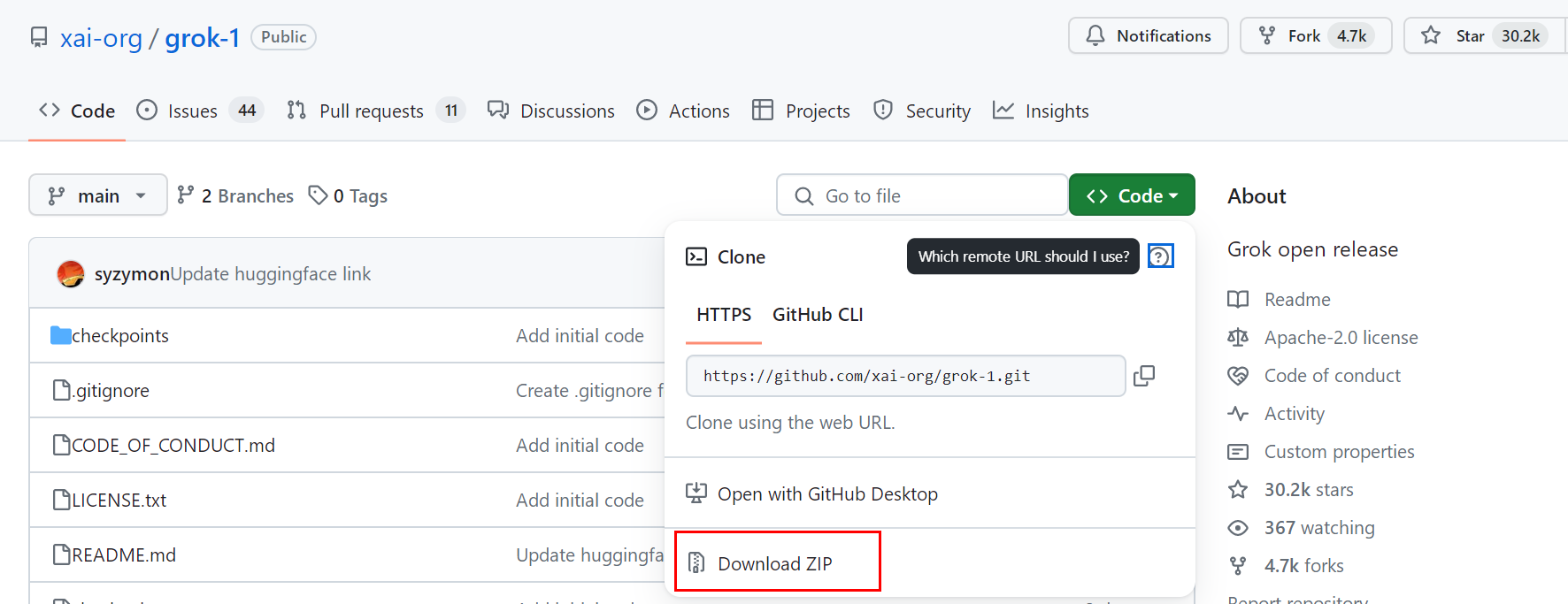

1.项目下载

直接在上面给出的项目地址中打开,进入github界面即可,点击右侧绿色的Code-->Download

下载到相应的路径文件夹下即可,代码文件不大,仅有1M左右。

2.python环境安装及调试

直接按照说明配置相应的python环境:pip install -r requirements.txt

然后进行代码测试看一下提示进行相应调试:python run.py

很明确的告诉你,你是运行不了的!!!!!为什么呢?因为你代码中没有相应的模型呀,所以下载模型去。

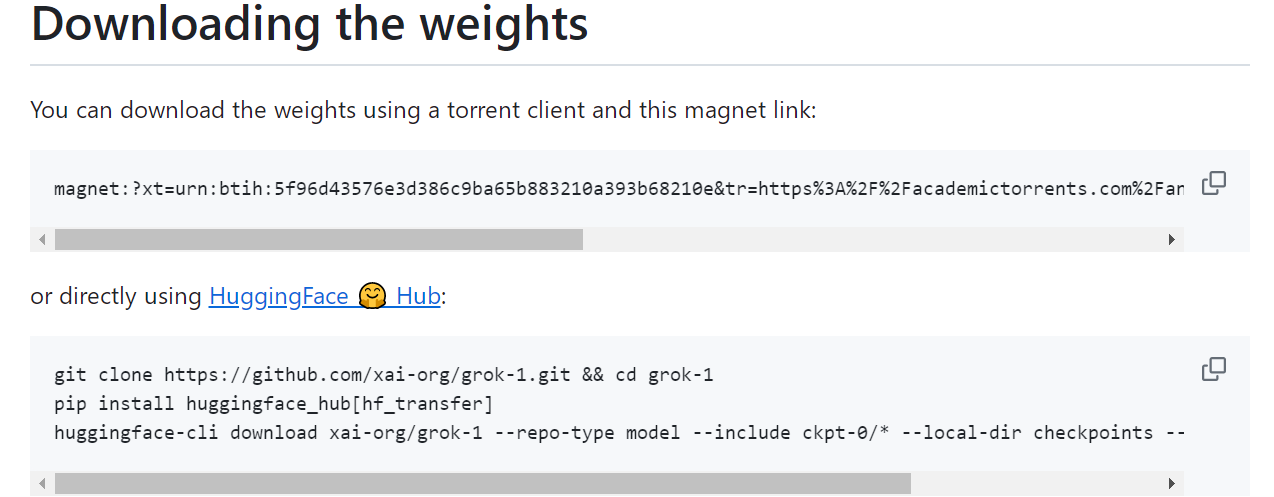

3. 模型下载

官网提供了两种下载方式,第二种没怎么看懂也没有用过,建议使用第一种方式下砸吧。

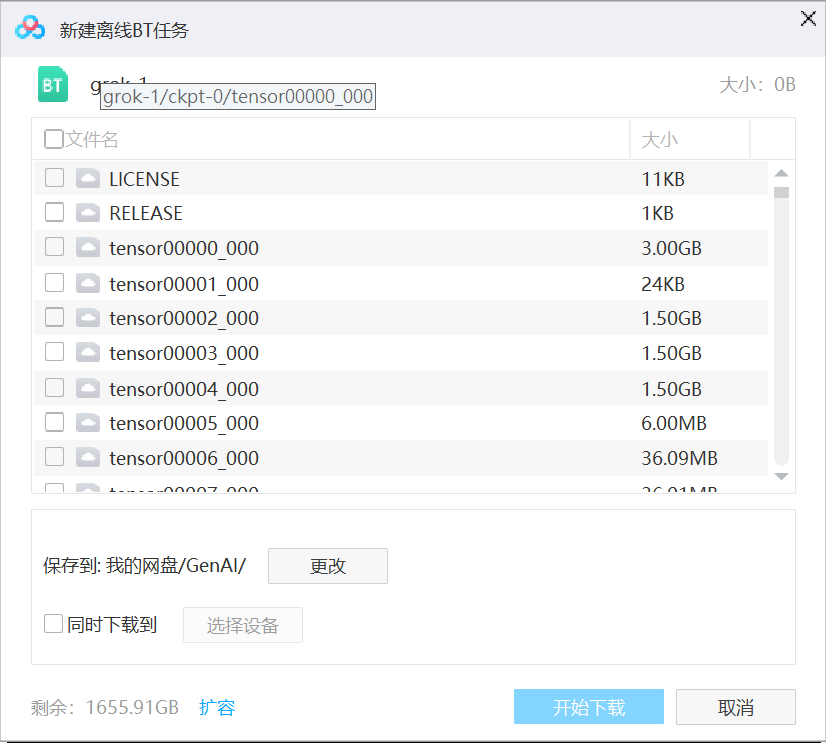

下载 checkpoint,使用百度网盘–种子–离线下载,地址:

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents

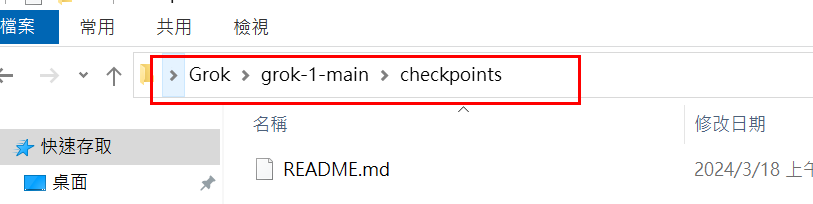

选择中所有文件,开始下载,等待下载完成后放入代码中的模型文件夹中即可。

选择中所有文件,开始下载,等待下载完成后放入代码中的模型文件夹中即可。

4.几个待解决问题

- 实际下载模型的时候才知道,模型使用元数据存储在分布式数据库中,大小将近300个G,哎,搞睡了,这么大的玩意,下载费劲,存储也费劲。下载过程容易中断或者失败,愁人。

- 由于模型较大,参数达到了314B参数,因此需要具有足够GPU内存的计算机,才能使用示例代码测试模型,估计至少需要拥有

628GB GPU内存以上的机器才可以运行(烧钱的玩意啊,得买多少张发烧级显卡啊,欲哭无泪)。而且,由于此存储库中MoE层的实现效率不高,选择该实现是为了避免需要自定义内核来验证模型的正确性。