热门标签

热门文章

- 1常规波束形成——时域与频域常规窄带波束形成、信噪比计算(附代码)

- 2OAuth2基础篇

- 3【PCL自学:I/O】PCD点云格式及输入输出模块(I/O)介绍(持续更新)_输入点云和输出点云 英文

- 4iOS加载webview时出现内存泄露导致闪退_ios webview调用input输入法闪退

- 5【Matlab】Matlab电话拨号音合成与识别(代码+论文)【独一无二】

- 6华为笔试题目100及最佳答案,华为笔试题库与答案_华为在线笔试

- 7网络安全思考题

- 8Matplotlib基础学习笔记_plt.scatter没有图框

- 9头歌|MySQL数据库 - 初识MySQL|第1关:创建数据库_头哥mysql第一关:创建并管理数据库

- 1022-07-18 西安 RabbitMQ (01) RabbitMQ安装、控制控制台界面、RabbitMQ五种模式_rabbitmq 控制台

当前位置: article > 正文

OCR-easyocr初识

作者:你好赵伟 | 2024-05-19 15:55:01

赞

踩

easyocr

一、介绍

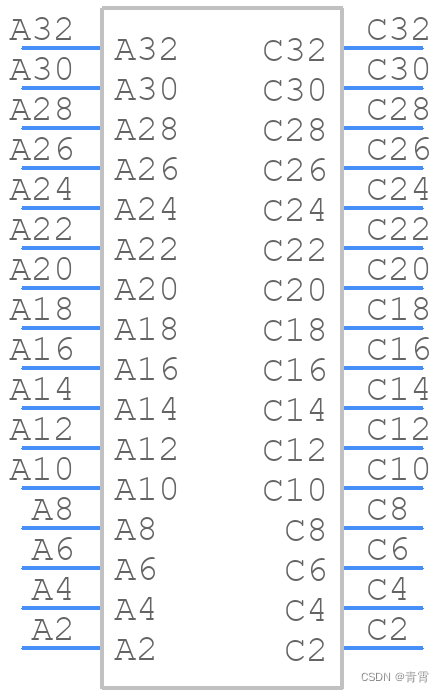

批量文字识别(OCR)是Python办公自动化的基本操作,应用在我们工作生活中的方方面面,比如车牌识别、证件识别、银行卡识别、票据识别等等。

Python中OCR第三方库非常多,比如easyocr、PaddleOCR、cnocr等等。

EasyOCR 是一个用 Python 编写的 OCR 库,用于识别图像中的文字并输出为文本,支持 80 多种语言。

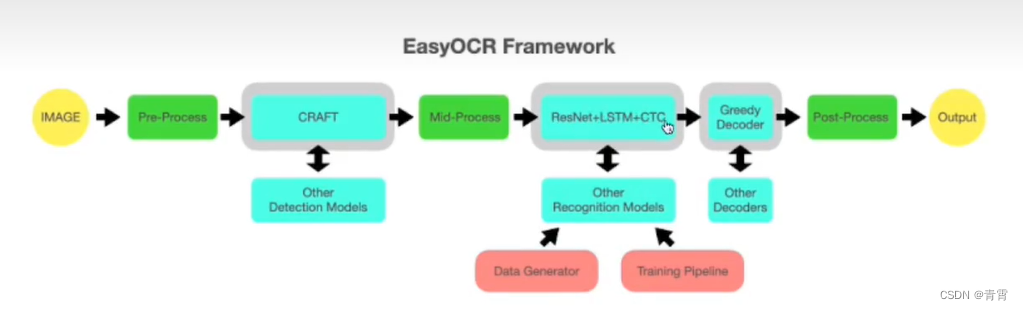

检测部分使用CRAFT算法,识别模型为CRNN,由3个组件组成:特征提取Resnet、序列标记LSTM、解码CTC。整个深度学习过程基于pytorch实现。

图片--预处理(去噪、色彩饱和度、尖锐处理等)--文字检测(CRAFT)--中间处理(倾斜处理等)---文字识别---后续处理---输出结果

二、安装

pip3 install -i https://pypi.tuna.tsinghua.edu.cn/simple easyocr

模型储存路径:

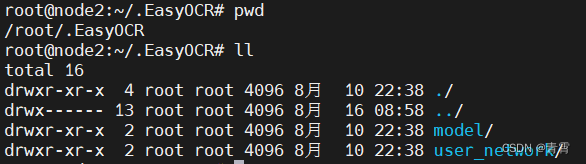

windows: C:\Users\username\.EasyOCR\linux:/root/.EasyOCR/

easyocr 的深度学习算法依赖于另一个著名的第三方模块 pytorch,图形处理部分则会用到 opencv、Pillow 等,所以还需要确保自己电脑上已经安装这些基础模块。

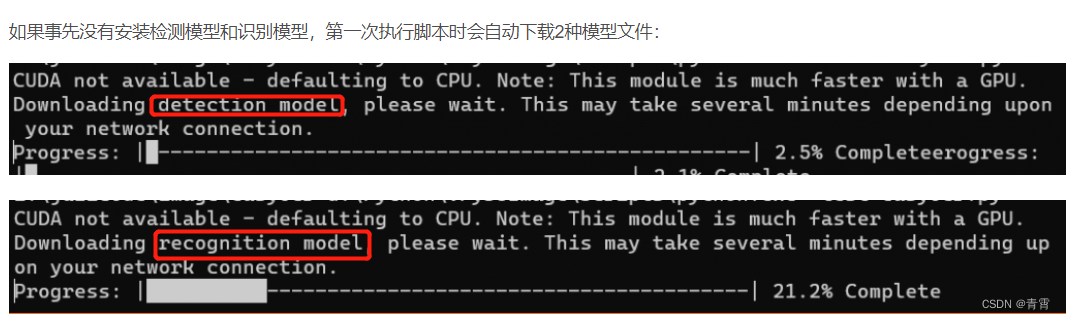

首次使用easyocr识别图片,会自动从网络中下载预训练模型。下载耗时较长,而且大概率遇到URLError错误,

推荐下载模型文件(下载链接:Jaided AI: EasyOCR model hub),不用解压直接复制粘贴于~/.EasyOCR/model/目录下。

三、API文档

3.1、easyocr.Reader class:

参数:

-

lang_list (list) - 识别的语言代码列表,例如 ['ch_sim','en']

-

gpu (bool, string, default = True) - 启用 GPU

-

model_storage_directory (string, default = None) - 模型数据目录的路径。如果未指定,将从环境变量 EASYOCR_MODULE_PATH(首选)、MODULE_PATH(如果已定义)或 ~/.EasyOCR/ 定义的目录中读取模型。

-

download_enabled (bool, default = True) - 如果 EasyOCR 无法找到模型文件,则启用下载;

-

user_network_directory (bool, default = None) - 用户模型存储的路径。如果未指定,将从 MODULE_PATH + '/user_network' (~/.EasyOCR/user_network) 读取模型;

-

recog_network (string, default = 'standard') - 用户模型、模块和配置文件的名称;

-

detector (bool, default = True) - 将检测模型加载到内存中

-

recognizer (bool, default = True) - 将识别模型加载到内存中

属性:

-

lang_char - 显示当前模型中的所有可用字符

3.2、reader.readtext()

Reader对象的主要方法。有 4 组参数:General、Contrast、Text Detection 和 Bounding Box Merging。

参数1:General

-

image (string, numpy array, byte) - 输入图像;

-

decoder (string, default = 'greedy')- 选项有 'greedy'、'beamsearch' 和 'wordbeamsearch';

-

beamWidth (int, default = 5) - 当解码器 = 'beamsearch' 或 'wordbeamsearch' 时要保留多少光束;

-

batch_size (int, default = 1) - batch_size>1 将使 EasyOCR 更快但使用更多内存;

-

worker (int, default = 0) - 数据加载器中使用的编号线程;

-

allowlist (string) - 强制 EasyOCR 只识别字符的子集。对特定问题有用(例如车牌等);

-

blocklist (string) - 字符的块子集。如果给定了允许列表,则此参数将被忽略。

-

detail (int, default = 1) - 将此设置为 0 以进行简单输出;

-

paragraph (bool, default = False) - 将结果合并到段落中;

-

min_size (int, default = 10) - 过滤文本框小于最小值(以像素为单位);

-

rotation_info (list, default = None) - 允许 EasyOCR 旋转每个文本框并返回具有最佳置信度分数的文本框。符合条件的值为 90、180 和 270。例如,对所有可能的文本方向尝试 [90, 180 ,270]。

参数2:Contrast 对比度

-

contrast_ths (float, default = 0.1) - 对比度低于此值的文本框将被传入模型 2 次。首先是原始图像,其次是对比度调整为“adjust_contrast”值。结果将返回具有更高置信度的那个;

-

adjust_contrast (float, default = 0.5) - 低对比度文本框的目标对比度级别。

参数3:Text Detection 文本检测(来自CRAFT)

-

text_threshold (float, default = 0.7) - 文本置信度阈值

-

low_text (float, default = 0.4) - 文本下限分数

-

link_threshold (float, default = 0.4) - 链接置信度阈值

-

canvas_size (int, default = 2560) - 最大图像尺寸。大于此值的图像将被缩小。

-

mag_ratio (float, default = 1) - 图像放大率

参数4:Bounding Box Merging 边界框合并

这组参数控制相邻边界框何时相互合并。除了 'slope_ths' 之外的所有参数都以盒子高度为单位。

-

slope_ths (float, default = 0.1) - 考虑合并的最大斜率 (delta y/delta x)。低值意味着不会合并平铺框。

-

ycenter_ths (float, default = 0.5) - y 方向的最大偏移。不应该合并不同级别的框。

-

height_ths (float, default = 0.5) - 盒子高度的最大差异。不应合并文本大小非常不同的框。

-

width_ths (float, default = 0.5) - 合并框的最大水平距离。

-

add_margin (float, default = 0.1) - 将边界框向所有方向扩展某个值。这对于具有复杂脚本的语言(例如泰语)很重要。

-

x_ths (float, default = 1.0) - 当段落=True 时合并文本框的最大水平距离。

-

y_ths (float, default = 0.5) - 当段落 = True 时合并文本框的最大垂直距离。

返回:结果列表

四、识别模型

4.1、训练识别模型

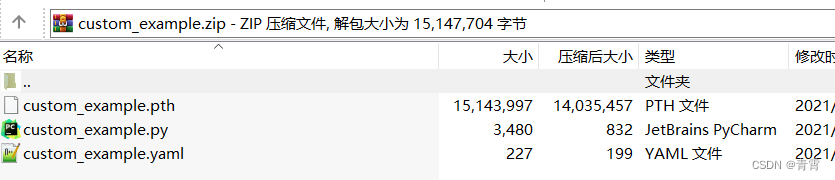

可以使用自己的数据或生成自己的数据集。要生成您自己的数据建议使用 TextRecognitionDataGenerator(GitHub - Belval/TextRecognitionDataGenerator: A synthetic data generator for text recognition)。我们在此处提供了一个数据集示例。拥有数据集后,您可以按照此存储库 deep-text-recognition-benchmark(https://github.com/clovaai/deep-text-recognition-benchmark)训练自己的模型。网络需要完全卷积才能预测灵活的文本长度。我们当前的网络是“None-VGG-BiLSTM-CTC”。一旦你有了训练好的模型(一个.pth文件),你需要两个额外的文件来描述识别网络架构和模型配置。此处custom_example.zip的文件中提供了一个示例。

我们还在此处提供我们的训练脚本版本。它是deep-text-recognition-benchmark的修改版本。

4.2、使用自定义的识别模型

需要三个文件,这三个文件必须共享相同的名称,即yourmodel.pth, yourmodel.yaml,yourmodel.py,然后您将使用它们在 EasyOCR API 中调用您的模型。

请下载custom_example.zip 作为示例,解压并放置custom_example.py,custom_example.yaml在user_network_directory(默认= ~/.EasyOCR/user_network),放置custom_example.pth在模型目录(默认= ~/.EasyOCR/model)。一旦你将所有3个文件放在各自的位置,你可以通过设置recog_network来使用custom_example:reader = easyocr.Reader(['en'], recog_network='custom_example')

五、使用

5.1、基本使用1

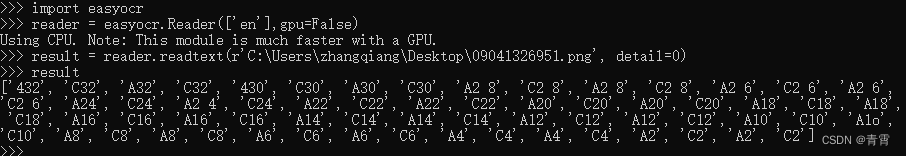

可以通过命令行使用如下:

$ easyocr -l ch_sim en -f chinese.jpg --detail=1 --gpu=True 5.2、基本使用2

- import easyocr

-

- reader = easyocr.Reader(

- lang_list=['ch_sim', 'en'], # 需要导入的语言识别模型,可以传入多个语言模型,其中英语模型en可以与其他语言共同使用

- gpu=False, # 默认为True

- download_enabled=True # 默认为True,如果 EasyOCR 无法找到模型文件,则启用下载

- )

-

- result = reader.readtext('id_card.jpg', detail=1 ) # 图片可以传入图片路径、也可以传入图片链接。但推荐传入图片路径,会提高识别速度。包含中文会出错。设置detail=0可以简化输出结果,默认为1

- print(result)

-

- readtext 返回的列表中,每个元素都是一个元组,内含三个信息:位置、文字、置信度:

- [

- ([[27, 37], [341, 37], [341, 79], [27, 79]], '姓 名 爱新觉罗 。玄烨', 0.6958897643232619),

- ([[29, 99], [157, 99], [157, 135], [29, 135]], '性 别 男', 0.914532774041559),

- ([[180, 95], [284, 95], [284, 131], [180, 131]], '民蔟满', 0.4622474180193509),

- ([[30, 152], [94, 152], [94, 182], [30, 182]], '出 生', 0.6015505790710449),

- ([[110, 152], [344, 152], [344, 184], [110, 184]], '1654 年54日', 0.42167866223467815),

- ([[29, 205], [421, 205], [421, 243], [29, 243]], '住 址 北京市东城区景山前街4号', 0.6362530289101117),

- ([[105, 251], [267, 251], [267, 287], [105, 287]], '紫禁城乾清宫', 0.8425745057905053),

- ([[32, 346], [200, 346], [200, 378], [32, 378]], '公民身份证号码', 0.22538012770296922),

- ([[218, 348], [566, 348], [566, 376], [218, 376]], '000003165405049842', 0.902066405195785)

- ]

-

- detail=0,从而只返回文字内容:

- ['姓 名 爱新觉罗 。玄烨', '性 别 男', '民蔟满', '出 生', '1654 年54日', '住 址 北京市东城区景山前街4号', '紫禁城 乾清宫', '公民身份证号码', '000003165405049842']

5.3、基本使用3

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/593620

推荐阅读

相关标签