- 12024 年 8 款最好的 Android 数据恢复应用程序和软件_minitool mobile recovery for android

- 2git push 提交操作出现 fatal: Authentication failed for 错误 解决方案_git push fatal: authentication failed for

- 3NodeJS 导入导出模块的方法( 代码演示 )_nodejs导出模块

- 4【Android】Android Studio安装教程+基础的使用方法_androidstudio安装

- 5硬件描述语言实验七:译码器实验_译码器实验报告实验数据

- 6阿里开源的15个顶级Java项目,你知道几个?_好的java项目

- 7Android ANR详解

- 8springBoot 启动 If you want an embedded database (H2, HSQL or Derby), please put it on the classpath.

- 9腾讯云智CSIG面试题目总结 - 2_腾讯云智测试面试题

- 10mount failed

CDH6.3.2-相关配置_cdh调整spark内存

赞

踩

相关配置

1.在阿里云环境下 Hadoop集群必须用域名访问,不能用IP访问,开启如下配置dfs.client.use.datanode.hostname

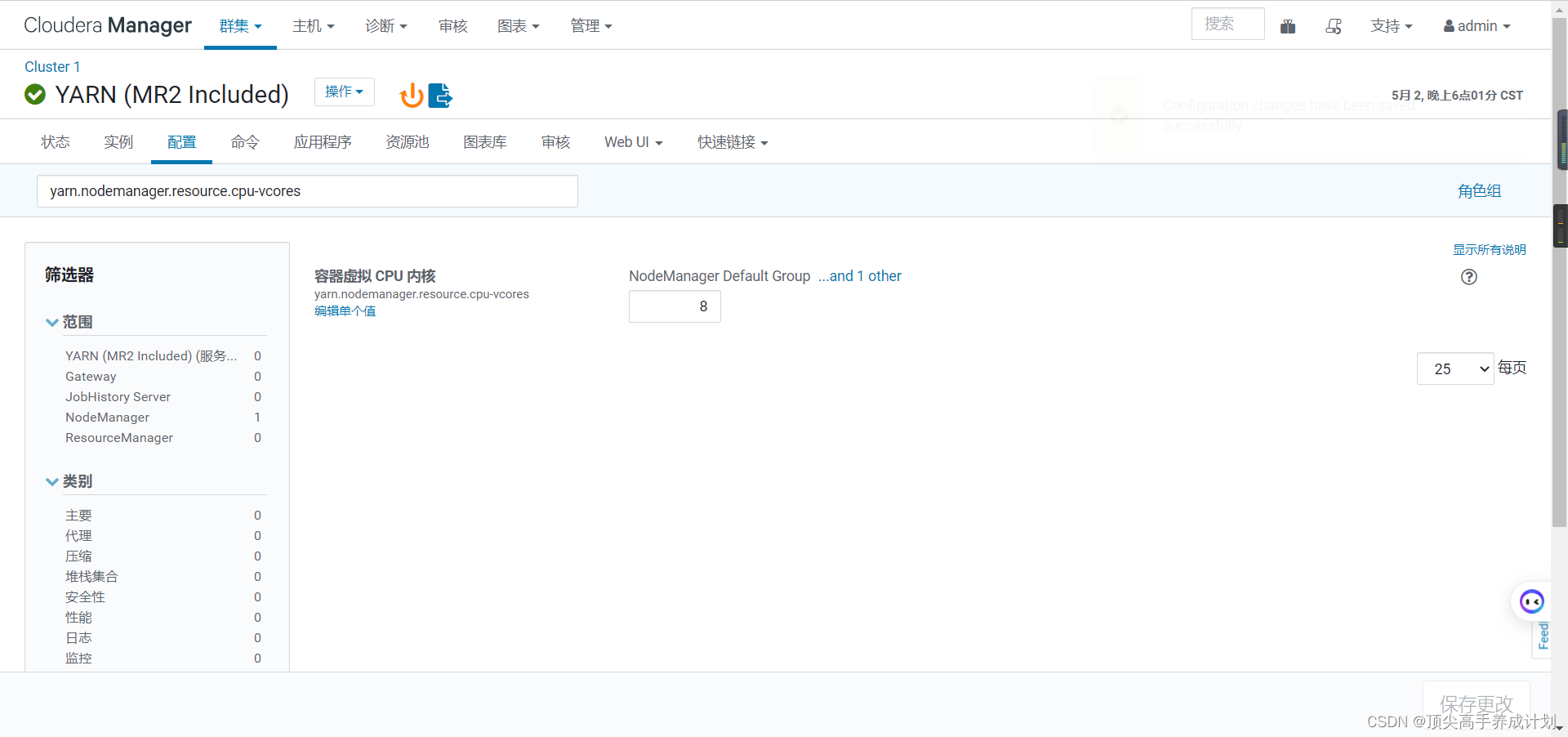

2.当前购买的阿里云配置物理核一共为20核,为演示效果将虚拟核扩大1倍,一般真实场景下物理核和虚拟核对比值为1:1或1:2。

修改配置,每台机器物理核4核虚拟成8核。yarn.nodemanager.resource.cpu-vcores

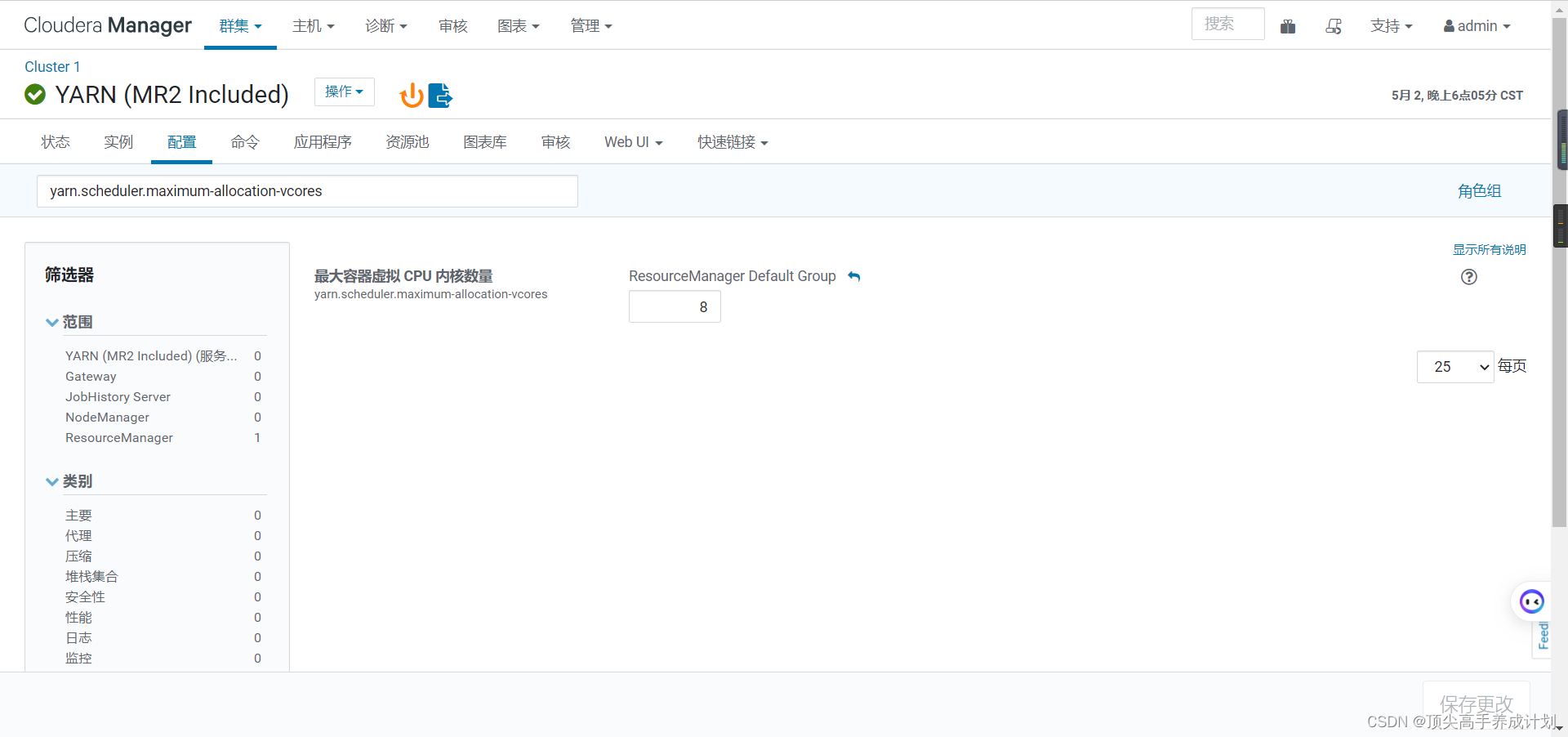

3.修改单个容器下最大cpu申请资源,修改yarn.scheduler.maximum-allocation-vcores参数调整8核。

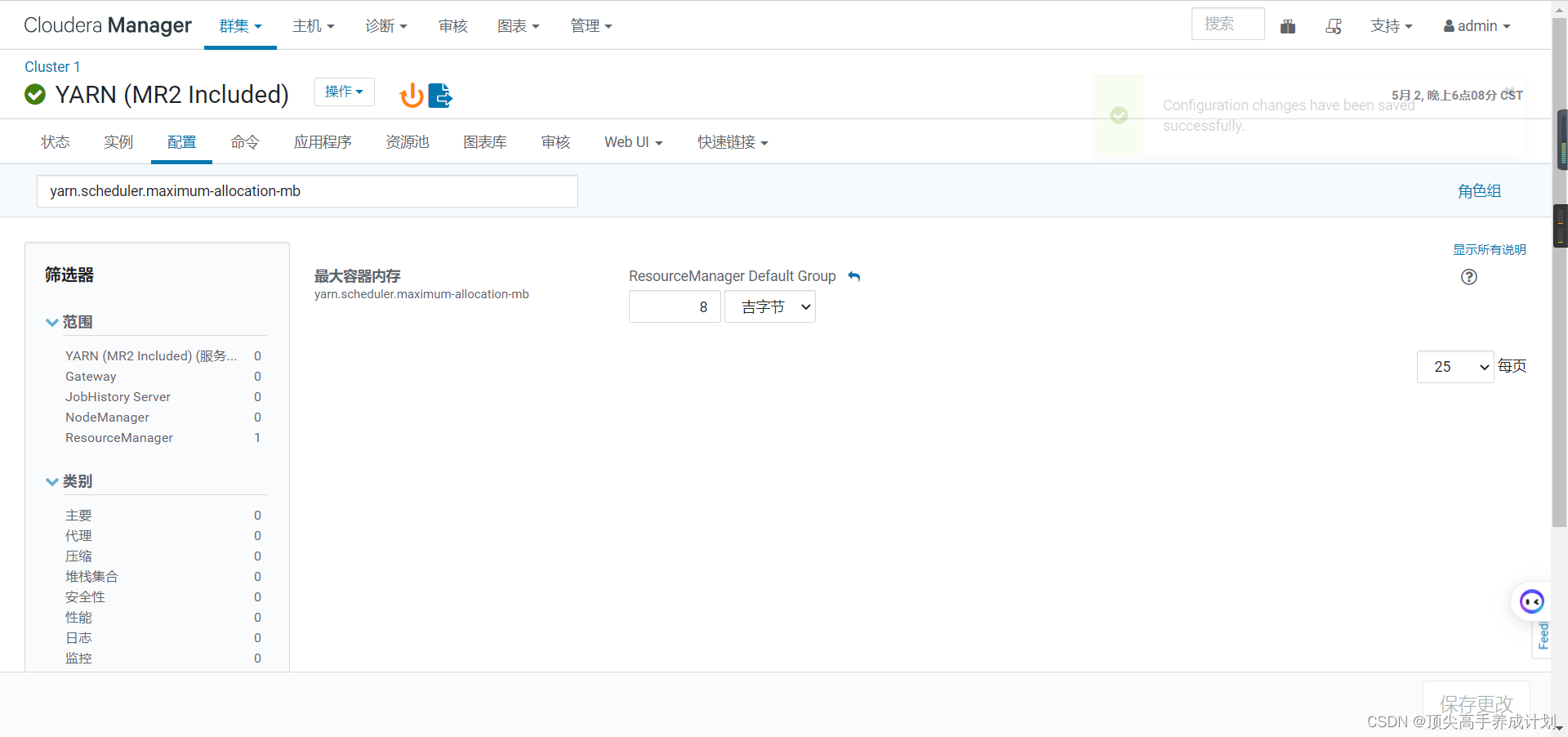

4.将每个任务容器默认大小从1G调大至8G,修改yarn.scheduler.maximum-allocation-mb 每个任务容器内存所需大小。

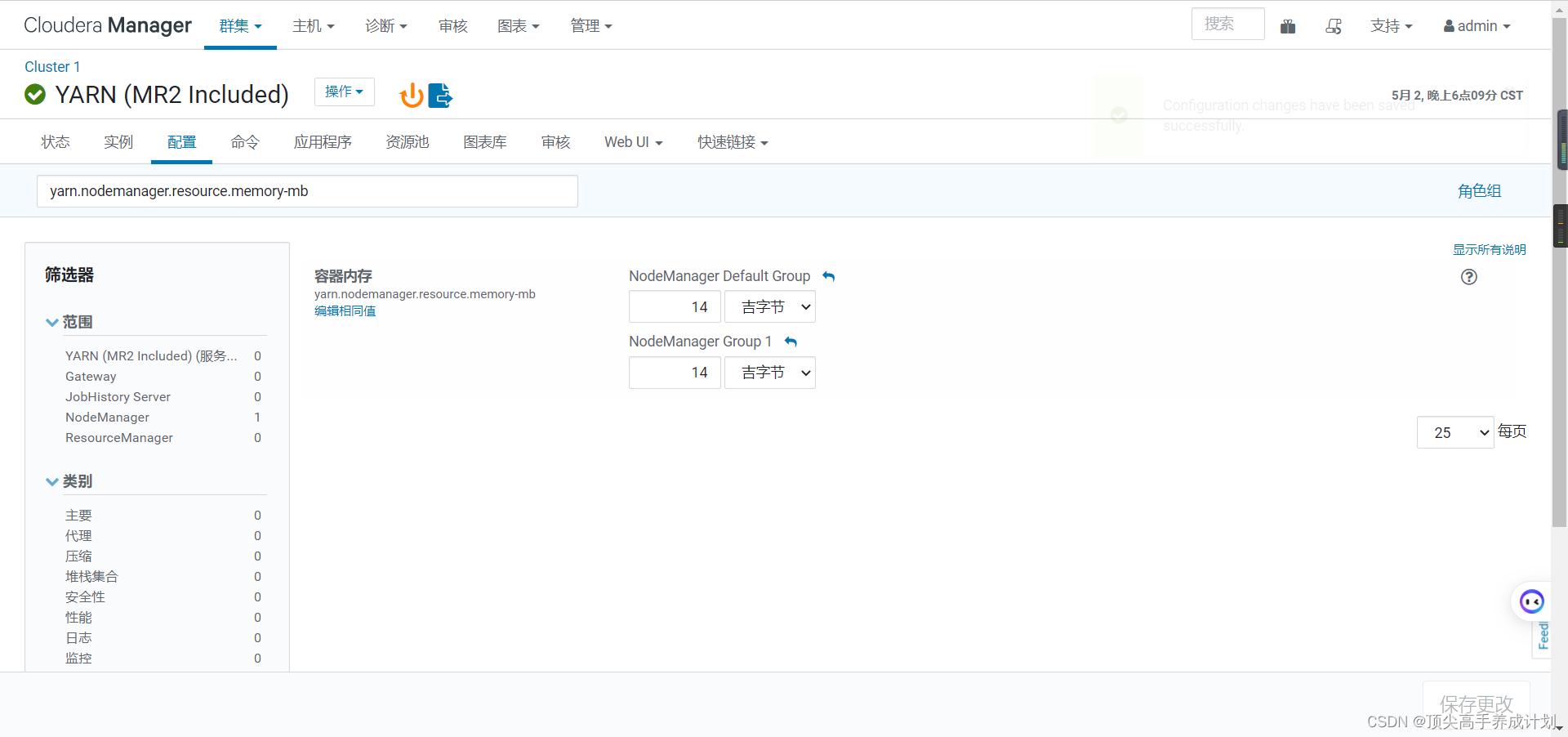

5.修改yarn.nodemanager.resource.memory-mb每个节点内存所需大小,当前集群环境下每个节点的物理内存为16G,设置每个yarn可用每个节点内存为14G。

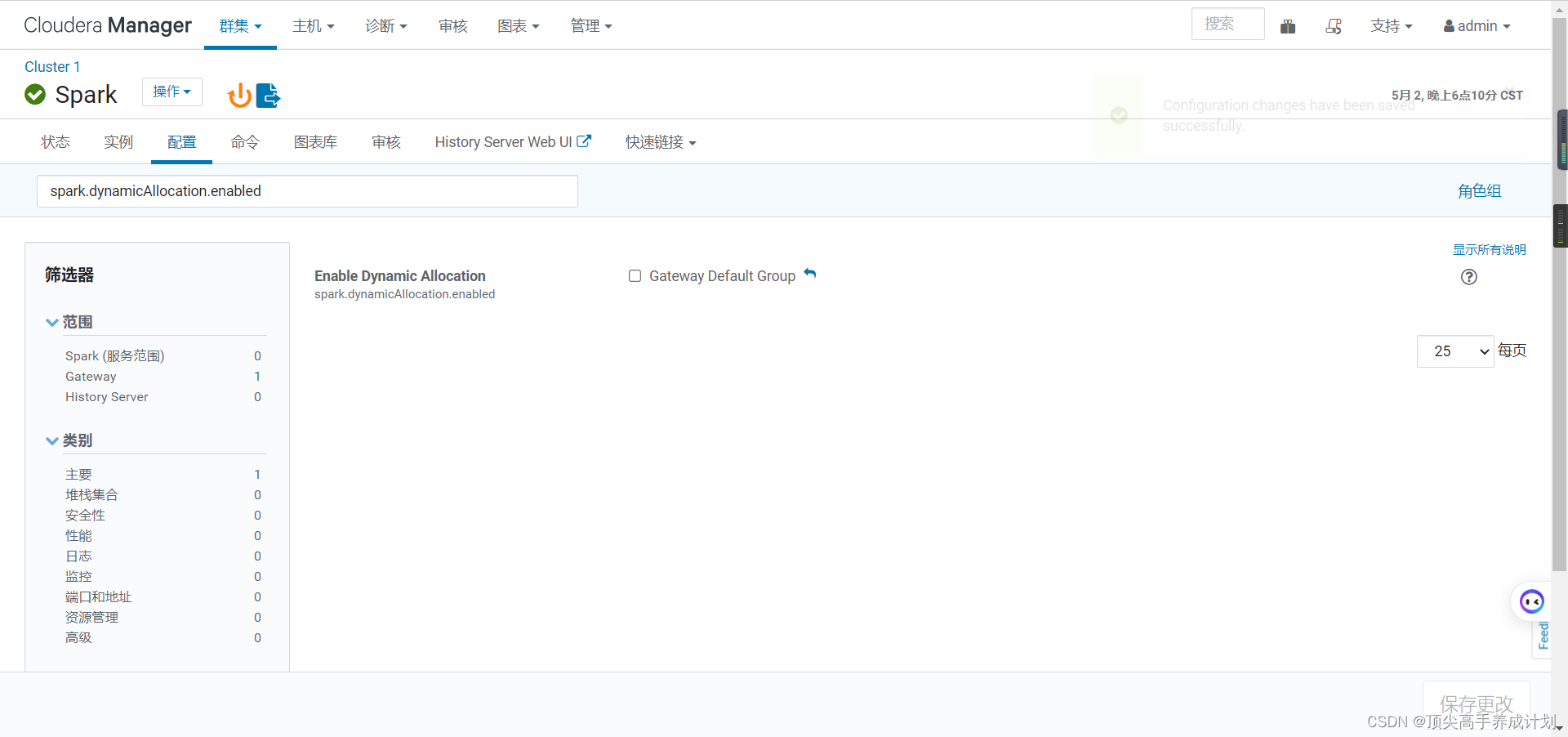

6.关闭spark.dynamicAllocation.enabled 参数否则分配的资源不受控制。

hive里面也要修改

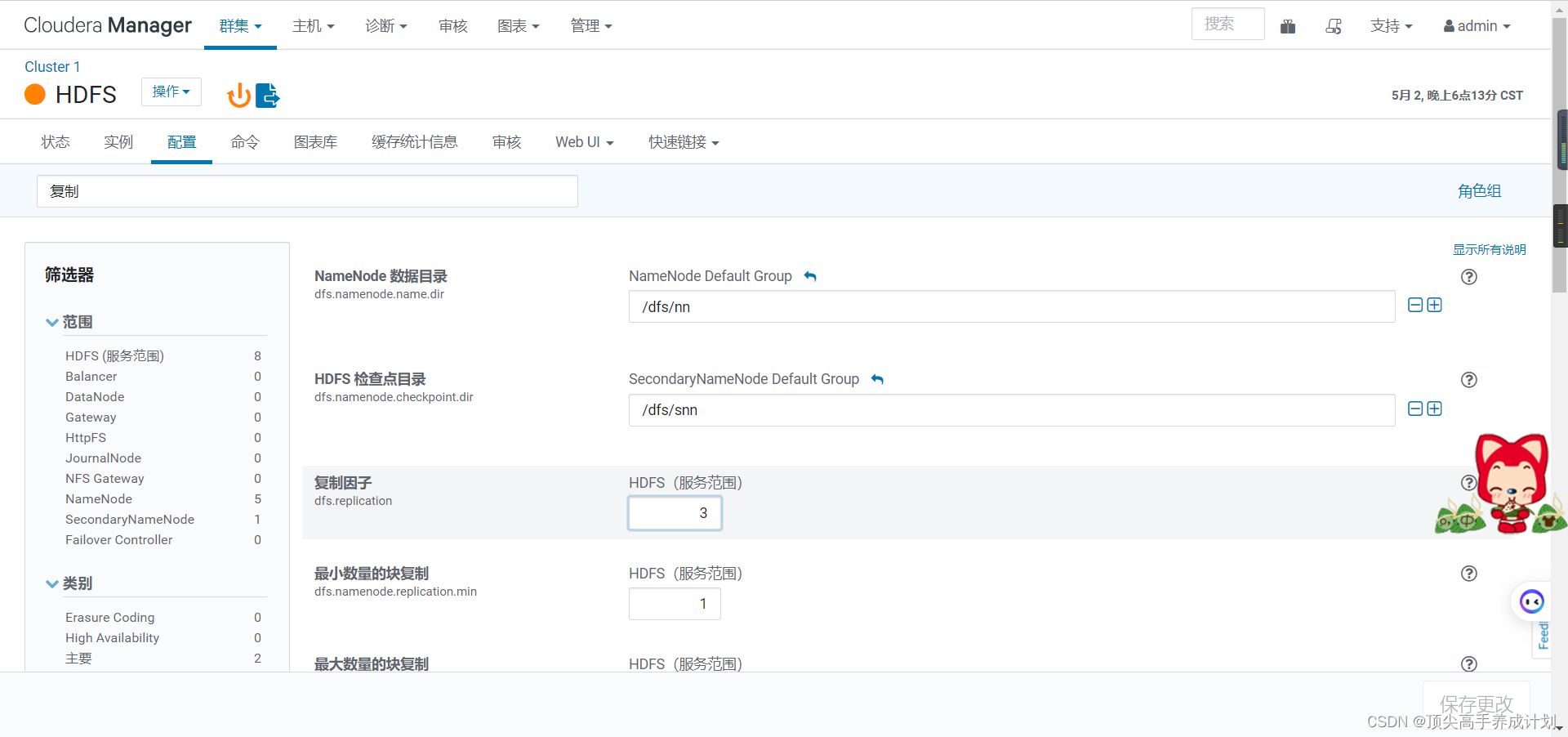

7.修改HDFS副本数。

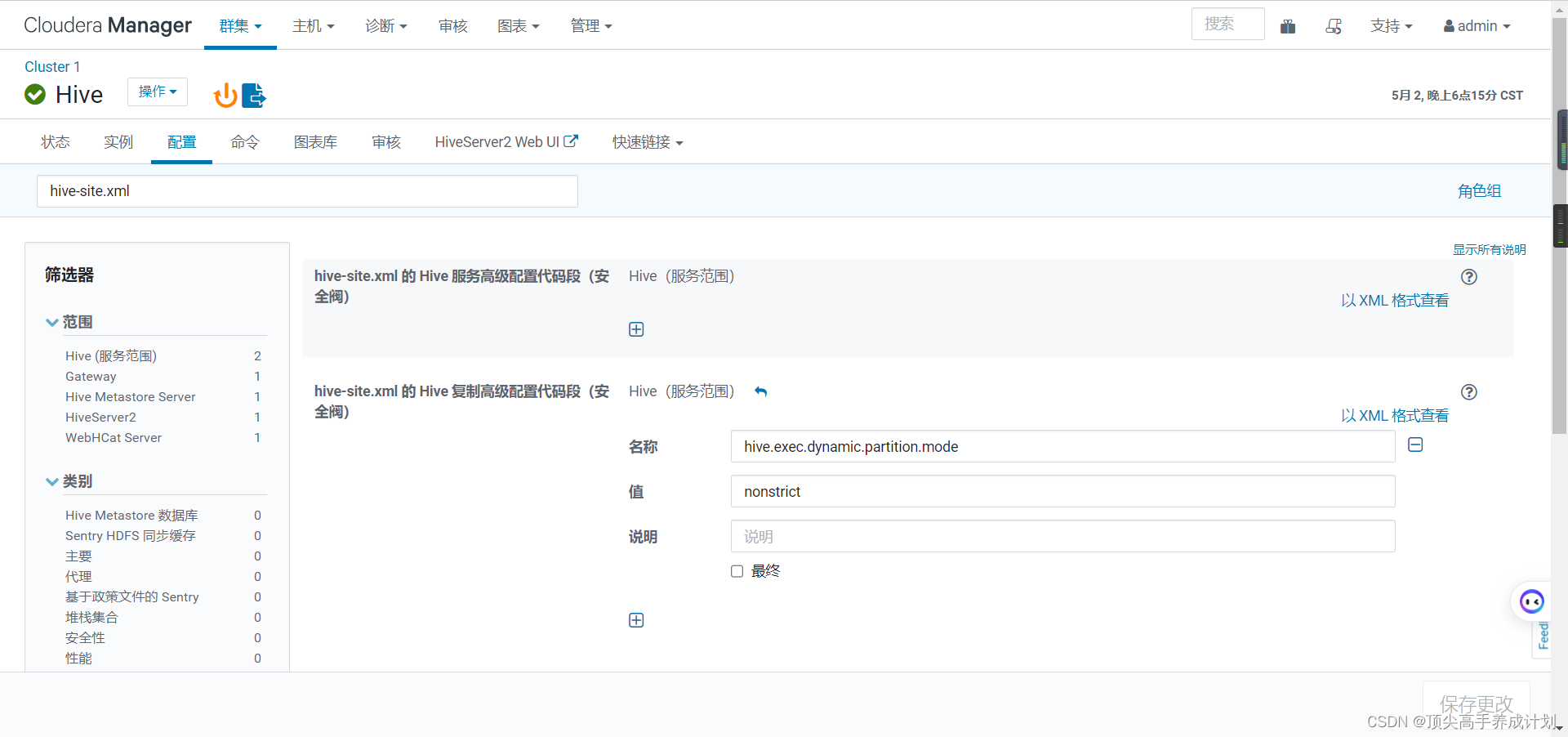

8.Hive动态分区非严格模式,默认是严格模式,严格模式下,动态分区至少要有一个静态分区字段。hive.exec.dynamic.partition.mode = nonstrict 。

9.Hive on Spark配置

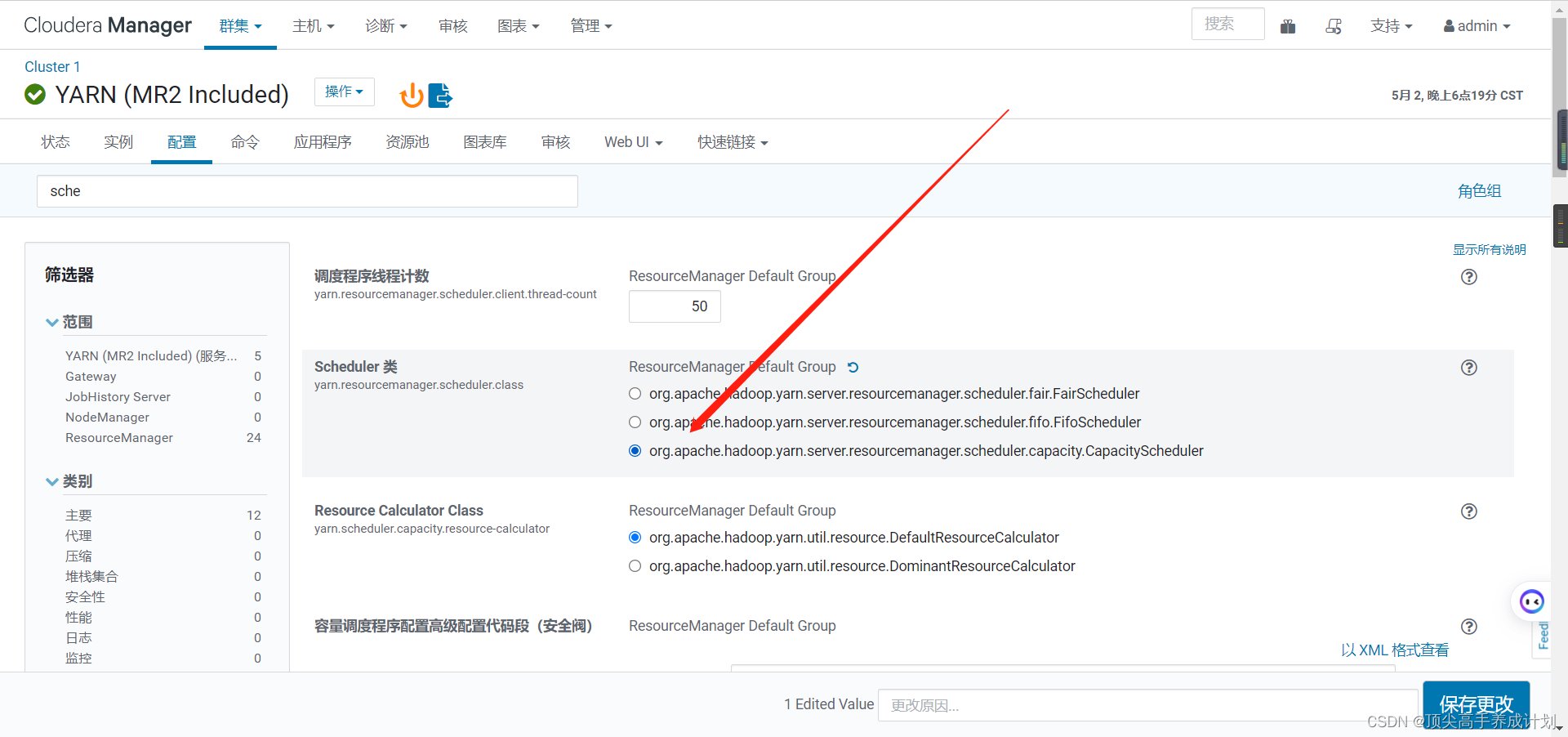

10.设置容量调度器

(本案例不进行修改,了解即可)默认root队列,可以进行修改,添加3个队列spark,hive,flink,spark资源设置占yarn集群40%,hive设置占yarn集群20%,flink设置占40%。

配置完毕后重启服务,到yarn界面查看调度器,已经发生变化有hive队列和spark队列。

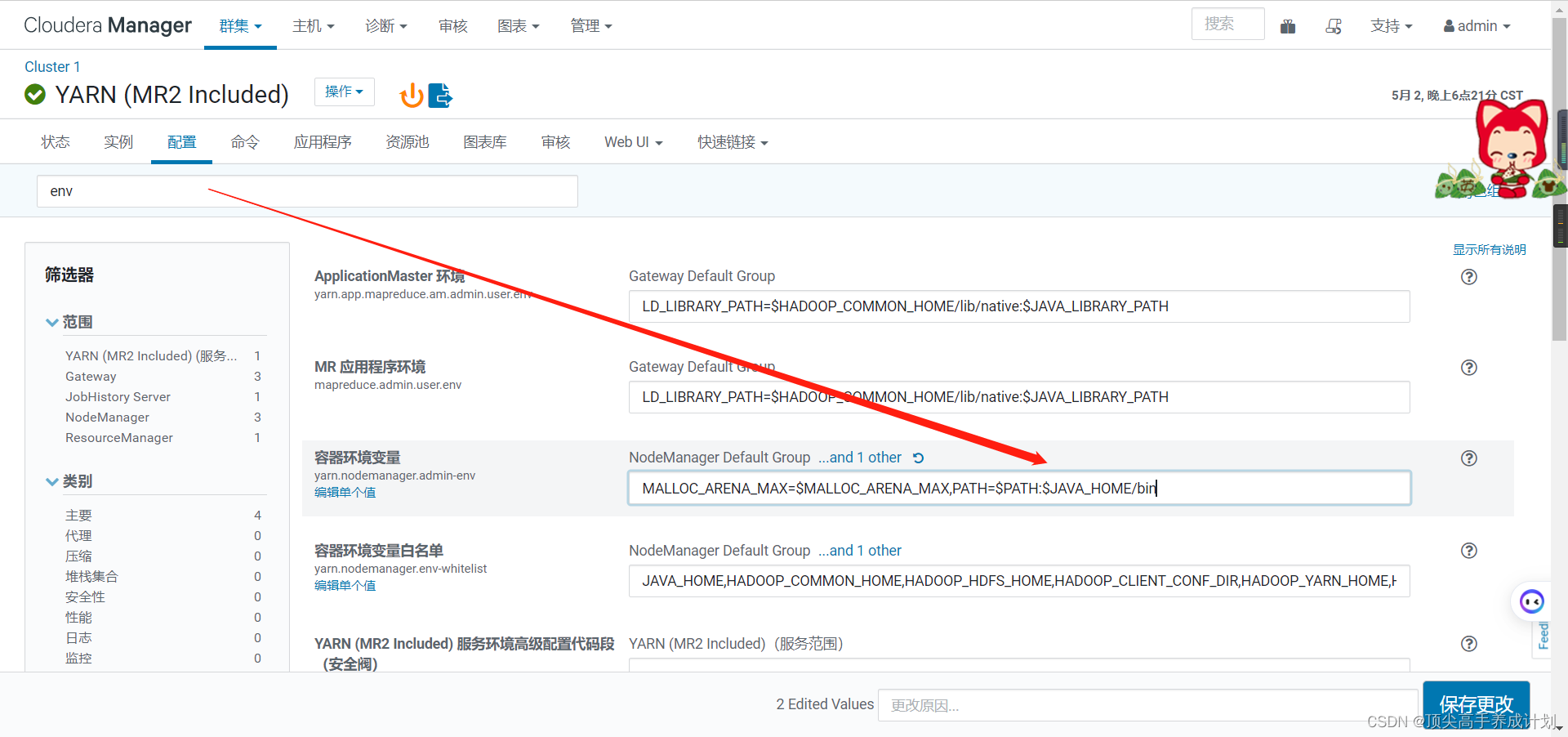

11.配置yarn环境变量,为了解决hue在执行调度任务时找不到环境变量。PATH=$PATH:$JAVA_HOME/bin.

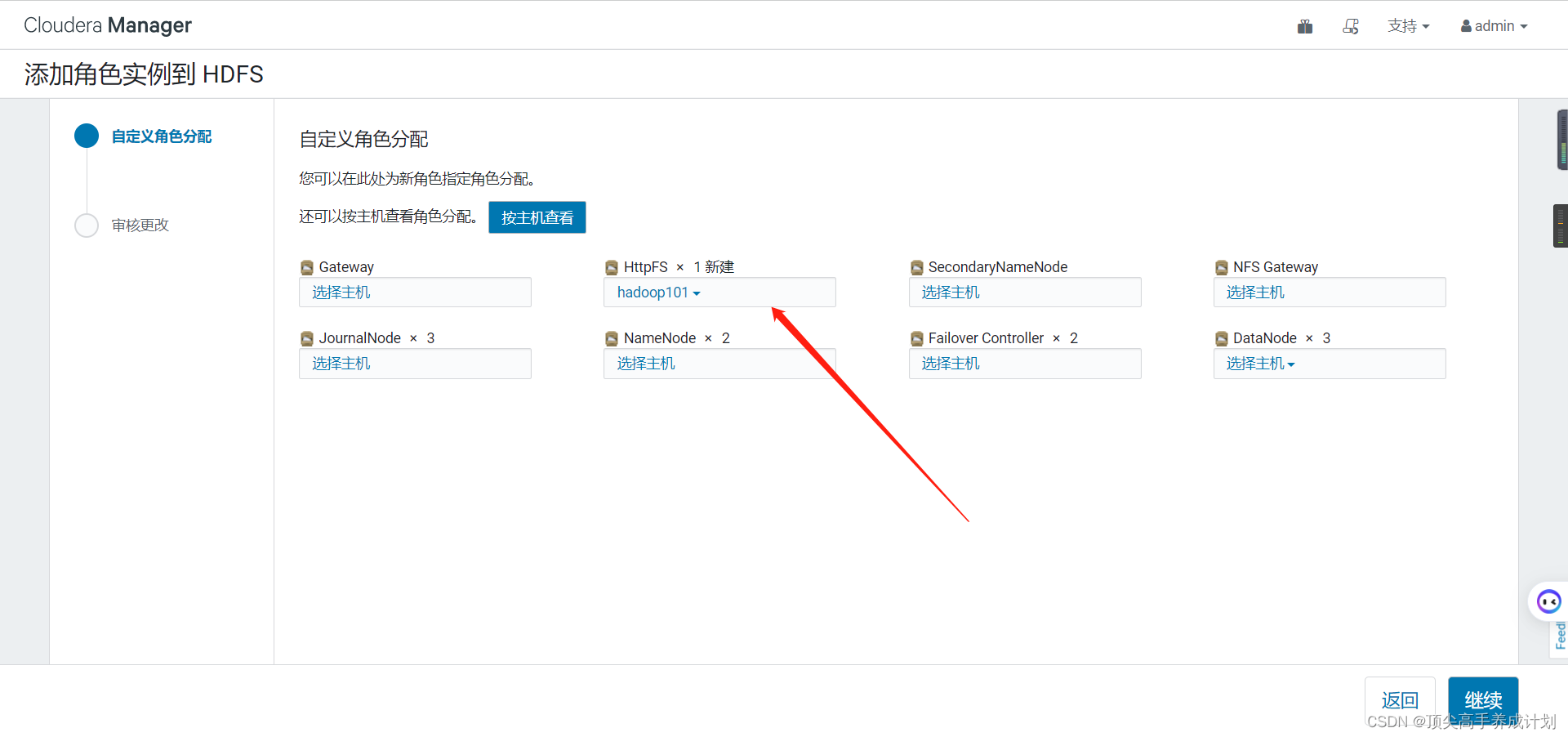

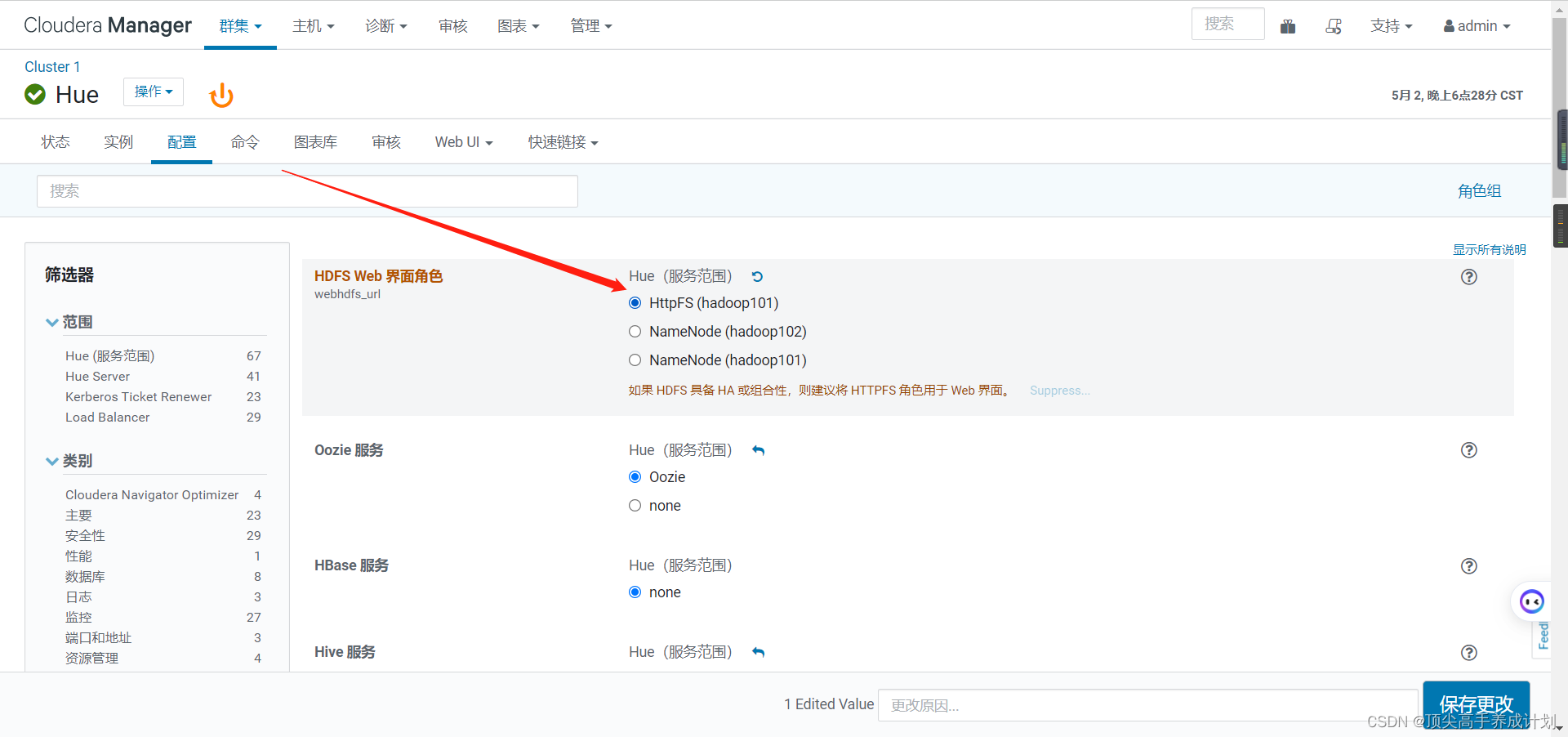

12.HUE和HDFS HA配置,由于HDFS开启了HA,导致Hue识别失败active节点和standby节点,故需配置HTTPFS 角色。

13.取消向量化执行hive.vectorized.execution.enabled向量化执行是hive优化的一种方式,但是他必须要求执行引擎是Tez,文件格式是orc,一次批量执行1024行而非一行来提高扫描、聚合、过滤器和连接等操作的性能。

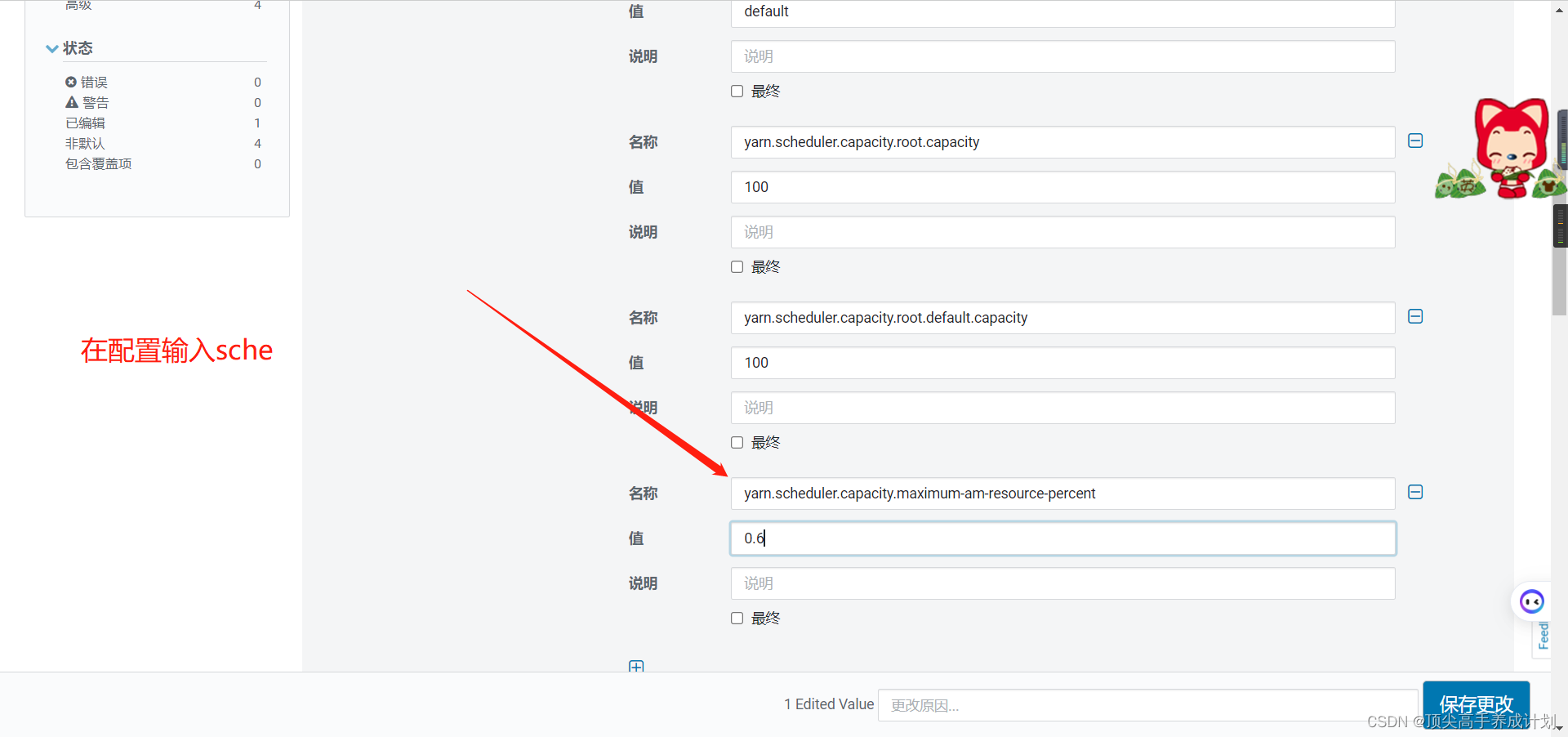

14.设置Yarn AppMaster资源限制yarn.scheduler.capacity.maximum-am-resource-percent =0.6,设置有多少资源可以用来运行app master,即控制当前激活状态的应用,默认是10%。

然后重启所有的服务。