热门标签

热门文章

- 1超级简单acme证书申请,不用dns配置,自动续期,个人网站首选

- 2大模型训练-实战的模型、算力与数据训练_训练私有大模型 需要什么算力资源

- 32024年人工智能领域10大预测

- 4在 Elasticsearch 中使用 PyTorch 进行现代自然语言处理的介绍_elasticsearch pytorch

- 5Visual Studio无法推送提交到Github的解决方法_visual studio git 提交无法推送

- 6Windows下MySQL服务启动常见的两种方式,完美适配Mysql5.7,MySql8.0_windows启动mysql

- 7pandas快速读取大文件csv方法_pandas读取文件csv

- 8释放Mac潜能,选择Magic Disk Cleaner for Mac

- 9Django搭建项目_django 搭建项目

- 10需要隐私清单签名的 SDK 功能描述_afnetworking 隐私清单

当前位置: article > 正文

在本地电脑上如何在 Visual Studio Code 中运行 Llama 3 — 分步指南_vscode打开continue-llama3

作者:你好赵伟 | 2024-05-30 21:04:00

赞

踩

vscode打开continue-llama3

在笔记本电脑上运行 80 亿个参数的人工智能模型的想法听起来似乎只适合精通技术的人。但别担心!在本文中,我将分享一个分步指南,让任何人都可以轻松完成。

先决条件

在进入实际步骤之前,请务必注意我当前运行的环境的规格:

笔记本电脑

操作系统:Windows 11

CPU:处理器 Intel® Core™ i7–9850H

内存:32GB

磁盘空间:642 GB

这是正确的!您不需要拥有高端 GPU 即可在本地运行模型。有了合适的 CPU 和足够的 RAM,您就可以在自己的计算机上运行 Llama 3,不会出现任何问题。

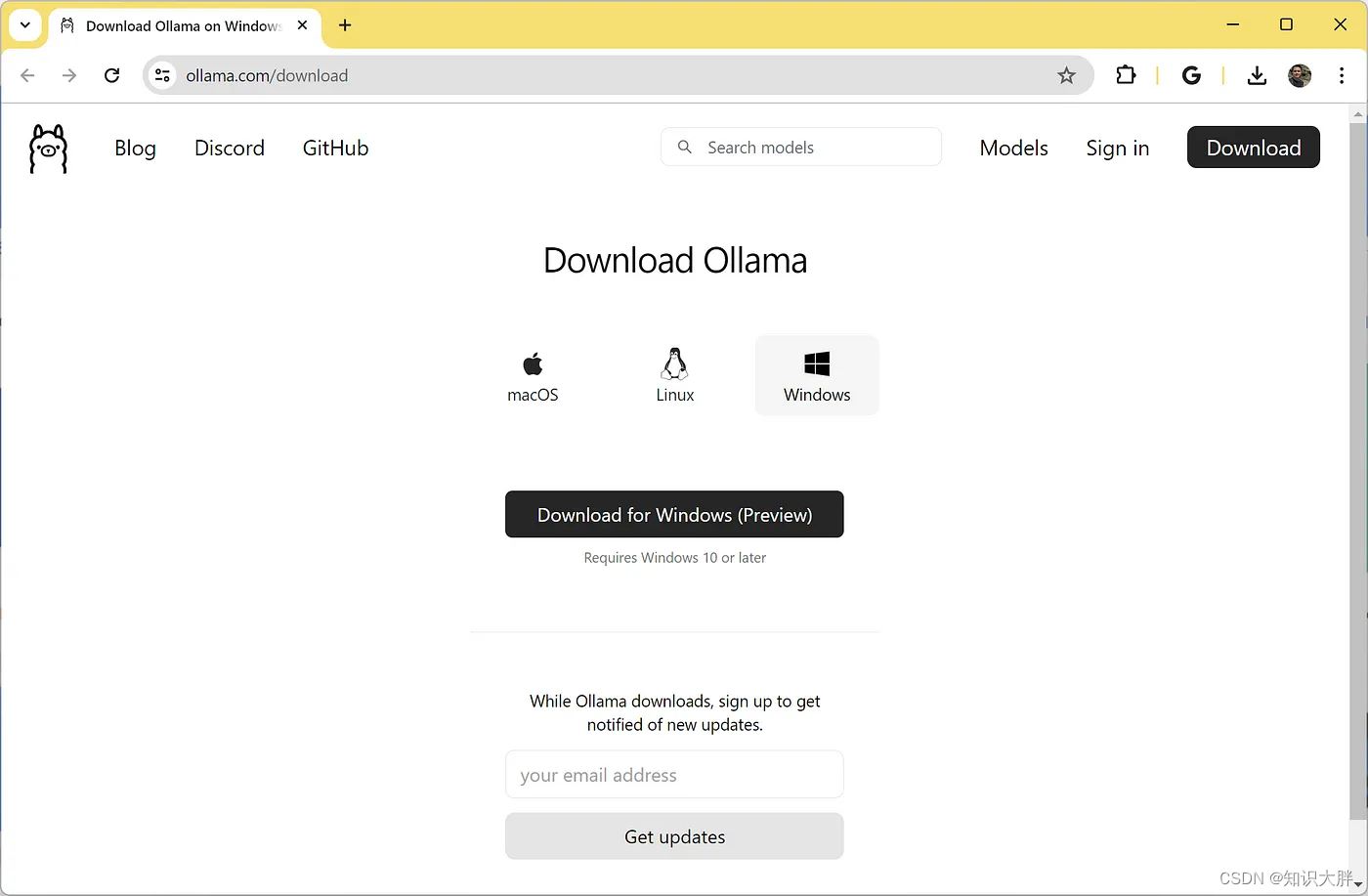

第1步:下载并安装Ollama

前往Ollama网站并下载最新版本的安装程序。 Ollama 是一款多功能工具,旨在在各种平台上本地运行、创建和共享大型语言模型 (LLM)。

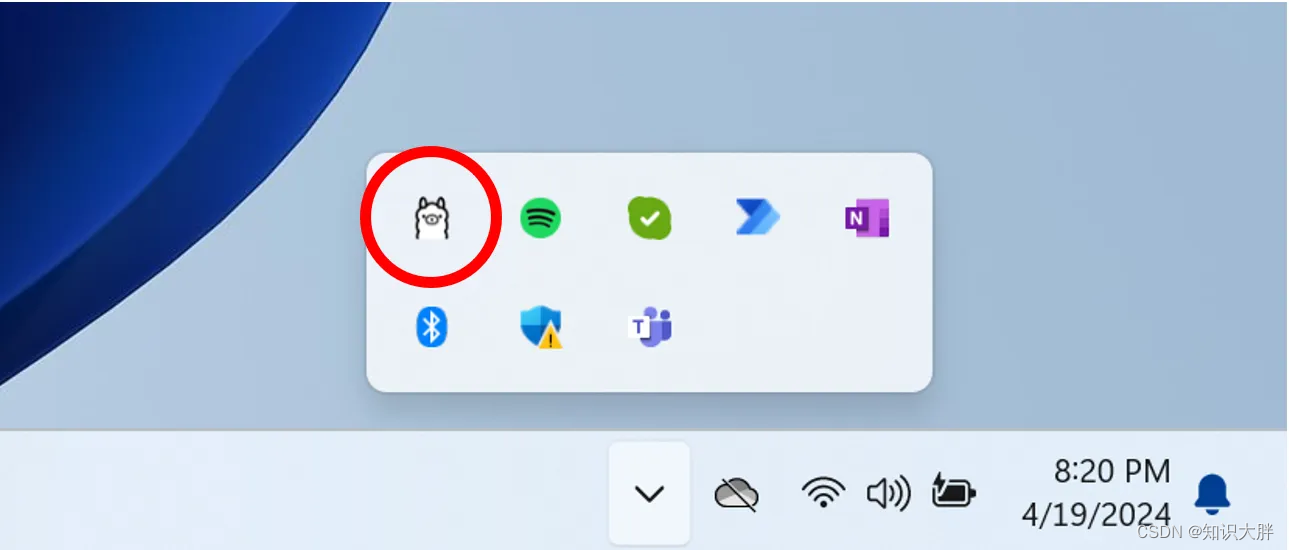

安装 Ollama 后,确保它在后台运行。您可以通过在系统托盘或任务管理器中查找 Ollama 图标来检查这一点。

要确认 Ollama 在命令行界面 (CLI) 中正常工作&

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/你好赵伟/article/detail/648599

推荐阅读

相关标签