- 1构建机器学习系统步骤_如何将预测模型做成系统

- 2assert()函数用法总结

- 3wordpress创建_如何在WordPress中轻松创建优惠券网站

- 4黑金AX7Z100 FPGA开发板移植LWIP库(一)PS端_黑金ac7z100c 教程

- 5【统信UOS下升级openssh及openssl】_统信服务器openssh怎么升级补丁

- 6AI提示语-让每个人都能轻松使用 AI,提高 10 倍生产力

- 7小米路由器MINI架设WEB服务_小米路由器部署web项目

- 8【Mac】鼠标控制\移动\调整窗口大小BBT\边缘触发调整音量\切换桌面_mac设置鼠标中键移动切换屏幕

- 9大一软件开发简单作业c语言简单超市库存管理系统_编写一个程序,模拟库存管理系统,主要有商品入库,商品出库,输出仓库中商品信息

- 10Word2VEC_java: Java实现的Word2Vec工具,带你深入文本理解

RKNN:yolov8模型转换与板端推理流程_yolov8 rknn

赞

踩

近期,在研究瑞芯微的RKNN模型推理时,遇到一些坑,现记录下来,以备忘,亦供同道者参考。

目录

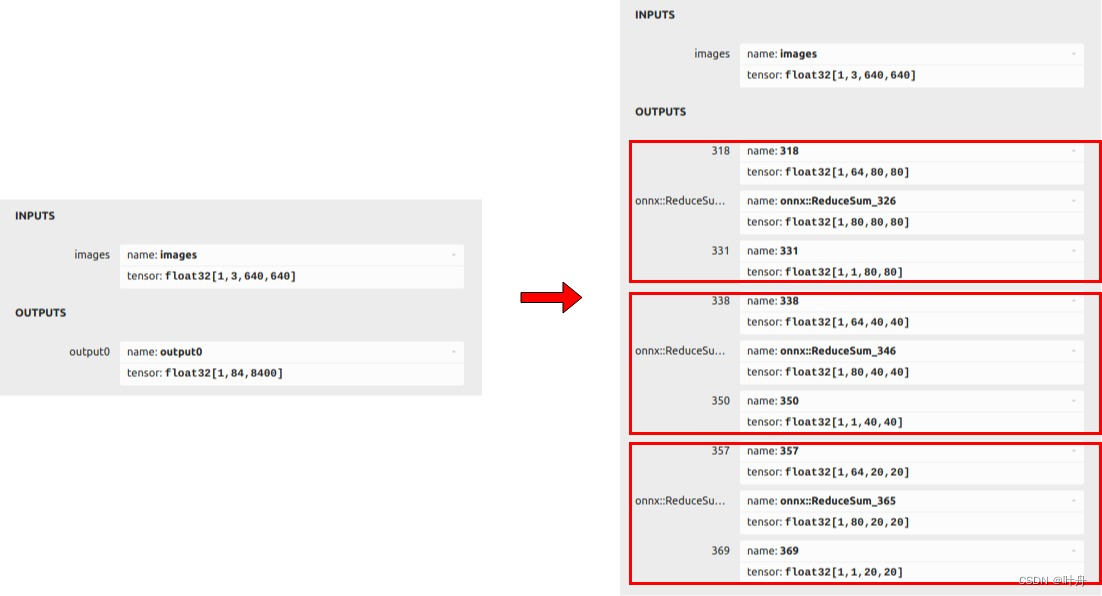

本文主要内容包括两块,一是在宿主机进行onnx-->rknn的模型转换,二是在SOC上利用转换好的rknn模型进行推理。

1. 模型转换

这一步需要在x86宿主机上进行,并配置相关环境。

1.1. 宿主机环境配置

主要就是在python环境中安装RKNN-Toolkit2。

构造环境这一步,建议在docker里面进行,这样可以避免和宿主机环境产生冲突,或者因为宿主机环境和需要的环境不匹配而导致的模型转换出现问题。

PS:之前博主在宿主机的python环境中直接pip安装的rknn-toolkit2,然而用一样的代码进行模型转换,最后推理结果总是出现错乱或者直接所有结果置信度特别低(接近0),最后放弃挣扎,转用docker才没有问题。

这里使用的版本是1.6.0,下载地址:

.

├── CHANGELOG.md

├── doc

├── LICENSE

├── README.md

├── res

├── rknn-toolkit2

├── rknn_toolkit_lite2

└── rknpu2

进到“rknn-toolkit2/docker/docker_file/ubuntu_20_04_cp38”目录下,并利用提供的Dockerfile构建一个docker镜像:

docker build -t rknn_toolkit2_1.6.0 . -f Dockerfile_ubuntu_20_04_for_cp38等待镜像构建完毕,就会在里面自动安装模型转换所需的所有软件环境。然后,就可以启动一个容器,进到docker系统中:

- # 注意:我们上一步构造的镜像命名为rknn_toolkit2_1.6.0,需要改为你的镜像名字;

- # 同时,这里作了一个主机和容器之间的路径映射,以便于文件共享,需要将“ /data/projects/other/rknn_test/share_dir”改为你自己的路径

- docker run -v /data/projects/other/rknn_test/share_dir:/workspace/ -it rknn_toolkit2_1.6.0

至此,就构建好了所需的环境。

1.2. onnx模型准备

这一步是为了从我们训练的torch模型转为onnx中间格式的模型。这里不能直接使用ultralytics官方的库,需要作一定的改动,使其最后的detect部分改为rknn支持的方式:

可以参考rknn修改后的ultralytics版本: