- 1【机器学习基础】无监督学习(5)——生成模型_数据生成模型

- 2微信小程序_微信开发者工具开启多个页面

- 3毕业设计超市进销存管理系统源码

- 4Mac OS下JDK1.7安装_mac os jdk1.7

- 5Android Studio ——在不root手机的情况下读取Data目录下的文件_adb查看文件目录

- 6构造c语言的上下文无关文法,正则文法和上下文无关文法

- 72022华为软件精英挑战赛比赛经历

- 8yolov5 过拟合 欠拟合_yolo 欠拟合

- 9鸿蒙开发 - 状态管理之@Observed和@ObjectLink

- 10Linux 十四 修改文件操作权限 用户文件权限详解_14.修改linux权限每个数字代表的含义

GPT4All 本地部署教程_gpt4all本地部署

赞

踩

省流:偷懒的可以直接看第二章的GPT4All部署

一. GPT4All README

根据官方网站GPT4All的描述,它是一个开源大型语言模型,可在CPU和几乎任何GPU上本地运行

github source: https://github.com/nomic-ai/gpt4all

GPT4All Website and Models: GPT4All

GPT4All Documentation: GPT4All Documentation

Discord: https://discord.com/invite/mGZE39AS3e

Official Langchain Backend: https://python.langchain.com/docs/integrations/llms/gpt4all.html

(1)GPT4All: 开源边缘大型语言模型生态系统。

!!!Important !!!

GPT4All v2.5.0 and newer only supports models in GGUF format (.gguf). Models used with a previous version of GPT4All (.bin extension) will no longer work.

备注1:上述意思是说新的版本基于只支持GGUF格式的模型,早先使用的版本.bin格式模型的GPT4All无法使用。

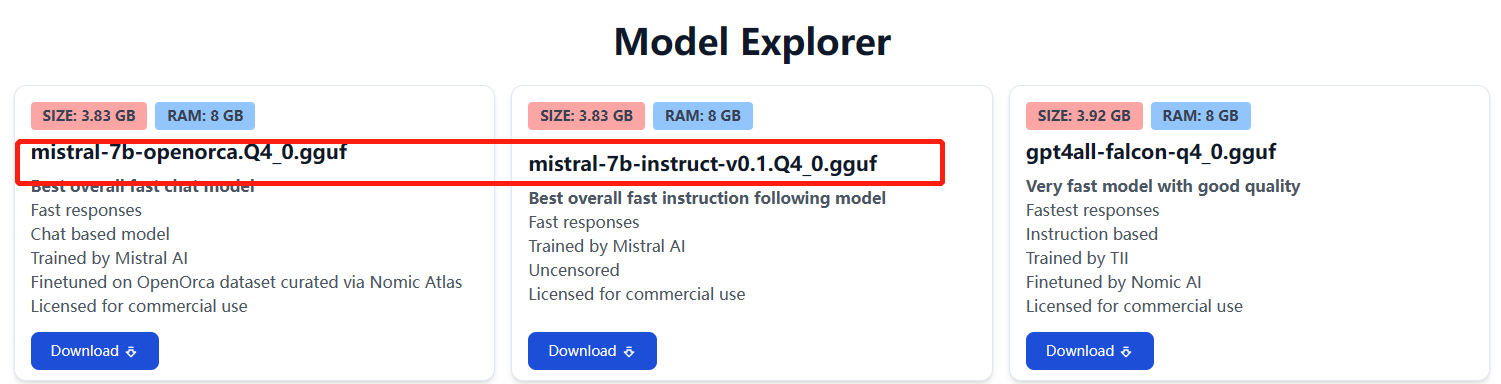

备注2:GGUF格式的模型在上述GPT4All Website and Models链接下载,进入网页往下翻即可找到。

备注3:GPT4All 是一个生态系统,用于运行功能强大的定制大型语言模型,可在消费级 CPU 和任何 GPU 上本地运行。请注意,您的 CPU 需要支持 AVX 或 AVX2 指令。

备注4:可以在上述GPT4All Documentation链接了解更多信息

GPT4All 模型是一个 3GB - 8GB 的文件,您可以下载并将其嵌入 GPT4All 开源生态系统软件。Nomic AI 支持并维护这一软件生态系统,以确保质量和安全性,同时率先努力让任何个人或企业都能轻松地训练和部署自己的边缘大型语言模型。

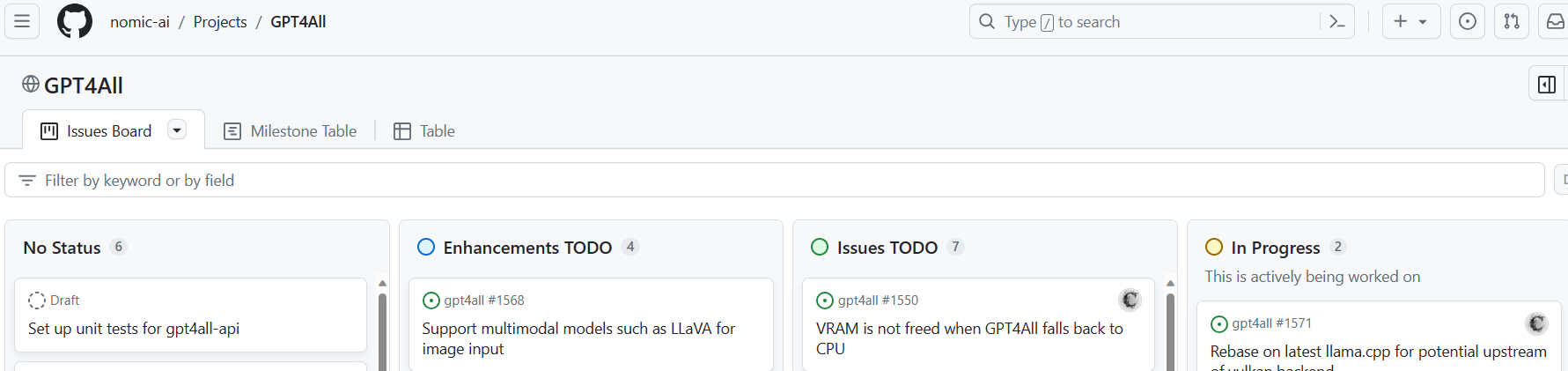

(2)What's New (Issue Tracker)

备注5:Issue Tracker 是一些网络用户关于GPT4All部署的问题,图片如下。

更新的信息如下:

1.October 19th, 2023: GGUF 支持以下方式启动:

- Mistral 7b是一个在GPT4All Website and Models上更新的模型图库、包括 Rift Coder v1.5 在内的多个新本地代码模型

- Nomic Vulkan 支持 GGUF 中的 Q4_0、Q6 量化。

- 离线构建支持运行旧版本的 GPT4All 本地 LLM 聊天客户端

2.September 18th, 2023:

Nomic Vulkan 发布,支持 AMD、英特尔、三星、高通和英伟达 GPU 上的本地 LLM 推理。

3.August 15th, 2023:

启动 GPT4All API,允许从 docker 容器推断本地 LLM。

4.July 2023:

稳定支持 LocalDocs,这是一个 GPT4All 插件,可让您与数据进行本地私聊。

(3)Chat Client

使用自动更新的桌面聊天客户端,在家用桌面上运行任何 GPT4All 模型。请参阅GPT4All Website and Models网址,了解您可以使用这款功能强大的桌面应用程序运行的开源模型的完整列表。

下载链接:

可在GPT4All Website and Models网址上查找最新信息

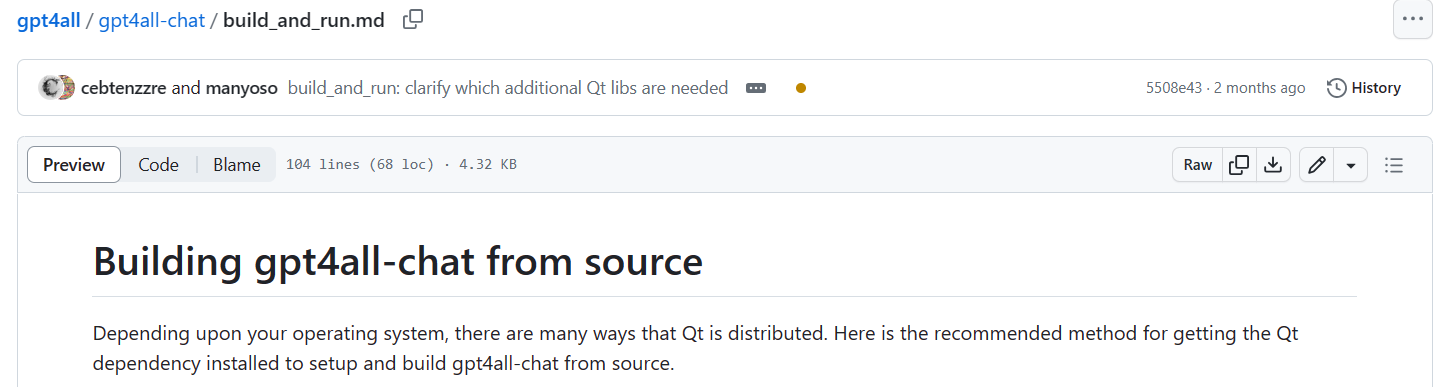

聊天客户端的构建和运行

按照聊天客户端 build_and_run 页面上的可视化说明进行操作

Bindings

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。