- 1特征工程——文本特征

- 2信用卡反欺诈模型

- 3国内区块链企业已超4.8万家,实际项目不过1800多个

- 4LLM主流框架:Causal Decoder、Prefix Decoder和Encoder-Decoder

- 5python读音发音器-python3 - 文本读音器

- 6人工智能应该怎么入门 首选哪个编程语言较好_人工智能学c++还是c#

- 7【粉丝福利社】Python从入门到精通(微课精编版)(软件开发视频大讲堂)(文末送书-完结)

- 82023最新版ESP8266 Arduino Http网页结果存入LittleFS文件_arduino-esp8266littlefs

- 9区别探索:掩码语言模型 (MLM) 和因果语言模型 (CLM)的区别

- 10UNet - 预测数据predict(多个图像的分割)_unet图象分割代码

TensorFlow实战——个性化推荐_基于tensorflow实现智能新闻推荐

赞

踩

原创文章,转载请注明出处: http://blog.csdn.net/chengcheng1394/article/details/78820529

请安装TensorFlow1.0,Python3.5

项目地址:

https://github.com/chengstone/movie_recommender

前言

本项目使用文本卷积神经网络,并使用MovieLens数据集完成电影推荐的任务。

推荐系统在日常的网络应用中无处不在,比如网上购物、网上买书、新闻app、社交网络、音乐网站、电影网站等等等等,有人的地方就有推荐。根据个人的喜好,相同喜好人群的习惯等信息进行个性化的内容推荐。比如打开新闻类的app,因为有了个性化的内容,每个人看到的新闻首页都是不一样的。

这当然是很有用的,在信息爆炸的今天,获取信息的途径和方式多种多样,人们花费时间最多的不再是去哪获取信息,而是要在众多的信息中寻找自己感兴趣的,这就是信息超载问题。为了解决这个问题,推荐系统应运而生。

协同过滤是推荐系统应用较广泛的技术,该方法搜集用户的历史记录、个人喜好等信息,计算与其他用户的相似度,利用相似用户的评价来预测目标用户对特定项目的喜好程度。优点是会给用户推荐未浏览过的项目,缺点呢,对于新用户来说,没有任何与商品的交互记录和个人喜好等信息,存在冷启动问题,导致模型无法找到相似的用户或商品。

为了解决冷启动的问题,通常的做法是对于刚注册的用户,要求用户先选择自己感兴趣的话题、群组、商品、性格、喜欢的音乐类型等信息,比如豆瓣FM:

先来看看数据

本项目使用的是MovieLens 1M 数据集,包含6000个用户在近4000部电影上的1亿条评论。

数据集分为三个文件:用户数据users.dat,电影数据movies.dat和评分数据ratings.dat。

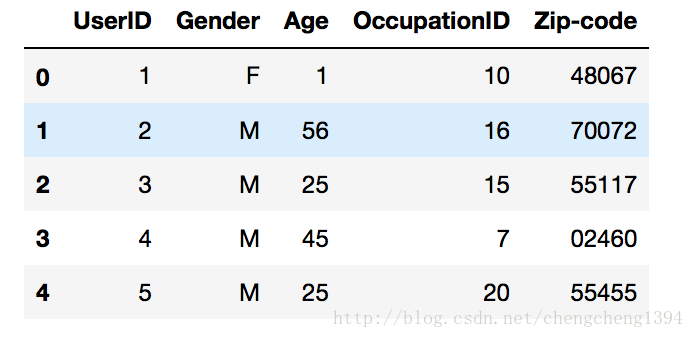

用户数据

分别有用户ID、性别、年龄、职业ID和邮编等字段。

数据中的格式:UserID::Gender::Age::Occupation::Zip-code

- Gender is denoted by a “M” for male and “F” for female

Age is chosen from the following ranges:

- 1: “Under 18”

- 18: “18-24”

- 25: “25-34”

- 35: “35-44”

- 45: “45-49”

- 50: “50-55”

- 56: “56+”

Occupation is chosen from the following choices:

- 0: “other” or not specified

- 1: “academic/educator”

- 2: “artist”

- 3: “clerical/admin”

- 4: “college/grad student”

- 5: “customer service”

- 6: “doctor/health care”

- 7: “executive/managerial”

- 8: “farmer”

- 9: “homemaker”

- 10: “K-12 student”

- 11: “lawyer”

- 12: “programmer”

- 13: “retired”

- 14: “sales/marketing”

- 15: “scientist”

- 16: “self-employed”

- 17: “technician/engineer”

- 18: “tradesman/craftsman”

- 19: “unemployed”

- 20: “writer”

其中UserID、Gender、Age和Occupation都是类别字段,其中邮编字段是我们不使用的。

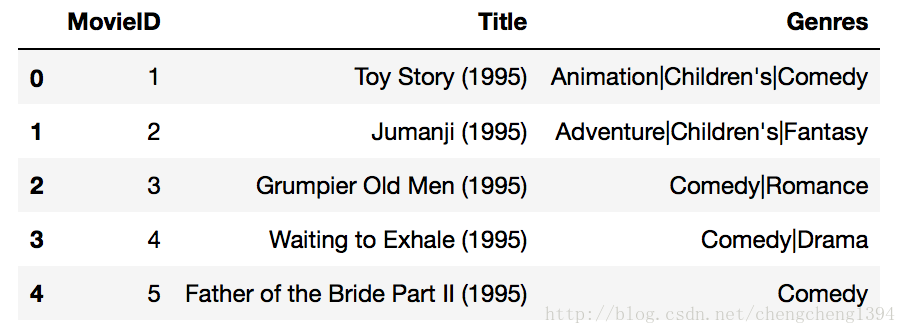

电影数据

分别有电影ID、电影名和电影风格等字段。

数据中的格式:MovieID::Title::Genres

- Titles are identical to titles provided by the IMDB (including

year of release) Genres are pipe-separated and are selected from the following genres:

- Action

- Adventure

- Animation

- Children’s

- Comedy

- Crime

- Documentary

- Drama

- Fantasy

- Film-Noir

- Horror

- Musical

- Mystery

- Romance

- Sci-Fi

- Thriller

- War

- Western

MovieID是类别字段,Title是文本,Genres也是类别字段

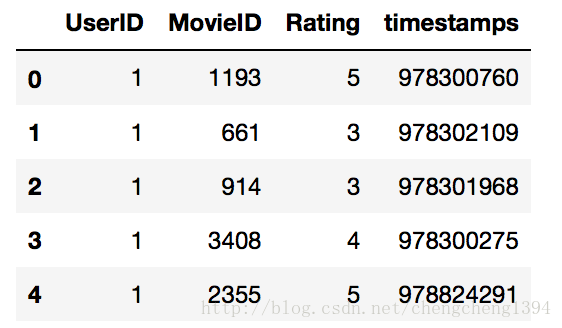

评分数据

分别有用户ID、电影ID、评分和时间戳等字段。

数据中的格式:UserID::MovieID::Rating::Timestamp

- UserIDs range between 1 and 6040

- MovieIDs range between 1 and 3952

- Ratings are made on a 5-star scale (whole-star ratings only)

- Timestamp is represented in seconds since the epoch as returned by time(2)

- Each user has at least 20 ratings

评分字段Rating就是我们要学习的targets,时间戳字段我们不使用。

说说数据预处理

- UserID、Occupation和MovieID不用变。

- Gender字段:需要将‘F’和‘M’转换成0和1。

- Age字段:要转成7个连续数字0~6。

- Genres字段:是分类字段,要转成数字。首先将Genres中的类别转成字符串到数字的字典,然后再将每个电影的Genres字段转成数字列表,因为有些电影是多个Genres的组合。

- Title字段:处理方式跟Genres字段一样,首先创建文本到数字的字典,然后将Title中的描述转成数字的列表。另外Title中的年份也需要去掉。

- Genres和Title字段需要将长度统一,这样在神经网络中方便处理。空白部分用‘< PAD >’对应的数字填充。

数据预处理的代码可以在项目中找到:load_data函数

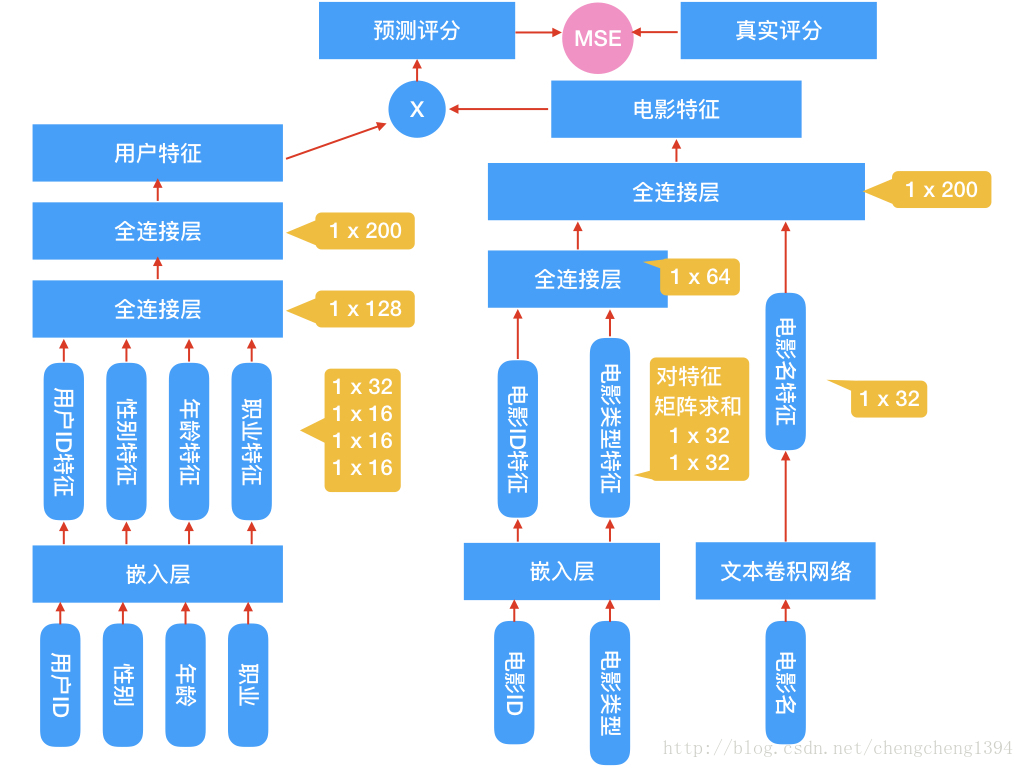

模型设计

通过研究数据集中的字段类型,我们发现有一些是类别字段,通常的处理是将这些字段转成one hot编码,但是像UserID、MovieID这样的字段就会变成非常的稀疏,输入的维度急剧膨胀,这是我们不愿意见到的,毕竟我这小笔记本不像大厂动辄能处理数以亿计维度的输入:)

所以在预处理数据时将这些字段转成了数字,我们用这个数字当做嵌入矩阵的索引,在网络的第一层使用了嵌入层,维度是(N,32)和(N,16)。

电影类型的处理要多一步,有时一个电影有多个电影类型,这样从嵌入矩阵索引出来是一个(n,32)的矩阵,因为有多个类型嘛,我们要将这个矩阵求和,变成(1,32)的向量。

电影名的处理比较特殊,没有使用循环神经网络,而是用了文本卷积网络,下文会进行说明。

从嵌入层索引出特征以后,将各特征传入全连接层,将输出再次传入全连接层,最终分别得到(1,200)的用户特征和电影特征两个特征向量。

我们的目的就是要训练出用户特征和电影特征,在实现推荐功能时使用。得到这两个特征以后,就可以选择任意的方式来拟合评分了。我使用了两种方式,一个是上图中画出的将两个特征做向量乘法,将结果与真实评分做回归,采用MSE优化损失。因为本质上这是一个回归问题,另一种方式是,将两个特征作为输入,再次传入全连接层,输出一个值,将输出值回归到真实评分,采用MSE优化损失。

实际上第二个方式的MSE loss在0.8附近,第一个方式在1附近,5次迭代的结果。

文本卷积网络

网络看起来像下面这样

图片来自Kim Yoon的论文:Convolutional Neural Networks for Sentence Classification

将卷积神经网络用于文本的文章建议你阅读Understanding Convolutional Neural Networks for NLP

网络的第一层是词嵌入层,由每一个单词的嵌入向量组成的嵌入矩阵。下一层使用多个不同尺寸(窗口大小)的卷积核在嵌入矩阵上做卷积,窗口大小指的是每次卷积覆盖几个单词。这里跟对图像做卷积不太一样,图像的卷积通常用2x2、3x3、5x5之类的尺寸,而文本卷积要覆盖整个单词的嵌入向量,所以尺寸是(单词数,向量维度),比如每次滑动3个,4个或者5个单词。第三层网络是max pooling得到一个长向量,最后使用dropout做正则化,最终得到了电影Title的特征。

核心代码讲解

完整代码请见项目

#嵌入矩阵的维度

embed_dim = 32

#用户ID个数

uid_max = max(features.take(0,1)) + 1 # 6040

#性别个数

gender_max = max(features.take(2,1)) + 1 # 1 + 1 = 2

#年龄类别个数

age_max = max(features.take(3,1)) + 1 # 6 + 1 = 7

#职业个数

job_max = max(features.take(4,1)) + 1# 20 + 1 = 21

#电影ID个数

movie_id_max = max(features.take(1,1)) + 1 # 3952

#电影类型个数

movie_categories_max = max(genres2int.values()) + 1 # 18 + 1 = 19

#电影名单词个数

movie_title_max = len(title_set) # 5216

#对电影类型嵌入向量做加和操作的标志,考虑过使用mean做平均,但是没实现mean

combiner = "sum"

#电影名长度

sentences_size = title_count # = 15

#文本卷积滑动窗口,分别滑动2, 3, 4, 5个单词

window_sizes = {

2, 3, 4, 5}

#文本卷积核数量

filter_num = 8

#电影ID转下标的字典,数据集中电影ID跟下标不一致,比如第5行的数据电影ID不一定是5

movieid2idx = {val[0]:i for i, val in enumerate(movies.values)}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

超参

# Number of Epochs

num_epochs = 5

# Batch Size

batch_size = 256

dropout_keep = 0.5

# Learning Rate

learning_rate = 0.0001

# Show stats for every n number of batches

show_every_n_batches = 20

save_dir = './save'- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

输入

定义输入的占位符

def get_inputs():

uid = tf.placeholder(tf.int32, [None, 1], name="uid")

user_gender = tf.placeholder(tf.int32, [None, 1], name="user_gender")

user_age = tf.placeholder(tf.int32, [None, 1], name="user_age")

user_job = tf.placeholder(tf.int32, [None, 1], name="user_job")

movie_id = tf.placeholder(tf.int32, [None, 1], name="movie_id")

movie_categories = tf.placeholder(tf.int32, [None, 18], name="movie_categories")

movie_titles = tf.placeho- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9