- 1人工智能三要素之算法Transformer_transformers算法

- 2计算机毕业设计-基于Spring Boot的高校毕业生离校管理系统_基于ssm的毕业设计

- 3设备仪器仪表盘读数识别算法 yolov5_yolo检测仪表盘

- 4手把手教你搭建YOLOv8环境,并进行训练、测试_配置 yolov8

- 5德里克文:GPT入门经验及提示词速查整理_gpt 改英语论文 promot词

- 6如何通过 Hardhat 来验证智能合约_hardhat verify

- 7NLP-基础任务-中文分词算法(4)-评价指标:精确率(“模型分词结果集”与“标准答案集”的交集/“模型分词结果集”)、召回率(“模型分词结果集”与“标准答案集”的交集/“标准答案集”)、F1_评估分词算法的指标

- 8SpringBoot-实现搜索功能_springboot实现搜索功能

- 9探索在GIS中使用ChatGPT_gisgpt

- 10web课程设计——仿小米商城(10个页面)HTML+CSS+JavaScript web前端课程设计 web前端课程设计代码 web课程设计 HTML网页制作代码

玩转ChatGPT:Code interpreter (vol. 1)_chatgpt code interpreter

赞

踩

一、写在前面

喜大普奔,GPT-4传说中的Code interpreter插件已经可以用了!!!

二、什么是Code interpreter

代码解释器(Code Interpreter)是一个工具,它能够读取和执行编程代码。这里有几个主要的功能和用法:

(1)执行代码:您可以在会话中提供任何有效的Python代码,代码解释器会执行这段代码并返回结果。例如,如果您输入print("Hello, world!"),代码解释器会输出"Hello, world!"。

(2)状态维持:代码解释器能够保持一定的状态,这意味着在一段时间内,之前的变量和函数定义都会被保存。例如,如果您先定义了一个变量x = 10,然后在稍后的会话中使用这个变量(比如计算x * 2),代码解释器会正确地返回结果20。

(3)文件操作:代码解释器能够读取和写入文件。例如,您可以上传一个.csv文件,并使用pandas库来处理数据。同样,您也可以将数据保存为文件,然后下载到您的设备上。

(4)数学公式渲染:代码解释器支持LaTeX渲染,这意味着您可以输入数学公式,并看到美观的渲染结果。请注意,应使用

需要注意的是,代码解释器不具有网络访问权限,因此不能执行需要网络的操作,例如从互联网上下载文件或数据。此外,代码解释器的知识库只更新到2021年9月,因此可能无法识别在这之后新出现的库或API。

有人说像是不带有pip功能的python,但那也是让人兴奋的GPT-4插件。

话不多说,开始尝鲜!!!

二、开始对线

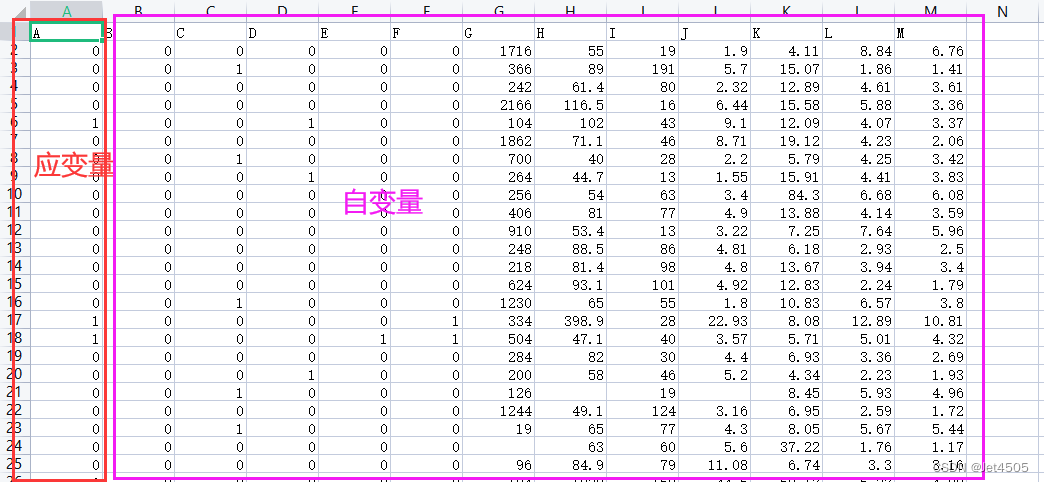

随意拿一个案例数据做机器学习分类模型试一试,数据格式如下:

(1)数据上传和概况描述

点击聊天输入框最左边的“+”按钮,选中你的数据集,上传。

输入咒语:请描述这个数据集的大致情况。

GPT-4输出:

这个数据集包含1927行和14列。每一行代表一个观察值,每一列代表一个特征。

这些特征的类型主要有两种:整数(int64)和浮点数(float64)。列'A'到'F'是整数类型,列'G'到'M'以及最后一列'Unnamed: 13'是浮点数类型。

需要注意的是,这个数据集存在缺失值。例如,列'G'只有1727个非空值,列'H'有1822个非空值,列'I'有1337个非空值,等等。最后一列'Unnamed: 13'全是空值,可能这一列是在数据收集或处理过程中误导入的,我们可能需要删除这一列。

在进行进一步的分析之前,我们需要对这些缺失值进行处理,方法可以有很多种,比如删除含有缺失值的行,或者使用某种策略(如平均值、中位数、最常见的值等)来填补缺失值。

评论:可以看到,GPT-4对整个数据集进行了描述,还指出了数据存在缺失值。此外,由于我的失误,多了一列空列(也就是他说的'Unnamed: 13')。

(2)数据清洗

咒语:删除最后一列,对整个数据集进行缺失值处理(采用中位数填充),并输出处理后的数据集为“jet-01.csv”。

GPT回复:

我已经删除了数据集中的最后一列,并使用每列的中位数填充了缺失值。处理后的数据集已经保存为"jet-01.csv"文件。

您可以通过这个链接下载处理后的数据集。

评论:点击下载文件,如下:

处理得很好啊~

(3)初步统计分析

咒语:请对每一列数据都进行简单的统计分析,用表格的形式展示。注意:分类变量和连续变量的数据集请分开描述;分类变量要展示出各个赋值的频数的数值。

GPT回复:

评论:突然觉得SPSS不香了啊!

(4)特征可视化

咒语:请用合适的图可视化每一列特征,要求能直观地展示数据分布。

GPT回复:

评论:这数据分析的效率,有点可怕。

(5)单因素分析

咒语:本例数据中,A列为应变量(分为两组0和1),其余列为自变量。请对每一列的自变量进行单因素分析,判断两组之间的自变量是否存在统计学差异。

GPT回复:

评论:看来SPSS可以卸载了。

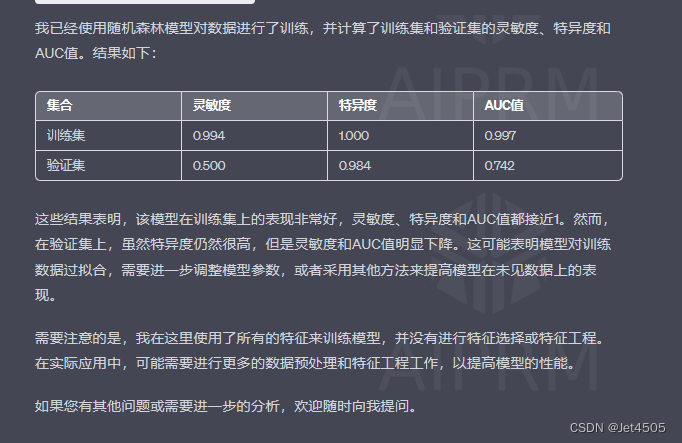

(6)建立随机森林分类模型

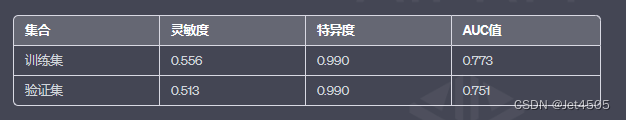

咒语:本例数据中,A列为应变量(分为两组0和1),其余列为自变量。请以A为应变量,其余为自变量建立随机森林模型(你自己自行进行特征工程)。并以表格的形式展示训练集和验证集的灵敏度、特异度和AUC值。

GPT回复:

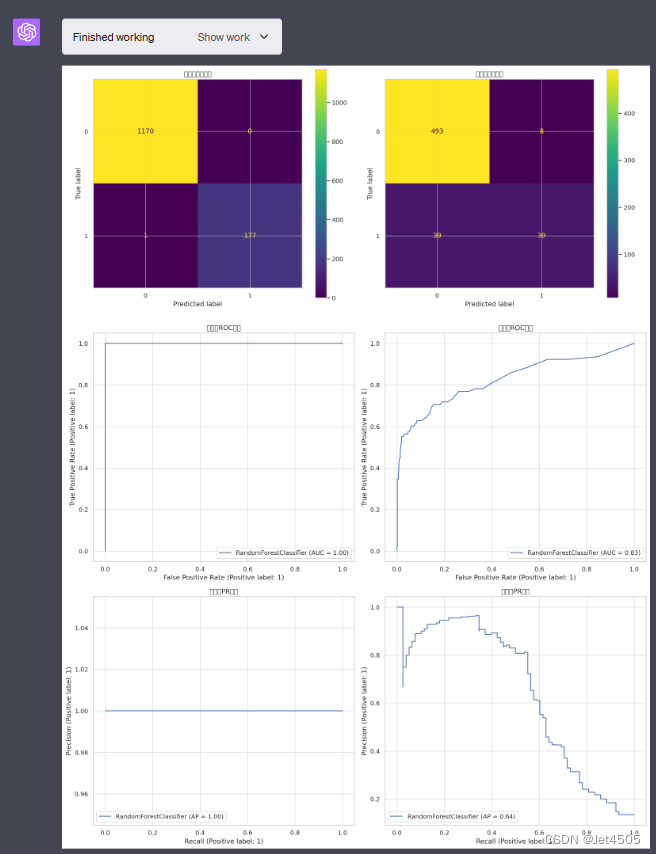

咒语:画出训练集和验证集的混淆矩阵、ROC曲线和PR曲线。

评论:跪了。

(7)优化随机森林分类模型

咒语:改善模型,优化验证集的过拟合,并以表格的形式展示训练集和验证集的灵敏度、特异度和AUC值。同时给出优化方案。

GPT回复:

我通过网格搜索方法优化了随机森林模型的参数,以改善模型在验证集上的过拟合问题。优化后的模型参数如下:

最大深度(max_depth): 10

最小样本分割(min_samples_split): 10

最小样本叶片(min_samples_leaf): 4

树的数量(n_estimators): 100

优化后的模型在训练集和验证集上的灵敏度、特异度和AUC值如下:

可以看出,优化后的模型在验证集上的性能有所提升,过拟合现象得到一定程度的缓解。然而,由于数据的不平衡性和模型的复杂性,模型的灵敏度仍然不高。在这种情况下,我们可以尝试其他的方法来进一步优化模型,例如使用更复杂的模型(如梯度提升树或神经网络)、进行更多的特征工程(如创建新的特征或进行特征选择)、使用过采样或欠采样等方法来处理数据的不平衡性,或者调整模型的决策阈值来改变模型的灵敏度和特异度。

(8)优化随机森林分类模型

咒语:请帮我更换其他模型进行测试,并以表格的形式展示训练集和验证集的灵敏度、特异度和AUC值。同时给出优化方案。

GPT回复:

我已经使用了逻辑回归、支持向量机、K近邻和决策树四种模型对数据进行了训练,并计算了训练集和验证集的灵敏度、特异度和AUC值。结果如下:

可以看出,逻辑回归和支持向量机在验证集上的表现比随机森林模型稍好一些。K近邻模型的表现相似,但略低一些。决策树模型在训练集上的表现完美,但在验证集上的表现明显下降,这是典型的过拟合现象。

四、写在最后

也不要惊慌,还是有缺陷的:

(1)不能联网:需很多新的算法不能用,例如Xgboost;

(2)专业性强:首先你得知道怎么数据分析,才能驾驭TA。因此,本底知识还得学习。

(3)对咒语要求较高:老生常谈了,得说清楚你的需求和目的;

(4)结果需要核对:毕竟是在后台算的,正确率有多高,需要谨慎对待。

然而,还是惊艳到了很多人啊。这个还是测试版,被限制了太多,谁知道给与TA足够多的权限,会发生什么哦,细思极恐。

初步尝鲜到此为止,后续我还会慢慢测试。。。。。。