热门标签

热门文章

- 1Python魔法方法指南_python 魔法报错

- 2树莓派wiringPi库,串口通信_树莓派io口应用wiringpi

- 3vue2.x el-table二次封装支持编辑修改_vue2封装一个通用表格组件

- 4学习笔记---内部类_内部类算字段吗

- 5Android通过lame进行音频格式转换_lame android mp3转pcm

- 6Spark:DataFrame使用_scala spark dataframe contains 函数

- 711-java安全——java反序列化CC5和CC6链分析_cc5反序列化

- 8力扣904. 水果成篮

- 9Qwen1.5微调_运行qwen1.5 gpu out of memory

- 10数据结构—图(Part Ⅲ)—拓扑排序&关键路径_邻接矩阵的拓扑排序时间复杂度

当前位置: article > 正文

如何在huggingface上申请下载使用llama2/3模型_huggingface 下载llama2

作者:凡人多烦事01 | 2024-06-09 21:06:27

赞

踩

huggingface 下载llama2

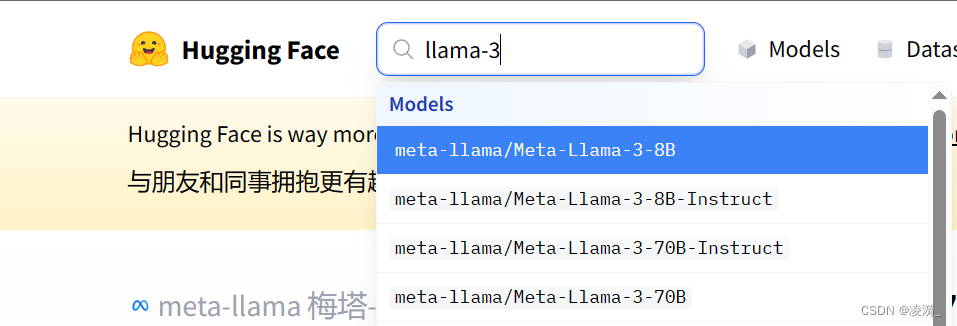

1. 在对应模型的huggingface页面上提交申请

搜索对应的模型型号

登录huggingface,在模型详情页面上,找到这个表单,填写内容,提交申请。需要使用梯子,country填写梯子的位置吧(比如美国)

等待一小时左右,会有邮件通知。

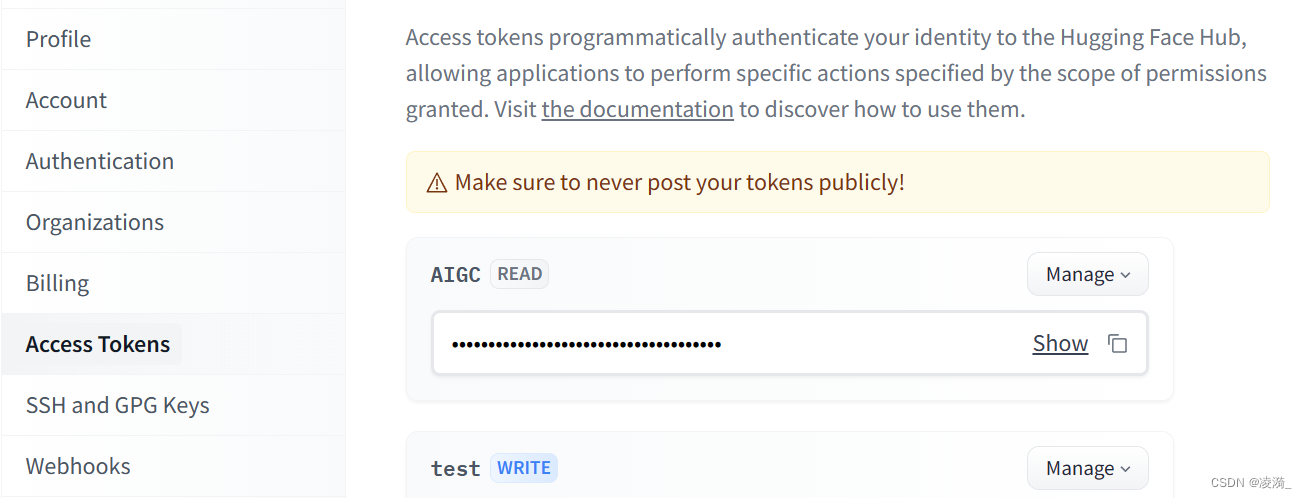

- 创建access token

在huggingface上登录后,点击头像,选择setting,点击左侧的access tokens,新建一个,然后复制。

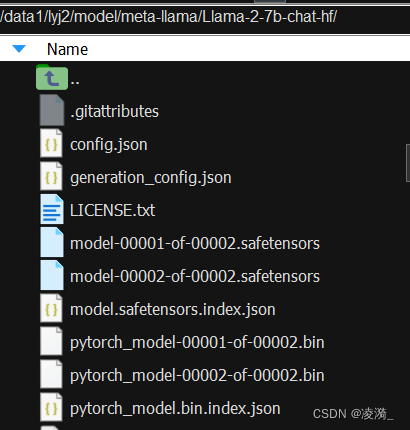

- 使用huggingface cli下载模型

pip install -U huggingface_hub

- 1

export HF_ENDPOINT=https://hf-mirror.com

- 1

huggingface-cli download --resume-download 模型名称 --local-dir 存放模型的位置 --local-dir-use-symlinks False --resume-download --token token序列号xxxxxxx

比如

huggingface-cli download --resume-download meta-llama/Llama-2-7b-chat-hf --local-dir /data1/user/model/meta-llama/Llama-2-7b-chat-hf/ --local-dir-use-symlinks False --resume-download --token xxxxx

- 1

这样就可以下载好啦

声明:本文内容由网友自发贡献,转载请注明出处:【wpsshop】

推荐阅读

相关标签