- 1linux中top性能分析工具中的TIME+_top time+

- 2一文搞懂《前后端动态路由权限》--后台控制篇_后端为什么要返回路由信息

- 3React 面试题(3)_props和state相同点和不同点?render方法在哪些情况下会执行?

- 4复习 1.c语言输入输出宽度限定_c语言, 让输出占固定宽度

- 5Git版本控制器使用教程(超详细版)_git的控制台工具

- 6Nacos_nacos 网关

- 7推荐|六个好用的前端开发在线工具

- 8Linux 常用命令汇总(详细版)_linux所有命令整理 csdn

- 9越面越退步,腾讯QQ、技术中台&;美团基础研发平台一面挂集锦_腾讯 技术中台—应用架构方向

- 10【Java 数据结构】排序

小白部署Baichuan2-7B-Chat-4bits和部署Baichuan2-7B-Chat-4bits和Baichuan2-13B-Chat手册

赞

踩

最近部署运行baichuan2,走了一些弯路,记录下来供参考。主要是遇到的问题及解决方式

部署Baichuan2-7B-Chat-4bits

基础环境:

CUDA 11.8、python3.10、torch-2.0.1+cu118-cp310-cp310-linux_x86_64.whl、xformers-0.0.22.post3-py310_cu11.8.0_pyt2.0.1.tar.bz2、transformers 4.33.1、bitsandbytes(需支持cuda118版)

腾讯云:CPU 32G、GPU 16G NVIDIA Corporation TU104GL [Tesla T4] (rev a1)

部署环境

1.创建conda环境

| conda create -n baichuan2 python=3.10 conda activate baichuan2 |

2. 进入项目目录

cd Baichuan2

下载baichuan2

|

如果觉得慢,就上网站https://github.com/baichuan-inc/Baichuan2下载后,解压到Baichuan2目录下。

![]()

安装依赖包

Bitsandbytes、xformers、PyTorch和本机的python版本、cuda版本相关,且相互之间也有关系。请正确下载,否则会出现各种意想不到的问题。

Baichuan2用到PyTorch2.0.以上的功能,否则会报错。

升级CUDA可参考https://blog.csdn.net/wangning6252820/article/details/134056484

使用4bits的话,安装量化包

| git clone https://github.com/TimDettmers/bitsandbytes.git cd bitsandbytes CUDA_VERSION=113 make cuda11x python setup.py install |

安装加速包

pip install xformers或参考https://blog.csdn.net/wangning6252820/article/details/134056100 下载安装对应版本

安装PyTorch 2.0.1

torch==2.0.1+cu118 --extra-index-url https://download.pytorch.org/whl/cu118或者参考baichuan2 Torch版本不支持CUDA-CSDN博客, 下载安装对应版本。

安装其他依赖包

pip –r requirements.txt 官网慢的话,可以从清华的镜像里下载,已经安装的可以排除

pip install -r requirements.txt -i Simple Index

下载模型文件

git clone https://huggingface.co/baichuan-inc/Baichuan2-7B-Chat-4bits如果没魔法,可以从国内镜像下载 互链高科。

共十几个文件,执行wget http://61.133.217.142:20800/download/models/baichuan-inc/Baichuan2-7B-Chat-4bits/config.json 依次下载。 大文件记得断点续传。

运行模型

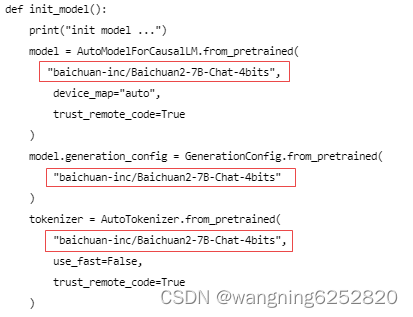

修改cli_demo.py,加载量化文件

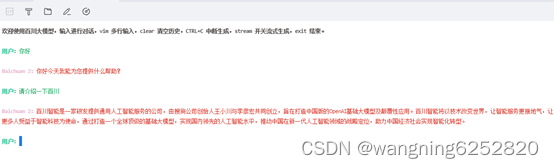

命令行交互

python cli_demo.py

界面访问

streamlit run web_ui.py, 同理需要改一下模型的目录

部署Baichuan2-13B-Chat

下载Baichuan2-13B-Chat模型

在上文的基础上,

访问互链高科,wget依次下载每个文件

运行模型

修改cli_demo.py,加载文件

模型文件放在和cli_demo.py同级目录下。

命令行和界面运行同上文

部署过程中遇到了一些问题:

baichuan2部署中,各种属性不存在的报错-CSDN博客

https://blog.csdn.net/wangning6252820/article/details/134056484

https://blog.csdn.net/wangning6252820/article/details/134056100

baichuan2 Torch版本不支持CUDA-CSDN博客

参考其他的:

玩一玩“baichuan2”,很强的中文开源模型,2060s即可流畅运行! - 知乎

https://blog.csdn.net/qq_36383272/article/details/118569105