热门标签

热门文章

- 1vue引用public文件夹中文件_vue引用public资源

- 2SpringBoot 如何使用 OAuth2 进行认证和授权_springboot oauth2

- 3各种变量的实例_自变量和应变量计算的实例代码

- 47.15 OPPO面试复盘

- 5常用的字符串函数详解

- 6最新最全的前端面试题集锦之 Ajax、Fetch、Axios 篇_fetch xhr axios相关面试题

- 7multiprocessing.dummy python使用笔记_multiprocessing.dummy处理数组

- 8【VSCode】C++环境配置(小白必看)_vscodec++环境配置

- 9Python学习-1-环境安装及IDE安装_download debug binaries(requires vs 2015 or later)

- 10核密度估计(KDE)_多维核密度估计

当前位置: article > 正文

LLM 经济学:ChatGPT 与开源, 部署像 ChatGPT 这样的 LLM 需要多少钱?开源LLM的部署成本是否更便宜?有哪些权衡?_chatglm建立知识库大概多少钱

作者:凡人多烦事01 | 2024-02-12 20:49:27

赞

踩

chatglm建立知识库大概多少钱

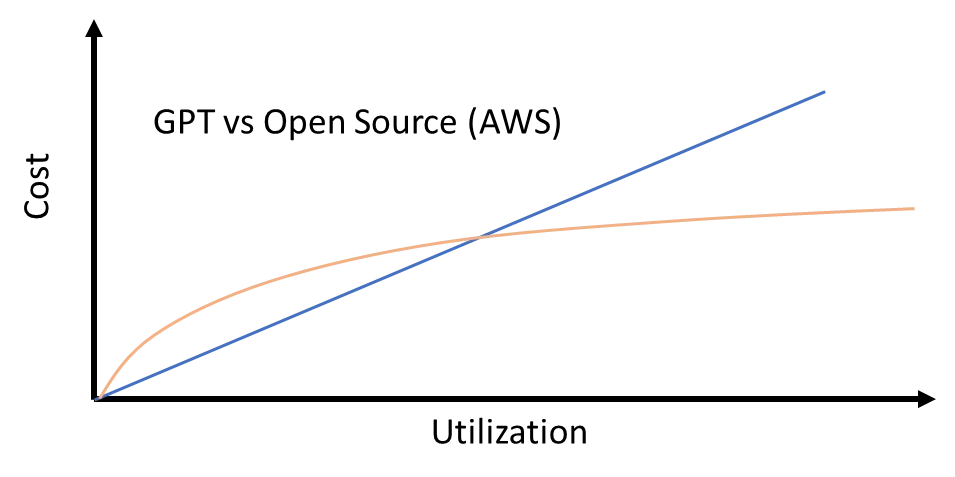

对于每天 1000 个请求范围内的较低使用量,ChatGPT 比使用部署到 AWS 的开源 LLM 更便宜。对于每天数百万个请求,部署在 AWS 中的开源模型的成本更低。(截至 2023 年 4 月 24 日撰写本文。)

大型语言模型正在席卷全球。Transformer 于 2017 年推出,随后出现了 BERT、GPT 和 BART 等突破性模型——数百个数百万个参数;能够执行多种语言任务,如情感分析、问答、分类等。

几年前,OpenAI 和谷歌的研究人员记录了多篇论文,表明具有超过数十亿个参数的大型语言模型开始显示出新兴的能力,它们似乎理解语言的复杂方面,并且它们的反应几乎与人类相似。

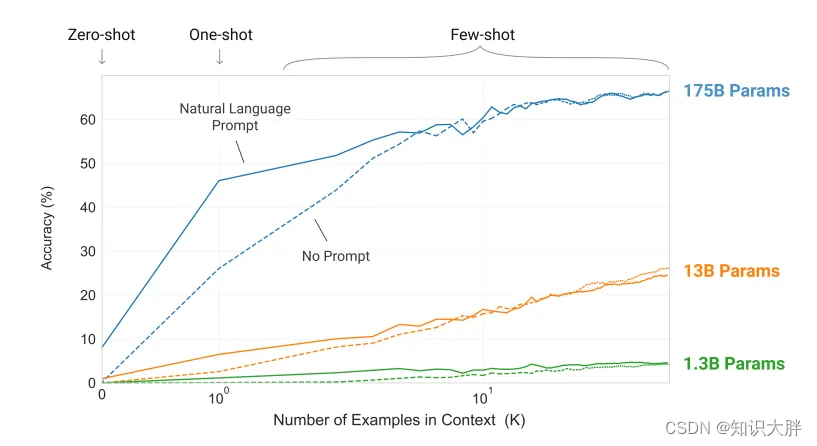

GPT-3 论文表明,参数超过 10-1000 亿的模型只需几十条提示即可显示出令人印象深刻的学习能力。

然而,这些法学硕士的资源非常密集,大规模部署在经济上具有挑战性。也就是说,直到最近 ChatGPT 的到来。ChatGPT 接口发布后不久,OpenAI 就使 ChatGPT API 变得可访问,以便开发人员可以在其应用程序中使用 ChatGPT。让我们看看这些项目的规模成本是多少以及经济可行性。

ChatGPT API 成本

ChatGPT API 按使用情况定价。其成本为 0.002 美元/1K 代币。每个令牌大约是一个单词的 3/4 — 并且单

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/78532

推荐阅读

相关标签