热门标签

热门文章

- 1绘制箱线图 与 异常值的输出 - 基于Python matplotlib库(1)_箱线图的异常值输出

- 2自然语言处理(NLP)—— 神经网络自然语言处理(Neural NLP)基础知识

- 3深入理解机器学习:概念、步骤、分类与实现_列举出两种以上机器学习什么什么过程

- 4一个初级运维工程师对于运维工作的一些浅显认知_设备运维工程师算不算研发岗

- 5数据结构(五)----特殊矩阵的压缩存储_压缩存储结构

- 6粤港澳青少年信息学创新大赛 Python 编程竞赛(初中部分知识点整理)_粤港澳青少年信息大赛初中python题目及答案

- 7深度学习图像处理04:图像分类模型训练实战——动物分类_动物分类数据集

- 8【VirtualBox】--- 从零开始搭建 Ubuntu系统 超详细

- 9MySql个人学习资料_mysql学习资料

- 10AI 大模型 | LLM 大型语言模型 VS 多模态模型_大语言模型和多模态模型

当前位置: article > 正文

NLP——attention_mlp 相似性

作者:喵喵爱编程 | 2024-06-24 15:09:12

赞

踩

mlp 相似性

https://blog.csdn.net/TG229dvt5I93mxaQ5A6U/article/details/78422216

1、什么是attention、为什么提出

模仿人脑机制,时间空间注意力

为了解决序列增长的注意力不集中的问题

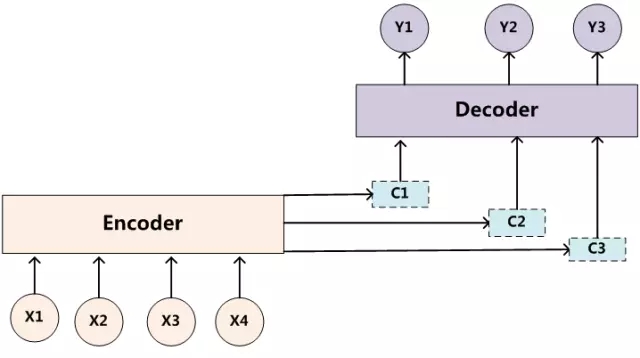

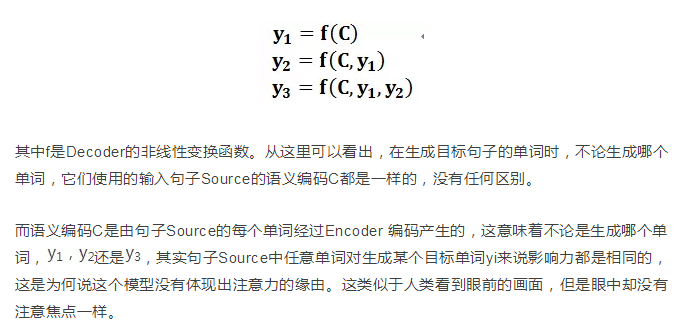

依托于encoder-decoder

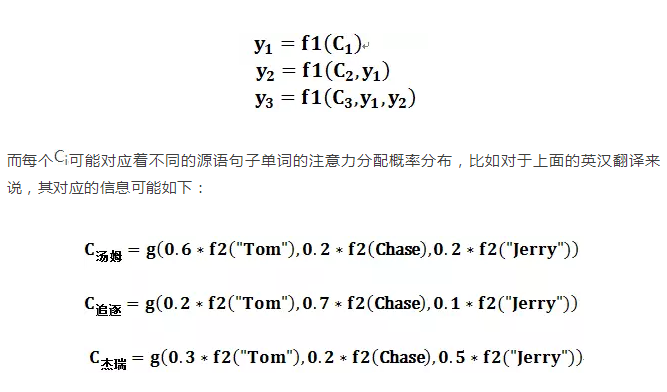

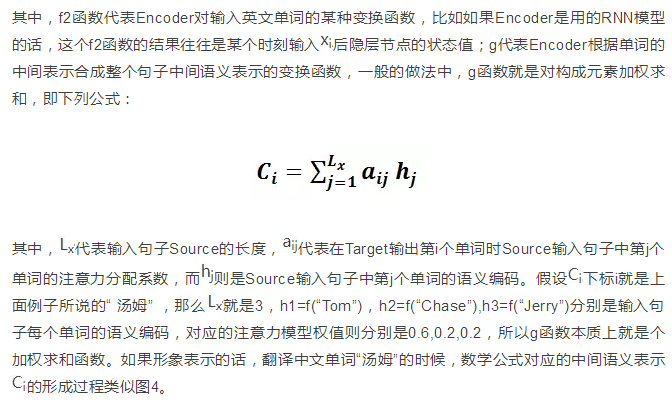

2、attention机制原理

总述

三个阶段

query/key/value

1:相似性度量 计算(点积 余弦相似度 MLP)

2:softmax归一化计算权重

3:加权求和得到中间attention语义值

引自:https://blog.csdn.net/TG229dvt5I93mxaQ5A6U/article/details/78422216

3、多头attention

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/喵喵爱编程/article/detail/753096

推荐阅读

相关标签