热门标签

热门文章

- 1Android Studio音乐播放器(使用sqlite创建数据库)_音乐播放器android studio

- 2Java NIO编程实例_java nio编程案例

- 3全网首发亲测有用:python免费将chatgpt机器人接入个人微信(同时支持钉钉、QQ 以及别的语言模型如文心一言等)_chatgpt怎么接入微信

- 4逻辑回归——牛顿法矩阵实现方式

- 5[ELK实战] Elasticsearch 聚合查询二: Bucketing/桶聚合_elk es查询时间查询

- 6辅警考试怎么搜题答案?八个受欢迎的搜题分享了 #学习方法#学习方法#媒体_千鸟搜题

- 7最优化算法之粒子群算法PSO_粒子群算法是谁提出的

- 8H3C SSH远程登录配置_h3c ssh配置

- 9第23篇 Android Studio第一个程序HelloWorld_android studio 4.2.2 helloworld

- 10Ubuntu20.04安装微信等软件全过程_ubantu20.04 安装微信

当前位置: article > 正文

MacOS本地部署codellama,并关联VSCode插件Cody AI_codellama docker

作者:喵喵爱编程 | 2024-07-04 05:20:29

赞

踩

codellama docker

Cody AI

打开 VSCode,导航到“Extension”选项卡并搜索“Cody”。,在搜索结果中找到“Cody AI”并安装“Pre Release Version”

然后,使用google账户或者github账户登录Cody:

选择您的使用目的:为个人项目

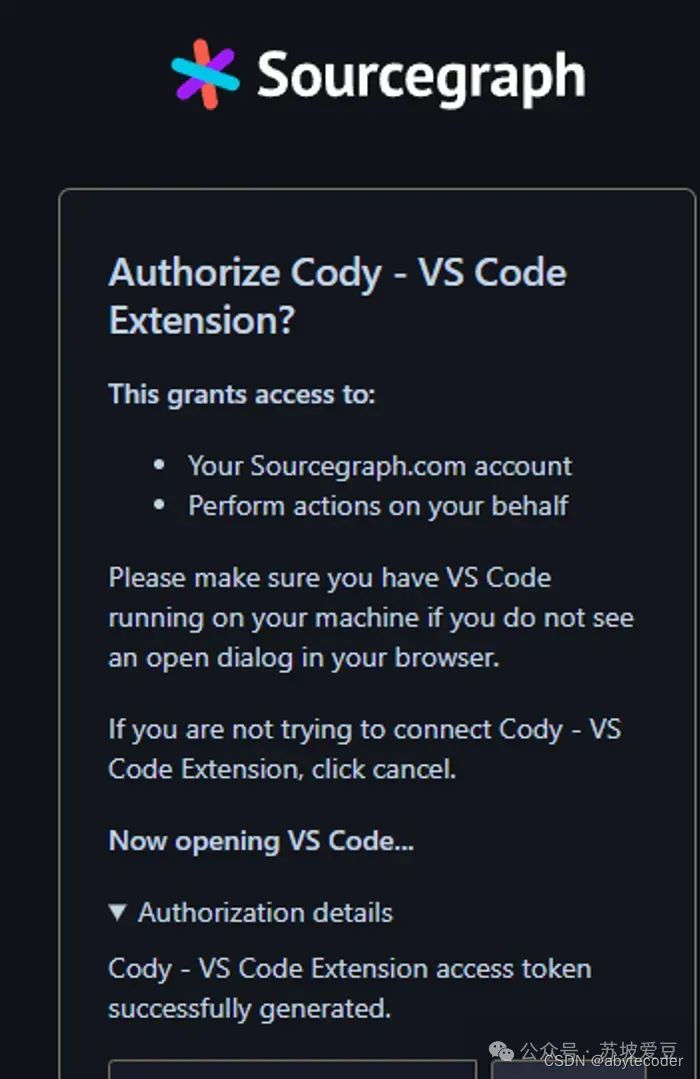

然后,授权 Cody 并复制您的 VSCode 扩展令牌

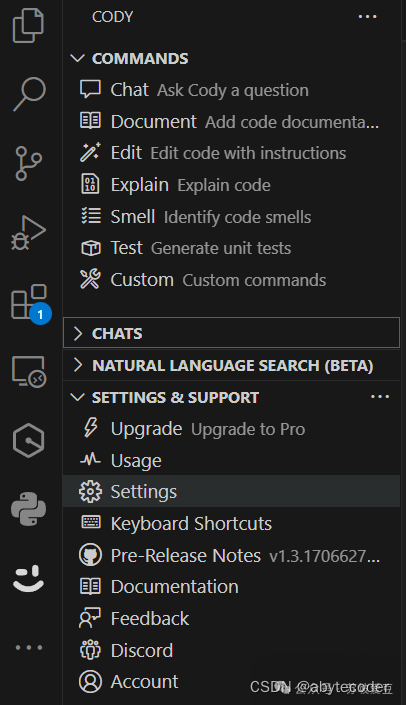

一旦获得授权,它将再次打开 VSCode:如果一切顺利,将会在左边栏看到以下可用指令:

默认情况下,Cody 使用 gpt-4,然后每月费用为 9 美元,这对于我们来说还是太贵了!因此,接下来安装Code-llama,使用本地、免费的模型替代GPT-4!

Ollama

Ollama是一个轻量级且可扩展的框架,通过提供命令行界面,可以帮助用户在本地电脑上运行、创建和管理大语言模型(LLMs),整体感觉和Docker很像。

官网:https://ollama.com/

如何使用呢?很简单,下载安装后,只需在CMD命令行窗口,执行下面的命令(比如我这里启动Google刚开源的codegemma模型),就可以启动快速下载和直接运行一个大模型。

ollama run codellama

ollama run codellama

运行后,就可以在命令行窗口进行交互了,但是整体还是不太方便,我们期待的是有个web页面可以进行交互,方便使用。

接下来,打开vscode,导航至 Cody 的“设置”

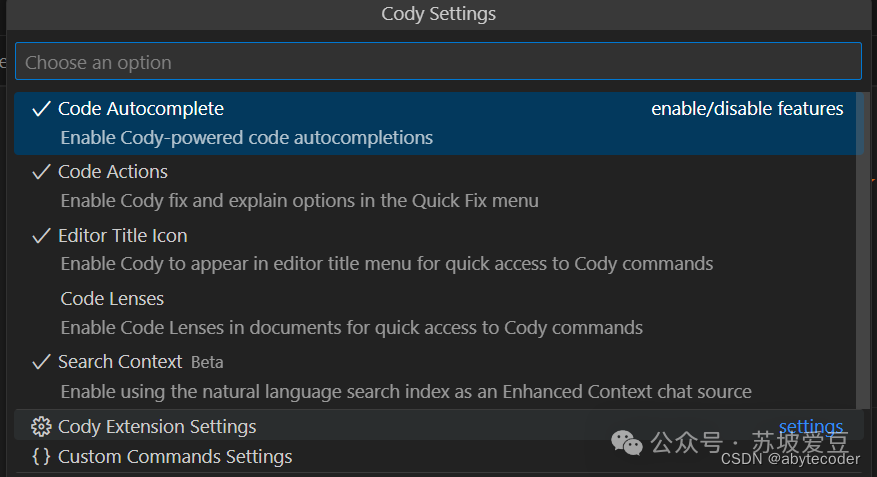

然后单击“Cody Extension Settings”:

向下滚动并找到“Cody > Autocomplete > Advanced: Provider”,然后选择“llama-code-13b”

现在,使用CodeLlama 7B的Copilot就设置好了!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/喵喵爱编程/article/detail/785762

推荐阅读

相关标签