热门标签

热门文章

- 1ClickOnce 部署中的服务器配置问题_oneclick无法与服务器建立安全连接

- 22023华为OD 面试手撕代码真题【求岛屿的个数】_华为od手撕代码题

- 3在大数据浪潮下如何高效的获取跨境电商销售数据(以亚马逊为例)

- 4实现随机函数 php,用php写随机函数的例子

- 5Visual Studio 2022安装与编译简单c语言以及C#语言(番外)_visual studio2022安装教程c语言和c#

- 6SpringMVC源码解析(二):请求执行流程

- 7安全组授权对象设置_安全组掩码

- 8FL Studio 24.1.1.4234破解版水果软件2024最新Crack安装包及补丁包_fl studio crack

- 9python使用 tkinter + you-get 实现视频下载器以及 pyinstaller 打包时的问题_用tkinter写出you-get下载器界面

- 10[python多版本管理] pyenv-win 详细安装和使用

当前位置: article > 正文

Llama3 mac本地部署教程_download ollama

作者:喵喵爱编程 | 2024-07-31 19:18:32

赞

踩

download ollama

1.下载的软件清单:

ollama下载:

nodejs下载:

2.安装

安装Ollama

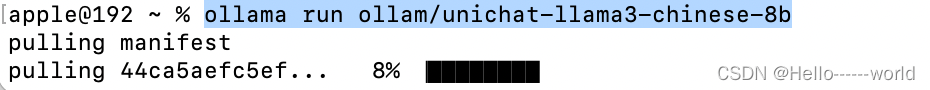

下载之后打开,直接点击Next以及Install安装ollama到命令行。安装完成后界面上会提示ollama run llama2,不需要执行这条命令,因为我们要安装llama3 的中文模型:

- #这是默认的模型:

- ollama run llama3

- #这是中文模型:

- ollama run ollam/unichat-llama3-chinese-8b

等待下载完成,这时候可以去安装web页面;

安装WebUI

- git clone https://github.com/ollama-webui/ollama-webui-lite.git

- cd ollama-webui-lite

- npm install

- npm run dev

之后访问 localhost:3000

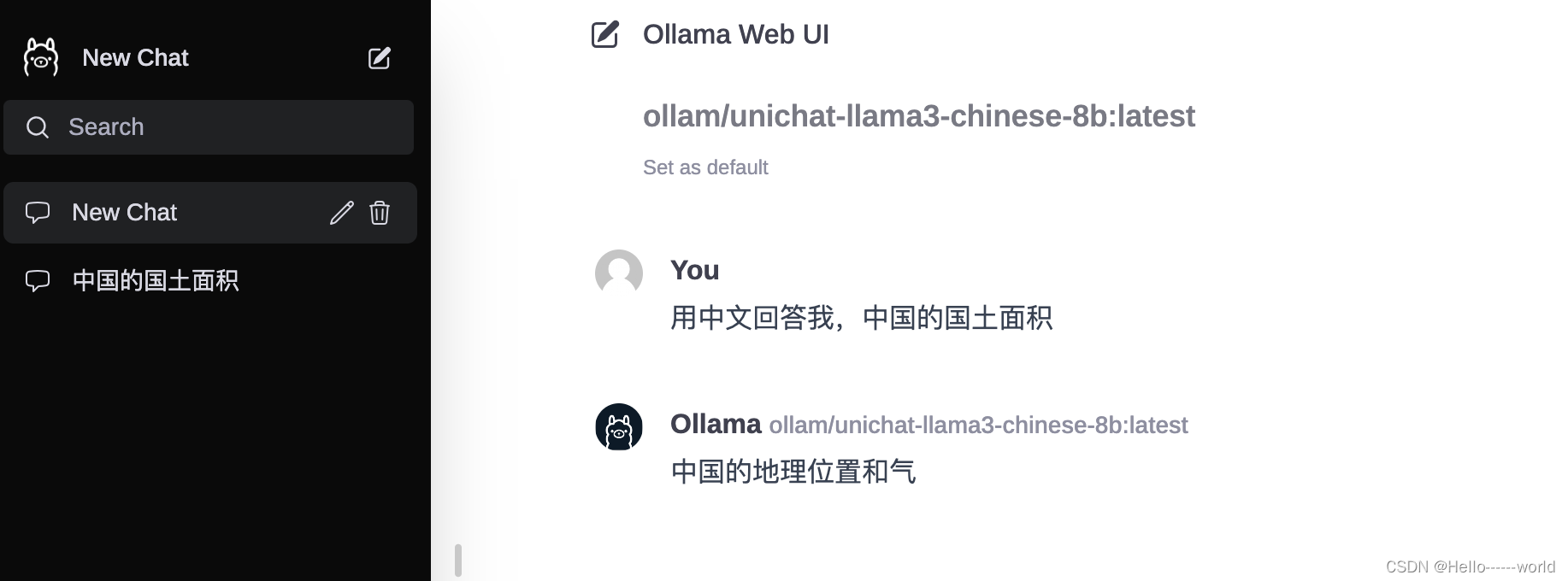

选择我们下载好的模型 即可实现本地化部署;

选择你的本地模型:

效果展示:

我的电脑跑这个模型还是很吃力的。。。时间很久

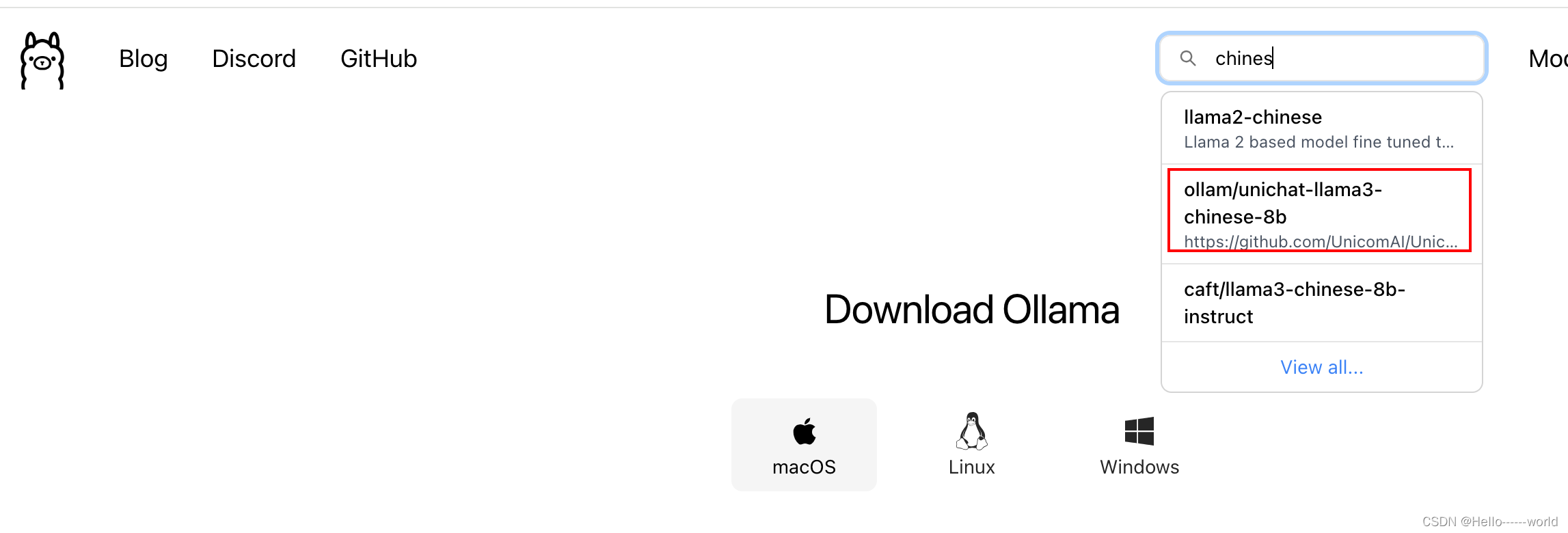

如果想下载别的模型可以在这里进行搜索

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/喵喵爱编程/article/detail/910356

推荐阅读

相关标签