热门标签

热门文章

- 1MySQL多条语句同时执行_mysql支持多语句同时执行吗

- 2百度开源进行时

- 3com.mysql.jdbc.Driver 和 com.mysql.cj.jdbc.Driver的区别以及设定serverTimezone

- 4孙宇晨大举进驻NFT艺术的背后:区块链+艺术还能有怎样的玩法?_nft与实体

- 5微信自定义菜单的创建(微信账号绑定功能的实现 Java)_java 账号绑定微信

- 6解决recaptcha、cloudflare、incapsula验证问题_突然有了cloudflare验证

- 7二本4年测龄年仅25岁,五面阿里(定薪25K)....._阿里巴巴测试开发工程师工资

- 8微信小程序抢票脚本

- 9在mybatis中处理集合、循环、数组和in查询等语句的使用_mybatis 循环数组

- 10mysql同一机器安装8.3和5.73版本步骤_mysql安装5.7和8.3

当前位置: article > 正文

最新开源对话大模型glm-4-9b-chat本地部署使用_glm-4-9b-chat 下载

作者:在线问答5 | 2024-07-07 01:17:57

赞

踩

glm-4-9b-chat 下载

简介

GLM-4-9B 是智谱 AI 推出的最新一代预训练模型 GLM-4 系列中的开源版本。 在语义、数学、推理、代码和知识等多方面的数据集测评中,GLM-4-9B 及其人类偏好对齐的版本 GLM-4-9B-Chat 均表现出较高的性能。 除了能进行多轮对话,GLM-4-9B-Chat 还具备网页浏览、代码执行、自定义工具调用(Function Call)和长文本推理(支持最大 128K 上下文)等高级功能。 本代模型增加了多语言支持,支持包括日语,韩语,德语在内的 26 种语言。我们还推出了支持 1M 上下文长度(约 200 万中文字符)的模型。

本文以glm-4-9b-chat为例,部署环境如下:

Ubuntu 22.04.4 LTS

显卡 RTX 4090(Nvidia驱动550.78)

内存 32G

- 1

- 2

- 3

部署步骤

1.glm4代码下载

git clone https://github.com/THUDM/GLM-4

- 1

2.模型文件下载(大约36G)

# 安装git lfs大文件存储插件

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash

apt install git-lfs

# 激活插件

git lfs install

# 下载模型文件

git clone https://www.modelscope.cn/ZhipuAI/glm-4-9b-chat.git

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

3.修改trans_cli_demo.py指向模型所在路径

vim trans_cli_demo.py

# MODEL_PATH修改为如下,/root/glm-4-9b-chat换成你的模型目录

MODEL_PATH = os.environ.get('MODEL_PATH', '/root/glm-4-9b-chat')

- 1

- 2

- 3

- 4

4.运行模型

# 安装python虚拟环境

cd /root

apt install python3.10-venv

mkdir -pv .virtualenvs/glm-4-9b-chat

python -m venv .virtualenvs/glm-4-9b-chat

source /root/.virtualenvs/glm-4-9b-chat/bin/activate

# 安装依赖包,依赖包有很多,耐心等待安装完成

cd /root/GLM-4/basic_demo

pip install -r requirements.txt

# 运行模型

python trans_cli_demo.py

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

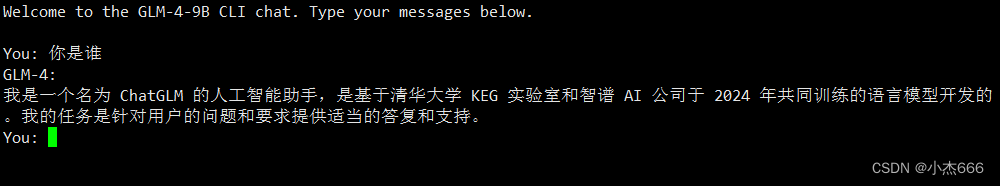

然后可以像下面这样跟glm-4-9b-chat对话(在4090上模型的回答速度还是很快的):

同时,你还可以用nvtop命令看到有一个进程在GPU上运行:

完!

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/在线问答5/article/detail/794496

推荐阅读

相关标签