- 1文心一言降重效果 快码论文_文心一言降重诀窍

- 2java计算机毕业设计(附源码)学生信息管理系统(ssm+mysql+maven+LW文档)

- 3Kafka怎么保证消息发送不丢失_kafka 生产者和消费者怎么保证不丢消息

- 4国密算法SM3

- 5常见开源许可证_弱著佐权类许可证

- 6pyglet python播放视频有声音_播放器播放rtsp混合流正常,python代码播放有杂音

- 7Prim算法:最小生成树的构建_prim算法怎么构建最小生成树

- 8paddleocr - 数据集制作_paddleocr数据集格式

- 9阿里、腾讯、字节、京东、美团、百度......薪资职级大比拼

- 10【xml解析】的学习_xml语言 sph

马尔科夫链与强化学习:不可分割的联盟_强化学习和马尔可夫链

赞

踩

马尔科夫链与强化学习:不可分割的联盟

在探索机器学习和人工智能的领域中,强化学习(RL)和马尔科夫链(MC)的结合是一个非常重要且常见的组合。很多研究和应用中,马尔科夫链都被视为理解和实施强化学习的关键工具。

马尔科夫链基础

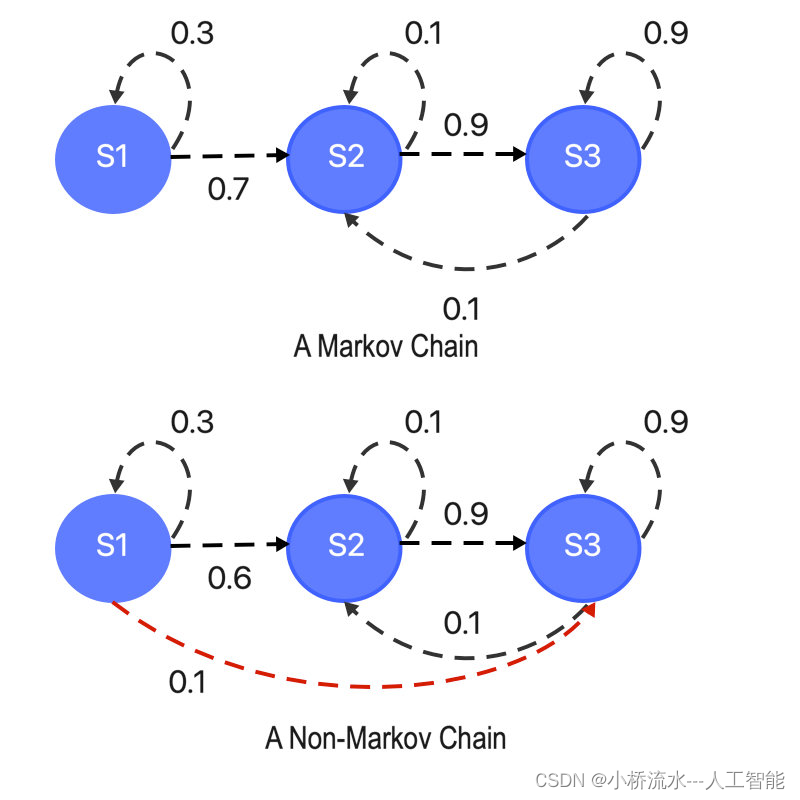

首先,我们需要理解马尔科夫链的基本概念。马尔科夫链是描述一个系统在给定状态下转移到下一个状态的概率模型。它的核心特性是无记忆性,即下一个状态的概率仅依赖于当前状态,而不依赖于之前的状态历史。

强化学习概述

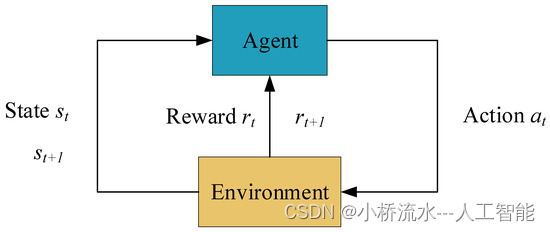

强化学习是一种学习方法,其中一个智能体通过与环境互动来学习如何最大化某种累积奖励。它通常涉及决策过程,在这个过程中,智能体需要在给定的状态下选择动作,然后环境响应这些动作并反馈新的状态和奖励。

马尔科夫链与强化学习的结合

为什么使用马尔科夫链?

强化学习经常涉及决策过程,这些过程可以自然地用马尔科夫链来描述。 在强化学习中,智能体的每个动作都可能改变未来的状态,而这些状态转移符合马尔科夫属性——即未来的状态仅依赖于当前状态和在该状态下采取的动作。这种性质使得马尔科夫链成为建模和解决RL问题的理想工具。

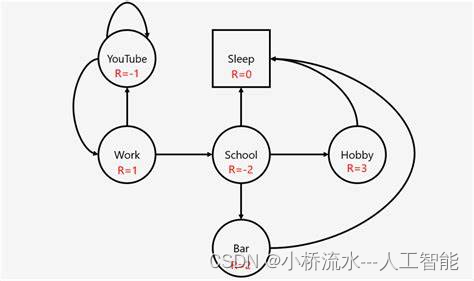

马尔科夫决策过程(MDP)

在强化学习中,马尔科夫决策过程提供了一个框架,用于处理具有马尔科夫性质的决策问题。MDP是一种特殊的马尔科夫链,它在标准的马尔科夫链模型中加入了行动(动作)和奖励的概念,使之成为决策过程。每一个决策点都涉及到选择最佳的动作来最大化未来的预期奖励。

状态和动作的选择

在RL中,智能体在每个时间步选择动作,这可以视为在马尔科夫链中移动的过程。智能体的目标是通过这些动作来优化其从环境中获取的总奖励。这种优化通常需要评估在特定状态下采取不同动作的长期影响,这正是MDP框架解决的问题。

马尔科夫链的作用

- 预测:通过分析状态转移概率,预测未来状态的分布。

- 决策:帮助智能体学习在每个状态下采取哪个动作能最大化长期奖励。

- 优化:提供算法(如Q-learning, DQN等)的数学基础,用于寻找最优策略。

强化学习中的应用示例

- 游戏玩耍:如下棋和电子游戏,智能体学习每个位置的最佳动作。

- 机器人导航:在复杂环境中找到最优路径。

- 自动驾驶汽车:决策制定在不断变化的道路情况下如何行驶。

结论

马尔科夫链在强化学习中的应用是不可或缺的,它提供了处理决策过程中不确定性的强有力工具。 理解马尔科夫链和强化学习之间的关系对于深入掌握这一领域的理论和实践至关重要。希望本篇博客能帮助您深入了解马尔科夫链在强化学习中的应用,并激发您进一步探索这一引人入胜的主题。