- 1Linux内核编译与安装_内核编译依赖工具安装

- 2Weisfeiler-Lehman(WL)算法和WL Test的学习笔记

- 3软考高级 真题 2014年上半年 信息系统项目管理师 综合知识_信息系统2014年上半年l为外资软件公司高级项目经理,负责

- 4每日AIGC最新进展(31):新加坡国立大学提出视频生成人类评估协议、加州大学提出视频生成测试基准TC-Bench、清华大学提出视频编辑新方法COVE

- 5Fiddler的安装和使用,PC和手机端抓包快速入门教程

- 6MAC 安装 protobuf_libprotobuf.28.dylib

- 7M1/M2 通过VM Fusion安装Win11 ARM,解决联网和文件传输

- 8pmp考试是什么?有没有含金量?值得考吗?(附2023 年考试时间、备考资料)

- 9feign.codec.EncodeException: Could not write request: no suitable HttpMessageConverter found【已解决】_caused by: feign.codec.encodeexception: could not

- 10面试必问的41道 SpringBoot 面试题,不看亏大了!_springboot管理系统导师会问什么

[国产大模型简单使用介绍] 开源与免费API_大模型 api 免费

赞

踩

个人博客:Sekyoro的博客小屋

个人网站:Proanimer的个人网站

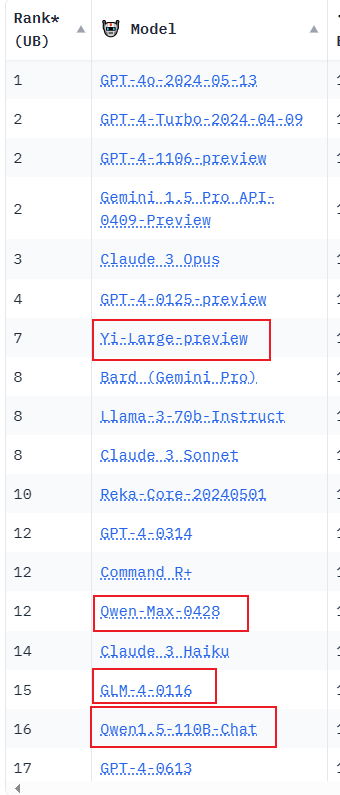

随着大模型技术蓬勃发展和开源社区越来越活跃,国内的大模型也如雨后春笋一般.这时,一些就会问了,有了llama3,Mistral还有Gemma等等,国外大厂接连发力,一些开源社区也会有一些不错的模型,国内怎么比?对一个人使用,ollama或者gpt4all直接本地使用,对于一个组,使用1panel+ollama+maxKBHome · 1Panel-dev/MaxKB Wiki (github.com)部署在内网 也成了最佳搭配. 国内大模型怎么比?

我想说的是,确实. 国内厂商也纷纷意识到了这些问题,这些大模型彷佛一夜之间成了garbage,因为一个人根本没有必要同时使用多个功能类似的大模型,除非搞多Agent工作流,也就是给一个任务,任务分步骤的让多个大模型解决,这些大模型之间还能互相协作. 当然,这方面还需要继续发展.

但不可否认的是,国内大模型能力貌似并没有超过国外大厂,此外审查力度不能说更宽松, 国内大模型根据一些报告已经达到了200多个,有高校研究所的,也就大厂的. 这些大模型比来比去, 现在看来已经意义不大的,对于它们来说,目前能否找到好的场景和建立良好的社区,才是能实现盈利的第一步,没有大厂背书的模型,等着开源然后期待在社区中焕发第二春吧.

国内商用目前最出名效果也最好的应该是GLM4了,可惜不开源,我目前对于不开源的模型不太感兴趣,一个是目前API价格还没有完全打下来,没有必要支付这些,如果真要付钱为啥不用GPT4呢? 说到付钱,可以考虑OpenRouter,Azure等平台使用GPT4.

所以对于国内大模型来说,我会首选开源,其次免费API的模型.

后者作为开发者来说非常方便,直接调用就是(但是可能限制比较大),不需要自己搞个VPS部署,即使硬件要求不高.

OpenSource

下面介绍几个国内开源大模型,主要用途就是跟ollama搭配进行部署本地,不过我猜测这些模型应该进行过国内特色微调,所以不要过于期待比较diverse的结果.

通义千问

阿里旗下的,目前开源的最大110B,非常不错.

ChatGLM3

清华的THUDM/ChatGLM3: ChatGLM3 series: Open Bilingual Chat LLMs | 开源双语对话语言模型 (github.com),目前有商用的GLM4,但是ollama截止目前貌似没有支持.

零一万物

开源最大的34B,勉强能用.

DeepSeek-V2

| 模型 | 开源/闭源 | 总分 | 中文推理 | 中文语言 |

|---|---|---|---|---|

| gpt-4-1106-preview | 闭源 | 8.01 | 7.73 | 8.29 |

| DeepSeek-V2 Chat (RL) | 开源 | 7.91 | 7.45 | 8.36 |

| erniebot-4.0-202404 (文心一言) | 闭源 | 7.89 | 7.61 | 8.17 |

| DeepSeek-V2 Chat (SFT) | 开源 | 7.74 | 7.30 | 8.17 |

| gpt-4-0613 | 闭源 | 7.53 | 7.47 | 7.59 |

| erniebot-4.0-202312 (文心一言) | 闭源 | 7.36 | 6.84 | 7.88 |

| moonshot-v1-32k-202404 (月之暗面) | 闭源 | 7.22 | 6.42 | 8.02 |

| Qwen1.5-72B-Chat (通义千问) | 开源 | 7.19 | 6.45 | 7.93 |

| DeepSeek-67B-Chat | 开源 | 6.43 | 5.75 | 7.11 |

| Yi-34B-Chat (零一万物) | 开源 | 6.12 | 4.86 | 7.38 |

| gpt-3.5-turbo-0613 | 闭源 | 6.08 | 5.35 | 6.71 |

| DeepSeek-V2-Lite 16B Chat | 开源 | 6.01 | 4.71 | 7.32 |

这是一个强大的专家混合(MoE)语言模型,具有训练经济、推理高效的特点。它由 236B 个参数组成,其中 21B 个参数用于激活每个标记。与 DeepSeek 67B 相比,DeepSeek-V2 性能更强,同时节省了 42.5% 的训练成本,减少了 93.3% 的 KV 缓存,最大生成吞吐量提高到 5.76 倍。

讯飞星火

在iFlytekSpark-13B中,使用Rotary Embedding作为位置编码方法,GELU作为激活函数,其中layer_num为40,head_num为40,hidden_size为5120,ffn_hidden_size为28672

说真的,上面这些大模型吹来吹去,一般来说参数量一样的情况下真的有差别吗? 使用的时候不必太纠结.

免费API

主要得益于大模型如过街老鼠,哦不对,雨后春笋,实在太多,对于大厂来说又无法完全盈利. 一般主打AI大模型的公司可能并不会开源或者非常低的价格提供API服务,但是一些大厂可能就不一样了.

百度有ERNIE和千帆两款大模型,文心大模型ERNIEKit旗舰版 - ERNIE 3.0介绍 | 百度AI开放平台 (baidu.com)

目前ERNIE可以免费了,而阿里的Qwen也降价至0.0005/1K tokens. 对于开发者还是很友好的. 比如你如果害怕疯狂调用、IP频繁改变被OpenAI ban掉,那也可以考虑使用国产的大模型API.

在线服务

如果自己部署缺硬件性能也嫌麻烦,除了Poe之外,国内的大模型很多也都支持在线问答了,比如Kimi,GLM等.

参考资料

- Chat with Open Large Language Models (lmsys.org)

- 大概是最全的开源大模型LLM盘点了吧! - 知乎 (zhihu.com)

- CLiB中文大模型能力评测榜单(持续更新) - 知乎 (zhihu.com)

如有疑问,欢迎各位交流!

服务器配置

宝塔:宝塔服务器面板,一键全能部署及管理

云服务器:阿里云服务器

Vultr服务器

GPU服务器:Vast.ai