热门标签

热门文章

- 1机器人外呼相比人工外呼优势有哪些

- 2android11 SurfaceFlinger 服务启动分析_android 11 surfaceflinger

- 3关于PostMan中Tests脚本的使用_postman tests脚本

- 4【整理】【Learn Git Branching】02 高级篇_learngitbranching.js.org通关

- 5swift定义iOS数据库框架1——创建数据库_swift数据库框架

- 62024年Web前端最新基于web的机票管理系统设计与实现(一)(1),2024年最新Web前端面试没项目经验_飞机管理系统的前端

- 7挑战与机遇:GPT模型的局限性与技术突破_gpt应用的技术难点

- 8家电专用降压DC-DC方案PL8310

- 9超星答案怎么查找? #经验分享#微信#其他

- 10SAR信号处理基础1——线性调频信号

当前位置: article > 正文

Dropout的原理与细节?_dropout为什么在推理时要删除

作者:天景科技苑 | 2024-07-14 21:28:19

赞

踩

dropout为什么在推理时要删除

1. 什么是Dropout?

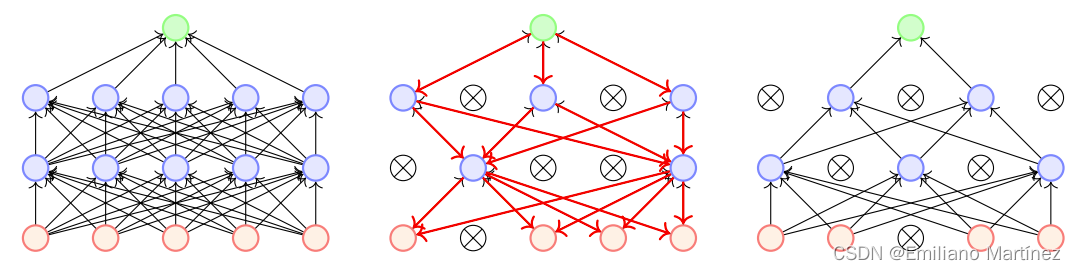

Dropout是通过使得每个神经元以一定的概率停止工作来接缓解过拟合问题。dropout(随机失活):dropout是通过遍历神经网络每一层的节点,然后通过对该层的神经网络设置一个keep_prob(节点保留概率),即该层的节点有keep_prob的概率被保留,keep_prob的取值范围在0到1之间。通过设置神经网络该层节点的保留概率,使得神经网络不会去偏向于某一个节点(因为该节点有可能被删除),从而使得每一个节点的权重不会过大,有点类似于L2正则化,来减轻神经网络的过拟合。

2. Dropout反向传播时如何处理?

反向传播时,忽略掉被dropout的神经元。即如果某个神经元被dropout,那么这个神经元以及与他相连接的前面的所有神经元通过这个路径计算的梯度都是0【并不意味着总梯度是0,因为前面的神经元可能还连接了别的神经元】。即:被暂时删除的神经元本次不进行更新

3. Dropout为什么能够缓解过拟合?

(1)由于每次都会随机删除一个节点,下一层的节点就不会太依靠上一层的某个节点,也就是说它再分配权重的时候,不会给上一层的节点分配很高的权重,有点像L2正则的作用。这样的话,某个节点就不会太依赖与某些局部的特征,模型的泛化能力就更强。

(2)Dropout可以看作是不同模型的集成。Dropout每次随机失活一些神经元,相当

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/天景科技苑/article/detail/826345

推荐阅读

相关标签