- 1Python3教程,从三流Python外包到秒杀阿里P7

- 2C++实现TCP服务器端同时和多个客户端通信(多线程)_windows下c++ tcp服务端多客户端

- 3SpringCloud(三)Eureka服务注册与发现《2》(actuator与Eureka自我保护)_actuator和eureka的关系

- 4FairyGUI-Cocos Creator官方Demo源码解读

- 5mysql binlog查看工具_MySQL日志文件

- 6微软账户和本地账户有什么区别?如何切换登录账户?_电脑本地账户和微软账户的区别

- 7Linux——僵尸进程以及僵尸进程的处理

- 8uniapp 微信小程序中image的mode属性详解_小程序 image mode

- 9单细胞测序系列之三:单细胞转录组测序

- 10力扣算法刷题顺序_力扣刷题顺序

视频生成赛道王者归来!Runway 最新 Gen-3 Alpha 炸场_runway gen 3

赞

踩

作者 | 王轶群,王启隆

出品丨AI 科技大本营(ID:rgznai100)

视频生成大模型赛道强者接连诞生。

继 Vidu、快手可灵、Luma AI 轮番炸场后,又一位 Sora 挑战者来了!

这次是由视频生成领域的核心玩家 Runway 宣布即将推出的 Gen-3 Alpha。

据 Runway 官方介绍,Gen-3 Alpha 是其推出的最新视频生成基础模型,“第三代 Alpa 是高保真、可控视频生成的新前沿”。

Runway 表示,Gen-3 Alpha 能生成具有复杂场景变化、多种电影风格选择以及详细艺术指导的高质量视频。

“Gen-3 Alpha 是 Runway 在全新大规模多模态训练基础设施上训练的首个模型,标志着我们在构建通用世界模型(General World Models)目标上的重要进展。”该公司强调。

话不多说,先上官方视频——来看看由 Gen-3 Alpha 制作的一个完整视频短片长什么样?场面恢弘,大片既视感!

简单提示词,即可诞生影视级画面

提示词:一个超速行驶的日本城市列车,窗户上映射出一个女人的微妙倒影。

可以看到,人物面部柔和自然,倒影的沿路光线在女人面部丝滑流转,光影效果堪比影视片段。

提示词:一位宇航员在里约热内卢的小巷中奔跑。

宇航员运动流畅,其运动速度与两边街景的倒退速度基本一致,整体画面毫无违和感。

提示词:第一人称视角(FPV)穿过森林,到达一座废弃的房子,然后进入海浪。

镜头一路纵深,从幽静森林到古建筑藏书阁,再到石柱长廊,直到海浪直接冲刷进来。这场景转化,在传统影视制作上,应该需要不少技术及经费,而在 Runway Gen-3 Alpha 的官方演示中,只需一句提示词描述。

提示词:一名老年男子在侧光下弹钢琴。

手指纹路、身体摆动、衣服褶皱,还有光源由远及近的变化,就好像在摄影棚拍摄的一样。

提示词:在 1980 年代风格的厨房里,镜头以电影般的缓缓推移,最终聚焦于一只站立的鸵鸟。

复古的陈列及光线下,一只鸵鸟活灵活现,同时运镜也很稳。时光穿越和奇妙组合,在简单提示词下就这样轻松实现了。

Runway 官方表示,以上视频皆由 Gen-3 Alpha 生成,未经任何修改。

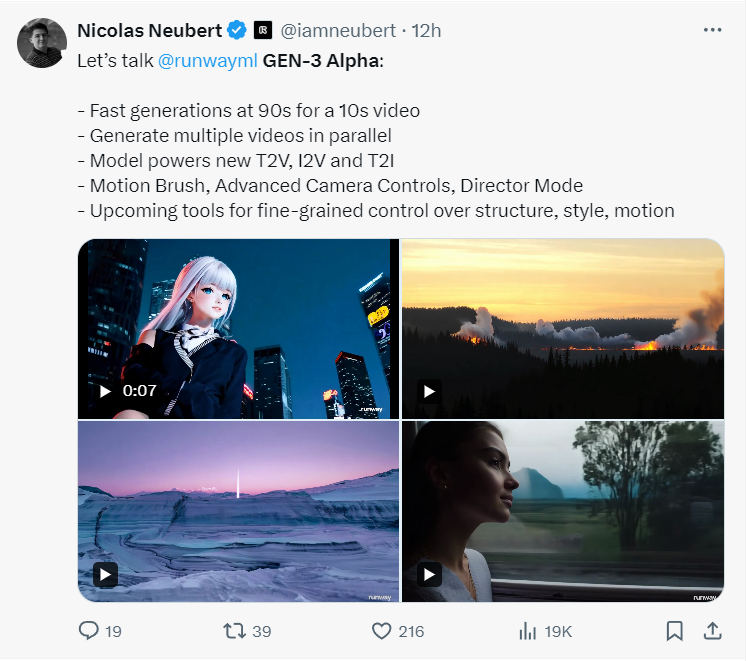

该公司介绍道, Gen-3 Alpha 在视频和图像上联合训练,将支持 Runway 的文本转视频、图像转视频和文本转图像工具,还包括现有的控制模式如运动刷、先进摄像机控制和导演模式,以及即将推出的更多精细控制结构、风格和运动的工具。

从其官网的几个视频 demo 的展示来看,效果确实不错。

跨学科团队支持,为创意而生

只有单人的微场景视频吗?

不,Gen-3 Alpha 可以整场演唱会!

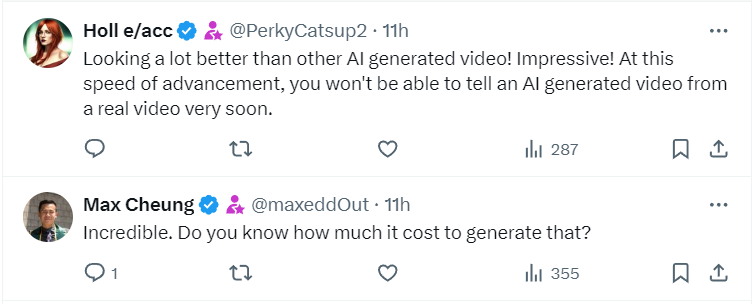

其热闹非凡的效果,多人躁动的场面,舞台灯光的快速变化,以及航拍到近场的视角,让网友直呼效果炸裂、迫不及待想尝试:“看起来比其他 AI 生成的视频好多了!令人印象深刻!以这样的发展速度,你很快就无法区分 AI 生成的视频和真实视频了。” “难以置信。你知道生成这个要花多少钱吗?”

还有网友表示想去听演唱会、震惊没有长得一样的两人:“我肯定会去听那场音乐会。看起来很有趣。” “让我吃惊的是,视频中包含的粒子或信息的数量(例如人数)不会让视频花费更多的推理/计算时间,我的假设是正确的,对吧?只有视频长度会花费更多的计算时间,对吧?这真是令人吃惊!” “没有两个人长得一模一样!”

官方表示,Gen-3 Alpha 为创意和创作而生,是为创意应用从头开始训练的。

为什么能生成如此效果炸裂而又流畅自然的视频?

其背后的跨学科研究团队的付出不容忽视。据 Runway 介绍,训练 Gen-3 Alpha 是一支由研究科学家、工程师和艺术家组成的跨学科团队的合作成果。这样团队支持,能让 Gen-3 Alpha 诠释各种风格和电影术语。

据 iamneubert 的 Nicolas Neubert 透露,Gen-3 Alpha 模型的生成速度非常之快。官方分享的演示视频普遍徘徊在 10 秒水平线上,而这 10 秒视频只需要 90 秒的时间就能快速生成。

Runway Gen-3 Alpha 具备以下功能特点:

-

高保真视频生成:能够生成接近真实世界质量的视频内容,具有高度的细节和清晰度。

-

精细动作控制:模型能够精确控制视频中对象的动作和过渡,实现复杂场景的流畅动画。

-

逼真人物生成:特别擅长生成具有自然动作、表情和情感的逼真人类角色。

-

多模态输入:支持文字转视频、图像转视频、文字转图像等多种创作方式。

-

支持专业创作工具:支持运动画笔、相机控制和导演模式等专业创作工具。

-

高质量训练:使用高描述性的、时间密集的字幕进行训练,使模型能够理解和生成具有丰富时间动态的视频。

“这一技术的飞跃代表了我们在支持艺术家创新方面的重要里程碑,为下一代创意和艺术创新铺平了道路。” Runway 表示。

同时,Gen-3 Alpha 还将配备一套新的安全措施,包括改进的内部视觉审核系统和 C2PA 溯源标准,以确保内容的安全可靠。

为创作而生的 Gen-3 Alpha 还开启了行业定制模式。Runway 还表示:“作为 Gen-3 模型家族的一部分,我们与领先的娱乐和媒体组织合作,推出了 Gen-3 Alpha 的定制版本。”

Gen-3 模型的定制化使角色能够实现更多风格化控制和一致性,满足特定的艺术和叙事需求。

跟 Gen-2 相比,Gen-3 在细节、一致性和运动表现方面有了显著改进。要知道,包括《黑寡妇》《瞬息全宇宙》等知名电影都运用了 Runway 的技术支持。Gen-3 将为影视创作带来怎样的效果和便利,我们拭目以待。

即将开放和更多的竞争

等不及了,什么时候可以试用?

官方表示,Gen-3 Alpha 将在未来几天内向所有人开放。对此,用户和 AI 业界大佬都好评不断、一片欢腾。

Hugging Face 联合创始人兼 CEO Clément Delangue 表示:“太酷了!谁将成为因开源视频收获百倍影响力的幸运儿?”

PyTorch 之父 Soumith Chintala 表示:“部分视频演示已达到 Sora 级别。不过我还想看到它生成人群拥挤的街道一类的短视频来看看效果如何。”

而上文提到的演唱会人群视频,也从侧面证明了其效果。

然而,也有人对其安全性表示了质疑。

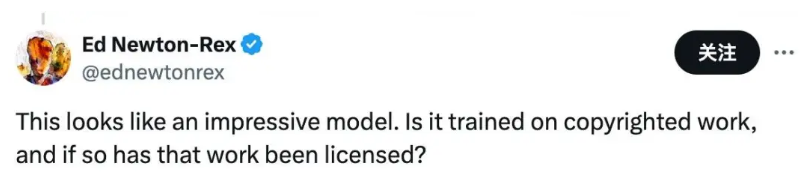

Fairly Trained 公司首席执行官 Ed Newton-Rex 表示:“这看起来是一个令人印象深刻的模型。它是否接受过受版权保护的作品的训练?如果是,该作品是否已获得许可?”

他曾任Stability AI 音频副总裁,也是一位作曲家。

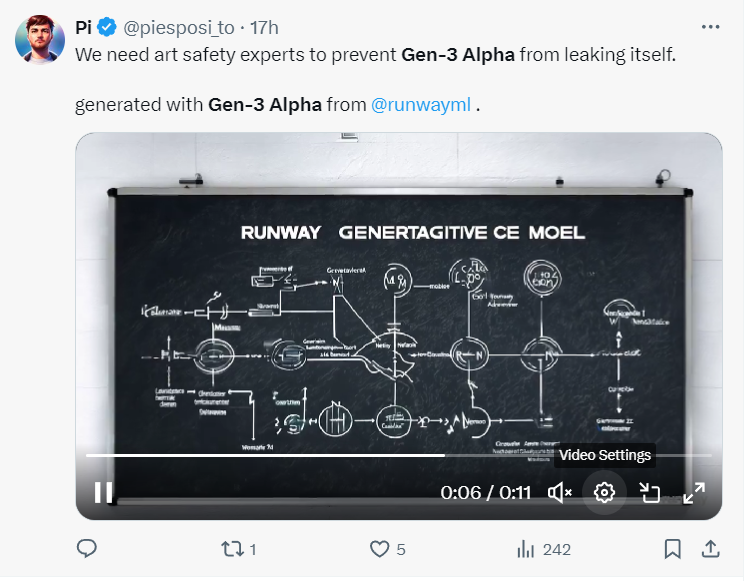

还有网友表示:“我们需要艺术安全专家来防止Gen-3 Alpha自我泄露。”

Runway是AI视频生成领域的先行者,2023年2月Runway发布第一代视频生成模型Gen1,支持视频风格转绘;随后在2023年3月发布Gen2,拉开了文生视频和图生视频的序幕。

这一次的 Gen-3 Alpha 发布能否让王者重回视频生成帝王宝座?

不可忽视的是,目前视频生成赛道竞争者众多。就在 Gen-3 Alpha 官宣的当天,Luma AI 宣布 Dream Machine 即将带来更强大的编辑功能和更直观的操作体验。

谷歌也不甘示弱,其人工智能研究实验室 DeepMind 表示正在开发用于为视频生成配乐的人工智能技术。谷歌在社交平台 X 上宣布推出新的模型技术 Video-to-audio,该技术支持根据视频和文本提示词生成和视频匹配的音频,甚至可以与主体角色唇形同步。

官方 demo 中,该技术为弹吉他视频生成的配乐,与人物动作极其一致,且配乐动听。

多重工具的争相改进和发布,将为创组者和用户带来多重选择,同时也会反向激励更多新模型新技术的诞生。视频生成大模型百花齐放,争奇斗艳,Runway的此次 Gen-3 Alpha 也会一定程度上续写其核心玩家的新华章。

参考链接:

https://runwayml.com/blog/introducing-gen-3-alpha/

https://mp.weixin.qq.com/s/ud_ZbZFMGu1SYSYYExPWDA

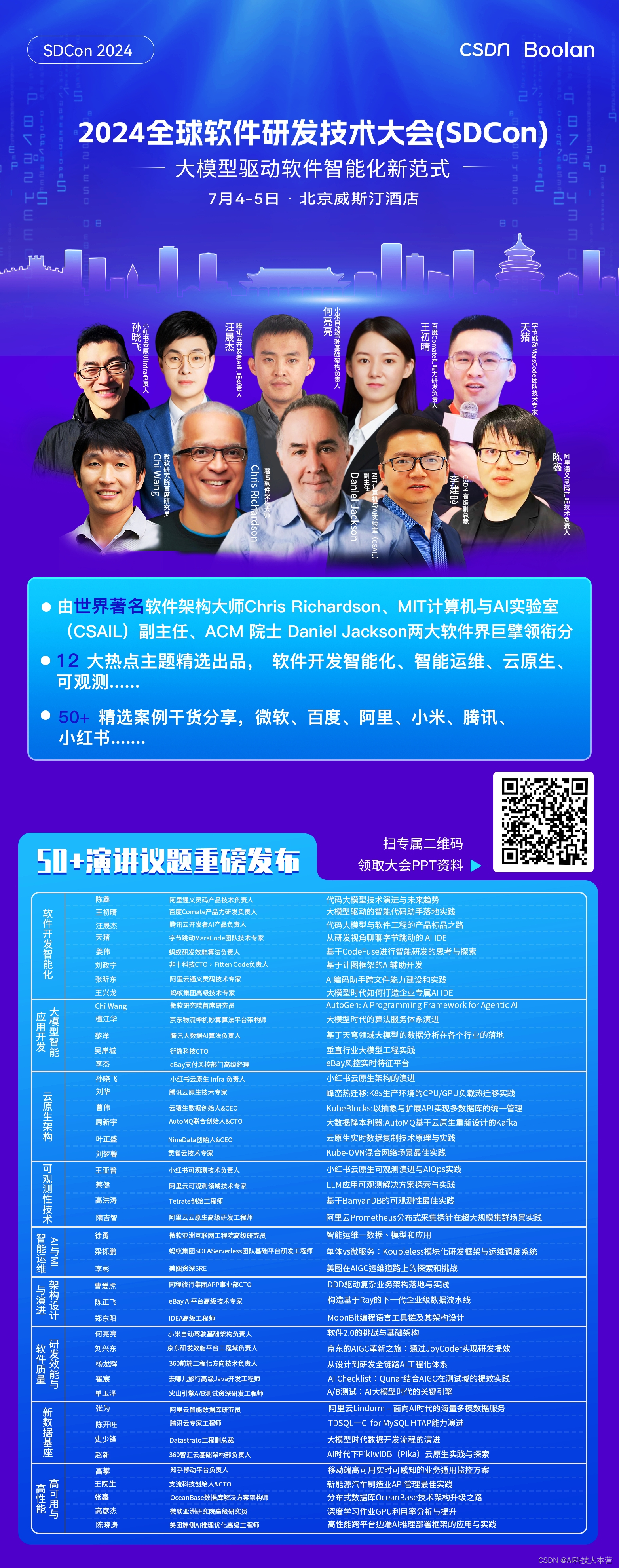

由 CSDN 和 Boolan 联合主办的「2024 全球软件研发技术大会(SDCon)」将于 7 月 4 - 5 日在北京威斯汀酒店举行。

由世界著名软件架构大师、云原生和微服务领域技术先驱 Chris Richardson 和 MIT 计算机与 AI 实验室(CSAIL)副主任,ACM Fellow Daniel Jackson 领衔,BAT、微软、字节跳动、小米等技术专家将齐聚一堂,共同探讨软件开发的最前沿趋势与技术实践。

大会官网:http://sdcon.com.cn/