Kafka集群搭建与SpringBoot项目集成_springboot kafka集群

赞

踩

本篇文章的目的是帮助Kafka初学者快速搭建一个Kafka集群,以及怎么在SpringBoot项目中使用Kafka。

kafka集群环境包地址:百度网盘 请输入提取码 提取码:x9yn

一、Kafka集群搭建

1、准备环境

(1)准备三台LINUX服务器:

xxx.xxx.xxx.1

xxx.xxx.xxx.2

xxx.xxx.xxx.3

(2)jdk版本大于1.8即可,我是1.8.0_181

(3)在三台服务器上创建用户admin,将环境放到admin用户下,嫌麻烦的同学也可以直接使用root用户安装(真实生产上不建议这么做)

tips:LINUX怎么给普通用户赋文件夹操作权限?

- 切换到root用户

- 使用chown -R admin:admin /home/admin命令

- 执行su - admin命令就可以切换用户并定位到/home/admin下

(4)一定要关闭三台服务器的防火墙,不然安装肯定会出问题,切记!这个真的很重要!

2、搭建Zookeeper集群

(1)解压zookeeper-3.4.12.tar.gz,进入zookeeper文件夹

(2)进入conf文件夹

1)复制zoo.cfg文件 cp zoo.cfg zoo_sample.cfg 2)修改zoo.cfg文件 vim zoo.cfg

这里的3个IP的作用如下:

2181:对cline端提供服务

3888:选举leader使用

2888:集群内机器通讯使用(Leader监听此端口)

(3)进入data文件夹,若没有自己创建一个

在data文件夹下创建myid文件,三台机器分别填入server对应的ID,这里我是1、2、3

(4)启动zookeeper集群

- 1. 启动ZK服务: sh bin/zkServer.sh start

- 2. 查看ZK服务状态: sh bin/zkServer.sh status

- 3. 停止ZK服务: sh bin/zkServer.sh stop

- 4. 重启ZK服务: sh bin/zkServer.sh restart

(5)三台机器都需要重复上述操作,注意myid中的ID要对应

3、搭建Kafka集群

(1)解压kafka_2.12-2.5.0.tgz,进入kafka文件夹

(2)进入config文件夹,修改 server.properties内容

- # Kafka使用唯一的一个整数来标识每个broker,该参数默认是-1。如果不指定,kafka会自动生成一个唯一值

- broker.id=1

- # broker监听器的CSV列表,格式是[协议]://[主机名]:[端口]。

- listeners=PLAINTEXT://xxx.xxx.xxx.1:9092

- # 非常重要的参数!该参数指定了kafka持久化消息的目录。该参数可以设置多个目录,以逗号分隔,比如/home/kafka1,/home/kafka2,多目录的做法是推荐的

- log.dirs=/tmp/kafka-logs

- # 同样是很重要的参数!这个参数完全没有默认值,是必须要自己设置的

- zookeeper.connect=xxx.xxx.xxx.1:2181,xxx.xxx.xxx.2:2181,xxx.xxx.xxx.3:2181

- # 是否开启unclean leader选举。由于开始可能不能保证数据一致性,所以设置为false

- unclean.leader.election.enable=false

- # topic 在当前 broker 上的分区个数

- num.partitions=1

- # 用来恢复和清理 data 下数据的线程数量

- num.recovery.threads.per.data.dir=1

- # segment文件保留的最长时间,超时将被删除

- log.retention.hours=16

- # 删除 topic 功能使能 ( 允许删除数据 ) ( 手动指定 )

- delete.topic.enable=true

- # 处理网络请求的线程数量

- num.network.threads=3

- # 用来处理磁盘 IO 的线程数量

- num.io.threads=8

- # 发送套接字的缓冲区大小

- socket.send.buffer.bytes=102400

- # 接收套接字的缓冲区大小

- socket.receive.buffer.bytes=102400

- # 请求套接字的缓冲区大小

- socket.request.max.bytes=10485760

(3)配置环境变量

vim ~/.bash_profile

- # KAFKA_HOME

- export KAFKA_HOME=/export/servers/kafka_2.11-0.11.0.0

- export PATH=$PATH:$KAFKA_HOME/bin

(4)启动kafka集群

启动 :bin/kafka-server-start.sh config/server.properties &

关闭 :bin/kafka-server-stop.sh stop

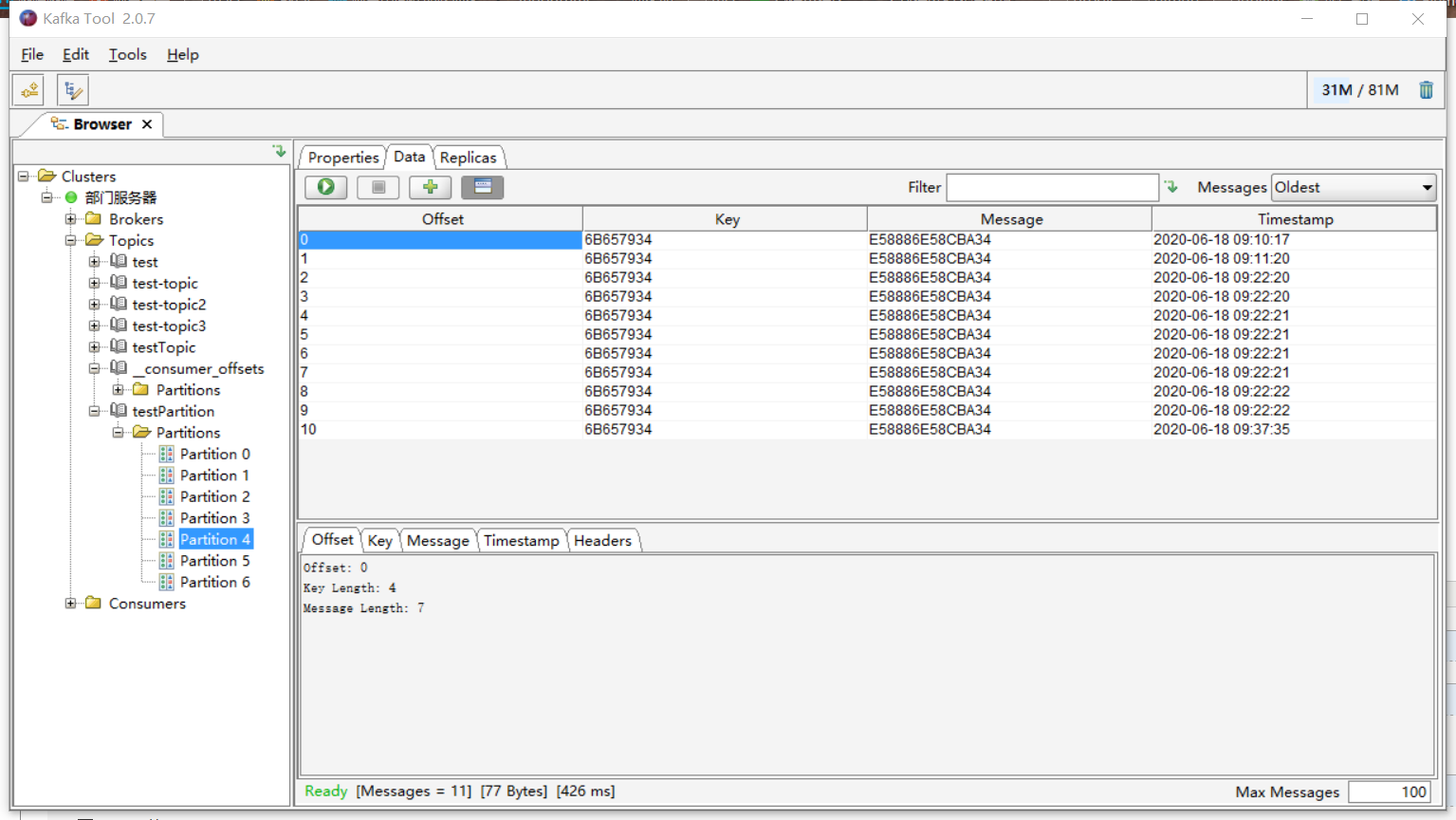

二、使用kafkatool工具操作Kafka

这里提供一篇详细操作:https://www.cnblogs.com/frankdeng/p/9452982.html

三、Kafka与SpringBoot集成

1、pom.xml导入

- <?xml version="1.0" encoding="UTF-8"?>

- <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

- xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

- <modelVersion>4.0.0</modelVersion>

- <parent>

- <groupId>org.springframework.boot</groupId>

- <artifactId>spring-boot-starter-parent</artifactId>

- <version>2.3.0.RELEASE</version>

- <relativePath/> <!-- lookup parent from repository -->

- </parent>

- <groupId>com.sunyard.bigdata</groupId>

- <artifactId>springbootkafka</artifactId>

- <version>0.0.1-SNAPSHOT</version>

- <name>springbootkafka</name>

- <description>Demo project for Spring Boot</description>

-

- <properties>

- <java.version>1.8</java.version>

- </properties>

-

- <dependencies>

- <dependency>

- <groupId>org.springframework.boot</groupId>

- <artifactId>spring-boot-starter-web</artifactId>

- </dependency>

- <dependency>

- <groupId>org.springframework.kafka</groupId>

- <artifactId>spring-kafka</artifactId>

- </dependency>

-

- <dependency>

- <groupId>org.projectlombok</groupId>

- <artifactId>lombok</artifactId>

- <optional>true</optional>

- </dependency>

- <dependency>

- <groupId>org.springframework.boot</groupId>

- <artifactId>spring-boot-starter-test</artifactId>

- <scope>test</scope>

- <exclusions>

- <exclusion>

- <groupId>org.junit.vintage</groupId>

- <artifactId>junit-vintage-engine</artifactId>

- </exclusion>

- </exclusions>

- </dependency>

- <dependency>

- <groupId>org.springframework.kafka</groupId>

- <artifactId>spring-kafka-test</artifactId>

- <scope>test</scope>

- </dependency>

- </dependencies>

-

- <build>

- <plugins>

- <plugin>

- <groupId>org.springframework.boot</groupId>

- <artifactId>spring-boot-maven-plugin</artifactId>

- </plugin>

- </plugins>

- </build>

-

- </project>

2、application.properties配置

3、启动类代码

- import org.springframework.boot.SpringApplication;

- import org.springframework.boot.autoconfigure.SpringBootApplication;

- import org.springframework.kafka.annotation.EnableKafka;

-

- @SpringBootApplication

- @EnableKafka

- public class SpringbootkafkaApplication {

- public static void main(String[] args) {

- SpringApplication.run(SpringbootkafkaApplication.class, args);

- }

- }

4、生产者代码

- import org.springframework.beans.factory.annotation.Autowired;

- import org.springframework.kafka.core.KafkaTemplate;

- import org.springframework.web.bind.annotation.*;

-

- @RestController

- @RequestMapping("/api/kafka/")

- public class KafkaController {

- @Autowired

- private KafkaTemplate<String, Object> kafkaTemplate;

- @GetMapping("send")

- @ResponseBody

- public boolean send(@RequestParam String message) {

- try {

- kafkaTemplate.send("test-topic", message);

- kafkaTemplate.send("test-topic2", message);

- System.out.println("消息发送成功...");

- } catch (Exception e) {

- e.printStackTrace();

- }

- return true;

- }

- @GetMapping("test")

- @ResponseBody

- public String test() {

- System.out.println("hello world!");

- return "ok";

- }

- }

5、消费者代码

- import org.springframework.kafka.annotation.KafkaListener;

- import org.springframework.stereotype.Component;

-

- @Component

- public class ConsumerListener {

-

- @KafkaListener(topics = "test-topic")

- public void onMessage1(String message) {

- System.out.println("我是第一个消费者:" + message);

- }

- @KafkaListener(topics = "test-topic2")

- public void onMessage2(String message) {

- System.out.println("我是第二个消费者:" + message);

- }

- }