- 1完全背包问题【动态规划】_cin>>full;

- 2Git Fork后与源作者同步更新_fork仓库会推送到作者

- 3python编写程序输入球的半径计算球的表面积和体积_编写程序,输入球体的半径,计算球体的表面积和体积并输出。半径为实数。 提示: ( 1 )球体的表面积为 S=4 π r 2 ;球体的体积为 V=4...

- 4一口气看完es(上)

- 5聊聊不再兼容安卓的鸿蒙

- 6二水源划分时的新安江模型的稳定入渗率试错法_新安江模型二水源划分

- 7Python数据分析入门(十):数据清洗和准备_数据分析:python爬虫、数据清洗和数据可视化 第十章

- 8我在群硕实习的日子_武汉群硕软件入职报道

- 9python程序设计编程题答案,python程序设计经典例题_表达式 isinstance('ass', int) 的值为?

- 10昇腾Ascend处理器相关介绍_昇腾芯片和ascend核怎么对应

[多模态大模型面试]InstructBLIP_qwen instruct

赞

踩

请详述多模态大模型如Llava、instructBLIP、Qwen-VL,以及他们之间的区别

多模态大模型 LLaVA、InstructBLIP 和 Qwen-VL 之间的主要区别如下:

- LLaVA15:

- LLaVA 是一个端到端训练的大型多模态模型,将视觉编码器和大型语言模型(LLM)连接起来实现通用的视觉和语言理解。

- LLaVA 在多模态聊天能力和科学问答任务上表现出色,相比 GPT-4 有 85.1% 的相对得分。

- LLaVA 通过 Pre-training + Instruction Tuning 的方式进行训练,大大简化了训练过程。

- InstructBLIP23:

- InstructBLIP 是基于自研的 Qwen 模型实现的大规模视觉语言模型。

- InstructBLIP 在理解、定位、文本识别等多个视觉语言任务上取得了SOTA水平。

- InstructBLIP 采用了位置感知的视觉-语言适配器来提升模型的效率和性能。

- Qwen-VL23:

- Qwen-VL 也是阿里云基于自研的 Qwen 模型实现的大规模视觉语言模型。

- Qwen-VL 在多个基准测试中达到了SOTA水平,超越了 BLIP-2、InstructBLILP 等模型。

- Qwen-VL 采用了 Vision Transformer 作为视觉编码器,并引入了位置感知的视觉-语言适配器。

总的来说, LLaVA、InstructBLIP 和 Qwen-VL 都是近期出现的强大的多模态大模型, 在视觉语言理解和生成等任务上取得了领先的性能。它们在模型结构、训练方式等方面都有一些独特的创新

InstructBLIP(Instruct-Based Language-Image Pretraining)是一种基于指令的跨模态预训练模型,它结合了自然语言处理(NLP)和计算机视觉(CV)的技术来处理和理解图像和文本。这种模型是为了解决多模态任务而设计的,比如图像描述、视觉问答(Visual Question Answering, VQA)和跨模态文本到图像的生成等。

InstructBLIP的核心特点通常包括:

-

多模态预训练:模型在大量图像和文本对上进行预训练,以学习视觉和语言之间的关联。

-

指令遵循:模型能够理解和遵循自然语言指令,这使得它在执行任务时更加灵活和准确。

-

自注意力机制:使用Transformer架构中的自注意力机制来捕捉文本和图像内的关键信息。

-

跨模态注意力:模型使用特殊的注意力机制来关联文本和图像中的内容,这有助于更好地理解两者之间的关系。

-

微调能力:在预训练完成后,InstructBLIP可以在特定任务上进行微调,以进一步提升性能。

-

生成能力:某些版本的InstructBLIP可能还包括生成模型,能够生成描述或图像。

InstructBLIP的预训练过程可能涉及以下步骤:

- 图像和文本的编码:使用CNN(卷积神经网络)或Transformer模型来编码图像,同时使用BERT或RoBERTa等模型来编码文本。

- 跨模态特征融合:将图像和文本的编码特征进行融合,以便于模型能够理解它们之间的关系。

- 指令遵循任务:模型可能会被训练来遵循与图像相关的自然语言指令,比如“描述图片中的活动”或“找出图片中的错误”。

InstructBLIP模型在处理多模态数据时,能够利用图像的视觉信息和文本的语义信息,从而在多种任务上实现更好的性能。这种模型的发展是AI领域中多模态学习和人工智能进步的重要方向之一。

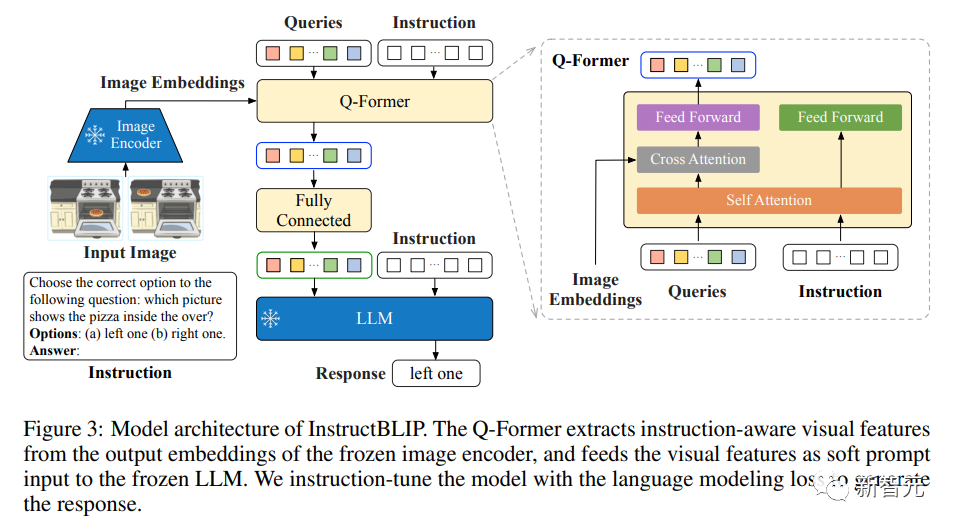

InstructBLIP是一种用于视觉-语言任务的指令微调框架,旨在通过统一的自然语言接口解决广泛的视觉语言任务。以下是根据原始论文arXiv:2305.06500对InstructBLIP架构的总结:

-

预训练模型:InstructBLIP基于预训练的BLIP-2模型,该模型由图像编码器、大型语言模型(LLM)和一个查询变换器(Query Transformer,简称Q-Former)组成,以桥接图像和语言模型。

-

指令微调:在指令微调过程中,研究人员仅对Q-Former进行微调,同时保持图像编码器和LLM的参数冻结。这样做的目的是让Q-Former能够根据给定的指令动态地提取视觉特征。

-

指令感知的视觉特征提取:InstructBLIP引入了一种新的机制,即指令感知的视觉特征提取。这意味着文本指令不仅提供给冻结的LLM,还提供给Q-Former,以便它能够从冻结的图像编码器中提取与指令相关的特征。

-

平衡数据集采样:为了处理训练数据集中数量众多和大小差异显著的问题,InstructBLIP采用了平衡采样策略,根据数据集大小的平方根比例来选择数据样本,以确保模型不会对较小的数据集过拟合,也不会对较大的数据集拟合不足。

-

模型架构:InstructBLIP的Q-Former包含一组可学习的查询嵌入,这些嵌入与图像编码器的输出通过交叉注意力机制进行交互。Q-Former的输出是一组编码的视觉向量,每个查询嵌入对应一个,然后通过线性投影送入LLM。

-

训练细节:InstructBLIP使用LAVIS库进行实现和训练。模型最多进行60K步的微调,每3K步验证一次性能。使用了AdamW优化器,并应用了线性预热和余弦衰减的学习率调度策略。

-

实验结果:InstructBLIP在13个未见数据集上进行了零样本评估,并与BLIP-2和Flamingo模型进行了比较。InstructBLIP在所有数据集上都取得了新的SOTA结果,显著超过了BLIP-2。

-

消融研究:研究人员通过移除指令感知视觉特征提取和数据平衡策略来进行消融研究,结果表明这些组件对于提高模型性能至关重要。

-

定性评估:InstructBLIP在定性评估中展现了其在复杂视觉推理、知识驱动的图像描述和多轮对话方面的能力。

-

下游任务微调:InstructBLIP在特定下游任务上的微调性能也得到了验证,与BLIP-2相比,InstructBLIP提供了更好的权重初始化模型,并在多个数据集上实现了SOTA性能。

InstructBLIP的提出,旨在通过指令微调的方法提高模型在未见任务和数据集上的泛化能力,并通过开源模型和代码促进了多模态AI研究的进一步发展。

对于LLaVA-Instruct-150K数据集,研究人员没有加入额外的指令模板,因为它是自然结构的指令格式。

现有的零样本图像到文本的生成方法,包括BLIP-2,在提取视觉特征时采取了与指令并无关系的方法。

也就是说,LLM中的视觉输入是不知道指令的,这并不利于该模型在不同任务中的灵活性。

相比之下,指令感知的视觉模型可以提高模型从不同指令中学习的能力。

举例来说,咱们考虑两种情况:输入同一图像,模型被要求完成两个不同的任务;以及,给定两个不同的图像,模型被指示完成同一任务。

在第一种情况中,一个指令感知的视觉模型可以根据指令从同一图像中提取不同的特征,在解决不同任务时呈现出更多的信息特征。

而在第二种情况中,一个指令感知的视觉模型可以利用指令中体现的共同知识来提取两个不同图像的特征,从而实现图像之间更好的信息转移。

InstructBLIP通过充分利用BLIP-2模型中的Q-Former架构,提出了一种指令感知的视觉特征提取方法。

如上图所示,Q-Former被设计用来从一个冻结的图像编码器的输出中提取视觉特征。

根据BLIP-2的论文,Q-Former已经分成两个阶段进行了预训练,通过预训练,它学会了提取可以被LLM消化的文本对齐的视觉特征。

在推理过程中,一个指令被附加在视觉提示之后,就可以指导LLM按照规定执行不同的任务。

而在InstructBLIP中,指令文本不仅作为输入给到LLM,同时也给到了QFormer。

由于训练数据集的数量众多,而且每个数据集的大小差异很大,均匀地混合这些数据集可能会导致模型在较小的数据集上过度拟合,而在较大的数据集上拟合不足。

为了缓解这样的问题,研究人员建议按照数据集的大小(即训练样本的数量)进行采样,并进行平方根平滑处理。一般来说,给定D个数据集的大小:

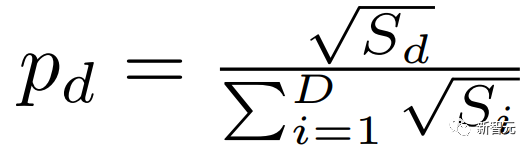

在训练期间,数据样本从数据集d中被选中的概率被表述为,

除了这个加权公式外,研究人员还对某些数据集的权重进行了手动微调,以提高其收敛性。

这是必要的环节,因为各种数据集和任务的内在差异,需要不同程度的训练强度,即使它们有类似的规模也是如此。

具体来说,研究人员降低了A-OKVQA(多选)的权重,增加了OKVQA的权重。

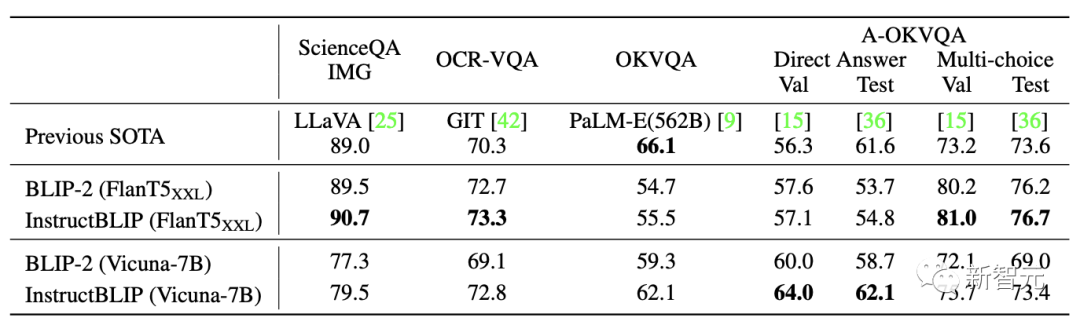

实验结果

零样本评估

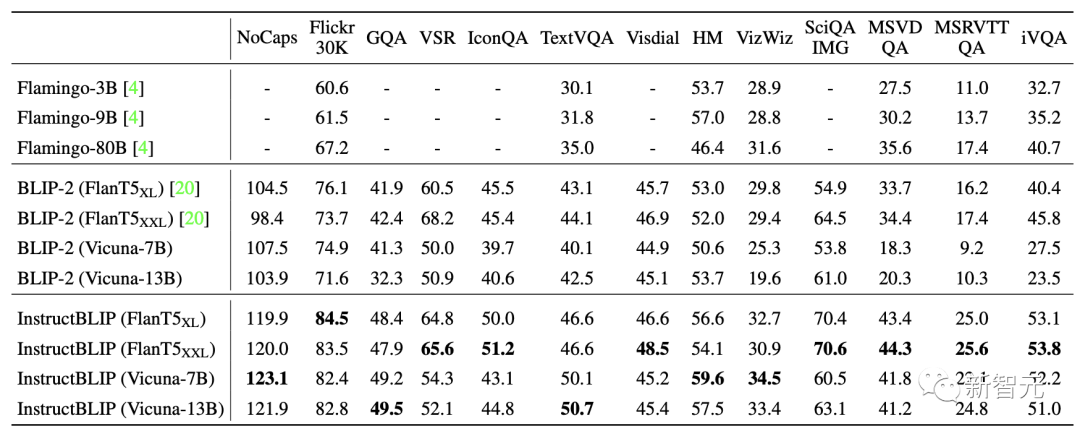

研究人员首先在13个数据集上评估InstructBLIP模型,并将InstructBLIP与之前的SOTA模型BLIP-2和Flamingo进行比较。

如表所示,InstructBLIP在所有的数据集上都取得了新的零样本的SOTA结果。

并且在所有的LLM上都超过了BLIP-2,这表明了视觉指令微调的有效性。

此外,指令微调提高了对未见过的任务类别(如视频QA)的零样本泛化能力。

尽管从未用时间视频数据进行训练,但InstructBLIP在MSRVTT-QA上比之前的SOTA提高了47.1%。

最后,研究人员用最小的InstructBLIP FlanT5XL(4B)在所有六个共享评估数据集上评估,其表现优于Flamingo-80B,平均相对改善率为24.8%。

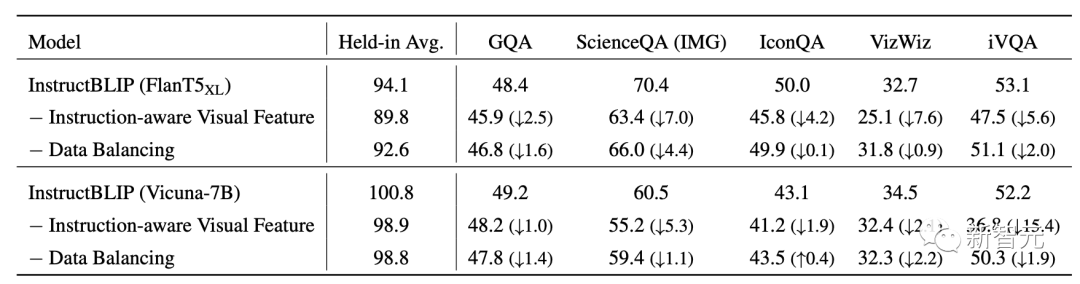

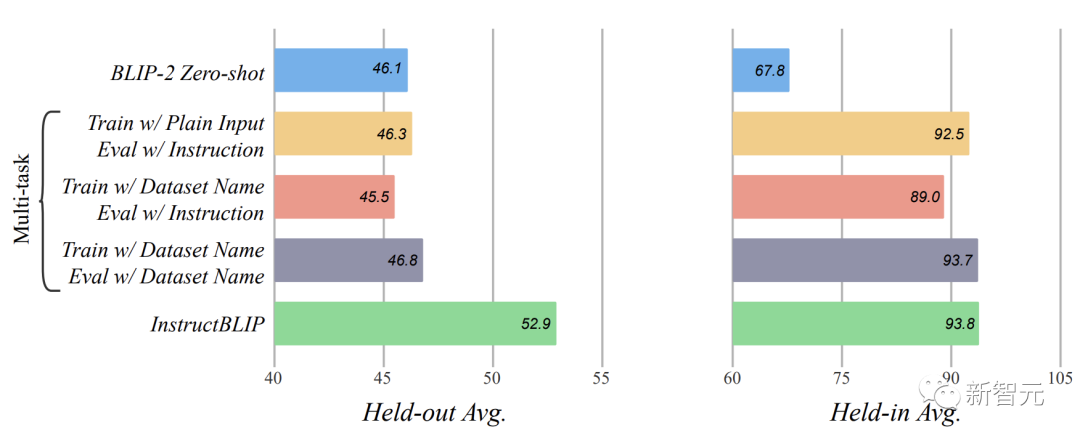

指令调优的消融研究

为了研究指令感知的视觉特征提取和数据集平衡策略的影响,研究人员通过在指令微调过程中分别移除它们来进行消融研究。

在所有的数据集中,视觉特征中缺乏指令感知会使性能明显下降。在涉及空间视觉推理(如ScienceQA)或时间视觉推理(如iVQA)的数据集中,这种性能下降更为严重。

在这些数据集中,给Q-Former输入指令可,以引导它更多地关注信息量更大的图像嵌入。

关于数据平衡策略,移除它会导致不稳定的训练模式,因为不同的数据集在明显不同的训练步骤中达到最佳性能。因此,这种不稳定性损害了整体性能。

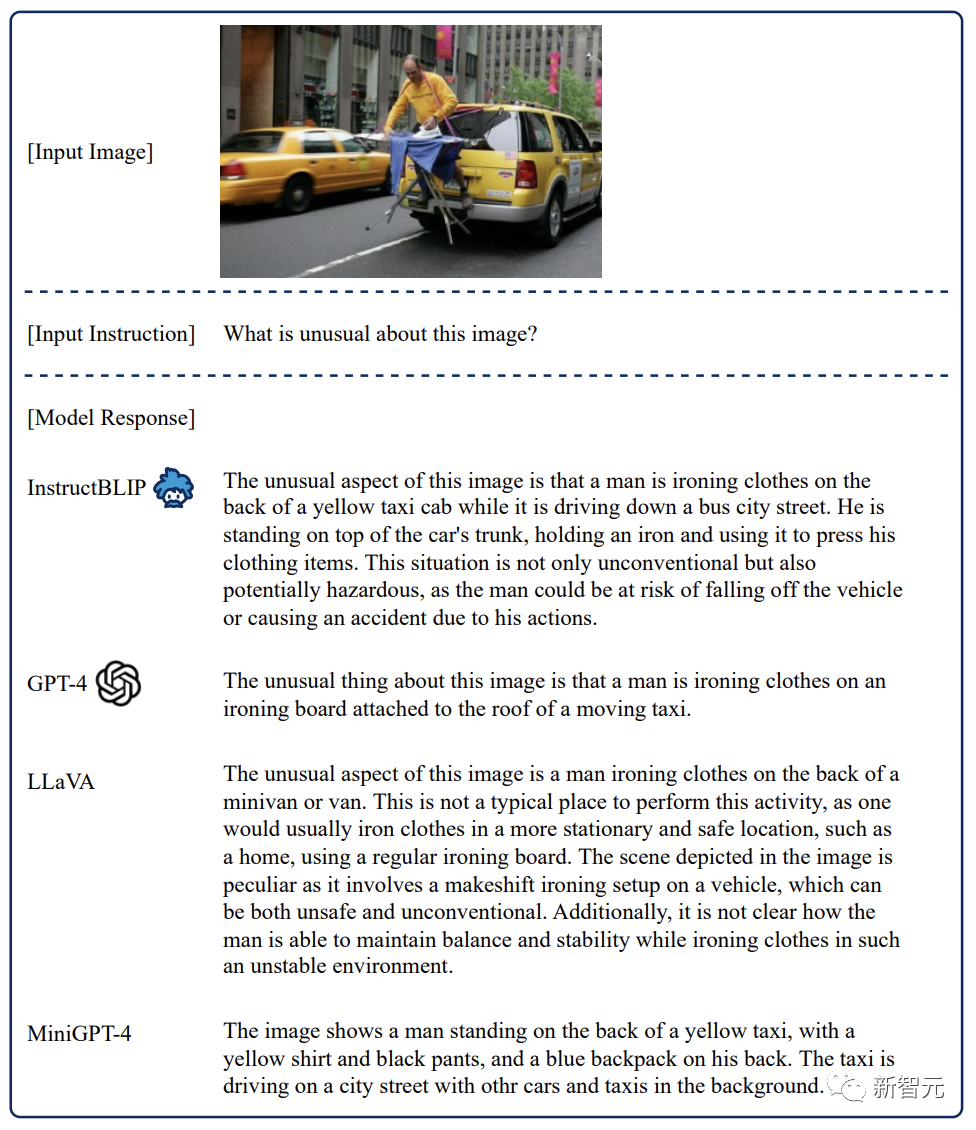

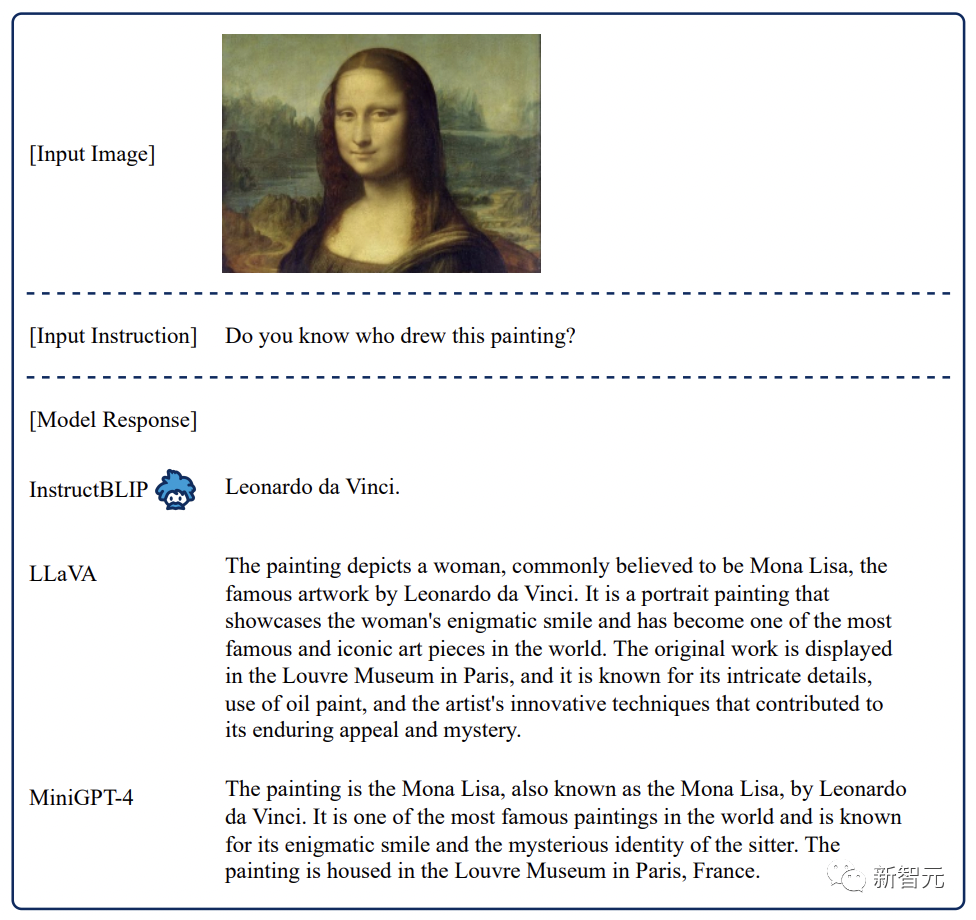

定性评估

此外,研究人员进一步使用更加多样化的图像和说明对Instruct-BLIP进行了定性研究。

比如使用GPT-4技术报告中的一张图。「这张图有什么不对劲的地方?」

从给出的回答中看出, InstructBLIP比GPT-4更全面,比LLaVA更视觉化,比MiniGPT-4更有逻辑性。

对于「蒙娜丽莎」这幅画是谁画的问题,InstructBLIP回答非常简短。

在这里,研究人员认为长回应不总是可取的。Instruct-BLIP 可以通过自适应调整响应长度直接解决用户的意图。

而其他模型倾向于生成较长的段落,以及较不相关的句子。

Instructlip能够取得这些优势,是使用多样化的指令调优数据和有效的架构设计的结果。

另外,通过研究发现,指令调整是提高模型零样本泛化能力的关键。

基于BLIP-2 FlanT5XL的指令调优和多任务训练的比较

此外,研究人员进一步对InstructBLIP模型进行微调,研究其在学习特定数据集上的表现。

与大多数以前的方法(如Flamingo,BLIP-2)相比,InstructBLIP在指令微调期间保持相同的图像分辨率(224×224),并在微调期间保持视觉编码器的冻结状态。

这大大减少了可训练参数的数量,从1.2B到188M,从而大大提高了微调效率。

作者介绍

Wenliang Dai

Wenliang Dai (戴文亮)是香港科技大学的博士研究生,导师是Pascale Fung教授。在此之前,他曾获得伦敦大学学院硕士学位,诺丁汉大学计算机学士学位。