- 1SpringBoot实现请求频率限制,基于aop实现_java springboot 前后端分离处理频繁请求限制

- 2SQL力扣练习(十一)_力扣 sql 练习

- 3图像处理的AI大模型:重塑视觉技术的未来_ai视觉大模型

- 4OpenSNN推文:剪映专业版使用教程_剪映专业版csdn

- 5OceanBase v4.2 特性解析:支持并发建表,提升OMS导入效率_oceanbase 导入速度慢

- 6软考:软件设计师 — 7.软件工程

- 7verilog实现CRC_crc32verilog代码

- 8WSN硬件实验平台综述及目标跟踪调研报告_wsn目标跟踪技术的研究

- 9搭建 canal 监控mysql数据到RabbitMQ_canal监听mysql,那mysql需要做什么配置(1)_canal配置rabbitmq

- 10利用python解决线性规划最优化问题_python求解线性规划差值最小

又一届「AI春晚」拉开序幕!智源大模型集体爆发了

赞

踩

每一年的智源大会不仅是分享前沿 AI 科技成果的平台,更为国内外业内人士提供了一个交流的舞台。果然,2024 智源大会又为我们带来了诸多惊喜。

一年一度的国内「AI 春晚」—— 智源大会又一次拉开了序幕。

20+ 个不同主题的论坛、百场精彩报告让现场和线上的观众目不暇接,切实感受到了当下 AI 尤其是大模型对内容创作、生产办公、机器人、生物医疗等千行百业的深度赋能。

在这场「AI 内行顶级盛会」上,不仅有 Llama、Sora 等大模型及 DiT 架构的作者参与交流,详解他们的研究成果;还有百度、零一万物、百川智能、智谱 AI、月之暗面、面壁智能等耳熟能详的国内大模型公司的 CEO 与 CTO 展开对话,探讨人工智能关键技术路径以及通往 AGI 之路。

同时,在 AI 安全这个愈加受到全球关注的课题上,包括图灵奖得主姚期智、加州大学伯克利分校教授 Stuart Russell、谷歌 DeepMind 前沿安全与治理主任 Allan Dafoe 等一众国内外大咖嘉宾分享洞见,为人工智能接下来的健康、可持续发展建言献策。

自 2019 年 10 月举办首届以来,智源大会已经来到第六个年头。每一年,智源研究院都会在大会上发布诸多重磅进展。

在今天的智源大会上,我们又一次看到了多项「全球首个」研究进展:

智源研究院带来了持续迭代后覆盖面更全、性能更强大、影响更深远的大模型全家桶,包括语言大模型、多模态大模型、具身大模型、生物计算大模型。新技术的亮相预示着智源始终走在大模型发展前列,引领大模型研究方向。

智源研究院院长王仲远博士。

训练万亿级大模型仅需四个月和 112 台 A800

在过去一年,Scaling Law 被研究者们反复提及和议论。这个定律揭示了一点:随着模型参数、训练数据量和计算量的持续增加,模型的性能通常会持续提升。正因此,大模型的参数每年都在指数级提升。

科学家们普遍认为人类大脑参数在万亿到 1000 万亿之间,而大模型参数与人类大脑参数的差距在不断缩小,从过去几年的相差 100 万倍到 1000 倍再到最近的仅差 100 倍。按照这个速度发展,未来几年,大模型参数很可能就会赶上或者超过人类大脑的参数,AGI 也会更快到来。

但人们同时意识到,算力的短缺将成为一大挑战。

为此,智源研究院与中国电信人工智能研究院(TeleAI)基于模型生长和损失预测等技术联合研发了全球首个低碳单体稠密万亿语言模型「Tele-FLM-1T」。该模型与百亿级的 52B 版本、千亿级的 102B 版本共同构成 Tele-FLM 系列,团队用 4 个月完成了 3 个模型总计 2.3T tokens 的训练,训练全程做到了零调整零重试,算力能效高且模型收敛性和稳定性好。

作为一个万亿级参数的模型,Tele-FLM-1T 仅需业界普通训练方案 9% 的算力资源和 112 台 A800 服务器。

Tele-FLM 系列模型在基础性能方面取得多项突破:BPB 显示,英文能力上,Tele-FLM-52B 接近 Llama3-70B,优于 Llama2-70B 和 Llama3-8B;中文能力上,Tele-FLM-52B 为开源最强,优于 Llama3-70B 和 Qwen1.5-72B。在对话模型性能方面:AlignBench 评测显示,Tele-FLM-Chat(52B)已经达到 GPT-4 中文语言能力的 96%,总体能力达到 GPT-4 的 80%。

大会上,智源研究院院长王仲远博士宣布,TeleFLM 系列中,52B 版本已经全面开源,包括所有的核心技术(生长技术、最优超参预测)、训练细节(loss 曲线、最优超参、数据配比和 Grad Norm 等),Tele-FLM-1T 版本也即将开源。

- Tele-FLM-52B 版本开源地址:huggingface.co/CofeAI/Tele…

- Tele-FLM-Chat 试用(纯模型单轮对话版)地址:modelscope.cn/studios/FLM…

对于 AI 研究者们来说,同样关心的还有模型的幻觉问题。针对这个问题,智源研究院推出了通用语义向量模型 BGE(BAAI General Embedding)。

自 2023 年 8 月发布以来,智源团队陆续发布了中英文模型 BGE v1.0、v1.5 以及多语言模型 BGE-M3。截至目前,BGE 系列模型全球下载量超过 1500 万,位居国内开源 AI 模型首位。BGE-M3 模型一度跃居 Hugging Face 热门模型前三,其所属代码仓库 FlagEmbedding 位居 Github 热门项目前 10;BGE-M3 所带来的全新的通用检索模式也相继被 Milvus、Vespa 等主流向量数据库集成。

同时,智源再度推出新一代检索排序模型 BGE Re-Ranker v2.0,同时扩展了向量模型 BGE 的「文本 + 图片」混合检索能力。

打造原生多模态世界模型

8B 小模型可达 GPT-4o 87% 性能

如今,行业主流多模态大模型多为针对不同任务而训练的专用模型,例如文生图的 Stable Diffusion,文生视频的 Sora,图生文的 GPT-4V,每类模型都有对应的架构和方法。

这就导致现有模型的能力多为单一分散的能力组合,而非原生的统一能力,比如 Sora 目前就做不到对图像和视频的理解。此次,智源研究院推出了 Emu3 原生多模态世界模型,让我们看到了不一样的选择。

值得关注的是,在技术路线上,智源研究院没有像行业其他玩家一样选择因 Sora 而爆火的 DiT 路线。Emu3 采用了智源自研的多模态自回归技术路径,在图像、视频、文字上联合训练,使模型具备真正原生的多模态能力,实现了图像、视频、文字的统一输入和输出。

简单来说,Emu3 从训练开始就是为实现统一的多模态生成和理解而设计的。这两种能力的融合使模型不仅能够生成高质量的图片和视频,还可以续写视频、理解物理世界。

图像、视频、文字等多模态以及生成、理解能力的多方面统一,让我们见识到了下一代更强大多模态大模型的雏形。

_视频生成能力演示。

_

图像及视频理解能力演示。

目前,Emu3 正在持续训练中,并将延续以往的开源策略,在经过安全评估之后会逐步开源。我们可以期待一波了。

当然了,多模态领域也少不了算力需求更少、部署更方便的「小」模型。此次为了适应模型在端侧的应用,智源研究院推出了轻量级图文多模态模型 Bunny 系列,包括 3B、4B、8B 版本。

该模型系列采用灵活架构,支持多种视觉编码器和语言基座模型。多个榜单的综合结果表明,Bunny-8B 的多模态能力可以达到 GPT-4o 性能的 87%。更难得可贵的是,Bunny 模型系列做到了真正的开源,模型、数据和代码全部开放给大家。

大模型具象化

用具身智能解决物理世界更多样任务

当前,赋予大模型「身体」,使其更具象地感知、理解并执行物理世界多样性任务成为了 AI 领域重要的发展趋势之一。这也是具身智能大模型兴起并引领 AI 下一个浪潮的重要原因。

过去一年,智源研究院在具身智能大模型领域取得了多项世界级突破性成果,涉及到了通用泛化抓取技术、具身操作 VLA(视觉 - 语言 - 动作)大模型、具身导航 VLA 大模型和自研机器人硬件等方向。

首先在具身智能通用抓取能力方面,智源研究院提出的通用抓取技术 ASGrasp 率先突破了 95% 的真机实验成功率,实现全球领先的商业级动作执行水平。其中使用到的大规模高质量仿真数据覆盖了千万级场景,执行了十亿次抓取动作。相关论文也被机器人领域顶会 ICRA 2024 收录。

如下图所示, 采用 ASGrasp 技术的机器人能够轻松应对复杂光线透射、反射的情况,并准确感知透明、高反光物体的形状和姿态,预测出高成功率的抓取位姿,轻松完成抓取任务。

其次在分级具身大模型系统方面,智源研究院研发布了两个「专模专用,各司其职」的分级大模型系统。

第一个是能够从失败中重思考、再尝试的铰接物体操作大模型系统 SAGE。据介绍,该系统有效结合了三维视觉小模型对空间几何的精确感知能力和通用图文大模型的通用物体操作知识,使大模型驱动的机器人能够在任务执行失败时能够重新思考并再次尝试新的交互方式,实现了传统机器人技术无法企及的智能性和鲁棒性。

第二个是全球首个开放指令六自由度拿取放置的大模型系统 Open6DOR。该系统不仅像谷歌 RT 系列大模型(只能实现三自由度)一样按照自然语言指令中的要求将物体放到指定位置,还能够进一步对物体的位置和姿态进行精细化控制。该项技术极大地提高了具身操作大模型的商业应用范围和价值。

除了简单的抓取任务之外,具身机器人有时还需要行走起来。在面向技术终局的端到端具身大模型层面,智源研究院发布了全球首个端到端基于视频的多模态具身导航大模型 NaVid。该模型可以直接将机器人视角的视频和用户的自然语言指令作为输入,端到端地输出机器人的移动控制信号。

NaVid 与以往机器人导航技术的区别在于:既无需建图,也不依赖于深度信息和里程计信息等其它传感器信号,而是完全依靠机器人摄像头采集的单视角 RGB 视频流。

不仅如此,NaVid 在只利用合成导航数据进行训练的情况下,通过 Sim2Real 的方式,实现在真实世界室内场景甚至是室外场景的 zero-shot 真机泛化。

在具身智能落地的另一个重要的医疗场景,智源研究院联合领视智远研发了全球首个智能心脏超声机器人,实现了全球首例真人身上的自主心脏超声扫查,对于解决心脏 B 超医生紧缺、诊断准确率不高、标准化欠缺、效率低等难题具有积极作用。

据介绍,基于超声影像和机械臂的受力信息,智能心脏超声机器人可在高速动态环境下快速计算,提取心脏特征,实现了相当于自动驾驶 L2、 L3 级的智能化水平。

临床验证结果显示,准确性上,智能心脏超声机器人能和高年资医生保持一致;稳定性上,智能心脏超声机器人更高;舒适性上,智能超声机器人的力度可以控制在 4 牛以内,舒适度更高;效率上,智能超声机器人实验机可与人类医生持平。

而为了让具身智能机器人能够通过通用计算机控制,智源研究院提出了通用计算机控制框架 Cradle,让智能体像人一样看屏幕,通过鼠标、键盘完成计算机上的所有任务。

Cradle 由信息收集、自我反思、任务推断、技能管理、行动计划以及记忆模块等 6 个模块组成,可进行「反思过去,总结现在,规划未来」的强大决策推理。不同于业界其他方法,Cradle 不依赖任何内部 API 实现了通用性。

未来,智源研究院将依托多模态大模型技术优势资源,投入更多人力,并联合北大、清华、中科院等高校院所,银河通用、加速进化等产业链上下游企业,建设具身智能创新平台,重点开展数据、模型、场景验证等研究,打造具身智能创新生态。

大模型如何变革生物计算?

伴随着大模型能力的持续提升,人工智能开始在更多科学领域显现出价值。

全世界的生物计算科学家们都希望借助大模型实现「微观世界」的研究突破。以药物研发为例,从新药研发到上市,通常要耗费 10 年以上的时间以及 10 亿美金以上的投入,业内称之为「双十定律」。其中 30% 到 40% 的投入是花在药物设计环节的,而 AI 有助于加速化合物的筛选、大分子结构的建模及预测等工作。

有了大模型,我们能否更好地解决生命分子的理解与生成问题呢?

在本次大会上,智源研究院重磅发布了全原子生物分子模型 OpenComplex 2,能有效预测蛋白质、RNA、DNA、糖类、小分子等复合物。它不仅可以预测大分子的稳定结构,还初步具备预测分子多构型以及折叠过程的能力。

在生物分子结构预测领域国际竞赛 CAMEO(Continous Automated Model EvaluatiOn)中,OpenComplex 已连续两年稳居第一,并获得了 CASP(Critical Assessment of Techniques for Protein Structure Prediction)15 的 RNA 自动化赛道预测冠军。OpenComplex 在精度和宏观结构方面的表现都优于同类竞品,比如 AlphaFold,结果相似且没有噪音。

OpenComplex 平台建立了将「蛋白质结构预测」「RNA 结构预测」和「蛋白质 - RNA 复合物结构预测」三类任务统一的端到端生物大分子三维结构预测深度学习框架。上述三类任务的推断和训练在该统一的「编码器 - 解码器」框架中完成,其中编码器支持多重序列比对(MSA)和语言模型(LM)两种编码策略。

此外,智源研究院还构建了全球首个实时孪生心脏计算模型,可实现高精度的前提下生物时间 / 仿真时间比小于 1,位于国际领先水平。

基于这一模型,智源将创新性地采用物理 - 数据双驱动模型,融合第一性原理和人工智能方法,从亚细胞级、细胞级、器官级、躯干级仿真出一个「透明心脏」,且能根据患者的临床数据,构建出反映患者的个性化生理病理的孪生心脏,从而进行药物筛选、治疗方案优化、术前规划等临床应用。

与此同时,智源研究院已与北大第一医院、安贞医院、长征医院、朝阳医院进行合作,将相关技术应用在临床实践之中。

五大版图布局升级

FlagOpen 大模型开源技术基座 2.0 来了

所有的研究成果,都要依赖于一个非常强大的基座。

去年,为帮助全球开发者一站式启动大模型开发和研究工作,智源研究院推出了面向异构芯片、支持多种框架的大模型全栈开源技术基座 FlagOpen 1.0。

今年,在 1.0 的基础上,智源研究院推出了 FlagOpen 2.0,进一步完善模型、数据、算法、评测、系统五大版图布局,旨在打造大模型时代的 Linux。

开源地址:github.com/FlagOpen

FlagOpen 2.0 可支持多种芯片和多种深度学习框架。目前,开源模型全球总下载量超 4755 万次,累计开源数据集 57 个,下载量近 9 万次,开源项目代码下载量超 51 万次。

数据层面,智源研究院发布了首个千万级高质量开源指令微调数据集开源项目 InfinityInstruct,首期发布经过验证的 300 万条中英文指令数据,近期将完成千万条指令数据的开源。当前开源的 300 万条指令数据集已经显示出超越 Mistral、Openhermes 等的 SFT 数据能力。在提升到千万级数据量级后,基座模型基于该指令微调数据集进行训练,对话模型能力有望达到 GPT-4 水平。

此外,智源研究院还构建并开源了 IndustryCorpus 中英文多行业数据集,包含总计 3.4TB 预训练数据集,其中中文 1TB,英文 2.4TB,覆盖 18 类行业,分类准确率达到 80%,未来计划增加到 30 类。

行业预训练数据集:data.baai.ac.cn/details/BAA…

评测层面,FlagEval 大模型评估自 2023 年发布以来,已从主要面向语言模型扩展到视频、语音、多模态模型,实现多领域全覆盖,采用主观客观结合以及开卷闭卷综合的考察方式,首次联合权威教育部门开展大模型 K12 学科测验,与中国传媒大学合作共建文生视频模型主观评价体系。

在系统软件层面,本次智源大会也宣布了几项重要进展:

FlagScale 首次在异构集群上实现不同厂商跨节点 RDMA 直连和多种并行策略的高效混合训练,成为业界首个在多元异构 AI 芯片上同时支持纵向和横向扩展两阶段增长模式的训练框架。

智源研究院推出了面向大模型的开源 Triton 算子库,包括首个通用算子库 FlagGems 和大模型专用算子库 FlagAttention,可基于统一开源编程语言,大幅提升算子开发效率,同时,面向多元芯片共享算子库。

为满足不断攀升的大模型训练和推理计算需求,应对大规模 AI 系统和平台面临的集群内或集群间异构计算、高速互联、弹性稳定的技术挑战,智源研究院推出了面向大模型、支持多种异构算力的智算集群软件栈 FlagOS。

FlagOS 融合了智源长期深耕的面向多元 AI 芯片的关键技术,包括异构算力智能调度管理平台九鼎、支持多元 AI 异构算力的并行训推框架 FlagScale、支持多种 AI 芯片架构的高性能算子库 FlagAttention 和 FlagGems,集群诊断工具 FlagDiagnose 和 AI 芯片评测工具 FlagPerf,目前已支持了超过 50 个团队的大模型研发,支持 8 种芯片,管理超过 4600 个 AI 加速卡,稳定运行 20 个月,SLA 超过 99.5%,帮助用户实现高效稳定的集群管理、资源优化、大模型研发。

写在最后

作为一家不以营利为目标的科研机构,智源研究院以往已经做的、现在正在做的以及未来要做的始终是技术突破、探索和创新。这也是智源研究院与其他大模型玩家的本质区别。

从 2020 年开始,智源研究院就投身于大模型技术研发,迄今已经形成了涵盖语言、多模态、具身、生物计算大模型在内的体系。

如果将 2023 年之前称为「弱人工智能」时代,那么 2023 年之后,我们将逐渐走进「通用人工智能」时代。在未来很长一段时间,大模型能力的强弱很大程度上将左右这一进程推进的速度。

在王仲远看来,现阶段语言大模型的发展已经具备了通用人工智能非常核心的理解和推理能力,并且形成了一条以语言大模型为核心对齐和映射其他模态的技术路线,从而让模型具备了初步的多模态理解和生成能力。但这并不是让人工智能感知、理解物理世界的终极技术路线,而应该采取统一模型的范式,实现多模态的输入和输出,让模型具备原生的多模态扩展能力,向世界模型演进。

此次,Emu3 原生多模态世界模型正是智源研究院在原生统一大模型技术路线上的牛刀初试。此外,通过在具身机器人、生物医疗等更多应用场景的落地,加之学术生态、产业生态的不断深化,大模型的能力会持续得到拓展与增强。

同时,智源研究院凭借对前沿 AI 和大模型技术的探索受到了广泛的业界认可。月之暗面 CEO 杨植麟表示,智源研究院至少是亚洲地区最早且真正投入去做大模型的机构,这是非常难得、非常领先的想法。

百川智能 CEO 王小川提到,大模型的思潮和很多技术都是从智源研究院发展而来的。如今智源拥有非常好的定位,既有技术高度,又承担了智库的角色,在生态层面能够帮助大家更加快速健康地发展。

智谱 AI CEO 张鹏称赞智源研究院真的是国内甚至国际人工智能领域的一面旗帜,并非常希望双方能在学术研究、落地应用、公共政策等多方面继续保持合作。

面壁智能 CEO 李大海则希望大家在智源研究院的撮合和带领下,搭建一个更好的平台,携手把需要做好的事情一起做好。

未来,智源研究院将继续坚持原始技术创新,做前沿方向的路线探索,广泛链接学术生态,赋能产业发展。可以预见,在通用人工智能最终到来之前,智源研究院将扮演无可替代的重要角色。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

资源分享

大模型AGI学习包

资料目录

- 成长路线图&学习规划

- 配套视频教程

- 实战LLM

- 人工智能比赛资料

- AI人工智能必读书单

- 面试题合集

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!

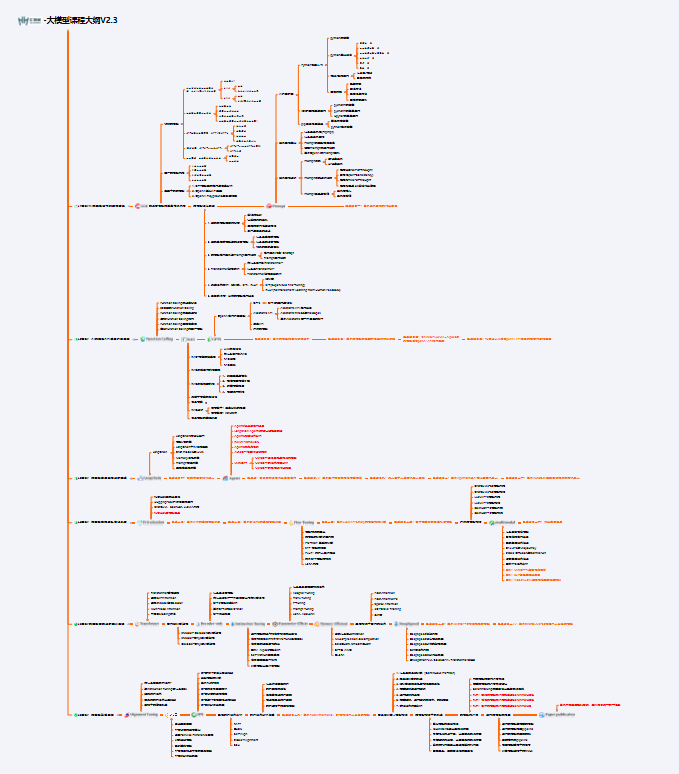

1.成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

2.视频教程

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,其中一共有21个章节,每个章节都是当前板块的精华浓缩。

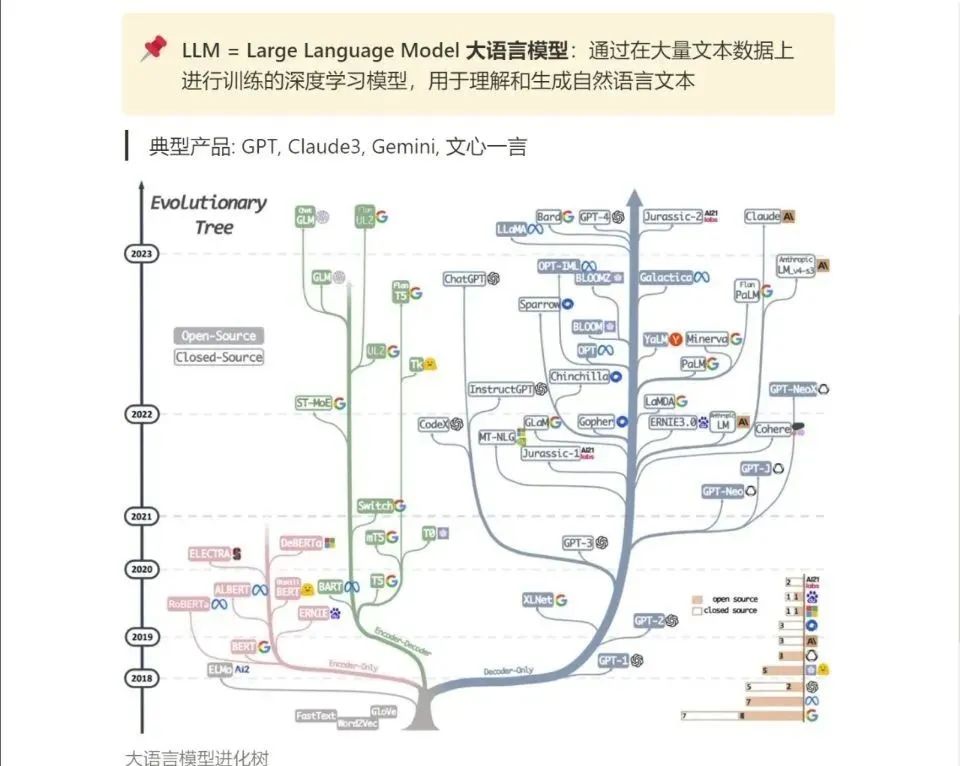

3.LLM

大家最喜欢也是最关心的LLM(大语言模型)

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!