- 1Django 入门教程_django入门教程

- 2Kettle的安装及简单使用

- 3linux(ubuntu20.04)+PicGo(gui版)+github+typora搭建笔记

- 4卷积神经网络(CNN)网络结构及模型原理介绍_卷积神经网络结构

- 5常用网络结构:深度残差理解Resnet_resnet综述

- 6uniapp转小程序,小程序转uniapp方法_uniapp如何转成原生小程序

- 7coma运行代码遇到的问题_no module named 'psbody

- 8Linux命令经典面试题:统计文件中出现次数最多的前10个单词_怎么统计指定条件出现次数最多的词

- 9好发现个开源又完全免费的大屏设计器_开源大屏组件

- 10小程序内嵌uniapp页面跳转回小程序指定页面方式

AI绘画:多种XP一次满足(Stable Diffusion进阶篇:模型训练)

赞

踩

前言

今天,是一个比较特殊的日子。

从我开始学习AI绘画开始到现在AI工具相关的笔记我已经写了50篇了,其中估摸着得近40篇都是关于Stable Diffusion的。

在这一天天的学习中我感受到了对知识的疲倦,是时候给自己来点奖励了!

所以!

今天开始和后续的一系列笔记内容将跟随小33学习如何训练出一个自己的Stable Diffusion模型,就像是用自己的双手捏出一个自己心目中的“伴侣”一样。

我知道很多人一直期待着这个环节,但是捏一个自己想要的模型并不是一件简单的事情,需要有足够的基本功作为铺垫。

今天!正是时候!

让我们废话少说,一起踏上“寻找理想伴侣”的旅程吧!

Stable Diffusion

AI绘画其实有很多家AI公司参与,旗下都有着自己的旗舰产品(Midjourney之类),但是为什么唯独是Stable Diffusion名气最响受众最广呢?

其中一个原因是它免费开源,还有一个原因则是Stable Diffusion有着包罗万象的模型生态。

像是以往封面的图片以及学习中所使用过的模型,超过99%都是由个人用户训练出来的微调模型。

像这样的

这些模型不仅弥补了原版模型绘制精度不足的局限性,还能让任何想要的人物、风景、物品出现在AI生成的作品里。这也一定程度上让AI绘画摆脱了抽卡式的随机性,这也是SD与其他的“闭源”图像生成应用的最大区别之一。

机器学习与模型训练

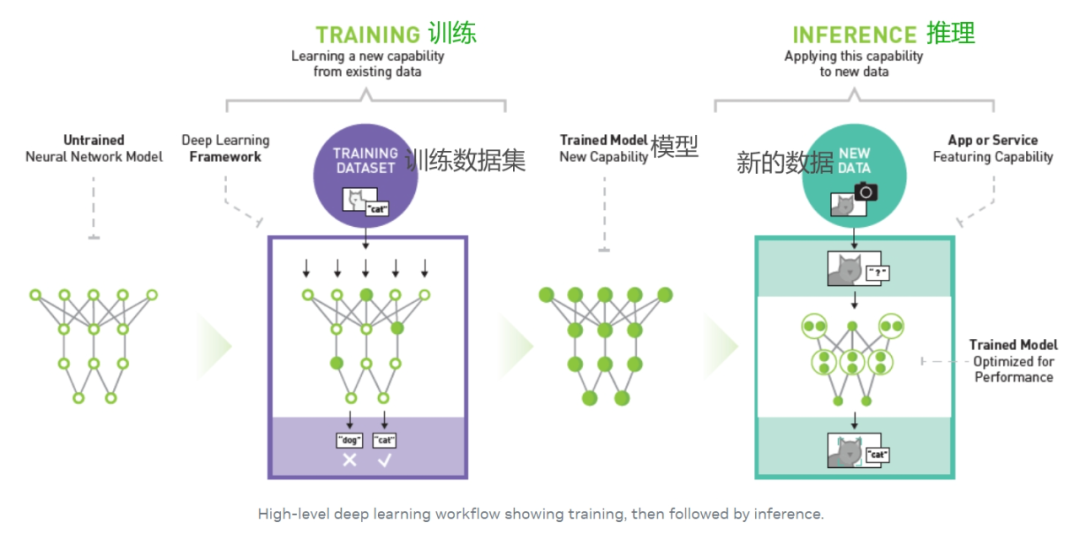

人工智能领域有一个专业词汇被称为“机器学习”,机器学习支持用户向计算机算法输送大量数据,让计算机分析这些数据后根据输入的数据给出数据驱动型建议和决策。

而我们提供数据和引导机器学习的过程就是“训练”,训练的结果是让AI得到我们想到他学到的“知识”,这个知识就是模型。后续用模型来解决问题的过程被称为推理。

图中的训练数据集就是要让AI学习的资料,而得到的新数据就是要让AI处理的工作。

AI绘画中要给AI灌输的学习资料就是从互联网上抓取的海量图片,这些图片连同描述图片的文字信息构成了用来训练的“数据集”。

数据集并不是像我们所想的一样把图片存进去,然后收到提示词信息后调用抓取图片。数据集所存储的是图片中蕴含的“像素分布规律”,每一张图片其实都是由不同的颜色的像素点所组成。

整理和输出教程属实不易,觉得这篇教程对你有所帮助的话,可以点击

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。