- 119 STM32标准库函数 之 通用定时器(TIM)-- A -- 所有函数的介绍及使用_开启通用定时器的函数

- 2Mybatis基础学习之使用注解开发_mybatis获取java静态属性

- 3小试牛刀-区块链WalletConnect协议数据解密_walletconnect文档

- 4FastAPI Python照片打马赛克API_马赛克拼图api

- 5第八章小程序总结

- 6STM32F1103C8T6综述_stm32f103c8t6rom的多少 csdn

- 7C++相关技术简介_c++ 技

- 8全网最详细【Mac终端改造计划】iTerm2 + Oh My Zsh,阿里内部资料_mac iterm2

- 9详解 | 大型分布式电商系统架构

- 10YOLOv8添加小目标检测层_yolov8增加小目标检测层

【机器学习】特征工程 - 文本特征提取CountVectorizer_如何调取countvectorizer的特征词列表_countvectorizer 文本字典

赞

踩

先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

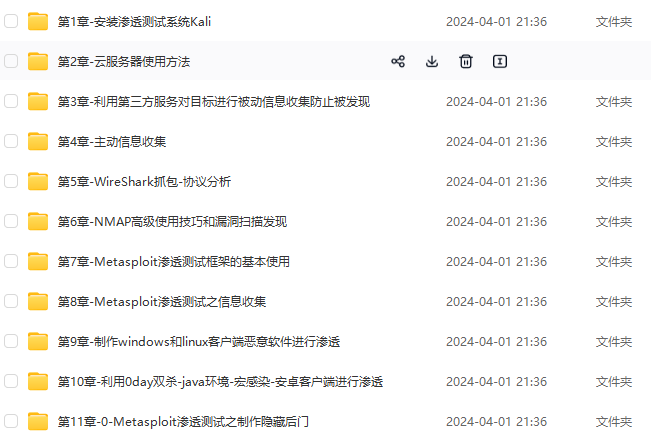

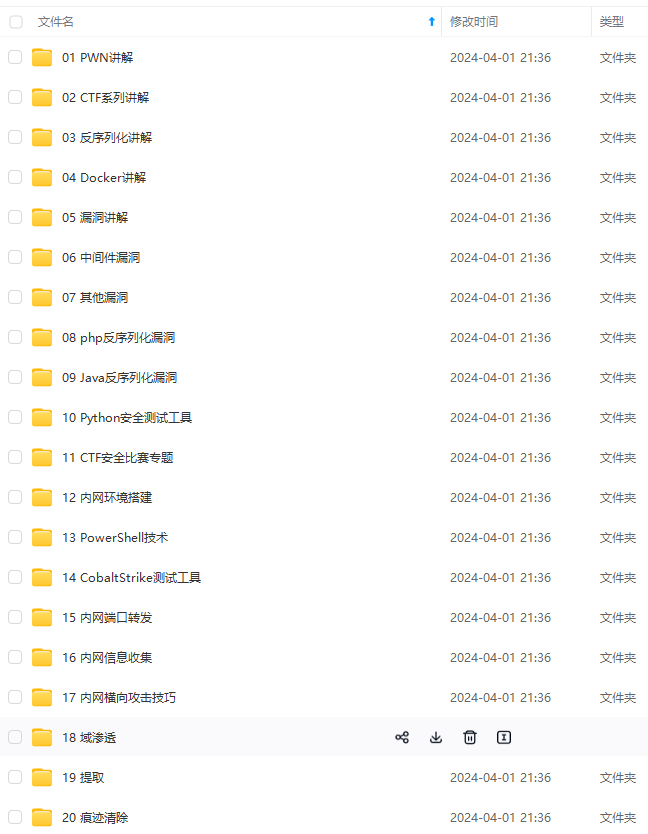

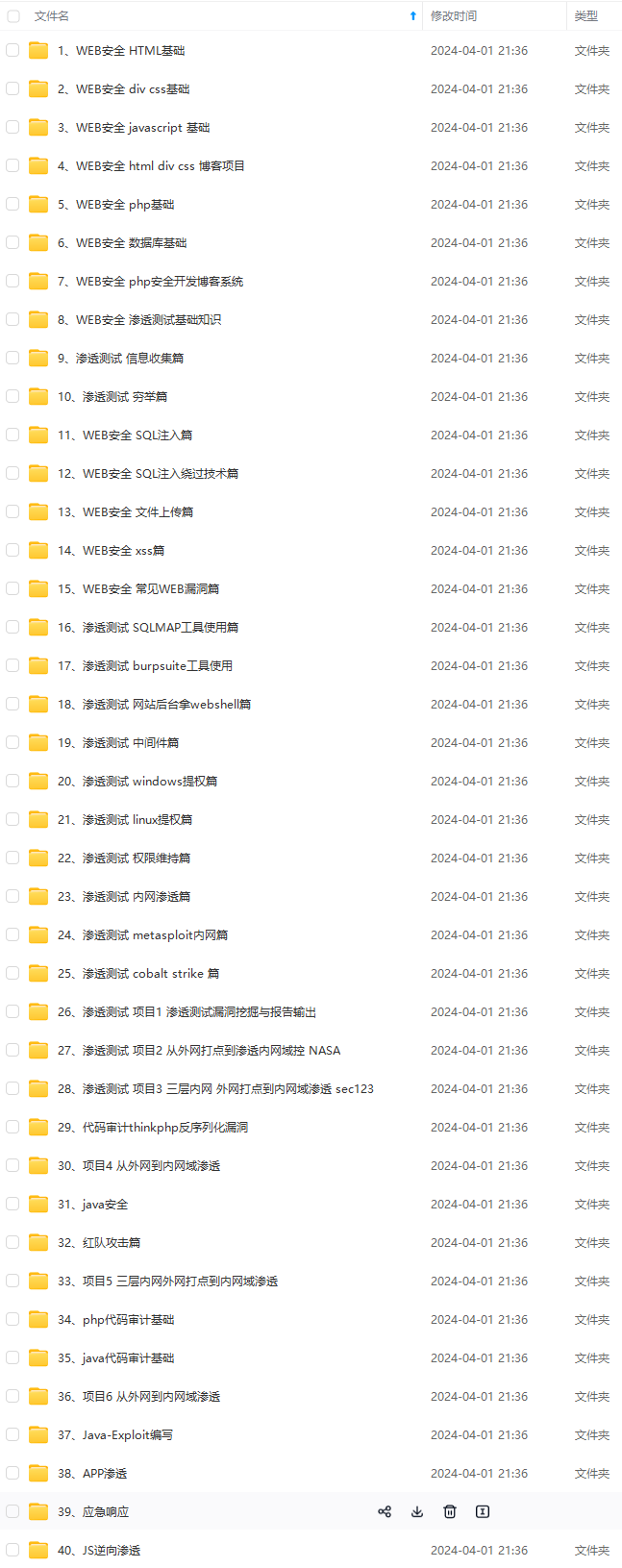

因此收集整理了一份《2024年最新网络安全全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上网络安全知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注网络安全)

正文

转换数据

new_data = vector.fit_transform(old_data)

print(new_data)

输出:

- 1

- 2

- 3

- 4

- 5

(0, 0) 1

(0, 3) 1

(0, 2) 1

(1, 0) 1

(1, 3) 1

(1, 1) 1

返回的提取的特征默认是「sparse矩阵」,我们用type打印一下返回值的类型。

- 1

- 2

- 3

- 4

- 5

转换数据

new_data = vector.fit_transform(old_data)

print(type(new_data))

输出:

- 1

- 2

- 3

- 4

- 5

<class ‘scipy.sparse._csr.csr_matrix’>

这种格式不利于我们观察分析,接下来,我们把sparse矩阵转换成数组格式。

## 三、转换成数组

sparse矩阵内置的 toarray() 方法 ,可以把结果转换成「二维数组」。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

from sklearn import feature_extraction

原始数据(字典)

old_data = [

“I am your mather !”,

“I am your father !”]

初始化

vector = feature_extraction.text.CountVectorizer()

转换数据

new_data = vector.fit_transform(old_data)

print(new_data.toarray())

输出:

- 1

- 2

- 3

- 4

- 5

[[1 0 1 1]

[1 1 0 1]]

这样的格式友好一些,但这些特征是什么意思呢?我们可以通过特征名字来分析。

## 四、特征名字

get\_feature\_names\_out() 方法可以获取「特征名字」。

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

from sklearn import feature_extraction

原始数据(字典)

old_data = [

“I am your mather !”,

“I am your father !”]

初始化

vector = feature_extraction.text.CountVectorizer()

转换数据

new_data = vector.fit_transform(old_data)

print(new_data.toarray())

print(vector.get_feature_names_out())

输出:

- 1

- 2

- 3

- 4

- 5

[[1 0 1 1]

[1 1 0 1]]

[‘am’ ‘father’ ‘mather’ ‘your’]

从特征名字我们可以发现,原始数据中出现的每个「单词」,都被当做一个「特征词」。 需要注意的是,「标点符号」和「字母」默认不统计,不作为特征词,因为没什么意义。 提取的特征数组中:每一行(也就是每个数组)对应一个「样本」,每一列(也就是数组的每一个值)对应一个特征词。 用数字表示特征词出现的次数。 比如第一个数组([1 0 1 1])对应第一个样本(“I am your mather !”); 数组中第一位时1,意思就是样本里 ‘am’ 这个词出现了1次; 数组中第二位是0,意思就是样本里 ‘father’ 这个词出现了0次; 为了方便观察,我们在第一个样本字符串里添加「重复」的单词:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

from sklearn import feature_extraction

原始数据(字典)

old_data = [

“I am your mather mather!”,

“I am your father !”]

初始化

vector = feature_extraction.text.CountVectorizer()

转换数据

new_data = vector.fit_transform(old_data)

print(new_data.toarray())

print(vector.get_feature_names_out())

输出:

- 1

- 2

- 3

- 4

- 5

[[1 0 2 1]

[1 1 0 1]]

[‘am’ ‘father’ ‘mather’ ‘your’]

可以看到特征数组里有了一个数字2,意思就是样本中,‘mather’ 这个词出现了2次。 ## 五、停用词 CountVectorizer() 的 stop\_words 参数可以指定「停用词」。 停用词的意思就是,不被算作特征词的单词,通常用于那些使用很少或没有统计意义的词。 这里我们指定两个停用词,观察一下提取的特征词有什么变化:

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

原始数据(字典)

old_data = [

“I am your mather mather!”,

“I am your father !”]

初始化

vector = feature_extraction.text.CountVectorizer(stop_words=[‘am’, ‘your’])

转换数据

new_data = vector.fit_transform(old_data)

print(vector.get_feature_names_out())

输出: ## 写在最后 **在结束之际,我想重申的是,学习并非如攀登险峻高峰,而是如滴水穿石般的持久累积。尤其当我们步入工作岗位之后,持之以恒的学习变得愈发不易,如同在茫茫大海中独自划舟,稍有松懈便可能被巨浪吞噬。然而,对于我们程序员而言,学习是生存之本,是我们在激烈市场竞争中立于不败之地的关键。一旦停止学习,我们便如同逆水行舟,不进则退,终将被时代的洪流所淘汰。因此,不断汲取新知识,不仅是对自己的提升,更是对自己的一份珍贵投资。让我们不断磨砺自己,与时代共同进步,书写属于我们的辉煌篇章。** 需要完整版PDF学习资源私我 **网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。** **需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注网络安全)**  **一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!** 体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。** **需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注网络安全)** [外链图片转存中...(img-fMXx6laI-1713469112441)] **一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29